Hadoop系列006-HDFS概念及命令行操作

本人微信公众号,欢迎扫码关注!

![]()

HDFS概念及命令行操作

一、HDFS概念

1.1 概念

HDFS,它是一个文件系统,用于存储文件,通过目录树来定位文件;其次,它是分布式的,由很多服务器联合起来实现其功能,集群中的服务器有各自的角色。

HDFS的设计适合一次写入,多次读出的场景,且不支持文件的修改。适合用来做数据分析,并不适合用来做网盘应用。

1.2 组成

1)HDFS集群包括,NameNode和DataNode以及Secondary Namenode。

2)NameNode负责管理整个文件系统的元数据,以及每一个路径(文件)所对应的数据块信息。

3)DataNode 负责管理用户的文件数据块,每一个数据块都可以在多个datanode上存储多个副本。

4)Secondary NameNode用来监控HDFS状态的辅助后台程序,每隔一段时间获取HDFS元数据的快照。

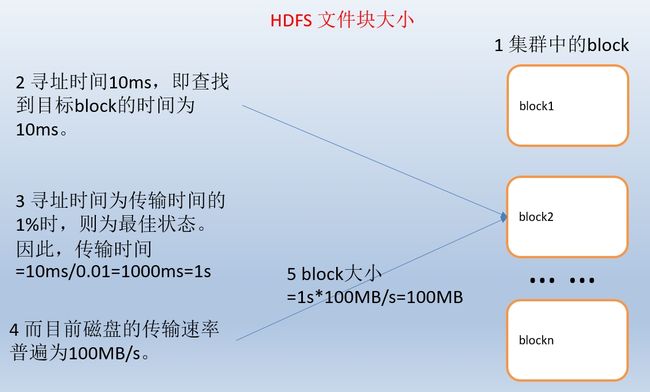

1.3 HDFS 文件块大小

- HDFS中的文件在物理上是分块存储(block),块的大小可以通过配置参数( dfs.blocksize)来规定,默认大小在hadoop2.x版本中是128M,老版本中是64M

- HDFS的块比磁盘的块大,其目的是为了最小化寻址开销。如果块设置得足够大,从磁盘传输数据的时间会明显大于定位这个块开始位置所需的时间。因而,传输一个由多个块组成的文件的时间取决于磁盘传输速率。

- 如果寻址时间约为10ms,而传输速率为100MB/s,为了使寻址时间仅占传输时间的1%,我们要将块大小设置约为100MB。默认的块大小实际为64MB,但是很多情况下HDFS使用128MB的块设置。

- 块的大小:10ms x 100 x 100M/s = 100M

二、HFDS命令行操作

2.1 基本语法

bin/hadoop fs 具体命令

2.2 参数大全

bin/hadoop fs

[-appendToFile ... ]

[-cat [-ignoreCrc] ...]

[-checksum ...]

[-chgrp [-R] GROUP PATH...]

[-chmod [-R] PATH...]

[-chown [-R] [OWNER][:[GROUP]] PATH...]

[-copyFromLocal [-f] [-p] ... ]

[-copyToLocal [-p] [-ignoreCrc] [-crc] ... ]

[-count [-q] ...]

[-cp [-f] [-p] ... ]

[-createSnapshot []]

[-deleteSnapshot ]

[-df [-h] [ ...]]

[-du [-s] [-h] ...]

[-expunge]

[-get [-p] [-ignoreCrc] [-crc] ... ]

[-getfacl [-R] ]

[-getmerge [-nl] ]

[-help [cmd ...]]

[-ls [-d] [-h] [-R] [ ...]]

[-mkdir [-p] ...]

[-moveFromLocal ... ]

[-moveToLocal ]

[-mv ... ]

[-put [-f] [-p] ... ]

[-renameSnapshot ]

[-rm [-f] [-r|-R] [-skipTrash] ...]

[-rmdir [--ignore-fail-on-non-empty] ...]

[-setfacl [-R] [{-b|-k} {-m|-x } ]|[--set ]]

[-setrep [-R] [-w] ...]

[-stat [format] ...]

[-tail [-f] ]

[-test -[defsz] ]

[-text [-ignoreCrc] ...]

[-touchz ...]

[-usage [cmd ...]]

3.3 常用命令实操

(1)-help:输出这个命令参数

bin/hdfs dfs -help rm

(2)-ls: 显示目录信息

hadoop fs -ls /

(3)-mkdir:在hdfs上创建目录

hadoop fs -mkdir -p /aaa/bbb/cc/dd

(4)-moveFromLocal从本地剪切粘贴到hdfs

hadoop fs - moveFromLocal /home/hadoop/a.txt /aaa/bbb/cc/dd

(5)-moveToLocal:从hdfs剪切粘贴到本地

hadoop fs - moveToLocal /aaa/bbb/cc/dd /home/hadoop/a.txt

(6)-appendToFile :追加一个文件到已经存在的文件末尾

hadoop fs -appendToFile ./hello.txt /hello.txt

(7)-cat :显示文件内容

hadoop fs -cat /user/intflag/input/liugx.txt

(8)-tail:显示一个文件的末尾

hadoop fs -tail /weblog/access_log.1

(9)-text:以字符形式打印一个文件的内容

hadoop fs -text /weblog/access_log.1

(10)-chgrp 、-chmod、-chown:linux文件系统中的用法一样,修改文件所属权限

hadoop fs -chmod 666 /hello.txt

hadoop fs -chown someuser:somegrp /hello.txt

(11)-copyFromLocal:从本地文件系统中拷贝文件到hdfs路径去

hadoop fs -copyFromLocal ./jdk.tar.gz /aaa/

(12)-copyToLocal:从hdfs拷贝到本地

hadoop fs -copyToLocal /aaa/jdk.tar.gz

(13)-cp :从hdfs的一个路径拷贝到hdfs的另一个路径

hadoop fs -cp /aaa/jdk.tar.gz /bbb/jdk.tar.gz.2

(14)-mv:在hdfs目录中移动文件

hadoop fs -mv /aaa/jdk.tar.gz /

(15)-get:等同于copyToLocal,就是从hdfs下载文件到本地

(15)-get:等同于copyToLocal,就是从hdfs下载文件到本地

(16)-getmerge :合并下载多个文件,比如hdfs的目录 /aaa/下有多个文件:log.1, log.2,log.3,…

hadoop fs -getmerge /aaa/log.* ./log.sum

(17)-put:等同于copyFromLocal

hadoop fs -put /aaa/jdk.tar.gz /bbb/jdk.tar.gz.2

(18)-rm:删除文件或文件夹

hadoop fs -rm -r /aaa/bbb/

(19)-rmdir:删除空目录

hadoop fs -rmdir /aaa/bbb/ccc

(20)-df :统计文件系统的可用空间信息

hadoop fs -df -h /

(21)-du统计文件夹的大小信息

hadoop fs -du -s -h /aaa/*

(22)-count:统计一个指定目录下的文件节点数量

hadoop fs -count /aaa/

(23)-setrep:设置hdfs中文件的副本数量

注意:这里设置的副本数只是记录在namenode的元数据中,是否真的会有这么多副本,还得看datanode的数量。因为目前只有3台设备,最多也就3个副本,只有节点数的增加到10台时,副本数才能达到10。

hadoop fs -setrep 3 /aaa/jdk.tar.gz