批量归⼀化

《动手学深度学习pytorch》部分学习笔记,仅用作自己复习。

批量归⼀化

本节我们介绍批量归一化(batch normalization)层,它能让较深的神经网络的训练变得更加容易。在实战Kaggle比赛:预测房价)里,我们对输入数据做了标准化处理:处理后的任意一个特征在数据集中所有样本上的均值为0、标准差为1。标准化处理输⼊数据使各个特征的分布相近:这往往更容易训练出有效的模型。

通常来说,数据标准化预处理对于浅层模型就足够有效了。随着模型训练的进⾏,当每层中参数更更新时,靠近输出层的输出较难出现剧烈烈变化。但对深层神经网络来说,即使输入数据已做标准化,训练中模型参数的更新依然很容易造成靠近输出层输出的剧烈变化。这种计算数值的不稳定性通常令我们难以训练出有效的深度模型。

批量归⼀化的提出正是为了应对深度模型训练的挑战。在模型训练时,批量归一化利用⼩批量上的均值和标准差,不断调整神经网络中间输出,从⽽使整个神经网络在各层的中间输出的数值更稳定。批量量归⼀化和将要介绍的残差网络为训练和设计深度模型提供了两类重要思路。

批量归一化层

对全连接层和卷积层做批量归⼀化的⽅法稍有不同。下面将分别介绍这两种情况下的批量归一化。

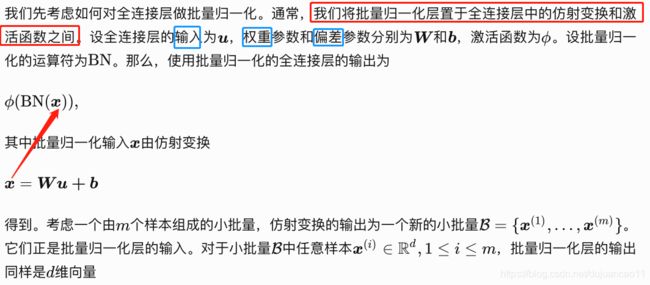

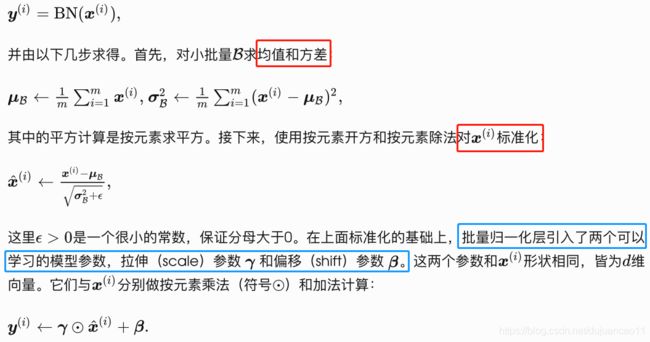

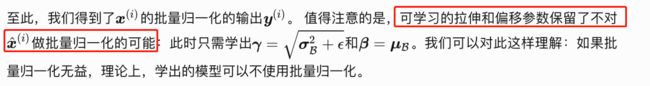

对全连接层做批量归一化

对卷积层做批量归一化

对卷积层来说,批量归⼀化发生在卷积计算之后、应用激活函数之前。如果卷积计算输出多个通道,我们需要对这些通道的输出分别做批量归⼀化,且每个通道都拥有独⽴的拉伸和偏移参数,并均为标量。设小批量中有 m个样本。在单个通道上,假设卷积计算输出的⾼和宽分别为 p和 q。我们需要对该通道中个元素同时做批量归一化。对这些元素做标准化计算时,我们使用相同的均值和⽅差,即该通道中 m x p x q个元素的均值和方差

预测时的批量归⼀化

使⽤批量归一化训练时,我们可以将批量⼤小设得⼤一点,从而使批量内样本的均值和⽅差的计算都较为准确。将训练好的模型⽤于预测时,我们希望模型对于任意输入都有确定的输出。因此,单个样本的输出不应取决于批量⼀化所需要的随机⼩批量中的均值和⽅差。⼀种常用的⽅法是通过移动平均估算整个训练数据集的样本均值和方差,并在预测时使用它们得到确定的输出。可见,和丢弃层一样,批量归一化层在训练模式和预测模式下的计算结果也是不一样的。

从零开始实现

import time

import torch

from torch import nn, optim

import torch.nn.functional as F

import sys

sys.path.append("..")

import d2lzh_pytorch as d2l

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

print(torch.__version__)

print(device)def batch_norm(is_training, X, gamma, beta, moving_mean, moving_var, eps, momentum):

# 判断当前模式是训练模式还是预测模式

if not is_training:

# 如果是在预测模式下,直接使用传入的移动平均所得的均值和方差

X_hat = (X - moving_mean) / torch.sqrt(moving_var + eps)

else:

assert len(X.shape) in (2, 4)

if len(X.shape) == 2:

# 1 使用全连接层的情况,计算特征维上的均值和方差

mean = X.mean(dim=0)

var = ((X - mean) ** 2).mean(dim=0)

else:

# 2 使用二维卷积层的情况,计算通道维上(axis=1)的均值和方差。这里我们需要保持

# X的形状以便后面可以做广播运算

mean = X.mean(dim=0, keepdim=True).mean(dim=2, keepdim=True).mean(dim=3, keepdim=True)

var = ((X - mean) ** 2).mean(dim=0, keepdim=True).mean(dim=2, keepdim=True).mean(dim=3, keepdim=True)

# 训练模式下用当前的均值和方差做标准化

X_hat = (X - mean) / torch.sqrt(var + eps)

# 更新移动平均的均值和方差

moving_mean = momentum * moving_mean + (1.0 - momentum) * mean

moving_var = momentum * moving_var + (1.0 - momentum) * var

Y = gamma * X_hat + beta # 拉伸和偏移

return Y, moving_mean, moving_var接下来,我们自定义⼀个 BatchNorm 层。它保存参与求梯度和迭代的拉伸参数 gamma 和偏移参数 beta ,同时也维护移动平均得到的均值和方差,以便能够在模型预测时被使用。 BatchNorm 实例所需指定的 num_features 参数对于全连接层来说应为输出个数,对于卷积层来说则为输出通道数。该实例所需指定的 num_dims 参数对于全连接层和卷积层来说分别为2和4。

class BatchNorm(nn.Module):

# 初始化

def __init__(self, num_features, num_dims):

super(BatchNorm, self).__init__()

if num_dims == 2:

shape = (1, num_features)

else:

shape = (1, num_features, 1, 1)

# 参与求梯度和迭代的拉伸和偏移参数,分别初始化成0和1

self.gamma = nn.Parameter(torch.ones(shape))

self.beta = nn.Parameter(torch.zeros(shape))

# 不参与求梯度和迭代的变量,全在内存上初始化成0

self.moving_mean = torch.zeros(shape)

self.moving_var = torch.zeros(shape)

# 前向传播

def forward(self, X):

# 如果X不在内存上,将moving_mean和moving_var复制到X所在显存上

if self.moving_mean.device != X.device:

self.moving_mean = self.moving_mean.to(X.device)

self.moving_var = self.moving_var.to(X.device)

# 保存更新过的moving_mean和moving_var, Module实例的traning属性默认为true, 调用.eval()后设成false

Y, self.moving_mean, self.moving_var = batch_norm(self.training,

X, self.gamma, self.beta, self.moving_mean,

self.moving_var, eps=1e-5, momentum=0.9)

return Y使用批量归⼀化层的LeNet

下⾯修改卷积神经⽹网络(LeNet)介绍的LeNet模型,从⽽应⽤批量归⼀化层。我们在所有的卷积层或全连接层之后、激活层之前加⼊批量归⼀化层。

net = nn.Sequential(

nn.Conv2d(1, 6, 5), # in_channels, out_channels, kernel_size

BatchNorm(6, num_dims=4),

nn.Sigmoid(),

nn.MaxPool2d(2, 2), # kernel_size, stride

nn.Conv2d(6, 16, 5),

BatchNorm(16, num_dims=4),

nn.Sigmoid(),

nn.MaxPool2d(2, 2),

d2l.FlattenLayer(),

nn.Linear(16*4*4, 120),

BatchNorm(120, num_dims=2),

nn.Sigmoid(),

nn.Linear(120, 84),

BatchNorm(84, num_dims=2),

nn.Sigmoid(),

nn.Linear(84, 10)

)训练修改后的模型。

batch_size = 256

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size=batch_size)

lr, num_epochs = 0.001, 5

optimizer = torch.optim.Adam(net.parameters(), lr=lr)

d2l.train_ch5(net, train_iter, test_iter, batch_size, optimizer, device, num_epochs)输出:

training on cuda

epoch 1, loss 0.0039, train acc 0.790, test acc 0.835, time 2.9 sec

epoch 2, loss 0.0018, train acc 0.866, test acc 0.821, time 3.2 sec

epoch 3, loss 0.0014, train acc 0.879, test acc 0.857, time 2.6 sec

epoch 4, loss 0.0013, train acc 0.886, test acc 0.820, time 2.7 sec

epoch 5, loss 0.0012, train acc 0.891, test acc 0.859, time 2.8 sec最后我们查看第一个批量归⼀化层学习到的拉伸参数 gamma 和偏移参数 beta

net[1].gamma.view((-1,)), net[1].beta.view((-1,))输出:

(tensor([ 1.2537, 1.2284, 1.0100, 1.0171, 0.9809, 1.1870], device='cuda:0'),

tensor([ 0.0962, 0.3299, -0.5506, 0.1522, -0.1556, 0.2240], device='cuda:0'))简洁实现

与我们刚刚⾃己定义的BatchNorm 类 相比 , Pytorch 中 nn 模 块 定 义 的 BatchNorm1d 和BatchNorm2d 类使⽤用起来更加简单,⼆者分别⽤于全连接层和卷积层,都需要指定输入的num_features 参数值。下面我们用PyTorch实现使⽤批量归⼀化的LeNet。

net = nn.Sequential(

nn.Conv2d(1, 6, 5), # in_channels, out_channels, kernel_size

nn.BatchNorm2d(6),

nn.Sigmoid(),

nn.MaxPool2d(2, 2), # kernel_size, stride

nn.Conv2d(6, 16, 5),

nn.BatchNorm2d(16),

nn.Sigmoid(),

nn.MaxPool2d(2, 2),

d2l.FlattenLayer(),

nn.Linear(16*4*4, 120),

nn.BatchNorm1d(120),

nn.Sigmoid(),

nn.Linear(120, 84),

nn.BatchNorm1d(84),

nn.Sigmoid(),

nn.Linear(84, 10)

)使⽤同样的超参数进行训练。

training on cuda

epoch 1, loss 0.0054, train acc 0.767, test acc 0.795, time 2.0 sec

epoch 2, loss 0.0024, train acc 0.851, test acc 0.748, time 2.0 sec

epoch 3, loss 0.0017, train acc 0.872, test acc 0.814, time 2.2 sec

epoch 4, loss 0.0014, train acc 0.883, test acc 0.818, time 2.1 sec

epoch 5, loss 0.0013, train acc 0.889, test acc 0.734, time 1.8 sec

小结

- 在模型训练时,批量归⼀化利用小批量上的均值和标准差,不断调整神经网络的中间输出,从⽽使整个神经网络在各层的中间输出的数值更稳定。

- 对全连接层和卷积层做批量归一化的⽅法稍有不同。

- 批量归一化层和丢弃层⼀样,在训练模式和预测模式的计算结果是不⼀样的。

- PyTorch提供了了BatchNorm类⽅便使用。