Android 快速集成手部关键点识别能力 超简单

前言

之前在《用华为HMS ML kit人体骨骼识别技术,Android快速实现人体姿势动作抓拍》文章中,我们给大家介绍了HMS ML Kit人体骨骼识别技术,可以定位头顶、脖子、肩、肘、手腕、髋、膝盖、脚踝等多个人体关键点。那么除了识别人体关键点以外,HMS ML Kit还为开发者提供了手部关键点识别技术,可以定位包括手指指尖、关节点,以及手腕点等21个手部关键点,让人机交互的体验更加丰富。

应用场景

手部关键点识别技术在生活中有很多的应用场景。比如拍摄短视频的软件在集成了这种技术后,可以根据手部关键点生成一些可爱或者搞笑的特效,增加短视频的趣味性。

或者是在面向智能家居的场景中,可以自定义一些手势作为智能家电的远距离操控指令,进行一些更加智能的人机交互方式。

开发实战

下面给大家介绍如何快速集成华为HMS ML Kit手部关键点识别技术,以视频流识别为例。

1. 开发准备

详细的准备步骤可以参考华为开发者联盟:

https://developer.huawei.com/consumer/cn/doc/development/HMS-Guides/ml-process-4

这里列举关键的开发步骤。

1.1 项目级gradle里配置Maven仓地址

buildscript {

repositories {

...

maven {

url 'https://developer.huawei.com/repo/'}

}

}

dependencies {

...

classpath 'com.huawei.agconnect:agcp:1.3.1.300'

}

allprojects {

repositories {

...

maven {

url 'https://developer.huawei.com/repo/'}

}

}

1.2 应用级gradle里配置SDK依赖

dependencies{

// 引入基础SDK

implementation 'com.huawei.hms:ml-computer-vision-handkeypoint:2.0.2.300'

// 引入手部关键点检测模型包

implementation 'com.huawei.hms:ml-computer-vision-handkeypoint-model:2.0.2.300'

}

1.3 在文件头添加配置

apply plugin: 'com.android.application'

apply plugin: 'com.huawei.agconnect'

1.4 添加如下语句到AndroidManifest.xml文件中,自动更新机器学习模型到设备

<meta-data

android:name="com.huawei.hms.ml.DEPENDENCY"

android:value= "handkeypoint"/>

1.5 申请相机权限和读取本地文件权限

<!--相机权限-->

<uses-permission android:name="android.permission.CAMERA" />

<!--读权限-->

<uses-permission android:name="android.permission.READ_EXTERNAL_STORAGE" />

2. 代码开发

2.1 创建手部关键点分析器

MLHandKeypointAnalyzerSetting setting = new MLHandKeypointAnalyzerSetting.Factory()

// MLHandKeypointAnalyzerSetting.TYPE_ALL表示所有结果都返回。

// MLHandKeypointAnalyzerSetting.TYPE_KEYPOINT_ONLY表示只返回手部关键点信息。

// MLHandKeypointAnalyzerSetting.TYPE_RECT_ONLY表示只返回手掌区域信息。

.setSceneType(MLHandKeypointAnalyzerSetting.TYPE_ALL)

// 设置同一张图片中最多支持检测的手部区域个数。默认最多支持10个手部区域信息检测。

.setMaxHandResults(1)

.create();

MLHandKeypointAnalyzer analyzer = MLHandKeypointAnalyzerFactory.getInstance().getHandKeypointAnalyzer(setting);

2.2 开发者创建识别结果处理类“HandKeypointTransactor”,该类实现MLAnalyzer.MLTransactor接口,使用此类中的“transactResult”方法获取检测结果并实现具体业务。检测结果除了包含每个手指点的坐标信息外,还包括手掌置信度,以及每个点的置信度值,可以基于置信度值过滤误识别的无效手掌,实际应用中可根据对误识别的容忍程度,设置阙值灵活应用。

public class HandKeypointTransactor implements MLAnalyzer.MLTransactor<List<MLHandKeypoints>> {

@Override

public void transactResult(MLAnalyzer.Result<List<MLHandKeypoints>> results) {

SparseArray<List<MLHandKeypoints>> analyseList = result.getAnalyseList();

// 开发者根据需要处理识别结果,需要注意,这里只对检测结果进行处理。

// 不可调用ML Kit提供的其他检测相关接口。

}

@Override

public void destroy() {

// 检测结束回调方法,用于释放资源等。

}

}

2.3 设置识别结果处理器,实现分析器与结果处理器的绑定。

analyzer.setTransactor(new HandKeypointTransactor());

2.4 创建LensEngine,该类由ML Kit SDK提供,用于捕捉相机动态视频流并传入分析器。建议设置的相机显示尺寸不小于320320像素,不大于19201920像素。

2.5 调用run方法,启动相机,读取视频流,进行识别。

// 请自行实现SurfaceView控件的其他逻辑。

SurfaceView mSurfaceView = findViewById(R.id.surface_view);

try {

lensEngine.run(mSurfaceView.getHolder());

} catch (IOException e) {

// 异常处理逻辑。

}

2.6 检测完成,停止分析器,释放检测资源。

if (analyzer != null) {

analyzer.stop();

}

if (lensEngine != null) {

lensEngine.release();

}

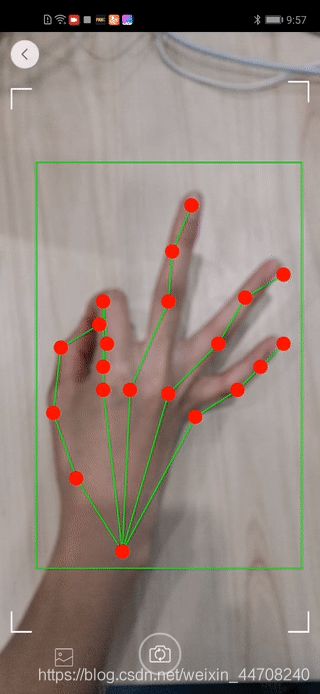

Demo效果

下面这个demo展示了不同手势时手部关键点识别的效果,开发者可根据实际开发需要进行拓展。

Github源码

https://github.com/HMS-Core/hms-ml-demo/blob/master/MLKit-Sample/module-body/src/main/java/com/mlkit/sample/activity/HandKeypointActivity.java

更详细的开发指南参考华为开发者联盟官网

https://developer.huawei.com/consumer/cn/hms/huawei-mlkit

欲了解更多详情,请参阅:

华为开发者联盟官网:https://developer.huawei.com/consumer/cn/hms

获取开发指导文档:https://developer.huawei.com/consumer/cn/doc/development

参与开发者讨论请到Reddit社区:https://www.reddit.com/r/HMSCore/

下载demo和示例代码请到Github:https://github.com/HMS-Core

解决集成问题请到Stack Overflow:https://stackoverflow.com/questions/tagged/huawei-mobile-services?tab=Newest

原文链接:https://developer.huawei.com/consumer/cn/forum/topicview?tid=0203346162792430439&fid=18

作者:留下落叶