关于散列表的代码实现及下边实践部分的代码实现均可从我的Github获取(欢迎star^_^)

散列思想

概念

散列表(Hash Table),也可以叫它哈希表或者Hash表

散列表用的是数组支持按照下标随机访问数据的特性,所以散列表其实就是数组的一种扩展,由数组演化而来。可以说,如果没有数组,就没有散列表

举例

假设全校有1000名学生,为了方便记录他们的期末成绩,会给每个学生一个编号,编号从1~1000。现在如果要实现通过编号来找到具体的学生

可以把这1000个学生的信息放在数组里。编号为1的学生,放到数组中下标为1的位置;编号为2的学生,放到数组中下标为2的位置。以此类推,编号为k的学生放到数组中下标为k的位置

因为编号跟数组下标一一对应,当我们需要查询编号为x的学生的时候,只需要将下标为x的数组元素取出来就可以了,时间复杂度就是O(1)

实际上,这个例子已经用到了散列的思想。在这个例子里,编号是自然数,并且与数组的下标形成一一映射,所以利用数组支持根据下标随机访问的特性,查找的时间复杂度是O(1) ,就可以实现快速查找编号对应的学生信息

但是,上边这个例子用到的散列思想不够明显,改一下

假设编号不能设置得这么简单,要加上年级、班级这些更详细的信息,所以这里把编号的规则稍微修改了一下,用8位数字来表示。比如05110067,其中,前两位05表示年级,中间两位11表示班级,最后四位还是原来的编号1到1000。这个时候该如何存储学生信息,才能够支持通过编号来快速查找学生信息呢?

思路还是跟前面类似。尽管不能直接把编号作为数组下标,但可以截取编号的后四位作为数组下标,来存取学生信息数据。当通过编号查询学生信息的时候,用同样的方法,取编号的后四位,作为数组下标,来读取数组中的数据

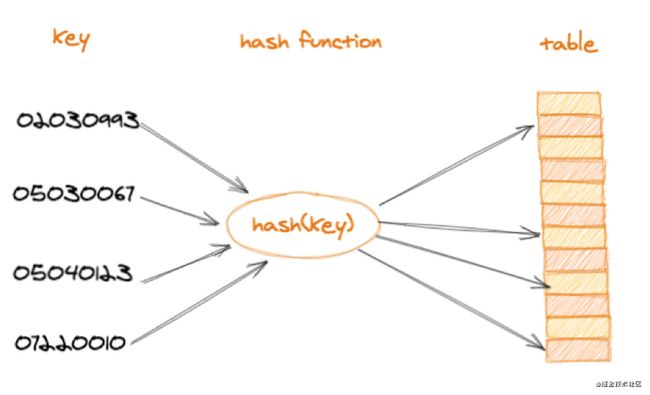

这就是典型的散列思想。其中,学生的编号叫作键(key)或者关键字。用它来标识一个学生。把学生编号转化为数组下标的映射方法就叫作散列函数(或“Hash函数”“哈希函数”),而散列函数计算得到的值就叫作散列值(或“Hash 值”“哈希值”)

总结

散列表用的就是数组支持按照下标随机访问的时候,时间复杂度是O(1)的特性。通过散列函数把元素的键值映射为下标,然后将数据存储在数组中对应下标的位置。当按照键值查询元素时,用同样的散列函数,将键值转化数组下标,从对应的数组下标的位置取数据

散列函数

概念

散列函数,顾名思义,它是一个函数。可以把它定义成hash(key) ,其中key表示元素的键值,hash(key)的值表示经过散列函数计算得到的散列值

在上边的例子中,编号就是数组下标,所以hash(key)就等于 key。改造后的例子,写成散列函数就像下边这样

func hash(key string) int {

hashValue,_ := strconv.Atoi(key[len(key)-4:])

return hashValue

}散列函数基本要求

上边的的例子,散列函数比较简单,也比较容易想到。但是,如果学生的编号是随机生成的6位数字,又或者用的是a到z之间的字符串,这种情况,散列函数就会复杂一些

散列函数设计的基本要求

- 散列函数计算得到的散列值是一个非负整数

- 如果key1 = key2,那hash(key1) == hash(key2)

- 如果key1 ≠ key2,那hash(key1) ≠ hash(key2)

第一点理解起来应该没有任何问题。因为数组下标是从0开始的,所以散列函数生成的散列值也要是非负整数。第二点也很好理解。相同的key,经过散列函数得到的散列值也应该是相同的

第三点理解起来可能会有问题。这个要求看起来合情合理,但是在真实的情况下,要想找到一个不同的key对应的散列值都不一样的散列函数,几乎是不可能的。即便像业界著名的MD5、SHA、CRC等哈希算法,也无法完全避免这种散列冲突。而且,因为数组的存储空间有限,也会加大散列冲突的概率

所以,几乎无法找到一个完美的无冲突的散列函数,即便能找到,付出的时间成本、计算成本也是很大的,所以针对散列冲突问题,需要通过其他途径来解决

散列冲突

开放寻址法

开放寻址法的核心思想是,如果出现了散列冲突,就重新探测一个空闲位置,将其插入。

重新探测一个空闲位置的方法有好几个,这里以线性探测举例

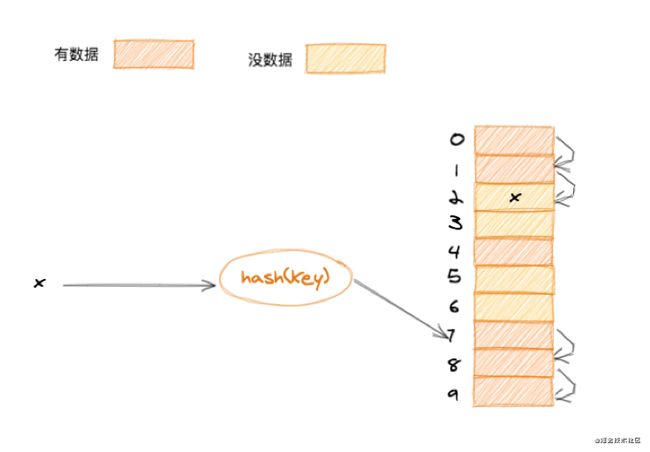

当往散列表中插入数据时,如果某个数据经过散列函数散列之后,存储位置已经被占用了,就从当前位置开始,依次往后查找,看是否有空闲位置,直到找到为止。看下图

从图中可以看出,散列表的大小为10,在元素x插入散列表之前,已经有6个元素插入到散列表中。x经过hash算法之后,被散列到下标为7的位置,但是这个位置已经有数据了,所以就产生了冲突。于是就顺序地往后一个一个找,看有没有空闲的位置,遍历到尾部都没有找到空闲的位置,于是再从表头开始找,直到找到空闲位置2,于是将其插入到这个位置

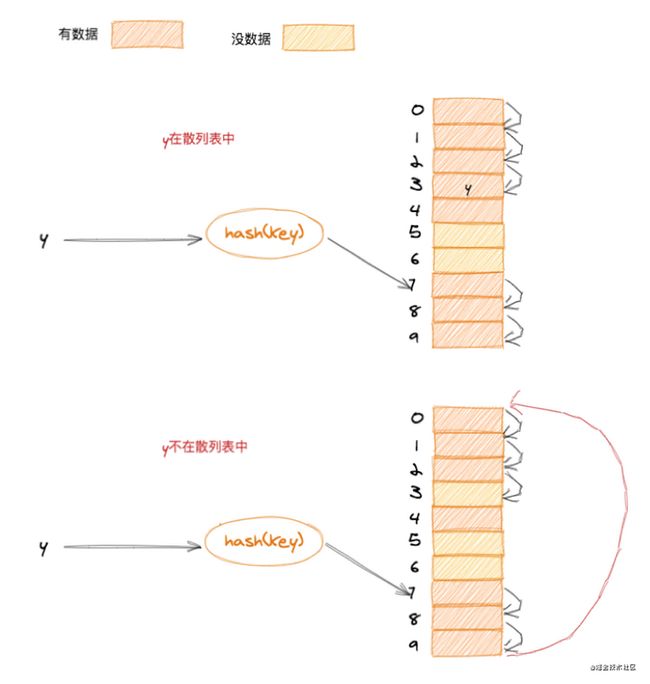

在散列表中查找元素的过程类似插入过程。通过散列函数求出要查找元素的键值对应的散列值,然后比较数组中下标为散列值的元素和要查找的元素。如果相等,则说明就是我们要找的元素;否则就顺序往后依次查找。如果遍历到数组中的空闲位置,还没有找到,就说明要查找的元素并没有在散列表中

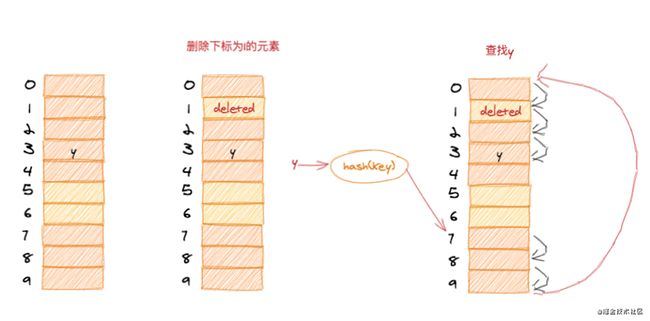

散列表和数组一样,也支持插入、查找、删除操作,但是对于线性探测方法解决散列冲突,在进行删除操作时比较特殊,不能单纯地把要删除的元素设置为空

上边在说散列表的查找操作时,通过线性探测的方式找到一个空闲位置,然后就认定散列表中不存在该数据。如果说这个空闲位置是后来删除的,就会导致原来的线性探测有问题,可能本来存在的数据,以为不存在了

这种情况下,就需要将删除的元素加一个删除的标记。在进行线性探测的时候,如果遇到删除标记的元素,则继续向下探测

小伙伴肯定已经看出问题了,当散列表中插入的数据越来越多时,散列冲突发生的可能性就会越来越大,空闲位置会越来越少,线性探测的时间就会越来越久。极端情况下,可能需要探测整个散列表,所以最坏情况下的时间复杂度为O(n)。同理,在删除和查找时,也有可能会线性探测整张散列表,才能找到要查找或者删除的数据

对于开放寻址冲突解决方法,除了线性探测方法之外,还有另外两种比较经典的探测方法,二次探测(Quadratic probing)和双重散列(Double hashing)

二次探测

二次探测跟线性探测很像,线性探测每次探测的步长是1,它探测的下标序列就是hash(key)+0,hash(key)+1,hash(key)+2……而二次探测探测的步长就变成了原来的“二次方”,它探测的下标序列是hash(key)+0,hash(key)+1^2,hash(key)+2^2,hash(key)+3^2……

双重散列

双重散列意思就是不仅要使用一个散列函数。使用一组散列函数 hash1(key),hash2(key),hash3(key)……先用第一个散列函数,如果计算得到的存储位置已经被占用,再用第二个散列函数,依次类推,直到找到空闲的存储位置

开放寻址法总结

不管采用哪种探测方法,当散列表中空闲位置不多的时候,散列冲突的概率就会大大提高。为了尽可能保证散列表的操作效率,一般情况下,会尽可能保证散列表中有一定比例的空闲槽位。用装载因子(load factor)来表示空位的多少

装载因子的计算公式

散列表的装载因子 = 填入表中的元素个数 / 散列表的长度装载因子越大,说明空闲位置越少,冲突越多,散列表的性能会下降

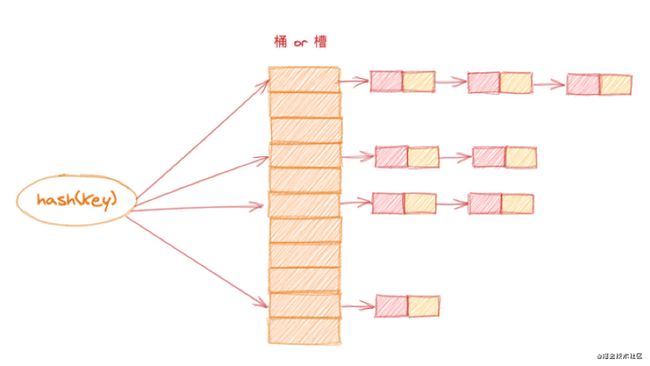

链表法

链表法是一种更加常用的散列冲突解决办法,相比开放寻址法,它比较简单。在散列表中,每个“桶(bucket)”或者“槽(slot)”会对应一条链表,所有散列值相同的元素都放到相同槽位对应的链表中

当插入的时候,只需要通过散列函数计算出对应的散列槽位,将其插入到对应链表中即可,所以插入的时间复杂度是O(1)。当查找、删除一个元素时,同样通过散列函数计算出对应的槽,然后遍历链表查找或者删除

对于查找和删除操作,时间复杂度跟链表的长度k成正比,也就是 O(k)。对于散列比较均匀的散列函数来说,理论上讲,k=n/m,其中n表示散列中数据的个数,m表示散列表中“槽”的个数

实践

假设我们有10万条URL访问日志,如何按照访问次数给URL排序?

遍历10万条数据,以URL为key,访问次数为value,存入散列表,同时记录下访问次数的最大值K,时间复杂度O(N)

如果K不是很大,可以使用桶排序,时间复杂度O(N)。如果 K 非常大(比如大于10万),就使用快速排序,复杂度O(NlogN)

由于文章篇幅的原因,代码实现,我放在了github上,需要的可以自取(GO实现)

有两个字符串数组,每个数组大约有10万条字符串,如何快速找出两个数组中相同的字符串?

以第一个字符串数组构建散列表,key 为字符串,value 为出现次数。再遍历第二个字符串数组,以字符串为 key 在散列表中查找,如果 value 大于零,说明存在相同字符串。时间复杂度 O(N)