OpenCV3学习笔记

OpenCV3学习笔记

- 一、OpenCV数据类型

-

- 1. 大型数组类型

-

- 1.1 Mat类

- 1.2 SparseMat类

- 二、Mat类基础操作

-

- 1. 图像的读写

-

- 1.1 读取

- 1.2 写入

- 2. 创建一个Mat类

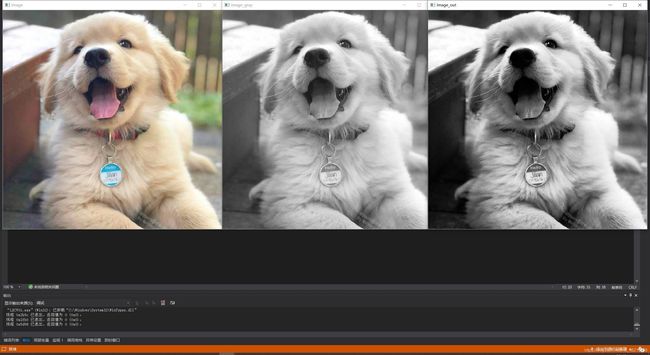

- 3. 色彩空间转换

- 4. 图像像素指针&掩膜操作(Mask)的实现

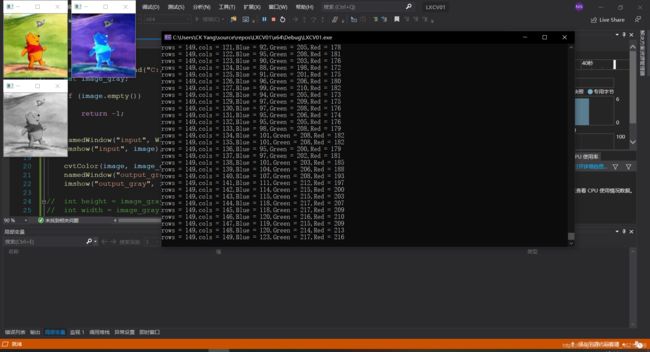

- 5. 像素数据的读写&修改

- 6. 图像的线性混合

- 7. 对比度&亮度增强——点操作

- 8. 绘制基础图型

-

- 8.1 图形&文字绘制

- 8.2 随机线生成

- 8.3 椒盐噪声

- 9. 图像模糊

-

- 9.1 均值模糊&高斯模糊:

- 9.2 中值滤波&双边滤波

- 10. 形态学操作

-

- 10.1 膨胀与腐蚀

- 10.2 开、闭、形态学梯度、顶帽、黑帽:

- 10.3 水平&竖直线条提取:

- 11. 图像的升采样和降采样、高斯不同

- 12. 阈值操作

- 13. 自定义线性滤波

- 14. 图像边缘提取

-

- 14.1 Sobel算子 & Scharr算子

- 14.2 Laplance算子

- 14.3 Canny算子

- 15.基础图形检测

-

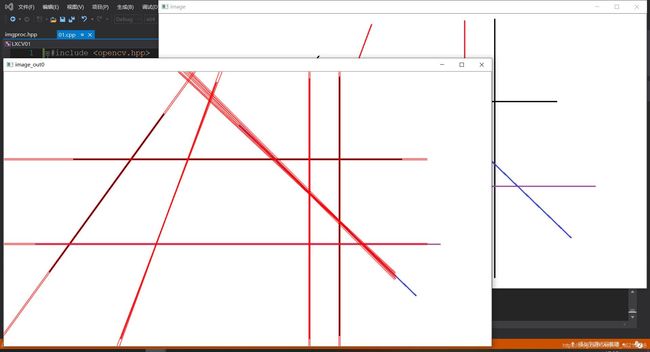

- 15.1 霍夫变换——直线检测

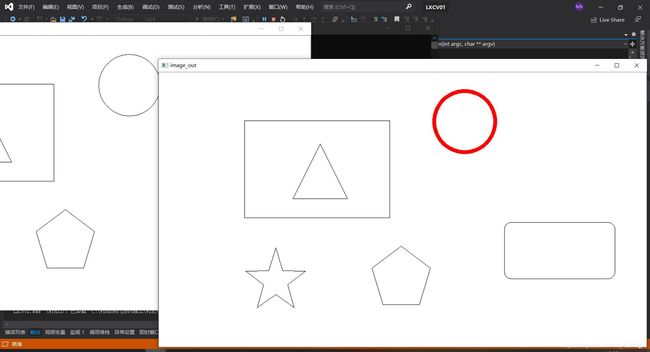

- 15.2 霍夫变换——圆

- 16. 像素重映射

- 17.灰度直方图

-

- 17.1 直方图均衡化

- 17.2 直方图计算

一、OpenCV数据类型

- 第一类是直接从C++中继承的基础数据类型(如int和float等)。这些类型包括简单的数组和矩阵,一些简单的几何概念,比如点、矩形、大小等;

- 第二类是辅助对象。这同时也代表些对象代表更抽象的概念, 比如垃圾收集指针类、用于数据切片的范围对象 (range objects) 以及抽象的终止条件类等;

- 第三类可以称为大型数组类型。这些对象原本目的是涵盖数组或一些其他的原语、 程序集或更常见的基础数据类型。这一类的典型代表是cv::Mat类,该类用来代表任意维度的包含任意基础元素的数组。存储图片对象是cv::Mat类的特殊用途。

为快速上手,先从第三类的Mat类开始。

1. 大型数组类型

比较具有代表性的是 cv::Mat和cv::SparseMat 类型。

-

cv::Mat针对的是密集连续性的存储,大多数的图像数据被存储为这种类,即使数据为空,预留的存储空间仍然存在;

-

cv::SparseMat针对的是稀疏的存储方式,只有数据不为0才保留空间,否则不会预留。显然cv::SparseMat存储更为节省空间,典型使用cv::SparseMat的例如直方图数据的存储。

1.1 Mat类

Mat 是一个类,由两个数据部分组成:

-

矩阵头(包含矩阵尺寸,存储方法,存储地址等信息)

-

一个指向存储所有像素值的矩阵(根据所选存储方法的不同矩阵可以是不同的维数)的指针。

1.2 SparseMat类

二、Mat类基础操作

1. 图像的读写

1.1 读取

imread功能是加载图像文件成为一个Mat对象,其中:

第一个参数为图像文件的路径;

第二个参数,表示加载的图像是什么类型,支持常见的三个参数值:

- IMREAD_UNCHANGED (<0) 表示加载原图,不做任何改变

- IMREAD_GRAYSCALE (=0)表示把原图作为灰度图像加载进来

- IMREAD_COLOR (>0) 表示把原图作为RGB图像加载进来

注意:OpenCV支持JPG、PNG、TIFF等常见格式图像文件加载。

同时用到的函数还有:

- namedWindow:功能是创建一个OpenCV窗口,它是由OpenCV自动创建与释放,你无需取销毁它。常见用法是:

namedWindow(“Window Title”, WINDOW_AUTOSIZE)。

— WINDOW_AUTOSIZE,会自动根据图像大小,显示窗口大小,不能人为改变窗口大小;

— WINDOW_NORMAL,跟QT集成的时候会使用,允许修改窗口大小。 - destroyWindow:功能是销毁指定的窗口。

- imshow:根据窗口名称显示图像到指定的窗口上去,第一个参数是窗口名称,第二参数是Mat对象

//加载图像

#include //加载为灰度图

#include 1.2 写入

imwrite功能是保存图像文件到指定目录路径,有三个参数:

-

第一个参数表示需要写入的路径&文件名,必须要加上后缀,比如“123.png”;

-

第二个参数表示Mat类型的图像数据,是你要保存的对象。

-

第三个参数表示为特定格式保存的参数编码,它有一个默认值std::vector< int >(),所以一般情况下不用写。

注意:只有8位、16位的PNG、JPG、Tiff文件格式而且是单通道或者三通道的BGR的图像才可以通过这种方式保存,保存PNG格式的时候可以保存透明通道的图片

#include 2. 创建一个Mat类

- Mat对象构造函数:Mat()

- Mat对象构造方法:A.create()

赋值一个全为0的Mat:img = Scalar(0)。

//三种建立Mat类的方式

#include 创建Mat类型的函数十分灵活:

#include 还可通过imread(“C:/2.jpg”);的方式建立图像的Mat

#include Mat的type和depth:

例:CV_32FC3——表示的是元素类型是一个32位的浮点数,通道为3。

- 数据类型中:

U(unsigned integer)表示的是无符号整数,

S(signed integer)是有符号整数,

F(float)是浮点数。 - 通道数中:C1,C2,C3,C4则表示通道数是1,2,3,4。

type一般是在创建Mat对象时设定,如果要取得Mat的元素类型,则无需使用type,使用depth:

depth是矩阵中元素的一个通道的数据类型,这个值和type是相关的。

例如: type为 CV_16SC2,一个2通道的16位的有符号整数。那么,depth则是CV_16S。

- depth:将type的值去掉通道信息就是depth值:CV_8U、CV_16S、CV_32F、CV_64F。

- elemSize:矩阵一个元素占用的字节数,例如:type是CV_16SC3,那么elemSize = 3 * 16 / 8 = 6

bytes - elemSize1:矩阵元素一个通道占用的字节数,例如:type是CV_16CS3,那么elemSize1 = 16 / 8 = 2

bytes = elemSize / channels

常用方法:

- void copyTo(Mat):完全复制;

- Mat clone():完全复制;

- void convertTo(Mat, int type):转换Mat为指定type;

- int type():查看Mat的type;

- size():查看Mat的size;

- int channels():查看Mat的channels;

- int depth():查看Mat的depth;

- bool empty():查看Mat是否为empty;

- uchar* ptr(i=0):像素指针。

注:

部分复制:一般情况下只会复制Mat对象的头和指针部分,不会复制数据部分

- Mat A= imread(imgFilePath);

- Mat B(A)

完全复制:如果想把Mat对象的头部和数据部分一起复制,可以通过如下两个API实现

- Mat F = A.clone();

- Mat G;

A.copyTo(G);

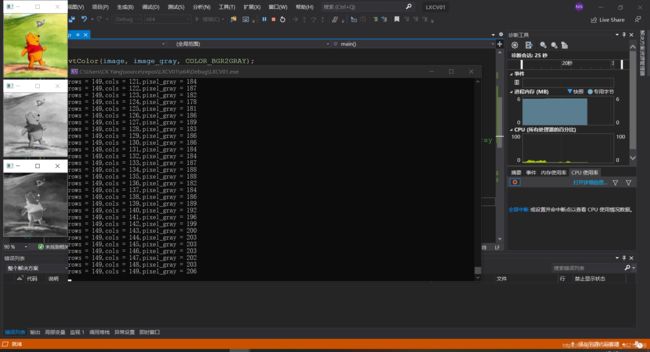

#include 3. 色彩空间转换

cvtColor( image, gray_image, COLOR_BGR2GRAY )

cvtColor功能是把图像从一个彩色空间转换到另外一个色彩空间,有三个参数:

-

第一个参数表示源图像;

-

第二参数表示色彩空间转换之后的图像;

-

第三个参数表示源和目标色彩空间如:COLOR_BGR2HLS 、COLOR_BGR2GRAY 等。

#include 4. 图像像素指针&掩膜操作(Mask)的实现

Mat.ptr(int i=0) 功能是获取像素矩阵的指针,索引 i 表示行数,从0开始计数。

- 获得当前行指针const uchar* current= myImage.ptr< uchar>(row);

- 获取当前像素点P(row, col)的像素值 p(row, col) = current[col]。

注意:掩膜Mask也被称之为Kernel。

实现一个下图的掩膜操作,功能是提高图像的对比度:

这能干嘛?我下载的某个PDF文档看着比较瞎眼,就可以用这个来让它看着没那么瞎眼。

saturate_cast< uchar>()是像素范围处理函数,功能是确保RGB值的范围在0~255之间。

- saturate_cast(-100),返回 0;

- saturate_cast(288),返回255;

- saturate_cast(100),返回100。

#include

除了利用图像像素指针进行掩膜操作,还能用OpenCV的api完成同样的操作,操作步骤:

- 定义掩膜:Mat kernel = (Mat_(3,3) << 0, -1, 0, -1, 5, -1, 0, -1,

0); - 调用filter2D( image, image_output, src.depth(), kernel):

其中image和 image_output是Mat类型变量;

src.depth表示位图深度,有32、24、8等,根据图像属性变化;

kernel是刚才定义的掩膜。

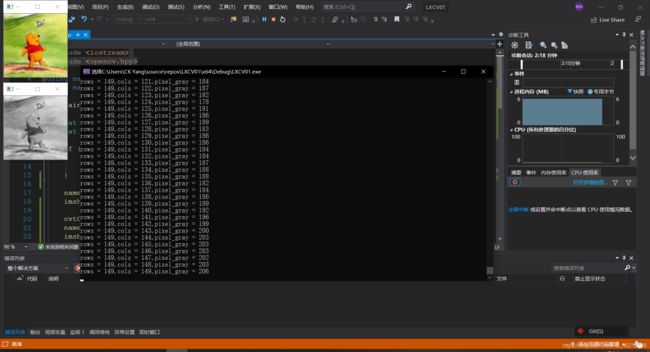

#include 5. 像素数据的读写&修改

- 灰度图像:只有1个通道,可直接赋值修改。

img.at(y, x) = 128;

//获取灰度图像的像素值

#include //灰度图像颜色反转

#include - RGB三通道图像:分通道逐个修改。

img.at(y,x)[0]=128; // blue

img.at(y,x)[1]=128; // green

img.at(y,x)[2]=128; // red

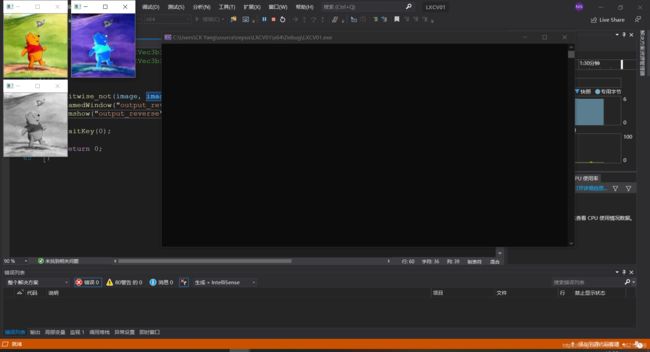

彩色像素值的修改,以颜色反转为例:

//rgb图像颜色反转

#include

注意:OpenCV中有api可以实现图片色彩反转:bitwise_not(image, image_out);

//利用bitwise_not(image, image_out);进行色彩反转

#include - Vec3b对应三通道的顺序是blue、green、red的uchar类型数据;

- Vec3f对应三通道的顺序是blue、green、red的float类型数据;

- 把CV_8UC1转换到CV32F1实现如下:

Mat.convertTo(dst, CV_32F)。

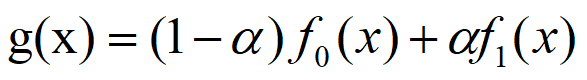

6. 图像的线性混合

f0——第一张图像;

f1——第二张图像;

α——混合参数。

相关api:addWeighted(),作用就是线性混合。

- 参数1:输入图像Mat

- 参数2:输入图像的alpha值

- 参数3:输入图像Mat

- 参数4:输入图像的alpha值

- 参数5:gamma值

- 参数6:输出图像Mat

注意:两张图像的大小和类型必须一致才可以进行操作。

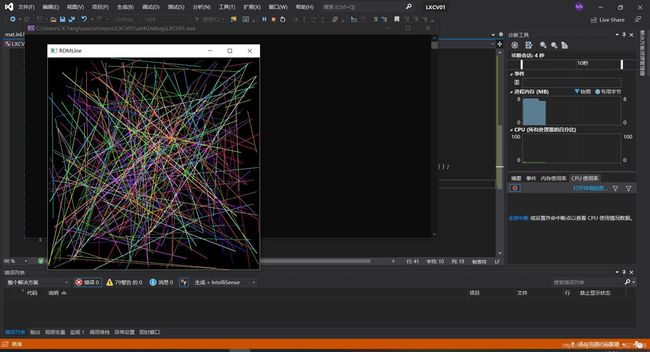

#include 权重不同,混合程度也不同,结果如下:

alpha = 0.25

alpha = 0.75

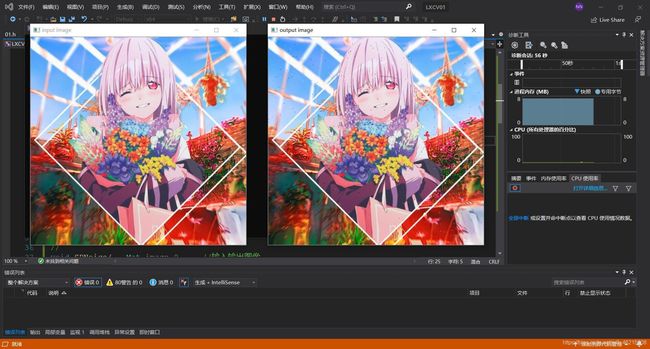

7. 对比度&亮度增强——点操作

图像变换可以看作如下:

- 像素变换 – 点操作;

- 邻域操作 – 区域。

调整图像亮度和对比度属于像素变换-点操作。

- alpha——对比度

- beta——亮度

相关api:

- Mat new_image = Mat::zeros( image.size(), image.type() );

创建一张跟原图像大小和类型一致的空白图像、像素值初始化为0 - saturate_cast(value)确保值大小范围为0~255之间

- Mat.at(y,x)[index]=value 给每个像素点每个通道赋值

#include (row, col)[0];会报错,需要先convertTo CV_32FC3类型再image_cvt2F.at(row, col)[0];即可

for (int row = 0; row < height; row++) {

for (int col = 0; col < width; col++) {

if (image.channels() == 3) {

float pixel_b = image_cvt2F.at<Vec3f>(row, col)[0];

float pixel_g = image_cvt2F.at<Vec3f>(row, col)[1];

float pixel_r = image_cvt2F.at<Vec3f>(row, col)[2];

image_out.at<Vec3f>(row, col)[0] = saturate_cast<uchar>(pixel_b * alpha + beta);

image_out.at<Vec3f>(row, col)[1] = saturate_cast<uchar>(pixel_g * alpha + beta);

image_out.at<Vec3f>(row, col)[2] = saturate_cast<uchar>(pixel_r * alpha + beta);

}

else if(image.channels() == 1) {

int pixel_gray = image.at<uchar>(row, col);

image_out.at<uchar>(row, col) = saturate_cast<uchar>(pixel_gray * alpha + beta);

}

}

}

namedWindow("output", WINDOW_AUTOSIZE);

imshow("output", image_out);

waitKey(0);

cvDestroyAllWindows();

return 0;

}

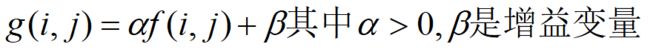

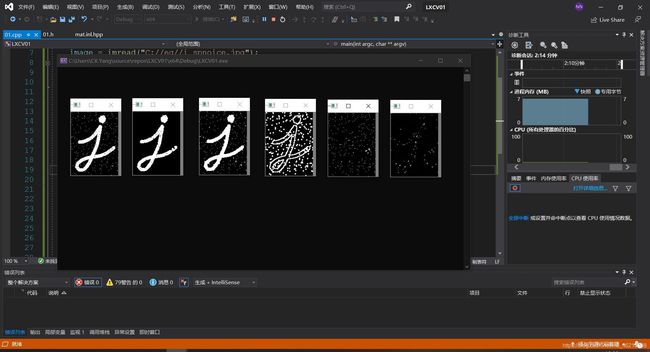

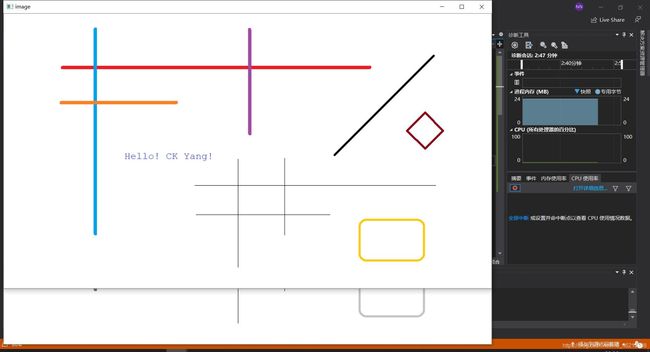

8. 绘制基础图型

8.1 图形&文字绘制

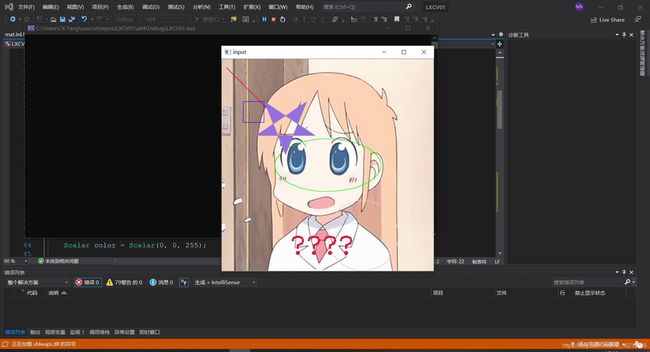

#include 8.2 随机线生成

#include 8.3 椒盐噪声

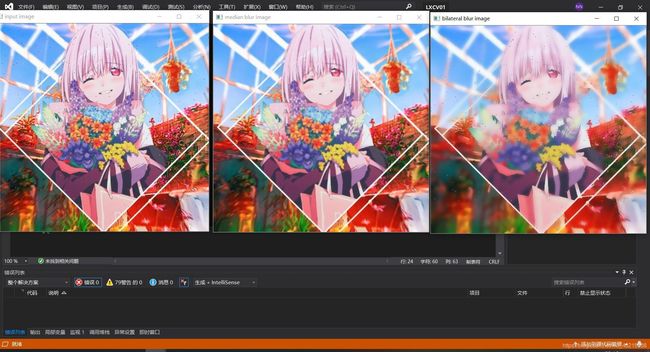

#include 9. 图像模糊

卷积:假设有6x6的图像像素点矩阵。6x6上面是个3x3的窗口,从左向右,从上向下移动,黄色的每个像个像素点值之和取平均值赋给中心红色像素作为它卷积处理之后新的像素值。每次移动一个像素格。

9.1 均值模糊&高斯模糊:

#include 9.2 中值滤波&双边滤波

中值模糊medianBlur(Mat src, Mat dest, ksize)

- Mat src:输入图像;

- Mat dest:输出图像;

- ksize:卷积核尺寸。

双边模糊bilateralFilter(src, dest, d, sigma color, sigma space)

- src:输入图像;

- dest:输出图像;

- d:计算的半径,半径之内的像数都会被纳入计算,如果提供-1 则根据sigma space参数取值;

- sigma color 颜色空间过滤器的sigma值,这个参数的值月大,表明该像素邻域内有更宽广的范围颜色会被混合到一起,产生较大的半相等颜色区域,看着雾蒙蒙的;

- sigma space 如果d的值大于0则声明无效,否则根据它来计算d值,中值模糊的ksize大小必须是大于1,而且必须是奇数。

#include 10. 形态学操作

10.1 膨胀与腐蚀

关键api:

-

getStructuringElement(int shape, Size ksize, Point anchor):返回指定形状和尺寸的结构元素。

shape形状 (MORPH_RECT \MORPH_CROSS \MORPH_ELLIPSE);

ksize大小;

anchor锚点,默认是Point(-1, -1)意思就是中心像素。 -

dilate(image, image_dilate, kernel)膨胀;

-

erode(image, image_erode, kernel)腐蚀.

#include 10.2 开、闭、形态学梯度、顶帽、黑帽:

-

开:先腐蚀后膨胀,可以去掉小的对象,假设对象是前景色,背景是黑色;

-

闭:先膨胀后腐蚀,可以填充小的洞,假设对象是前景色,背景是黑色;

-

形态学梯度:膨胀减去腐蚀,又称为基本梯度(其它还包括-内部梯度、方向梯度);

-

顶帽:原图像和开操作图像的差值;

-

黑帽:闭操作图像和原图像的差值。

关键api:

morphologyEx(src, dest, CV_MOP_BLACKHAT, kernel);

- Mat src – 输入图像

- Mat dest – 输出

- int OPT – CV_MOP_OPEN/ CV_MOP_CLOSE/ CV_MOP_GRADIENT /CV_MOP_TOPHAT/ CV_MOP_BLACKHAT 形态学操作类型

Mat kernel 结构元素

int Iteration 迭代次数,默认是1

#include 10.3 水平&竖直线条提取:

- 输入图像彩色图像 imread

- 转换为灰度图像 – cvtColor

- 转换为二值图像 – adaptiveThreshold

- 定义结构元素

- 开操作(腐蚀+膨胀)提取水平与垂直线

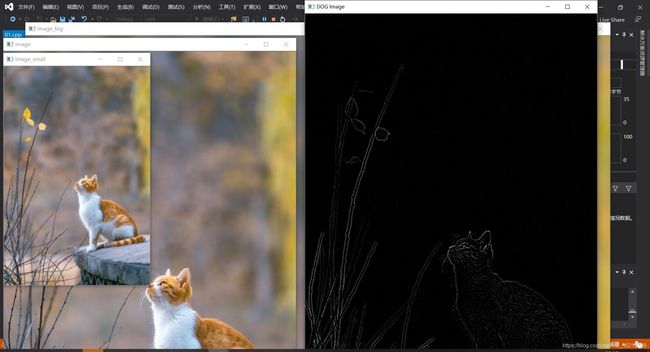

#include 11. 图像的升采样和降采样、高斯不同

-

两种采样的目的是放缩图片大小,放缩图像也可以使用几何变换,这里使用图像金字塔的方式,

-

升采样(cv::pyrUp) – zoom in 放大

降采样 (cv::pyrDown) – zoom out 缩小 -

高斯金子塔是从底向上,逐层降采样得到。

降采样之后图像大小是原图像MxN的M/2 x N/2 ,就是对原图像删除偶数行与列,即得到降采样之后上一层的图片。高斯金子塔的生成过程分为两步:- 对当前层进行高斯模糊

- 删除当前层的偶数行与列

这样即可得到上一层的图像,这样上一层跟下一层相比,都只有它的1/4大小

-

高斯不同的定义:就是把同一张图像在不同的参数下做高斯模糊之后的结果相减,得到的输出图像。称为高斯不同(DOG)。

-

高斯不同是图像的内在特征,在灰度图像增强、角点检测中经常用到。

#include 12. 阈值操作

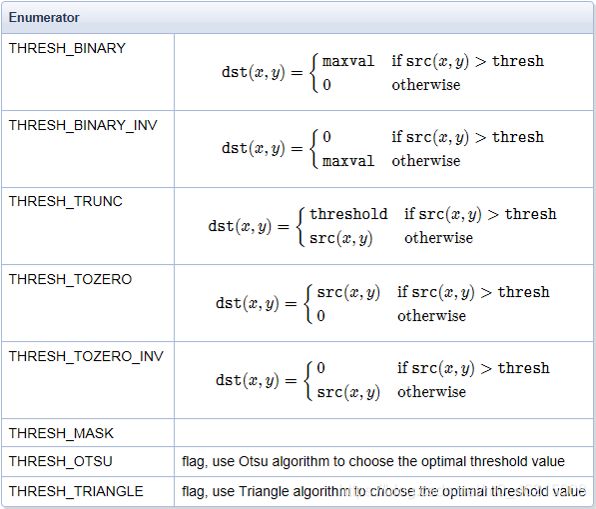

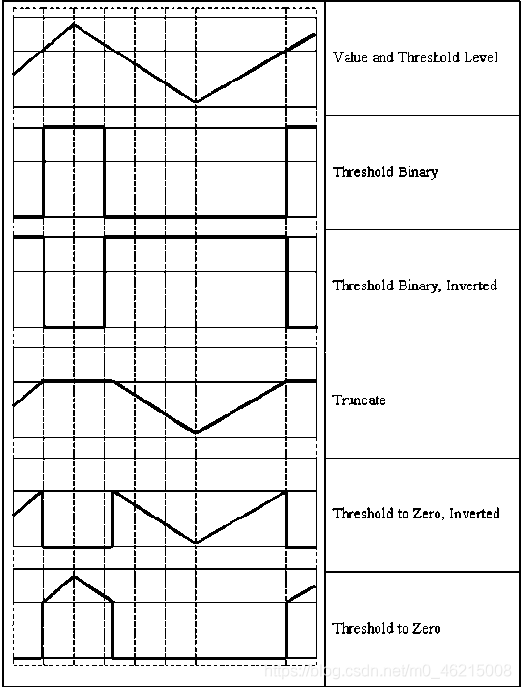

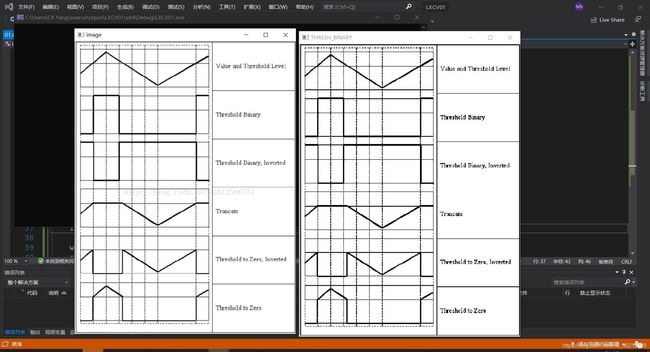

基本的图像阈值操作有:二值化、反二值化、截断、取零、反取零,还有后面三个以后再学。

#include 利用二值化阈值操作来去水印

#include 13. 自定义线性滤波

-

卷积是图像处理中一个操作,是kernel在图像的每个像素上的操作。Kernel本质上一个固定大小的矩阵数组,其中心点称为锚点(anchor point)。

-

把kernel放到像素数组之上,求锚点周围覆盖的像素乘积之和(包括锚点),用来替换锚点覆盖下像素点值称为卷积处理。

-

自定义卷积模糊:

filter2D(

Mat src, //输入图像

Mat dst, // 模糊图像

int depth, // 图像深度32/8

Mat kernel, // 卷积核/模板

Point anchor, // 锚点位置

double delta // 计算出来的像素+delta

)

注意:其中 kernel是可以自定义的卷积核

#include

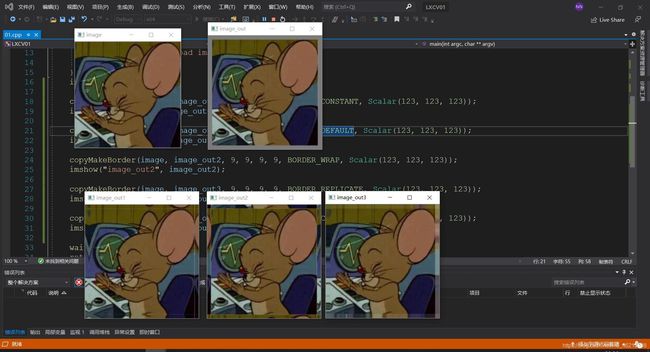

卷积边界问题:图像卷积的时候边界像素,不能被卷积操作,原因在于边界像素没有完全跟kernel重叠,所以当3x3滤波时候有1个像素的边缘没有被处理,5x5滤波的时候有2个像素的边缘没有被处理。

- 相关api:

copyMakeBorder(

Mat src, // 输入图像

Mat dst, // 添加边缘图像

int top, // 边缘长度,一般上下左右都取相同值,

int bottom,

int left,

int right,

int borderType // 边缘类型

Scalar value) - 边缘类型:

BORDER_DEFAULT – OpenCV中默认的处理方法,镜像填充;

BORDER_CONSTANT – 用指定像素值填充边缘;

BORDER_REPLICATE – 用最边缘的像素值作为插值来填充边缘像素;

BORDER_WRAP – 用另外一边的图像来填充。

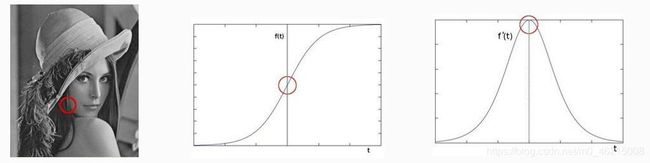

#include #include 14. 图像边缘提取

-

如何捕捉/提取边缘?

对图像求导数,delta = f(x) – f(x-1), delta越大,说明像素在X方向变化越大,边缘信号越强。

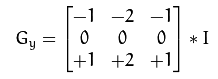

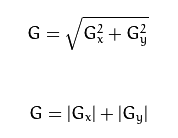

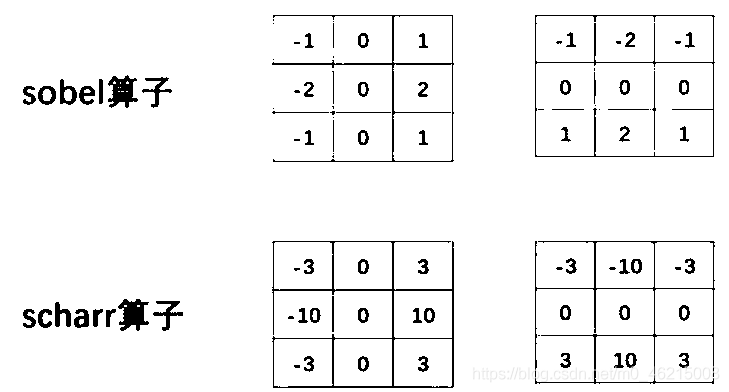

14.1 Sobel算子 & Scharr算子

注意:相比sobel算子,scharr算子能计算出更小的梯度变化

- 处理步骤:

- 相关api:

- cv::Sobel (

InputArray Src // 输入图像

OutputArray dst// 输出图像,大小与输入图像一致

int depth // 输出图像深度.

Int dx. // X方向,几阶导数

int dy // Y方向,几阶导数.

int ksize, SOBEL算子kernel大小,必须是1、3、5、7、

double scale = 1

double delta = 0

int borderType = BORDER_DEFAULT

) - cv::Scharr (

InputArray Src // 输入图像

OutputArray dst// 输出图像,大小与输入图像一致

int depth // 输出图像深度.

Int dx. // X方向,几阶导数

int dy // Y方向,几阶导数.

double scale = 1

double delta = 0

int borderType = BORDER_DEFAULT

) - GaussianBlur( src, dst, Size(3,3), 0, 0, BORDER_DEFAULT );

- cvtColor( src, gray, COLOR_RGB2GRAY );

- addWeighted( A, 0.5,B, 0.5, 0, AB);

- convertScaleAbs(A, B)// 计算图像A的像素绝对值,输出到图像B

- saturate_cast< uchar> () //截断

- cv::Sobel (

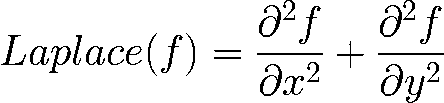

#include 14.2 Laplance算子

- 处理步骤

- 高斯模糊去噪声

- 转换为灰度图像

- 拉普拉斯 – 二阶导数计算Laplacian()

- 取绝对值convertScaleAbs(),显示结果

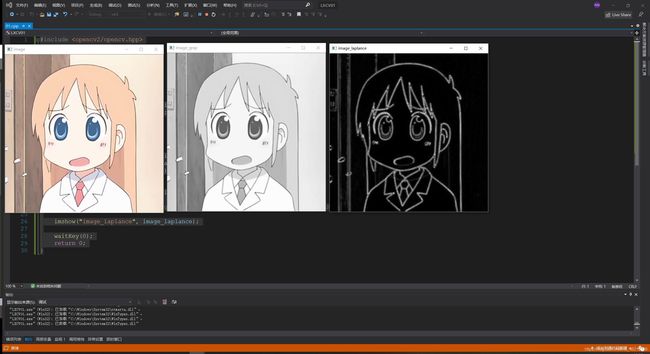

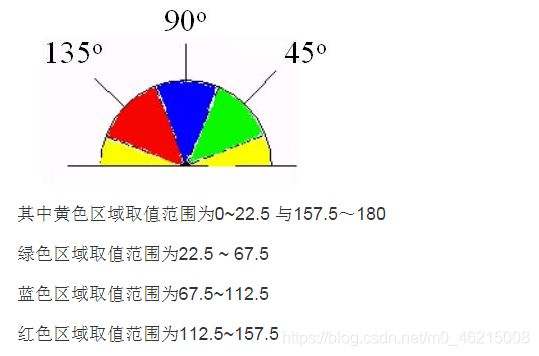

#include 14.3 Canny算子

Canny算子被很多人推崇为当今最优的边缘检测的算法。

- Canny算子的流程:

-

高斯滤波消除噪声;

-

将图像转换为灰度图;

-

用双阈值算法检测和连接边缘:T1, T2为阈值,凡是高于T2的都保留,凡是小于T1都丢弃,从高于T2的像素出发,凡是大于T1而且相互连接的,都保留。最终得到一个输出二值图像。

推荐的高低阈值比值为 T2: T1 = 3:1/2:1其中T2为高阈值,T1为低阈值。

- 相关api:

- Canny(

InputArray src, // 8-bit的输入图像

OutputArray edges,// 输出边缘图像, 一般都是二值图像,背景是黑色

double threshold1,// 低阈值,常取高阈值的1/2或者1/3

double threshold2,// 高阈值

int aptertureSize,// Soble算子的size,通常3x3,取值3

bool L2gradient // 选择 true表示是L2来归一化,否则用L1归一化,默认选择L1。

)

- Canny(

#include 15.基础图形检测

15.1 霍夫变换——直线检测

-

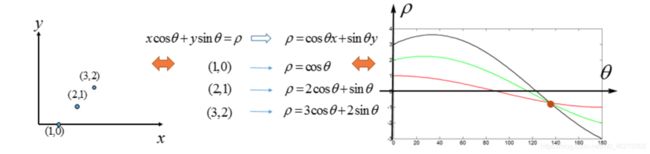

在边缘检测已经完成的条件下,霍夫直线变换用来做直线检测,主要是平面空间到极坐标空间转换。

-

直线从直角坐标系转换到极坐标系:r = xcosθ + ysinθ

-

可以看到,根据以上公式,同时在图像空间处于一条直线的 n个点 将他们的坐标代入,会得到n个在参数空间中关于r和θ的函数,表示为图像就是n条曲线,n条曲线总会相交于同一点。图像空间中共线的点在参数空间中曲线相交于一点。

-

也就是说,如果一幅图像空间(x-y)中的像素构成一条直线,那么这些像素坐标值(x, y)在参数空间对应的曲线一定相交于一个点,所以我们只需要将图像空间(x-y)中的所有像素点变换成参数空间(r-θ)的曲线,并在参数空间检测曲线的交点,得到交点(r,θ)就可以确定直线了。

-

霍夫变换的直线检测是把图像空间中的直线变换到参数空间中的点,通过统计特性来解决检测问题。为何要用?以及如何使用统计特性?因为确定一点时,找到一个能够与这点构成直线的点有无限种可能。在现实应用里,我们就要限定(r-θ)的密度,也就是要将θ离散化。

-

霍夫变换检测直线的原理:

//标准霍夫变换、多尺度霍夫变换

CV_EXPORTS_W void HoughLines( InputArray image, OutputArray lines,

double rho, double theta, int threshold,

double srn = 0, double stn = 0,

double min_theta = 0, double max_theta = CV_PI );

//InputArray image:输入图像,必须是8位单通道图像。

//OutputArray lines:检测到的线条参数集合。

//double rho:以像素为单位的距离步长。

//double theta:以弧度为单位的角度步长。

//int threshold:累加计数值的阈值参数,当参数空间某个交点的累加计数的值超过该阈值,则认为该交点对应了图像空间的一条直线。

//double srn:默认值为0,用于在多尺度霍夫变换中作为参数rho的除数,rho=rho/srn。

//double stn:默认值为0,用于在多尺度霍夫变换中作为参数theta的除数,theta=theta/stn。

//如果srn和stn同时为0,就表示HoughLines函数执行标准霍夫变换,否则就是执行多尺度霍夫变换。

//渐进概率式霍夫变换

CV_EXPORTS_W void HoughLinesP( InputArray image, OutputArray lines,

double rho, double theta, int threshold,

double minLineLength = 0, double maxLineGap = 0 );

//InputArray image:输入图像,必须是8位单通道图像。

//OutputArray lines:检测到的线条参数集合。

//double rho:直线搜索时的距离步长,以像素为单位。

//double theta:直线搜索时的角度步长,以弧度为单位。

//int threshold:累加计数值的阈值参数,当参数空间某个交点的累加计数的值超过该阈值,则认为该交点对应了图像空间的一条直线。

//double minLineLength:默认值为0,表示最小线段长度阈值(像素)。

//double maxLineGap:线段上最近两点之间的阈值.默认值为0,表示直线断裂的最大间隔距离阈值。即如果有两条线段是在一条直线上,但它们之间有间隙,那么如果这个间隔距离小于该值,则被认为是一条线段,否则认为是两条线段。

- 使用霍夫变换api检测直线具体步骤:

- 转换为灰度图;

- 高斯模糊去噪;

- 边缘检测;

- 二值化(判断此处是否为直线点,就看灰度值==255);

- 映射到霍夫空间(准备两个容器,一个用来展示hough-space概况,一个数组hough-space用来储存voting的值,因为投票过程往往有某个极大值超过阈值,多达几千,不能直接用灰度图来记录投票信息);

- 取局部极大值,设定阈值,过滤干扰直线;

- 绘制直线、标定角点。

#include #include 15.2 霍夫变换——圆

HoughCircles(

InputArray image, // 输入图像 ,必须是8位的单通道灰度图像

OutputArray circles, // 输出结果,发现的圆信息圆心坐标,圆半径

Int method, // 方法 - HOUGH_GRADIENT

Double dp, // dp = 1;

Double mindist, // 10 最短距离-可以分辨是两个圆的,否则认为是同心圆- src_gray.rows/8

Double param1, // canny edge detection low threshold

Double param2, // 中心点累加器阈值 – 候选圆心

Int minradius, // 最小半径

Int maxradius // 最大半径

)

#include 16. 像素重映射

相关api:

remap(

InputArray src, //输入图像

OutputArray dst, //输出图像

InputArray map1, //x映射表 CV_32FC1/CV_32FC2

InputArray map2, //y映射表

Int interpolation, //插值方式

Int borderMode, //边界模式

Const Scalar borderValue //边界Color

)

#include (j, i) = 2 * (i - (image.cols * 0.25));

// map_y.at(j, i) = 2 * (j - (image.rows * 0.25));

// }

// else {

// map_x.at(j, i) = 0;

// map_y.at(j, i) = 0;

// }

}

}

remap(image, image_out, map_x, map_y, INTER_LINEAR, BORDER_CONSTANT, Scalar(0, 0, 0));

imshow("image", image);

imshow("image_out", image_out);

waitKey(0);

return 0;

}

17.灰度直方图

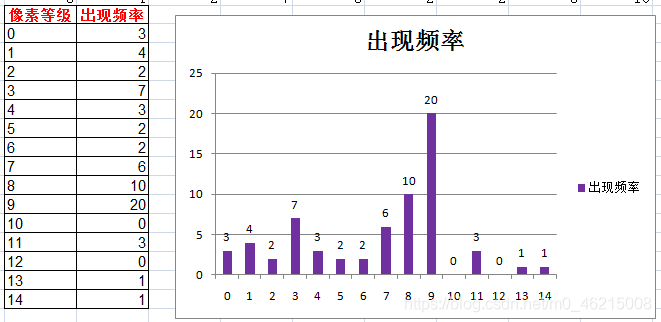

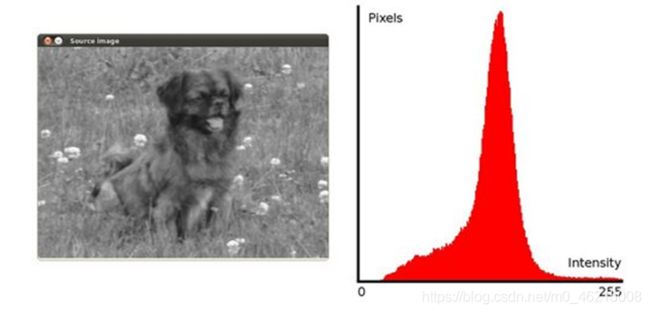

灰度直方图是表示不同灰度出现频率的图像,为柱状图;是图像的统计学特征。

17.1 直方图均衡化

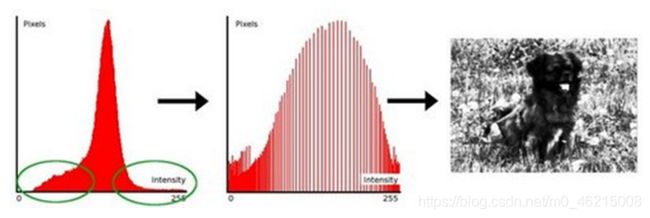

目的是提高图像的对比度,拉伸图像的灰度值范围。

相关api:

equalizeHist(

InputArray src,//输入图像,必须是8-bit的单通道图像

OutputArray dst// 输出结果

)

#include 17.2 直方图计算

split(// 把多通道图像分为多个单通道图像

const Mat &src, //输入图像

Mat* mvbegin)// 输出的通道图像数组

calcHist(

const Mat* images,//输入图像指针

int images,// 图像数目

const int* channels,// 通道数

InputArray mask,// 输入mask,可选,不用

OutputArray hist,//输出的直方图数据

int dims,// 维数

const int* histsize,// 直方图级数

const float* ranges,// 值域范围

bool uniform,// true by default

bool accumulate// false by defaut

)