django-celery动态添加定时任务

make

make install

接着重新安装python 2.7,首先,

tar -zxf Python-2.7.9.tgz

cd ~/tools/Python-2.7.9

修改setup.py,

sqlite_inc_paths = [ '/usr/include',

'/usr/include/sqlite',

'/usr/include/sqlite3',

'/usr/local/include',

'/usr/local/include/sqlite',

'/usr/local/include/sqlite3',

'~/install/include',

'~/install/include/sqlite3',

]

也就是加上sqlite3的路径,然后,

./configure --prefix=/home/panxiaofeng/install/ && make -j4 && make install #4核并行编译

ln -s ~/install/bin/python ~/bin/python

完成。

测试安装成功否,

~/bin/python

>>>import sqlite3

>>>

没报错即可。

~/bin/python setup.py build install #用哪个python来安装包,包就会安装到哪个python的目录下,其他版本的python无法使用该包

cd ~/tools/pip-6.0.6

~/bin/python setup.py build install

python setup.py install --record log

这时所有的安装细节都写到 log 里了

想要卸载的时候

cat log | xargs rm -rf

就可以干净卸载了

Collecting chardet==2.2.1

/usr/lib/python2.6/site-packages/pip/_vendor/requests/packages/urllib3/util/ssl_.py:79: InsecurePlatformWarning: A true SSLContext object is not available. This prevents urllib3 from configuring SSL appropriately and may cause certain SSL connections to fail. For more information, see https://urllib3.readthedocs.org/en/latest/security.html#insecureplatformwarning.

InsecurePlatformWarning

Downloading chardet-2.2.1-py2.py3-none-any.whl (180kB)

72% |███████████████████████▎ | 131kB 357bytes/s eta 0:02:19

Hash of the package https://pypi.python.org/packages/2.7/c/chardet/chardet-2.2.1-py2.py3-none-any.whl#md5=556de73cc5d2d14233b3512798423da1 (from https://pypi.python.org/simple/chardet/) (be001cd2dbe90bb1f1dd4ab4b008c169) doesn't match the expected hash 556de73cc5d2d14233b3512798423da1!

Bad md5 hash for package https://pypi.python.org/packages/2.7/c/chardet/chardet-2.2.1-py2.py3-none-any.whl#md5=556de73cc5d2d14233b3512798423da1 (from https://pypi.python.org/simple/chardet/)

解决方案:

wget https://pypi.python.org/packages/2.7/c/chardet/chardet-2.2.1-py2.py3-none-any.whl --no-check-certificate

md5sum chardet-2.2.1-py2.py3-none-any.whl

pip install chardet-2.2.1-py2.py3-none-any.whl

import djcelery

###

djcelery.setup_loader()

###

CELERY_TIMEZONE='Asia/Shanghai' #并没有北京时区,与下面TIME_ZONE应该一致

BROKER_URL='redis://10.121.84.90:16379/8'

#任何可用的redis都可以,不一定要在django server运行的主机上

CELERYBEAT_SCHEDULER = 'djcelery.schedulers.DatabaseScheduler'

###

# Application definition

INSTALLED_APPS = (

'django.contrib.admin',

'django.contrib.auth',

'django.contrib.contenttypes',

'django.contrib.sessions',

'django.contrib.messages',

'django.contrib.staticfiles',

'djcelery',

###

'apps',

###

)

TIME_ZONE='Asia/Shanghai'

###

#!/bin/python

from __future__ import absolute_import

import os

from celery import Celery

os.environ.setdefault('DJANGO_SETTINGS_MODULE', 'djtest.settings')

#Specifying the settings here means the celery command line program will know where your Django project is.

#This statement must always appear before the app instance is created, which is what we do next:

from django.conf import settings

app = Celery('djtest')

app.config_from_object('django.conf:settings')

#This means that you don’t have to use multiple configuration files, and instead configure Celery directly from the Django settings.

#You can pass the object directly here, but using a string is better since then the worker doesn’t have to serialize the object.

app.autodiscover_tasks(lambda: settings.INSTALLED_APPS)

#With the line above Celery will automatically discover tasks in reusable apps if you define all tasks in a separate tasks.py module.

#The tasks.py should be in dir which is added to INSTALLED_APP in settings.py.

#So you do not have to manually add the individual modules to the CELERY_IMPORT in settings.py.

@app.task(bind=True)

def debug_task(self):

print('Request: {0!r}'.format(self.request)) #

dumps its own request information

#!/bin/python

from __future__ import absolute_import

# This will make sure the app is always imported when

# Django starts so that shared_task will use this app.

from .celery import app as celery_app

from __future__ import absolute_import

from celery import task

from celery import shared_task

#from celery.task import tasks

#from celery.task import Task

@task()

#@shared_task

def add(x, y):

print "%d + %d = %d"%(x,y,x+y)

return x+y

#class AddClass(Task):

# def run(x,y):

# print "%d + %d = %d"%(x,y,x+y)

# return x+y

#tasks.register(AddClass)

@shared_task

def mul(x, y):

print "%d * %d = %d"%(x,y,x*y)

return x*y

@shared_task

def sub(x, y):

print "%d - %d = %d"%(x,y,x-y)

return x-y

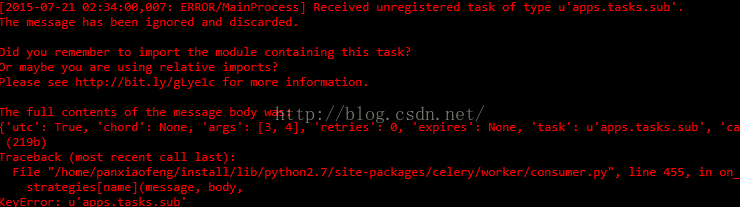

--autoreload option, it correctly reloads if the tasks.py module is changed. But if I change a module that is imported and used by the tasks module, nothing is reloaded and the worker still uses the old code. Currently autoreloader doesn't monitor the dependency tree

.

来源: < https://github.com/celery/celery/issues/1025

>