南大周志华团队开源深度森林软件包DF21:训练效率高、超参数少,普通设备就能跑 | AI日报...

![]()

中国学者研发新型电子纹身,实现8倍延展,有望用于医疗、VR和可穿戴机器人等领域

可穿戴设备,已经成为我们生活中极为常见的一种设备,它们体积轻巧、佩戴方便、检测数据齐全,但也存在一个很明显的缺点——无法适应运动状态的数据实时监测。为解决这一问题,科学家们近年来一直在不断探索新的解决方案,电子纹身应运而生。

“电子纹身” 是一张可以直接贴在人体表面的超薄电路,与普通纹身不同,电子纹身无需外创即可紧紧贴在皮肤上,随皮肤可随意拉伸、弯曲,可用于检测心电、肌电等人体健康数据,被认为是可穿戴设备的终极形态。

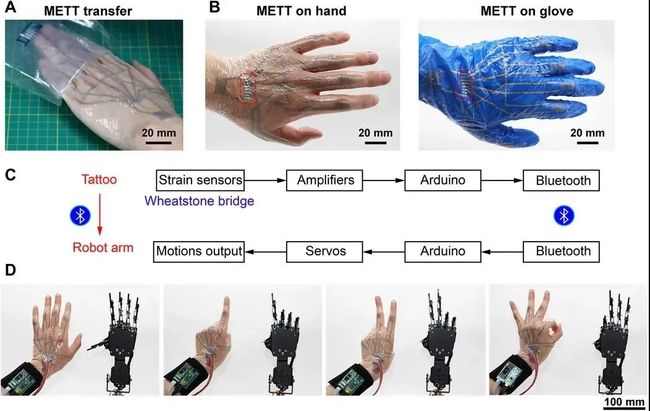

近日,来自南方科技大学、首都医科大学和中国科学院大学的联合研究团队在电子纹身这一研究方向实现了新突破。他们开发出一种集成多层电路的电子纹身(multilayered electronic transfer tattoo,METT)。

这种电子纹身兼具高延展性(8 倍)、保形性和粘性等优点,可以嵌入手指皱褶和指纹等一些皮肤上细小的特征中,能够牢固地附着在皮肤上,且在皮肤表面经反复变形后也不会脱落。

图注:METT 可以远程控制机械手(A)将电子纹身转移到手上的照片;(B)METT 分别粘贴在皮肤上(左)和处置手套上(右),红色虚线框为外部接触垫;(C)机器人控制系统的系统级框图;(D)METT 可以远程控制机械手的部分动作。(来源:Science Advances)

相关研究论文以 “Multilayered electronic transfer tattoo that can enable the crease amplification effect” 为题,于近日在线发表在科学期刊 Science Advances 上。

研究人员表示,这一新型电子皮肤有望在医疗系统、虚拟现实和可穿戴机器人领域实现广泛应用。

神经形态计算新研究:借助光子融合信息存储和处理

近日,科学家对开发下一代「快速节能的计算系统」有了新见解,系统将使用光而不是电子来处理和存储信息——其中的硬件直接受到人脑功能的启发。

包括来自埃克塞特大学的C. David Wright教授在内的一个科学家团队,探索了利用「光子学」取代「传统电子学」的计算机系统的可能性。该研究论文前几天(2021年1月29日)发表在著名杂志《自然光子学》上。这个研究主要针对当今世界上最紧迫的计算问题之一——如何快速又节能的方式处理大规模数据。

我们目前使用的计算机都是基于冯-诺依曼架构,其中「快速的中央处理器(CPU)」与「相对缓慢的程序和数据存储器」在物理上是分离的。这意味着当前电脑的计算速度是有限的,并且由于需要通过「带宽有限和能源效率低下的电气互连」来不断地将数据传输到内存和处理器,大量的电力也被浪费了,而这就是著名的「冯-诺依曼瓶颈」。因此,据估计,现代计算系统50%以上的能量都浪费在这种数据传输上。

来自埃克塞特大学工程系的C. David Wright教授,是该研究的共同作者之一,他解释说,「显然,我们需要一种新的方法——一种能够将『计算』和『记忆的核心信息处理任务』融合在一起的方法,即能够将学习、适应和进化的能力直接纳入硬件中的方法,让我们能够摒弃现在的这种『耗能又有局限性的电气互连』。」

光子神经形态计算就是这样一种方法。在这里,处理器将使用光而不是电子来沟通和处理信号,从而获得更高的带宽(处理器速度),并大大降低能量损耗。此外,研究人员还试图使计算硬件本身与生物处理系统(大脑)『同构』,去直接模仿大脑神经元和突触的基本功能,然后将这些连接在一起,为人工智能和机器学习应用提供快速和并行化的自适应处理。

论文地址:https://www.nature.com/articles/s41566-020-00754-y

南大周志华团队开源深度森林软件包DF21:训练效率高、超参数少,普通设备就能跑

深度森林,是探索神经网络以外 AI 领域重要的研究方向之一,在表格数据建模任务中已初现锋芒。但是,由于基于决策树的集成模型在具体实现当中,经常会遇到内存不足,硬件效率不如神经网络等问题,是推动其大规模应用的主要瓶颈之一。

2021年2月1日,南大教授周志华微博宣布,他们团队新的深度森林软件包DF21在 GitHub与开源中国同时开源了。该软件包尝试解决了这一方向在上述实际应用过程中所遇到的关键问题,未来在各类在数据建模过程中,大家啊也可以便捷地使用深度森林了。据介绍,该项目目前主要由南大徐轶轩进行开发和维护,在正式发布之前它已经在南大机器学习与数据挖掘研究所(LAMDA)内部经过测试和使用。

项目地址:http://www.lamda.nju.edu.cn/deep-forest/

Gitee 地址:https://gitee.com/lamda-nju/deep-forest

Github 地址:https://github.com/LAMDA-NJU/Deep-Forest

深度森林参与者之一冯霁博士提到,深度森林在表格数据建模上,相对传统算法效果显著,但是之前开源的代码主要用于算法验证,以及辅助其他科研工作者进行深度森林算法相关的研究,代码本身对内存和服务器性能要求较高。徐同学开源的这一版更为简单易用,做了很好的封装,同时进行了高性能优化,大幅降低了内存依赖,对于科研和实际落地应用都是很好的工具。

徐轶轩提到,这个模型的全名是:DF21: A Practical Deep Forest for Tabular Datasets,内存消耗是DF21主要解决的问题。此前的gcForest在处理百万级别的表格型数据集上,占用的内存可能会达到上百 GB。但在新版本中,在千万级别的表格型数据集上进行训练,占用的内存约为原来的十分之一左右。

DeepMind提出人工生命框架,促进智能生物体的出现

近日,DeepMind的研究者提出了一种人工生命框架,旨在促进智能生物体的出现。该框架中没有明确的智能体概念,而是由原子元素构成的环境。这些元素包含神经操作,通过信息交换和环境中包含的类物理规则进行交互。研究者讨论了进化过程如何导致由许多此类原子元素构成的不同生物体的出现,这些原子元素可以在环境中共存和繁荣。此外,研究者还探讨了这如何构成通用AI生成算法的基础,并提供了这种系统的简化版实现,讨论了需要做哪些改进才能进一步扩大规模。

论文名称:SELF-ORGANIZING INTELLIGENT MATTER: A BLUEPRINT FOR AN AI GENERATING ALGORITHM

论文链接:https://arxiv.org/pdf/2101.07627.pdf

三星、麦吉尔大学等提出全新多模态感知AI框架,用能同时模拟人眼和手预测物体运动

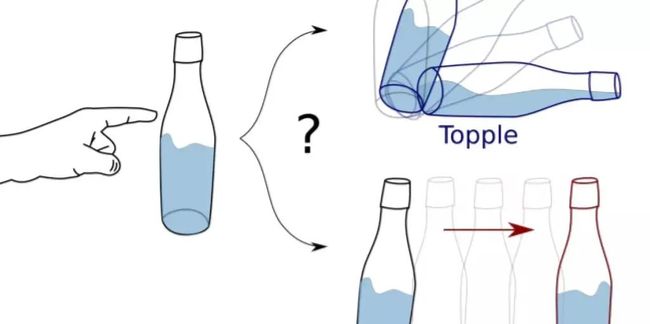

据VentureBeat报道,来自三星、麦吉尔大学和约克大学的研究人员,近日研发出一个全新的生成式多模态感知AI框架,能够根据物体初始状态的视觉和触觉数据,来预测出物体的运动趋势。据悉,这是第一个利用视觉和触觉感知来学习多模态动力学模型的研究。

运动预测是自动化领域的一大关键技术,通过预判物体和环境的交互方式,自动化系统得以作出更加智能的决策。该团队的这项研究,似乎又将这一技术的应用向前推进了一步。这篇论文名为《基于多模态的生成模型指导的直观物理研究(Learning Intuitive Physics with Multimodal Generative Models)》,已发表于arXiv平台。

在研究人员看来,视觉、触觉信号的组合,或有助于推测出物体运动后的最终稳定状态。研究人员在论文写道:“先前的研究表明,由于摩擦力、几何特性、压力分布存在不确定性,预测运动对象的轨迹具有挑战性。”

比如推一个瓶子,如何准确预测这个动作的结果,接下来这个瓶子是会向前移动,还是会翻倒?

图注:《基于多模态的生成模型指导的直观物理研究(Learning Intuitive Physics with Multimodal Generative Models)》论文插图

图注:《基于多模态的生成模型指导的直观物理研究(Learning Intuitive Physics with Multimodal Generative Models)》论文插图

为了减少这种不确定性,研究团队设计并实现了一个由软硬件组成的高质量AI感知系统,经训练后,该系统能捕获到运动轨迹中最关键、最稳定的元素,从而准确测量和预测物体落在表面上的最终静止状态。

论文链接:https://arxiv.org/pdf/2101.04454.pdf

![]()

点击左下角“阅读原文”,了解更多!