机器学习之无监督学习:降维

前置准备

详情请见我的上一篇博客

PCA方法及其应用

实现机理

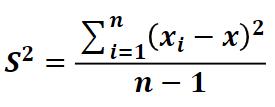

-

PCA方法也叫主成分分析,它是最常用的一种降维方法,通常用于高维数据集的探索与可视化,还可以用作数据压缩和预处理等。

-

PCA可以把具有相关性的高位变量合称为线性无关的低维变量,称为主成分。主成分能够尽可能保留原始数据的信息。

PCA涉及到的部分相关术语:方差、协方差、协方差矩阵、特征向量和特征值。 -

协方差

用于度量两个变量之间的线性相关程度,若两个变量的协方差为0,则可认为二者线性无关。协方差矩阵则是由变量的协方差值构成的矩阵(对称阵)。

-

PCA原理

矩阵的主成分就是其协方差矩阵对应的特征向量,按照对应的特征值大小进行排序,最大的特征值就是第一主成分,其次就是第二主成分,以此类推。

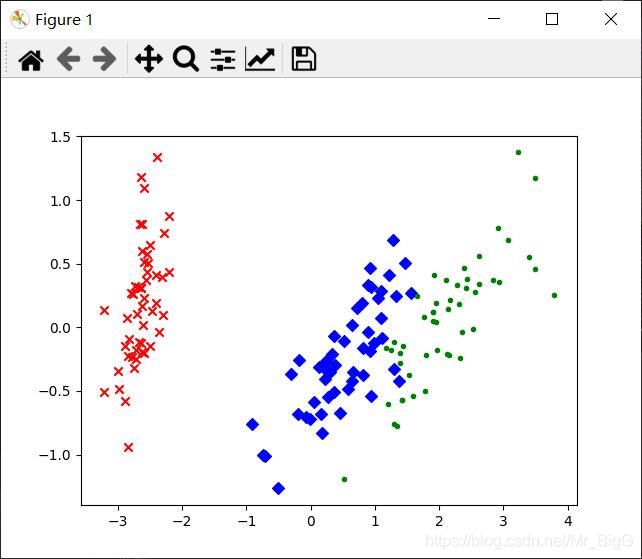

PCA实现高维数据可视化

已知鸢尾花数据是4维的,共三类样本。使用PCA实现对鸢尾花数据进行降维,实现在二维平面上的可视化。

效果图

源代码

#PCA-鸢尾花数据集降维.py

import matplotlib.pyplot as plt

from sklearn.decomposition import PCA

from sklearn.datasets import load_iris

data = load_iris() #以字典形式加载鸢尾花数据集

y = data.target #使用y表示数据集中的标签

X = data.data #使用x表示数据集中的属性数据

pca = PCA(n_components=2) #加载PCA算法,设置降维后主成分数目为2,也即参数n_components的设定

reduced_X = pca.fit_transform(X) #对原始数据进行降维,保存在变量reduced_X中

red_x, red_y = [], [] #第一类数据点

blue_x, blue_y = [], [] #第二类

green_x, green_y = [], [] #第三类

for i in range(len(reduced_X)): #按照鸢尾花的类别将降维后的数据点保存在不同的列表中

if y[i] == 0:

red_x.append(reduced_X[i][0])

red_y.append(reduced_X[i][1])

elif y[i] == 1:

blue_x.append(reduced_X[i][0])

blue_y.append(reduced_X[i][1])

else:

green_x.append(reduced_X[i][0])

green_y.append(reduced_X[i][1])

plt.scatter(red_x, red_y, c='r', marker='x') #第一类数据点

plt.scatter(blue_x, blue_y, c='b', marker='D') #第二类

plt.scatter(green_x, green_y, c='g', marker='.') #第三类

plt.show() #数据可视化

NMF方法及其应用

实现机理

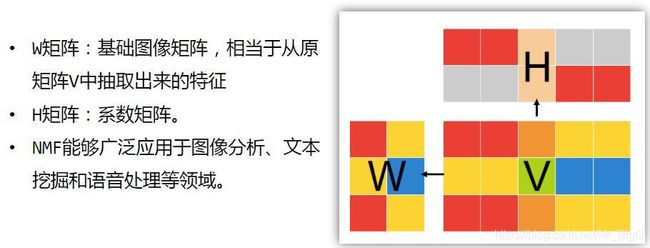

- 非负矩阵分解(NMF),是在矩阵中所有元素均为非负数约束条件之下的矩阵分解方法。其基本思想为:给定一个非负矩阵V,NMF能够找到一个非负矩阵W和一个非负矩阵H,使得W和H的乘积近似等于V中的值。

- 矩阵分解优化目标:最小化W矩阵和H矩阵的乘积和原始矩阵之间的差别,目标函数如图所示:

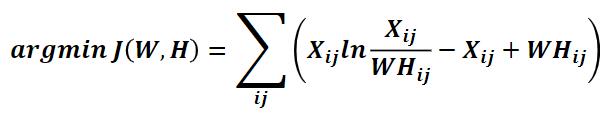

- 基于KL散度的优化目标,损失函数如图所示:

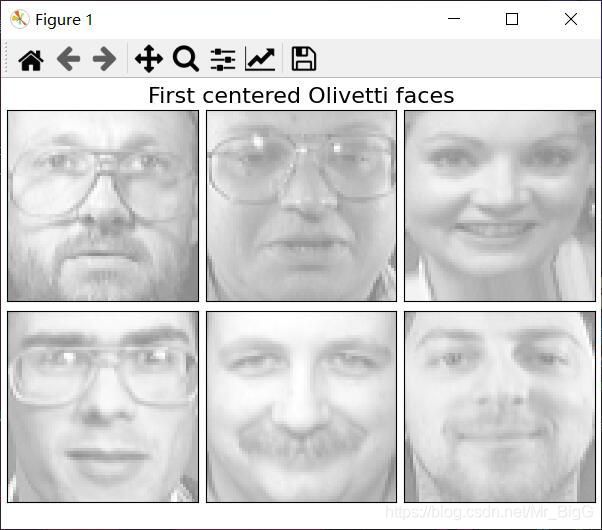

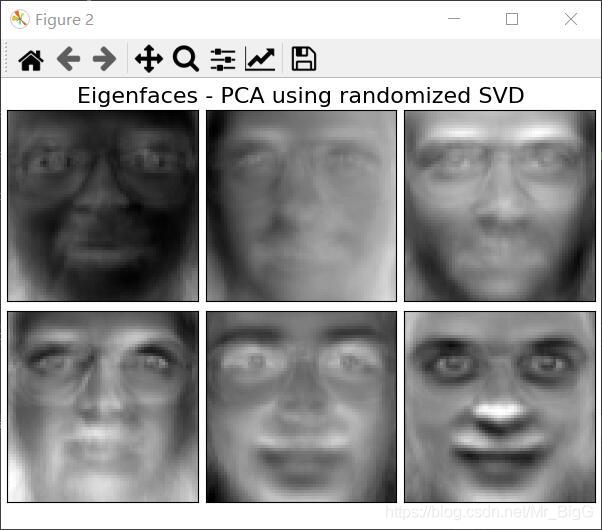

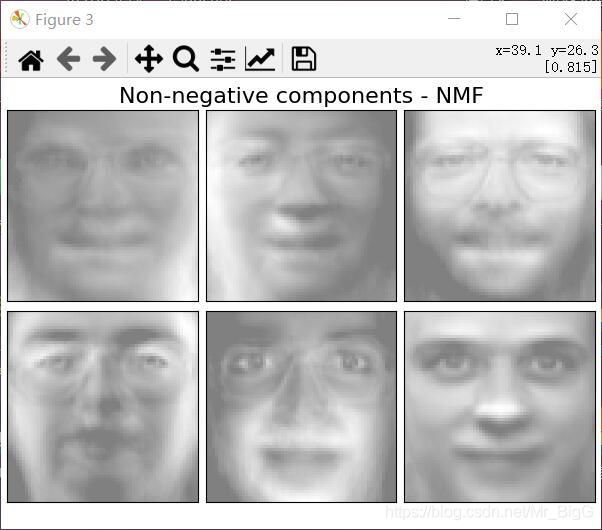

NMF人脸数据特征提取

已知Olivetti人脸数据共有400个,每个数据都是64*64大小。由于NMF分解得到的W矩阵相当于从原始矩阵中提取到的的特征,那么就可以使用NMF对400个人脸数据进行特征提取。在本例中,设置k=6,随后将提取出的特征以图像的形式展示出来。

效果图

源代码

#NMF、PCA-人脸图像特征抽取与对比.py

from numpy.random import RandomState

import matplotlib.pyplot as plt

from sklearn.datasets import fetch_olivetti_faces

from sklearn import decomposition

n_row, n_col = 2, 3 #设置图像展示时的排列情况

n_components = n_row * n_col #设置提取的特征的数目

image_shape = (64, 64) #设置人脸数据图片的大小

###############################################################################

# Load faces data

dataset = fetch_olivetti_faces(shuffle=True, random_state=RandomState(0))

faces = dataset.data #加载数据,打乱顺序

###############################################################################

def plot_gallery(title, images, n_col=n_col, n_row=n_row):

plt.figure(figsize=(2. * n_col, 2.26 * n_row)) #创建图片,并指定图片大小(英寸)

plt.suptitle(title, size=16) #设置标题和字号大小

for i, comp in enumerate(images):

plt.subplot(n_row, n_col, i + 1) #选择画制的子图

vmax = max(comp.max(), -comp.min())

plt.imshow(comp.reshape(image_shape), cmap=plt.cm.gray,

interpolation='nearest', vmin=-vmax, vmax=vmax) #数值归一化,以灰度图形显示

plt.xticks(())

plt.yticks(()) #去除子图的坐标轴标签

plt.subplots_adjust(0.01, 0.05, 0.99, 0.94, 0.04, 0.) #对子图位置及间隔调整

plot_gallery("First centered Olivetti faces", faces[:n_components])

###############################################################################

estimators = [

('Eigenfaces - PCA using randomized SVD',

decomposition.PCA(n_components=6,whiten=True)),

('Non-negative components - NMF',

decomposition.NMF(n_components=6, init='nndsvda', tol=5e-3))

] #对PCA和NMF进行实例化

###############################################################################

for name, estimator in estimators: #分别调用PCA和NMF

print("Extracting the top %d %s..." % (n_components, name))

print(faces.shape)

estimator.fit(faces) #调用PCA或NMF提取特征

components_ = estimator.components_ #获取提取的特征

plot_gallery(name, components_[:n_components]) #按照固定格式进行排列

plt.show() #数据可视化

注:本文是博主机器学习课程的心得总结,不支持任何商用且不支持转载!如果你也对机器学习有一定的兴趣和理解,欢迎随时找博主交流~