Spark SQL DataFrame查询和输出函数一文详解运用与方法

前言

配置的虚拟机为Centos6.7系统,hadoop版本为2.6.0版本,先前已经完成搭建CentOS部署Hbase、CentOS6.7搭建Zookeeper和编写MapReduce前置插件Hadoop-Eclipse-Plugin 安装。在此基础上完成了Hive详解以及CentOS下部署Hive和Mysql和Spark框架在CentOS下部署搭建。Spark的组件Spark SQL的部署:Spark SQL CLI部署CentOS分布式集群Hadoop上方法。

配置JDK1.8、Scala11.12

本文将介绍DataFrame基础操作以及实例运用,重点介绍直接在DataFrame对象上查询的方法。

DataFrame查询操作

第一种方法是将DataFrame注册成为临时表,通过SQL语句进行查询。

第二种方法是直接在DataFrame对象上进行查询,DataFrame的查询操作也是一个懒操作,只有触发Action操作才会进行计算并返回结果。

DataFrame常用查询结果:

| 方法 | 描述 |

| where | 条件查询 |

| select/selectExpr/col/apply | 查询指定字段的数据信息 |

| limit | 查询前n行记录 |

| order by | 排序查询 |

| group by | 分组查询 |

| join | 连接查询 |

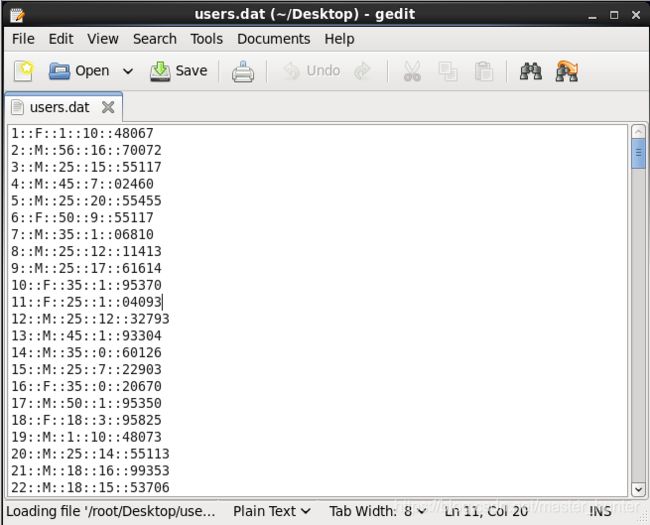

对于连接查询有两份数据用户对电影评分数据ratings.dat和用户的基本信息数据users.dat。

ratings.dat4个字段分别为:UserID,MovieID,Rating,Timestamp

users.dat5个字段分别为:UserID,Gender,Age,Occupation,Zip-code

首先将文件导入,创建两个case class:

(一不小心敲错了几下~)

1.条件查询

(1)where

DataFrame可以使用where(conditionExpr:String)根据指定条件进行查询,参数中可以使用and或or,该方法的返回结果仍为DataFrame类型。

(2)filter

filter和where使用方法一样。

2.查询指定字段的数据信息

(1)select:获取指定字段值

select方法根据传入的string类型字段名获取指定字段的值,以DataFrame类型返回。

(2)selectExpr:对指定字段进行特殊处理

selectExpr可对字段的名称进行替换也可对字段对于的数值进行替换,原表不变:

基本看一眼程序就知道是干什么的,很简单。

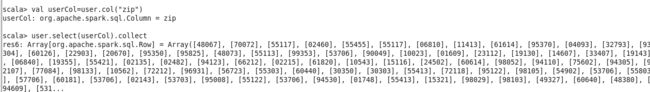

(3)col/apply

col或者apply也可以获取DataFrame指定字段,但是只能获取一个字段,并且返回对象为Column类型。

3.limit

limit方法获取指定DataFrame的前n行记录,得到一个新的DataFrame对象。不同于take与head,limit方法不是Action操作。

4.orderBy/sort

orderBy方法是根据指定字段排序,默认为升序排序。若是降序可以用三种方法来表示

orderBy(desc.("userId"))

orderBy($"userId".desc)

orderBy(-user("userId"))

sort方法和orderBy方法一样

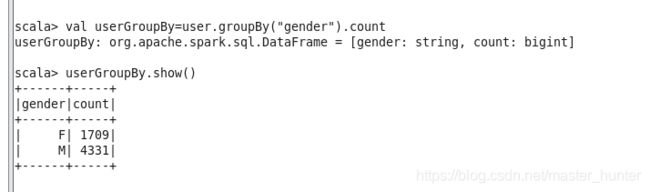

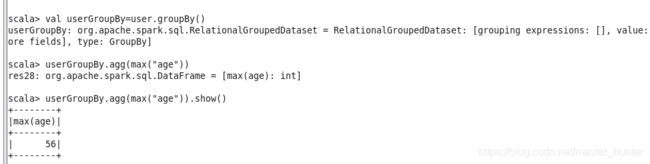

5.groupBy

groupBy方法是根据字段进行分组操作,groupBy方法有两种调用方式,可以传入String类型的字段名,也可传入Column类型的对象。groupBy返回的是 RelationalGroupedDataset 对象。

GroupedData常用方法

| 方法 | 描述 |

| max(colNames:String) | 获取分组中指定字段或者所有的数值类型字段的最大值 |

| min(colNames:String) | 获取分组中指定字段或者所有的数值类型字段的最小值 |

| mean(colNames:String) | 获取分组中指定字段或者所有的数值类型字段的平均值 |

| sum(colNames:String) | 获取分组中指定字段或者所有的数值类型字段的值的和 |

| count() | 获取分组中元素的个数 |

agg(expers:column*) 返回dataframe类型 。

6.join

join可连接两个表进行操作,数据库常用函数。

join常用方法:

| 方法 | 描述 |

| join(right:DataFrame) | 两个表做笛卡尔积 |

| join(right:DataFrame,joinExprs:Column) | 根据两表中相同的某个字段进行连接 |

| join(right:DataFrame,joinExprs:Column,joinType:String) | 根据两表中相同的某个字段进行连接并指定连接类型 |

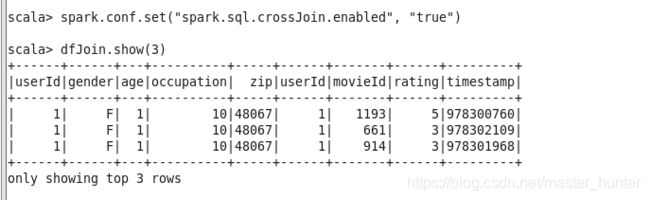

spark2.x版本中默认不支持笛卡尔积操作。通过参数spark.sql.crossJoin.enabled开启,方式如下:

spark.conf.set("spark.sql.crossJoin.enabled", "true")

DataFrame输出操作

DataFrame API在提供了很多输出操作方法。save方法可以将DataFrame保存成文件,save操作有一个可选参数SaveMode,用这个参数可以指定如何处理数据已经存在的情况。另外,在使用HiveContext的时候,DataFrame可以用saveAsTable方法将数据保存成持久化的表。与registerTempTable不同,saveAsTable会将DataFrame的实际内容保存下来,并且在HiveMetastore中创建一个游标指针。持久化的表会一直保存,即使spark程序重启也没有影响,只要连接到同一个metastore就可以读取其数据。读取持久化表示,只需要用表明作为参数,调用SQLContext.table方法即可得到对应的DataFrame。

将DataFrame保存到同一个文件里面有两种方法。

(1)首先创建一个Map对象,用于存储一些save函数需要用到的一些数据,这里将指定保存文件路径及JSON文件的头信息

(2)从DataFrame对象中选择出userId、gender和age

(3)调用save函数保存(2)中的DataFrame数据到copyOfUser.json文件夹中

要加载SaveMode需要先加载SQLContext

![]()

mode函数可以接收的参数有Overwrite、Append、Ignore和ErrorIfExists。

Overwirte代表覆盖目录之前就存在的数据,Append代表给指导目录下追加数据,Ignore代表如果目录下已经有的文件,那就什么都不执行,ErrorIfExits代表如果保存目录下存在的文件,那么跑出相应的异常。

方法二为直接调用save方法

参阅

Spark DataSet常用action,及操作汇总

spark学习进度21(聚合操作、连接操作)