CNN做文本分类《Effective Use of Word Order for Text Categorization with Convolutional Neural Networks》

原文链接

本文发表于自然语言处理领域顶级会议 NAACL 2015

摘要

本文将CNN用于文本分类任务,没有像传统方法那样采用低维词向量作为输入,而是采用高维,还提出了一种在卷积中使用的词袋转换的变体,为了提高准确率,还探索了将多个卷积层结合的方法,实验表明效果不错。

模型

1.bow-CNN for text

假设我们有一个词库 V={ 我,他,它,爱,你} V = { 我 , 他 , 它 , 爱 , 你 }

那么我们将词库中每个词onehot表示,这样每个词就成了一个五维向量,比如“我”就能被表示为: [1,0,0,0,0] [ 1 , 0 , 0 , 0 , 0 ] ,“它”被表示为 [0,0,1,0,0] [ 0 , 0 , 1 , 0 , 0 ]

这样一来,一句话“我爱你”就可以被表示为 [1,0,0,0,0,0,0,0,1,0,0,0,0,0,1] [ 1 , 0 , 0 , 0 , 0 , 0 , 0 , 0 , 1 , 0 , 0 , 0 , 0 , 0 , 1 ] ,

由此可见,采用这种方式,一个文本case可以被表示为一个 p|V| p | V | 维的向量,其中 p p 为case序列的长度, |V| | V | 为词表的size。

CNN用于文本问题和图像问题有一个本质的区别,就是图像一般只有RGB三个通道,而文本的通道数量则取决于词库的大小,很可能有上千上万维,而维数与参数的个数密切相关,向量的维度越高则代表所需要学习的参数越多,这样一来会使模型过拟合,并且学习速度特别慢。

解决上述问题的方式为采用词袋模型。

将单个case的维度从 p|V| p | V | 维降到 |V| | V | 维,即将一个序列中的每个单元的embedding向量给加起来。比如“我爱你”就可以表示为 [1,0,0,1,1] [ 1 , 0 , 0 , 1 , 1 ]

2.Pooling for text

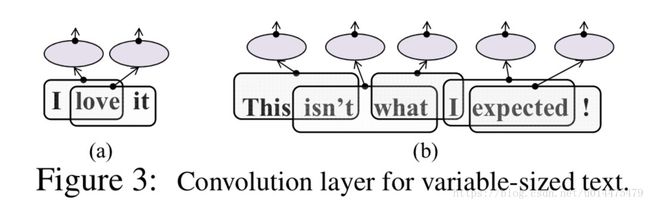

由于每一条句子的长度是不固定的,所以卷积层的输出长度也是不固定的,如图所示:

使用动态pooling的方式可以解决这个问题,通过固定pooling单元的数目,然后动态的改变pooling区域的大小来实现。

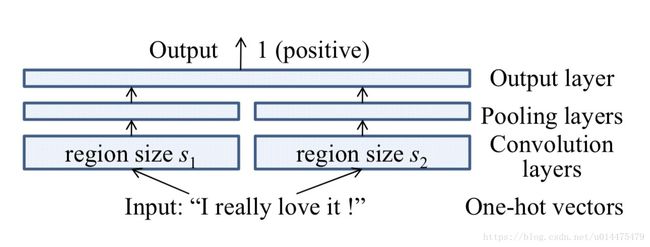

3.Extension: parallel CNN

首先将句子序列中每个词onhot表示,然后可以通过不同size的卷积池化层来对其进行特征抽取,得到结果之后再进行concat,然后再接全连接输出层进行输出。