SLAM练习题(十二)—— ICP(Iterative Closest Point)

SLAM 学习笔记

文章目录

- 推导ICP

- 求解ICP原理

-

- 线性方法(SVD分解)

- 非线性方法

- ICP实战

-

- 代码

- 总结

ICP全称Iterative Closest Point,翻译过来就是迭代最近点。ICP在点云配准领域应用的非常广泛,因此基于深度相机、激光雷达的算法使用ICP的频率比较高。

推导ICP

以下题目来自计算机视觉life从零开始一起学习SLAM系列

推导ICP中的一个步骤

证明:《视觉SLAM十四讲》第174页公式7.55中的

各符号定义见书上,其中,tr表示矩阵的迹。

直接设出 q i , R , q i ′ q_i,R,q_i' qi,R,qi′:

高童靴收集的第二种答案看的不是很懂,暂时就先用这种简单粗暴的方式吧。

求解ICP原理

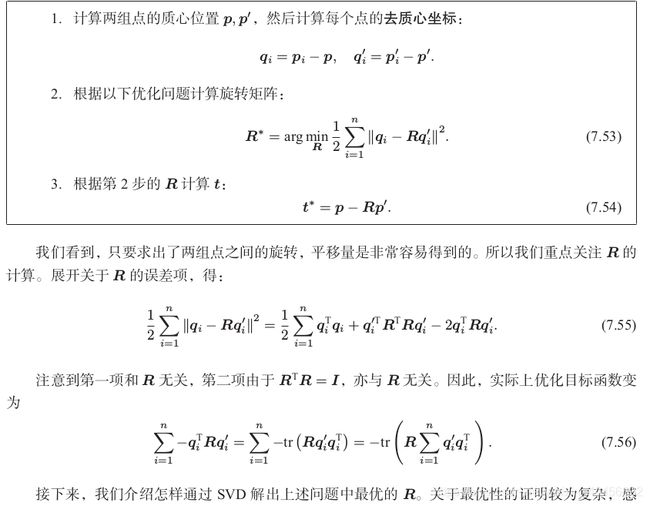

线性方法(SVD分解)

参考14讲173页。

最优性的证明可以参考之前的一篇文章:从零手写VIO(六)

通过对W进行奇异值分解,因为R满秩,所以R=UVT。

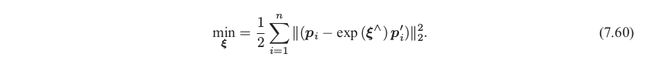

非线性方法

构建无约束优化问题

然后就是使用g2o进行优化了,g2o里面没有3D-3D的边,需要自己构建,自己算算误差对位姿扰动量的偏导数,参考书上175。

ICP实战

以下题目来自计算机视觉life从零开始一起学习SLAM系列

题目: 给定一个轨迹1,数据格式:timestamp tx ty tz qx qy qz qw, 自定义一个任意的旋转矩阵和平移向量(可

以尝试不同的值,甚至加一些噪声看看结果有什么变化),对轨迹1进行变换,得到一个新的轨迹2, 使用ICP算法

(提示:取平移作为三维空间点)估计轨迹1,2之间的位姿,然后将该位姿作用在轨迹2。

验证:ICP算法估计的旋转矩阵和平移向量是否准确;轨迹1,2是否重合。 如下是加了一个旋转平移量后的两个轨迹,经过ICP计算好位姿后再反作用在变换后的轨迹,最终两个轨迹是重合滴!

代码框架及数据 链接:https://pan.baidu.com/s/1a_6FGAd955EPED-duUqpPw 提取码:30sz

代码

/****************************

* 题目:给定一个轨迹1,数据格式:timestamp tx ty tz qx qy qz qw

* 自定义一个任意的旋转矩阵和平移向量(可以尝试不同的值看看结果有什么变化),对轨迹1进行变换,得到一个新的轨迹2

* 使用ICP算法(提示:取平移作为三维空间点)估计轨迹1,2之间的位姿,然后将该位姿作用在轨迹2

* 验证:ICP算法估计的旋转矩阵和平移向量是否准确;轨迹1,2是否重合

****************************/

#include 附:CMakeLists.txt:

cmake_minimum_required( VERSION 2.8 )

project( ICP )

set( CMAKE_BUILD_TYPE "Release" )

set( CMAKE_CXX_FLAGS "-std=c++11 -O3" )

find_package( OpenCV REQUIRED )

# find_package( OpenCV REQUIRED ) # use this if in OpenCV2

FIND_PACKAGE(Pangolin REQUIRED)

FIND_PACKAGE(Sophus REQUIRED)

include_directories(

${

Sophus_INCLUDE_DIRS}

${

Pangolin_INCLUDE_DIRS}

${

OpenCV_INCLUDE_DIRS}

"/usr/include/eigen3/"

)

add_executable( ${

PROJECT_NAME} icp.cpp )

target_link_libraries( ${

PROJECT_NAME}

# ${

Sophus_LIBRARIES}

${

Pangolin_LIBRARIES}

${

OpenCV_LIBS}

/home/yan/3rdparty/Sophus/build/libSophus.so

)

总结

其实就是把原始数据旋转平移一下,然后用旋转后点的数据,使用ICP估计这个旋转平移。;这个旋转是从原始位姿到新位姿的旋转,如果对其R求逆,t取负,就是新位姿到原始数据的变换矩阵,能够把新位姿复位,看是否与原位姿重合。

也可以使用g2o非线性优化方法,参考书上179页。

参考:

视觉SLAM14讲

从零开始一起学习SLAM | ICP原理及应用