Better Performance at Lower Occupancy(一)使用更少线程隐藏计算延迟

这两天看到Vasily Volkov的ppt,对如何更有效的使用GPU做通用计算提出了增加线程级并行以外的另一种方法---增加指令级并行,受益匪浅。刚好也没找到中文版本,就翻译过来与大家交流下,有错误请各位指正,所有的实验结果和图片均出自原ppt。请参考《Better Performance at Lower Occupancy》后面两个案例。

以下为译文:

为提升GPU的效率,常用的方法是提升设备占用率(occupancy),包括在每个流处理器上运行更多的线程和为每个线程块设定更多的线程。人们常常认为这是隐藏延迟的唯一方法,但我们的实验结果证明最大化占用率反而可能会降低性能:

大矩阵相乘,单精度浮点(SGEMM)

1024点复数到复数快速傅里叶变换(FFT),单精度浮点:

两个常见谬误:

1. 多线程是GPU上隐藏延迟的唯一方法。

2. 共享内存和寄存器一样快。

整个报告分成五部分:

1. 使用更少线程隐藏计算延迟。

2. 使用更少线程隐藏内存访问延迟。

3. 使用更少线程来加速。

4. 案例研究:矩阵相乘。

5. 案例研究:FFT。

使用更少线程隐藏计算延迟

计算的延迟

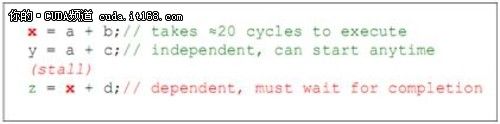

延迟:执行操作所需时间。一次计算操作需要约20个时钟周期,一次内存访问操作需要400+个时钟周期:

以上代码中计算z时,由于z对x的依赖性,在计算x的延迟期内(约20cycle),该操作无法执行。但y的计算由于没有依赖性,因而可以与x的计算重叠(即在20cycle内执行)。

计算的吞吐量

延迟的概念常常与吞吐量的概念混淆,比如“计算比内存操作快100倍----每个warp(G80)只需花费4个时钟周期,而内存操作要花费400个时钟周期”这句话就是错误的,因为前者是比率,而后者是时间。

吞吐量:每个时钟周期完成多少条指令。

计算:1.3Tflop/s = 480 ops/cycle (指令每周期) (指令为乘加运算)

访问显存:177GB/s ≈ 32 ops/cycle (指令为32位装载)

隐藏延迟:在延迟等待时做其他的操作。这样可以运行更快,但上限为峰值。那么怎样达到峰值呢?

使用里特尔定律(Little’s law),即 所需并行度=延迟*吞吐量

那么当前设备的并行度怎样呢?

(延迟随指令的不同而变化)

由于指令的延迟固定,如果没有足够的并行度,就不可能达到100%的吞吐量,也就是说没有足够多的运行中指令,那么就存在空闲指令周期。

怎样得到足够的并行度?

线程级并行(TLP):通常做法是使用足够的线程来提供需要的并行度,比如:在G80上每个SM执行192个线程。

指令级并行(ILP):但你同样可以在单个线程内利用指令间的并行性来达到足够的并行度。

你可以在GPU上同时使用ILP和TLP。

这个规则适用于所有可以运行CUDA的GPU。

比如在G80上,如果没有ILP,你可以通过25%的GPU占用率达到100%的峰值;或者,在每个线程中有三条指令可以同时进行的情况下,通过8%的GPU占用率达到峰值。

而在GF104上,如果要达到66%以上的峰值性能,你则必须应用IPL,因为:每个SM中有48个核,单条指令每次广播给16个核。而为了使每个核都有指令执行,单个时钟周期内必须分发3条指令,但事实上每个SM中只有2个warp调度器,无法分发3条指令。所以NV在这里提供了ILP,每个warp在同一指令周期内却可以分发两条以上的指令,这就给我们提供了使每个核都有指令执行的方法。

我们用实验来证明:

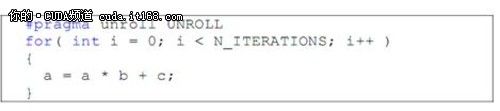

1.不用ILP来运行大量计算指令

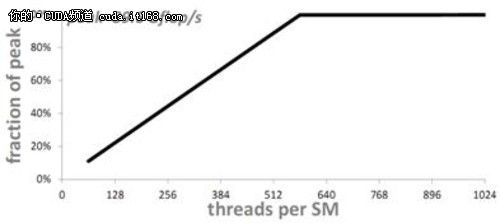

将N_ITERATIONS设定为一个很大的数,选择合适的UNROLL,并保证a,b,c都存储在寄存器中。执行一个block(即只使用一个SM),选择不同的线程块大小,检测所能达到的性能:

GPU为GTX480,理论峰值为1.3Tflop/s,一个SM就是89.6Gflop/s(1.3T/15, GTX480中有15个SM)

可以看到,如果没有ILP,一个SM上需要576个线程才能达到100%的利用率

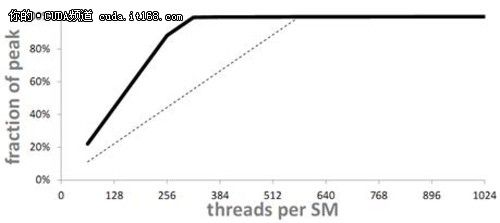

2. 引入指令级并行

实验ILP=2时,即每个线程执行2条相互独立的指令,

那么如果使用更多线程是在GPU上隐藏延迟的唯一方法,则我们应该得到相同的性能曲线,事实上:

虚线标出的是原本曲线,可以看出:

当ILP=2时,只需要320个线程就能达到100%的利用率

加入更多的指令级并行:

当ILP=3时,每个线程3条独立指令:

得到的结果是:

即当ILP=3时,只需要256个线程就可以达到100%利用率。

不幸的是,当ILP超过4时,就不会再扩展了(lz:猜想每个warp在一个时钟周期内最多就只能分发4条指令了)

当ILP=4时,需要192个线程就能达到100%的利用率。

总结

可以通过两种方法隐藏计算延迟

这条同样适用于其他GPU,比如G80架构

谬误:提升占用率是隐藏延迟的唯一方法?错误,提升ILP是另一种方法。

谬误:占用率是衡量GPU利用率的标准?错误,它只是一个影响因素。

谬误:“为完全隐藏计算延迟,流处理器必须在计算能力为1.x的设备上运行至少192个线程,或者在计算能力为2.0的设备上运行384个线程”(出自CUDA Best Practices Guide)。错误,在G80-GT200上通过64个线程,在GF100上通过192个线程同样可以达到目的。