超分辨率重建-PNSR与SSIM的计算(RGB、YUV和YCbCr互转)

RGB、YUV和YCbCr

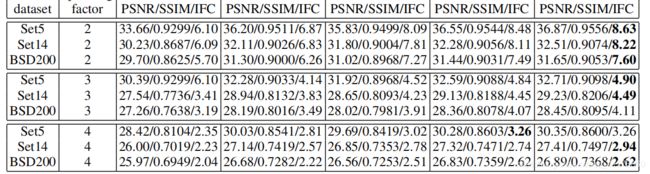

自己复现的FSRCNN网络跑出来的模型进行预测的时候,不知道为啥算出来的结果比论文中要低好多。不论scale factor为多少,我算出来的结果均普遍低于论文中给出的,PSNR大概低个1-2,其他指标正常,后来细读论文,查阅资料,看了一下别人写的网络,发现论文中这个指标是计算的YCbCr彩色空间下的PSNR,所以计算出的结果会有差异。

RGB

RGB(红绿蓝)是依据人眼识别的颜色定义出的空间,可表示大部分颜色。但在科学研究一般不采用RGB颜色空间,因为它的细节难以进行数字化的调整。它将色调,亮度,饱和度三个量放在一起表示,很难分开。它是最通用的面向硬件的彩色模型。该模型用于彩色监视器和一大类彩色视频摄像。还可能见到BGR,它就是把颜色通道换了个位置。

YUV

YUV是北美NTSC系统和欧洲PAL系统中模拟电视信号编码的基础。YUV,电视机的神,哈哈。

在 YUV 空间中,每一个颜色有一个亮度信号 Y,和两个色度信号 U 和 V。亮度信号是强度的感觉,它和色度信号断开,这样的话强度就可以在不影响颜色的情况下改变。YUV 使用RGB的信息,但它从全彩色图像中产生一个黑白图像,然后提取出三个主要的颜色变成两个额外的信号来描述颜色。把这三个信号组合回来就可以产生一个全彩色图像。Y 通道描述 Luma 信号,它与亮度信号有一点点不同,值的范围介于亮和暗之间。 Luma 是黑白电视可以看到的信号。U (Cb) 和 V (Cr) 通道从红 (U) 和蓝 (V) 中提取亮度值来减少颜色信息量。这些值可以从新组合来决定红,绿和蓝的混合信号。

YCbCr

YCbCr 颜色空间是YUV的国际标准化变种,在数字电视和图像压缩(比如JPEG)方面都有应用。YCbCr 是在世界数字组织视频标准研制过程中作为ITU - R BT1601 建议的一部分, 其实是YUV经过缩放和偏移的翻版。其中Y与YUV 中的Y含义一致, Cb , Cr 同样都指色彩, 只是在表示方法上不同而已。在YUV 家族中, YCbCr 是在计算机系统中应用最多的成员, 其应用领域很广泛,JPEG、MPEG均采用此格式。一般人们所讲的YUV大多是指YCbCr。

如何转换

一件非常幸运的事情,OpenCV提供了它们之间互相转换的函数,举个例子:

先读取图片:

t1 = cv2.imread('data/Set5/baby.png')如果图片是RGB的,想要转为YCbCr,就通过以下方式:

t1 = cv2.cvtColor(t1, cv2.COLOR_RGB2YCrCb)除此之外,它们之间可以任意进行转换,甚至还有BGR这种,COLOR_BGR2YCrCb就是BGR转YCbCr,也有COLOR_YUV2BGR是YUV转BGR,COLOR_YCrCb2RGB是YCbCr转RGB,可以根据自己需求进行转换。

也可以用公式进行转换,如RGB与YCbCr互转:

def convert_rgb_to_ycbcr(img, dim_order='hwc'):

if dim_order == 'hwc':

y = 16. + (64.738 * img[..., 0] + 129.057 * img[..., 1] + 25.064 * img[..., 2]) / 256.

cb = 128. + (-37.945 * img[..., 0] - 74.494 * img[..., 1] + 112.439 * img[..., 2]) / 256.

cr = 128. + (112.439 * img[..., 0] - 94.154 * img[..., 1] - 18.285 * img[..., 2]) / 256.

else:

y = 16. + (64.738 * img[0] + 129.057 * img[1] + 25.064 * img[2]) / 256.

cb = 128. + (-37.945 * img[0] - 74.494 * img[1] + 112.439 * img[2]) / 256.

cr = 128. + (112.439 * img[0] - 94.154 * img[1] - 18.285 * img[2]) / 256.

return np.array([y, cb, cr]).transpose([1, 2, 0])

def convert_ycbcr_to_rgb(img, dim_order='hwc'):

if dim_order == 'hwc':

r = 298.082 * img[..., 0] / 256. + 408.583 * img[..., 2] / 256. - 222.921

g = 298.082 * img[..., 0] / 256. - 100.291 * img[..., 1] / 256. - 208.120 * img[..., 2] / 256. + 135.576

b = 298.082 * img[..., 0] / 256. + 516.412 * img[..., 1] / 256. - 276.836

else:

r = 298.082 * img[0] / 256. + 408.583 * img[2] / 256. - 222.921

g = 298.082 * img[0] / 256. - 100.291 * img[1] / 256. - 208.120 * img[2] / 256. + 135.576

b = 298.082 * img[0] / 256. + 516.412 * img[1] / 256. - 276.836

return np.array([r, g, b]).transpose([1, 2, 0])PSNR与SSIM计算

公式原理等等可以参考图像质量评价指标之 PSNR 和 SSIM - 知乎 (zhihu.com)

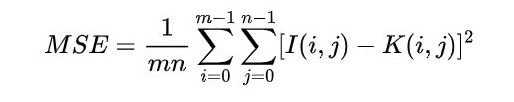

PSNR

SSIM

公式法

PSNR

def psnr1(img1, img2):

mse = np.mean((img1/1.0 - img2/1.0) ** 2)

if mse < 1.0e-10:

return 100

return 10 * math.log10(255.0 ** 2 / mse)

def psnr2(img1, img2):

mse = np.mean((img1 / 255. - img2 / 255.) ** 2)

if mse < 1.0e-10:

return 100

PIXEL_MAX = 1

return 20 * math.log10(PIXEL_MAX / math.sqrt(mse))使用 :

t1 = cv2.imread('data/Set5/baby.png')

t2 = cv2.imread('data/Set5/baby_fsrcnn_x4.png')

print(psnr1(t1,t2))

print(psnr2(t1,t2))在Pytorch中也可以用公式来计算

def calc_psnr(img1, img2):

return 10. * torch.log10(1. / torch.mean((img1 - img2) ** 2))

SSIM这玩意用公式计算太麻烦了,我放弃。

TensorFlow自带函数

TensorFlow计算PSNR

tf.image.psnr(img1, img2, max_val=255)TensorFlow计算SSIM

tf.image.ssim(img1, img2, max_val=255)skimage法

skimage也提供了计算psnr和ssim的函数,如果要安装,就

pip install scikit-imageskimage计算PSNR

skimage.measure.compare_psnr(img1, img2, data_range=255) skimage计算SSIM

skimage.measure.compare_ssim(img1, img2, data_range=255) 有警告就这么写:

skimage.measure.compare_ssim(t1, t2, data_range=255, multichannel=True)