机器学习期末复习

1.有监督学习:

通过已有的训练样本去训练得到一个最优模型,再利用这个模型将所有的输入映射为相应的输出,对输出进行简单的判断从而实现预测和分类的目的,也就具有了对未知数据进行预测和分类的能力。简单来说,就像有标准答案的练习题,然后再去考试,相比没有答案的练习题然后去考试准确率更高。监督学习中的数据中是提前做好了分类信息的, 它的训练样本中是同时包含有特征和标签信息的,因此根据这些来得到相应的输出。

2.无监督学习:

训练样本的标记信息未知, 目标是通过对无标记训练样本的学习来揭示数据的内在性质及规律,为进一步的数据分析提供基础,此类学习任务中研究最多、应用最广的是"聚类" (clustering),聚类目的在于把相似的东西聚在一起,主要通过计算样本间和群体间距离得到。

3.回归:

(1) 把一系列的散点的数据用一条线段尽可能的拟合出来(二维是线段 三维是平面 高维那就是超平面)

(2) 这条曲线不仅仅可以拟合,在未来趋势上也会对未来数值x,进行预测y

4.假设函数: 假设函数就是假设某一个函数,使其能尽可能的代表数据的分布。

5.线性回归:

其表达形式为y = w’x+e,e为误差服从均值为0的正态分布。

回归分析中,只包括一个自变量和一个因变量,且二者的关系可用一条直线近似表示,这种回归分析称为一元线性回归分析。如果回归分析中包括两个或两个以上的自变量,且因变量和自变量之间是线性关系,则称为多元线性回归分析。

6.代价函数:

概况来讲,任何能够衡量模型预测出来的值h(θ)与真实值y之间的差异的函数都可以叫做代价函数C(θ),如果有多个样本,则可以将所有代价函数的取值求均值,记做J(θ)。

7.代价函数性质:

(1) 对于每种算法来说,代价函数不是唯一的;

(2) 代价函数是参数θ的函数;

(3) 总的代价函数J(θ)可以用来评价模型的好坏,代价函数越小说明模型和参数越符合训练样本(x, y);

(3) J(θ)是一个标量;

8.梯度下降

梯度下降小结

9.逻辑回归:

logistic回归是一种广义线性回归(generalized linear model),因此与多重线性回归分析有很多相同之处。它们的模型形式基本上相同,都具有 w‘x+b,其中w和b是待求参数,其区别在于他们的因变量不同,多重线性回归直接将w‘x+b作为因变量,即y =w‘x+b,而logistic回归则通过函数L将w‘x+b对应一个隐状态p,p =L(w‘x+b),然后根据p 与1-p的大小决定因变量的值。如果L是logistic函数,就是logistic回归,如果L是多项式函数就是多项式回归。

logistic回归的因变量可以是二分类的,也可以是多分类的,但是二分类的更为常用,也更加容易解释,多类可以使用softmax方法进行处理。实际中最为常用的就是二分类的logistic回归。

10.逻辑回归的适用条件:

(1) 因变量为二分类的分类变量或某事件的发生率,并且是数值型变量。但是需要注意,重复计数现象指标不适用于Logistic回归。

(2) 残差和因变量都要服从二项分布。二项分布对应的是分类变量,所以不是正态分布,进而不是用最小二乘法,而是最大似然法来解决方程估计和检验问题。

(3) 自变量和Logistic概率是线性关系

(4) 各观测对象间相互独立。

11.朴素贝叶斯:

带你理解朴素贝叶斯分类算法

12.ID3算法:

这个 算法的基础是奥卡姆剃刀原理,越是小型的决策树越优于大的决策树,尽管如此,也不总是生成最小的树型结构,而是一个启发式算法。在信息论中,期望信息越小,那么信息增益就越大,从而纯度就越高。ID3算法的核心思想就是以信息 增益来度量属性的选择,选择分裂后信息增益最大的属性进行分裂。该算法采用自顶向下的贪婪搜索遍历可能的决策空间。

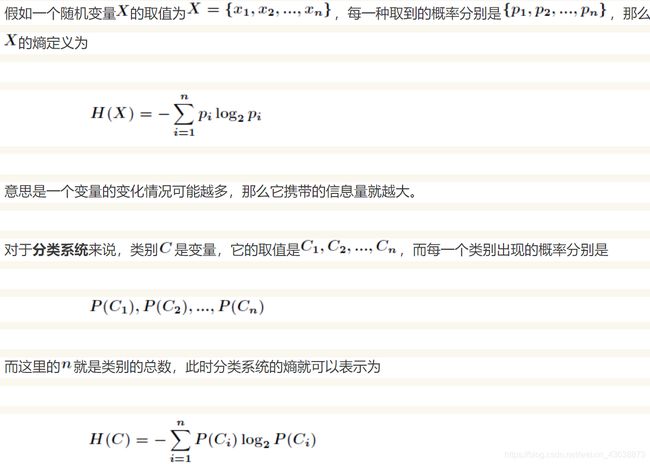

13.信息熵:香农引入了信息熵,将其定义为离散随机事件出现的概率,一个系统越是有序,信息熵就越低,反之一个系统越是混乱,它的信息熵就越高。所以信息熵可以被认为是系统有序化程度的一个度量。

信息熵实例:

14.信息增益:信息增益是针对一个一个特征而言的,就是看一个特征t,系统有它和没有它时的信息量各是多少,两者的差值就是这个特征给系统带来的信息量,即信息增益。

15.C4.5算法:C4.5是一系列用在机器学习和数据挖掘的分类问题中的算法。它的目标是监督学习:给定一个数据集,其中的每一个元组都能用一组属性值来描述,每一个元组属于一个互斥的类别中的某一类。C4.5的目标是通过学习,找到一个从属性值到类别的映射关系,并且这个映射能用于对新的类别未知的实体进行分类。

16.人工神经网络:人工神经网络的核心成分是人工神经元。每个神经元接收来自其他几个神经元的输入,将它们乘以分配的权重,将它们相加,然后将总和传递给一个或多个神经元。一些人工神经元可能在将输出传递给下一个变量之前将激活函数应用于输出。人工神经网络由一个输入层和一个输出层组成,其中输入层从外部源(数据文件,图像,硬件传感器,麦克风等)接收数据,一个或多个隐藏层处理数据,输出层提供一个或多个数据点基于网络的功能。

17.激活函数作用:

激活函数在人工神经网络的神经元上运行,负责将神经元的输入映射到输出端。引入激活函数是为了增加神经网络模型的非线性。没有激活函数的每层都相当于矩阵相乘。就算你叠加了若干层之后,无非还是个矩阵相乘罢了。如果不用激活函数,每一层输出都是上层输入的线性函数,无论神经网络有多少层,输出都是输入的线性组合,这种情况就是最原始的感知机。如果使用的话,激活函数给神经元引入了非线性因素,使得神经网络可以任意逼近任何非线性函数,这样神经网络就可以应用到众多的非线性模型中。

18.归一化:把数变为(0,1)之间的小数,主要是为了数据处理方便提出来,把数据映射到0-1范围内处理,更加快速便捷。主要优点是加快训练网络的收敛性。

19.正则化原理:在损失函数上加上某些规则(限制),缩小解空间,从而减少求出过拟合解的可能性

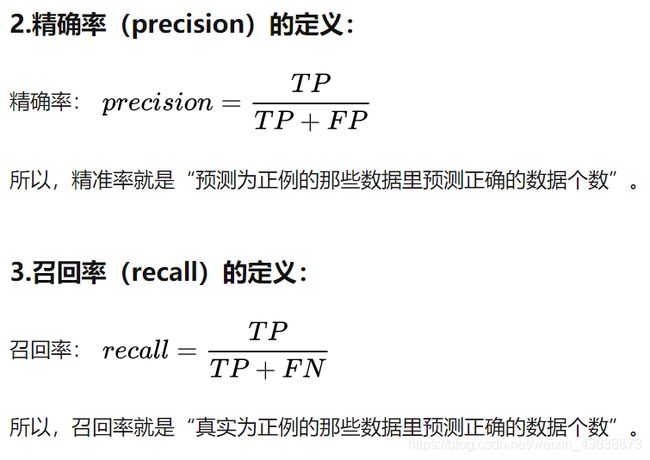

21.查准率和查全率:

在二分问题的情况下(非对即错,非0即1):

查准率(Precision)就是你认为是对的样例中,到底有多少真是对的。

查全率(Recall)就是所有对的样例,你找出了多少,或者说你判断对了多少。

23.过拟合和欠拟合的判断依据:

我们可以绘制这个模型的学习曲线,通过学习曲线的形态来判断。所谓学习曲线就是训练集得分和验证集得分随着训练样本数的增大而变化的曲线。当模型出现欠拟合和过拟合情况时,学习曲线一般有不同形状

欠拟合情况:随着训练样本数增大,训练集得分和验证集得分收敛,并且两者的收敛值很接近。

过拟合情况:随着训练样本数增大,训练集得分和验证集得分相差还是很大。

24.过拟合解决方案:

(1)数据层面

增加数据的量,或者增加数据的多样性,让模型学到更有效的特征。

(2)模型层面

降低模型的复杂度,把模型变得更简单。如决策树的剪枝算法、神经网络中的L2/L1正则化等。

(3)训练层面

使用验证集,当验证集发生过拟合现象时及早停止模型。

在训练过程中使用正则化技术,如神经网络中的Dropout、L2、L1正则化等。

(4)模型融合

把多个模型集成在一起,降低模型过拟合的风险,如Bagging方法。

25.欠拟合解决方案:

(1)添加新的数据特征

(2)增加模型复杂度,假设一个更复杂的空间

(3)减小正则化系数

(4)增加模型训练时间,直到模型收敛为止