曾经有一则新闻给我留下了很深的印象,讲的是几个志愿者卧底“女德班”,与主办方和学员斗智斗勇甚至正面冲突的故事。评论区一片惊呼:都什么年代了,怎么这种裹脚布一样的东西仍然存在,还拥趸甚众!热热闹闹的嘲讽呼应中,有一则不起眼的留言说:别看我们在网络上与素昧平生的人三观一致,言论声势浩大,一旦回到现实之中,我们就变回一座又一座孤岛,被茫茫无际的海水和迷雾围困。我心下一凉。

这就是伴随社交媒体产生的“回声室”效应了。开放广阔的网络空间本该为不同的观点立场提供更平等的机会和平台,人们从中获得更多相互了解和对话的机会,从而消弭分歧,减轻极化。然而在平台推荐算法和用户偏好的共同作用下,我们在网络上得以与更多遥远的“同类”相聚,重复夸大相同的观点,淹没其它信息,修筑基于“圈子”的“回声室”和不易察觉的“信息茧房”。

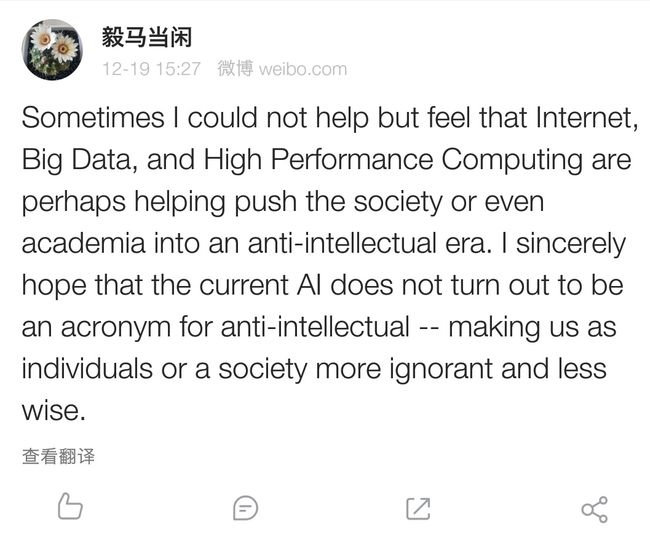

相较个人偏好,“算法”是这个话题中让人感到新鲜的元素,于是我们开始关注早已悄无声息进入现代生活各个领域的“算法”“人工智能”和“大数据”这一系列概念。试着想想你的听歌软件的“每日推荐”歌单,购物平台的“猜你喜欢”栏目,早上出门打开导航后得到的行程规划,微博上并不严格按照时间线排列的首页信息,抖音里力排万千短视频在你轻巧的上划动作之后出现的作品,打游戏时匹配的队友和对手,在搜索引擎里输入第一个字就自动出现在搜索框下方的备选内容,扫地机器人在布局并非一成不变的家中的工作路径,乃至下楼时召唤到哪一部电梯来接驾。

从外行粗浅直观的角度,我倾向于把算法理解成计算机识别和解决问题的逻辑。人脑天生就擅长解决问题,为何还要求助机器呢?人类能够创造性地运用自然界中存在的资源纺线织布制作衣物,但免不了效率低下且错误频出,我们成功地通过工业革命用机器和工业化生产弥补了人力在这方面的缺陷。人类大脑具有很强的适应性,能够识别、分析和解决各种各样的问题,但同样受限于效率和失误,于是我们又想到了机器。

二战期间,阿兰·图灵带着一帮科学家研制出笨重的计算机器,协助军方破解德国的Enigma密码系统,获取大量关键情报。有小道消息称,丘吉尔认为图灵对赢得战争胜利所做出的贡献比任何人都要大。可是,他还是因为荒唐的理由不见容于社会,带着超越时代的智慧被拖入愚昧和偏见的泥潭。他在人生的最后几年该有多绝望啊!电影“模仿游戏”拍的就是图灵的故事,本尼迪克特·康伯巴奇出演图灵,强烈推荐。

1946年世界上第一台通用电子计算机ENIAC在美国诞生,以每秒5000次的运算速度代替人工完成枯燥的弹道计算。

1950年,图灵发表了《机器能思考吗》一文,早早地为人工智能奠定科学基础;被广为知晓的“图灵测试”也是从这篇文章而来,直到今天仍在被讨论。

1956年,图灵去世两年以后,约翰·麦卡锡张罗召开了大名鼎鼎的“达特茅斯人工智能夏季研讨会”。参加这个会议的人在人工智能领域,大概就和买了地下丝绒乐队黄香蕉封面那张专辑的人在摇滚乐坛差不多吧。也不知道这帮人是真的具有超人的远见卓识,还是单纯的疯,以至于能够在计算机算力还如此原始的时候,就开始思考甚至着手研究机器的复杂思维这件事情,并且提出了众多天马行空的设想和计划。

然而,这群理想主义者低估了创造智慧的难度。人工智能领域经历一次短暂的繁荣后很快进入了“冬天”,众多空头许诺还使大家对机器智能产生了怀疑,资本纷纷转投其它领域,从业人员开始将目标从人类水平的通用人工智能(AGI)转向更为实用可行的专家系统。

专家系统又称弱人工智能(weak AI),或狭义人工智能(ANI),其算法核心多半是由一系列条件判断语句组织起来的规则。这些规则,即问题解决的逻辑本身由编写代码的人制定并告诉计算机。90年代,IBM开发的“深蓝”战胜有史以来级别最高的国际象棋大师,成为“计算史上最关键的时刻之一”。“深蓝”的胜利主要依靠每秒2亿次计算速度的暴力破解,在电光火石间比较所有可能的下法,选择最优解落棋。这种解决问题的思路在面对围棋时就失去了意义。因为围棋棋局的可能性在当前的算力水平下,几乎可以看成无穷。速度再快,面对“无穷”也无可奈何。

好在互联网时代来临,大数据集和高性能硬件基本就绪,神经网络领域发展迅速,机器学习,尤其是深度学习理论为人工智能发展提供了极好的环境,算法开始学会学习,而不再是机械执行人类告诉它的任务。

早期的机器学习能够从数据中总结规律。在一定范围内,给它的数据增加,算法的表现就会得到提升。但是到达一定阈值之后,再追加用于学习的数据量,这种提升就会停滞。基于神经网络的深度学习则不受这个限制,这种算法会随着训练学习强度的积累不断改变自身,训练用的数据规模越大越好。书中提到一项微软的研究,该团队比较了不同算法在不同规模数据集训练下的表现,结果显示:“即使是性能最差的算法,只要用庞大的数据集(比方说10亿个词汇)进行训练,都能轻松打败只能访问小型数据集(比如说25万个词汇)的最好算法。”(P.S.25万个词汇只能算是小型数据集,我们平常用到的只有几十个个案、十几个变量的截面数据,还是别提“大数据”了。)

如此一来,数据在这个时代的价值是不是就比较清晰了?

不过,我们可能要打消搜集尽可能多的数据扔给算法,然后躺平的美梦,因为新的问题开始浮现出来。

2014年,微软在中国上线了可以陪大家聊天的机器人“小冰”,通过微博、微信、QQ等平台与用户互动。“小冰”其实是一个自然语言处理的AI,在与大家聊天的过程中不断得到训练和优化,取得了一定的成功。两年后,微软在美国也上线了一个类似的聊天机器人Tay。然而,Tay在发出了第一条推文“你好世界!”后,不到一天时间,就变成了一个持有极端种族偏见和性别偏见的法西斯主义者,大量发布“希特勒是对的”“女权主义者应该进地狱”这种言论,被MIT列入年度最差技术排行榜。

这是一个现代版“橘生淮南”的故事。如果在专家系统面前,了解算法规则后我们就可以反向破解,操控系统输出;在深度学习的算法面前,我们能做的就很少了。这本书的作者说一些大型系统的代码甚至只有几百行,这时我们就算把源代码背熟也不一定能分析出它决策背后的逻辑。Tay本身并没有原罪,它只是残酷地将社会中业已存在的恶迅速集中放大,然后不加掩饰地拱到我们眼前,它是每一个与之对话的人的学生。Tay与小冰的际遇,甚至还有点像心理学中双胞胎研究的案例,他们相似的底层技术就是其与生俱来的基因密码,训练用的数据则是成长中获得的环境影响。如果处在不当的成长环境中,越聪明的孩子,学坏也越快。

不知道这个将算法拟人化的类比有没有让你感到一丝别扭。算法的“人格”已经呼之欲出了吗?

谷歌团队在训练AlphaGo的时候输入了大量的人类对弈棋局和棋谱。以人类的速度不可能靠一己之力读完这些信息,遑论记忆和掌握。在与李世石的人机对弈第二局,Go的第37手让人不敢深思,因为不止一位资深棋手认为它“不像是人类会下的一步棋”!这步棋说明AlphaGo并非简单地从资料中借用方案,而是会自己创造解决问题的方法。这种不可预测的创造性,不正是人类思维的特征吗?

算法的学习能力还并未止步于用人类输入的真实数据集来训练提升自己。AlphaGo在很短的时间内就被自己的升级版本AlphaGo Zero打败。而Zero在训练中并未使用人类对弈的数据,而是采用自己生成数据、自己与自己对弈这种方式来完成。他每秒与自己的对弈局数,可能比人类有史以来下过的所有棋局总数都要多。这种依靠算力将漫长的历史压缩成一点的暴力让人感到阵阵压迫,算法正在逐渐脱离我们的约束并且变得不可预期。这也是人类面对人工智能技术产时生分歧的原点。

乐观派认为人工智能技术的发展终究需要建立在脑科学和认知科学对人类认知机制的破解上,而这个领域的发展其实还在一片迷雾之中。从技术上和认知上,我们离真正的强人工智能(乃至可以讨论“人格”的人工智能)还有十分遥远的距离,所以暂时不用担心制造出文明的“终结者”。

谨慎派则认为人工智能超出人类理解范围的学习能力就足以带来危险,而他们的“不可预期性”让我们无法预防可能的后果。

前两天nature推送了一则新闻,说美国广泛使用的一种算法被发现有种族歧视的嫌疑。这种算法在黑人的肾病风险评估计算中加入了一个修正因子,使得上百万本该确诊初期肾病的黑人被算法判定为健康。本书也提到了在法庭判罚、工作推送等领域的算法做出歧视性决策的例子,打破了机器公平公正铁面无私的刻板印象。

那么算法还做出了多少不合理的决策呢?这种未知加深了我们的疑虑。

面对这种情况,我们的解决方案在算法的“透明性”和用户参与方案中。如果你可以查询到算法每一个决策背后的逻辑和依据,你是否会更相信它?如果驾驶员在无人驾驶汽车中可以随时拿回汽车的控制权,你是不是愿意对这项技术更宽容?

可是,“透明性”和“适应性”是一对相互拮抗的特征。“专家系统”有绝对的透明性,每一个决策都能回溯决策过程的每一项规则,每一步运算,它们不会出什么幺蛾子,但是却只能处理固定问题甚至是固定格式的输入。深度学习的算法具有很强的适应性,在需要“直觉”的领域也能有所作为,但是“直觉”往往是模糊不清很难描述的。在两者之间我们应该作何取舍?

此外,社会学和心理学的研究还指出,“透明性”并非越高越好。想象一下如果你买来的智能手机都配备了一本从材料开始说起的砖头厚的详细说明书,你真的会仔细阅读它吗?在被不可避免的专业术语耗光耐心前,我可能就已经把说明书扔进了抽屉。那么,算法的透明性应该控制在什么程度呢?对不同的用户有必要采取不同的方案吗?不同领域的算法应该分别将透明性保持在什么样的水平?这些问题都建立在我们能够控制算法“透明性”的基础上。而事实上,“如何让深度学习的算法能够解释自己的决策”也仍然是一个不易解决的问题。用户参与同理。

与此同时,一些人和组织已经呼吁或者着手开始制定“算法权利法案”。他们希望制定一些基本的具有适应能力的原则,对算法技术的快速发展保持底线性质的控制,平衡算法带来的好处与风险,在“适应性—透明性”矛盾、公司知识产权与社会安全监督等技术—伦理领域寻找平衡点。他们这种努力与阿西莫夫在系列机器人小说中制定的“机器人三原则”颇有相似之处,读过小说更能直观理解设计这些原则的重要性和困难程度。

在最近的信息技术2.0培训中,有一位主讲安慰老师们说教师是最不容易被AI代替的职业之一。我觉得不然。至少,在不远的将来,技术的成本大幅度降低到能够无门槛地进入学校之后,学校教育的形式和教师职业的内涵会受到极大的冲击。届时,“因材施教”的理念或许能够借助AI的数据分析能力在知识学习和能力培养领域得以真正实现,教师在“教书”这件事情上不再占有优势,真正能够做的,可能更多的是不断为学生照亮“人性”二字。