- Python 原生爬虫

eddie_k2

Pythonpython爬虫开发语言

Python描述代码描述爬网站的页面配合正则表达式设置定时任务仅学习参考,切勿使用其他用途代码importreimportscheduleimporttimefromurllib.requestimporturlopenclassSpider:def__init__(self):#初始化代码...pass#self.start_schedule()#需要爬的网址url='https://www.*

- 高速图像采集卡设计原理图: 613-VU9P信号处理板卡

大嘴教授

信号处理fpga开发

基于6UVPXC6678+XCVU9P的信号处理板卡一、板卡概述板卡基于6UVPX标准结构,包含一个C6678DSP芯片,一个XCVU9P高性能FPGA,双路HPCFMC。二、处理板技术指标•DSP处理器采用TI8核处理器TMS320C6678;•DSP外挂一组64bitDDR3颗粒,总容量2GB,数据速率1333Mb/s;•DSP采用EMIF16NorFlash加载模式,NorFlash容量32

- 【vivado】debug相关时钟及其约束关系

liuchj04

XilinxSoCFPGAfpga开发

一、前言在xilinxfpga的degug过程中,经常出现由于时钟不对而导致的观测波形失败,要想能够解决这些问题需要了解其debug的组成环境以及之间的数据流。本文主要介绍debug过程中需要的时钟及各时钟之间的关系。二、debug相关时钟Vivado硬件管理器使用JTAG接口与VivadoDebug内核进行通信,DebugHub在FPGA器件的JTAG边界扫描(BSCAN)接口和VivadoDe

- 【电路笔记 TMS320C6***DSP】外部存储器接口 A EMIFA向FPGA(作为异步存储器)写入数据的示例

FakeOccupational

硬件和移动端fpga开发笔记

目录DSP和FPGA的连接DSP端:传输数据给FPGAFPGA端:接收数据EMIFA(ExternalMemoryInterfaceA)的“异步存储器”(AsynchronousMemory)指的是那些不与系统时钟同步进行读写操作的外部存储设备。这类存储器使用特定的控制信号(如芯片选择、输出使能、写使能等)来管理数据传输,而不是依赖于一个全局时钟信号。这意味着数据传输的时机是由控制信号的变化触发的

- 【国产FPGA入学必备】国产FPGA权威设计指南+配套FPGA图像视频教程

小眼睛FPGA

fpga开发

本原创文章由深圳市小眼睛科技有限公司创作,版权归本公司所有,如需转载,需授权并注明出处(www.meyesemi.com)一、《国产FPGA权威设计指南》简介为更好地服务广大FPGA工程师和高等学校师生,2025,紫光同创携手金牌方案提供商小眼睛科技,组织了数十位应用技术专家,共同编写《国产FPGA权威设计指南》。本书系统地介绍紫光同创FPGA的开发与应用,详细阐述FPGA开发的各个方面,从基础原

- FPGA开发,使用Deepseek V3还是R1(2):V3和R1的区别

LeeConstantine

用Deepseek开发FPGAfpga开发

以下都是Deepseek生成的答案FPGA开发,使用DeepseekV3还是R1(1):应用场景FPGA开发,使用DeepseekV3还是R1(2):V3和R1的区别FPGA开发,使用DeepseekV3还是R1(3):系统级与RTL级FPGA开发,使用DeepseekV3还是R1(4):Deepseek参数配置FPGA开发,使用DeepseekV3还是R1(5):temperature设置FPG

- 【安路科技FPGA软件TangDynasty】避坑总结和心得

月薪不过亿

fpga开发科技

前面的话作为为数不多的几个“纯国产化”的FPGA芯片,安路科技的FPGA芯片在军工领域有着很大的号召力。平心而论,安路科技的FPGA只能说够用,在速度越来越快资源越来越丰富的FPGA领域,真正干大活,还得是别家,甚至很多场景下只能用xilinx家或者altera的,哦不,是AMD和INTEL家的。本文主要总结一下在使用安路FPGA以及安路TD软件这些年来踩过的坑、那些反直觉的使用体验以及一些设计心

- 【PCIE737】基于全高PCIe x8总线的KU115 FPGA高性能硬件加速卡

北京青翼科技

图像处理产品图像处理信号处理人工智能智能硬件

产品概述PCIE737是一款基于PCIE总线架构的KU115FPGA的12路光纤通道处理平台,该板卡具有1个PCIeGen3x8主机接口、3个QSFP+40G光纤接口,可以实现3路QSFP+40G光纤的数据实时采集、实时缓存与PCIE高速传输。该板卡采用Xilinx的高性能KintexUltraScale系列FPGAXCKU115作为主处理器,板载4组独立的64位DDR4SDRAM超大容量数据缓存

- 【FMC165】基于 VITA57.1 标准的 2 路 1GSPS 14 位 AD 采集、4 路 2.5G 16 位 DA 回放 FMC 子卡(100%国产化)

北京青翼科技

FMC子卡fpga开发人工智能图像处理信号处理AI编程

FMC165是一款基于VITA57.1规范标准的,实现2路14-bit、1GSPSADC同步采集,4路16-bit2.5GSPSDAC同步回放功能的FMC子卡模块。该模块可直接与符合VITA57.1标准的FPGA载卡配合使用,板卡ADC器件采用ADI公司的AD9680国产替代品,该芯片具有两个模拟输入通道和4个JESD204B输出数据通道,可用于对高达2GHz的宽带模拟信号进行采样。板卡DAC器件

- 测量纹波是否合格的标准是什么?

CircuitWizard

硬件工程师成长之路硬件工程

测量纹波是否合格需要结合具体应用场景和技术规范,以下为收集到的详细判断标准及分类说明:一、通用行业标准数字电路基础逻辑电路(如TTL/CMOS):<100mVpp高速数字电路(DDR/FPGA):<50mVpp处理器核心供电(如CPU/GPU):<30mVpp注:高频噪声需额外控制在10mV以下模拟电路运算放大器电源轨:<10mVpp音频电路(DAC/ADC):<5mVpp高精度传感器供电:<1m

- FPGA的滤波器设计流程

LeeConstantine

用Deepseek开发FPGAfpga开发

在FPGA滤波器设计中,合理的流程规划能显著提高设计效率和可靠性。以下是针对数字滤波器设计的结构化开发流程建议:一、设计前期准备阶段1.需求规格化(关键第一步)明确滤波参数:-采样率:100KS/s-截止频率:20KHz(低通)-阻带衰减:>40dB-实时性要求:处理延迟<5个采样周期确定硬件约束://示例约束模板parameterCLK_FREQ=100_000_000;//100MHz主频pa

- Xilinx FPGA用于QSFP模块调试的实战指南

不教书的塞涅卡

本文还有配套的精品资源,点击获取简介:本项目旨在利用XilinxFPGA进行QSFP模块的调试,着重介绍接口设计、PHY层配置、逻辑控制、误码率测试和眼图分析等关键步骤。QSFP作为数据中心和电信网络的高带宽传输解决方案,其调试在100Gbps时代尤为关键。通过此项目,开发者将掌握高速接口调试的核心技能,并提升在光通信系统中应用FPGA的专业能力。1.FPGA在电子设计中的应用1.1FPGA的基本

- 深入解析:FIR滤波器在FPGA上的设计与实现全流程

king-agic

FPGAfpga开发经验分享

在FPGA中实现FIR(FiniteImpulseResponse)滤波器涉及多个步骤,包括滤波器设计、系数量化、硬件架构设计、HDL(HardwareDescriptionLanguage)编码、综合、布局布线以及验证。1.滤波器设计使用软件工具如MATLAB、Octave或者Python中的SciPy库来设计FIR滤波器。定义滤波器的规格,例如采样频率、截止频率、通带和阻带衰减等。生成滤波器的

- FPGA开发,使用Deepseek V3还是R1(4):Deepseek参数配置

LeeConstantine

用Deepseek开发FPGAfpga开发语言模型

以下都是Deepseek生成的答案FPGA开发,使用DeepseekV3还是R1(1):应用场景FPGA开发,使用DeepseekV3还是R1(2):V3和R1的区别FPGA开发,使用DeepseekV3还是R1(3):系统级与RTL级FPGA开发,使用DeepseekV3还是R1(4):Deepseek参数配置FPGA开发,使用DeepseekV3还是R1(5):temperature设置FPG

- WPF复制异常问题(OpenClipboard 失败 (异常来自 HRESULT:0x800401D0 (CLIPBRD_E_CANT_OPEN)))

互联网搬砖老肖

闲谈wpf

最近在维护WPF系统的时候发现的问题,刚刚开始自己的电脑都不能重现,后面写日志跟踪才发现问题的所在。问题主要是由于:1.在程序访问剪切板的时候,有其他程序正在占用剪切板,导致自己的程序无法访问,从而抛出异常;2.没有访问的权限,导致自己的程序无法访问。这个是之前在App.xaml.cs文件中的写法: #region / /处理异常的方法 /

- FPGA开发,使用Deepseek V3还是R1(5):temperature设置

LeeConstantine

用Deepseek开发FPGAfpga开发

以下都是Deepseek生成的答案FPGA开发,使用DeepseekV3还是R1(1):应用场景FPGA开发,使用DeepseekV3还是R1(2):V3和R1的区别FPGA开发,使用DeepseekV3还是R1(3):系统级与RTL级FPGA开发,使用DeepseekV3还是R1(4):Deepseek参数配置FPGA开发,使用DeepseekV3还是R1(5):temperature设置FPG

- Vivado 约束文件XDC使用经验总结

宁静致远dream

FPGA不积跬步

1.1Vivado约束文件XDC使用经验总结1.1.1本节目录1)本节目录;2)本节引言;3)FPGA简介;4)Vivado约束文件XDC使用经验总结;5)结束语。1.1.2本节引言“不积跬步,无以至千里;不积小流,无以成江海。就是说:不积累一步半步的行程,就没有办法达到千里之远;不积累细小的流水,就没有办法汇成江河大海。1.1.3FPGA简介FPGA(FieldProgrammableGateA

- 基于FPGA的数字信号处理(18)--半加器和全加器

孤独的单刀

基于FPGA的数字信号处理fpga开发信号处理Verilog入门定点数Xilinx浮点数DSP

目录1、前言2、半加器3、全加器4、用半加器实现全加器文章总目录点这里:《基于FPGA的数字信号处理》专栏的导航与说明1、前言在数字系统中,加法运算是最常见的算术运算,同时它也是进行各种复杂运算的基础。2、半加器最简单的加法器叫做半加器(HalfAdder),它将2个输入1bit的数据相加,输出一个2bits的和,和的范围为0~2(10进制)。和的高位也被称为进位(Carry),和的低位则通常被直

- 驱动开发系列39 - Linux Graphics 3D 绘制流程(二)- 设置渲染管线

黑不溜秋的

GPU驱动专栏驱动开发

一:概述Intel的Iris驱动是Mesa中的Gallium驱动,主要用于IntelGen8+GPU(Broadwell及更新架构)。它负责与i915内核DRM驱动交互,并通过Vulkan(ANV)、OpenGL(IrisGallium)、或OpenCL(Clover)来提供3D加速。在Iris驱动中,GPUPipeline设置涉及多个部分,包括编译和上传着色器、设置渲染目标、绑定缓冲区、配置固定

- FPGA中利用fifo时钟域转换---慢时钟域转快时钟域

@晓凡

FPGA学习之路fpga开发

FPGA中利用fifo时钟域转换—慢时钟域转快时钟域一、时间计算方法FIFO的输入数据的时钟是40MHz,FIFO输出数据取60MHz,刚好是40MHz的1.5倍,将慢时钟域转快时钟域。另外,fifo输出的数据,要输出给上位机,一帧数据要传输640*512=327680个像素数据,要求帧频为100Hz,对应的时间是1/100Hz=10ms,即要求10ms内将327680个数据传输完毕。验证fifo

- 算力革新引领数字中国智能跃迁

智能计算研究中心

其他

内容概要算力作为数字经济的核心驱动力,正通过架构创新与场景融合加速重构技术生态。当前算力体系呈现三大演进方向:异构计算突破传统芯片性能瓶颈,实现CPU、GPU、FPGA等多元架构的协同调度;边缘计算推动工业设备、物联网终端等场景的实时响应能力提升,形成“云-边-端”三级计算网络;量子计算则在加密通信、药物研发等领域展现颠覆性潜力,其物理比特操控精度已达实用化临界点。技术方向核心特征典型应用场景异构

- 【教程4>第1章>第4节】FPGA时序图制作小工具

fpga和matlab

#fpga开发时序图

欢迎订阅《★教程1:matlab入门100例》《★教程2:fpga入门100例》《★教程3:simulink入门60例》《★教程4:FPGA/MATLAB/Simulink联合应用开发入门与进阶X例》教程4·目录·目录1.软件版本2.FPGA时序图概述3.FPGA时序图绘制4.视频操作步骤5.总结与展望

- FPGA三大串行通信接口之UART

ritian73

FPGAuartfpga开发

UART是一种通用串行数据总线,用于异步通信。该总线双向通信,可以实现全双工传输和接收。在嵌入式设计中,UART用于主机与辅助设备通信,如汽车音响与外接AP之间的通信,与PC机通信包括与监控调试器和其它器件,如EEPROM通信。UART通信在使用前需要做多项设置,最常见的设置包括数据位数、波特率大小、奇偶校验类型和停止位数。数据位(Databits):该参数定义单个UART数据传输在开始到停止期间

- 高效能计算与高速数据传输的完美结合:飞腾D2000处理器与复旦微双FPGA集成主板

国产化嵌入式平台解决方案

fpga开发linux硬件工程硬件架构pcb工艺嵌入式硬件

随着数字化转型和高性能计算需求的不断增长,工业、通信、人工智能等领域对硬件平台的性能要求也在不断提升。为应对这些挑战,一款高效能、灵活可扩展的定制主板应运而生,基于飞腾D2000处理器和复旦微FPGA技术,提供了一流的计算能力和高速数据传输能力,成为企业高性能计算与数据处理需求的理想选择。这款主板并非通用的开发板,而是针对特定需求的定制化设计。它更适合那些需要高性能计算、FPGA并行处理或高速通信

- 超硬核!DeepSeek 全面赋能 FPGA 工程师,实操干货大放送

AI_DL_CODE

fpga开发DeepSeek人工智能深度学习AI大语言模型

摘要:本文聚焦DeepSeek大语言模型在FPGA开发中的实操应用。通过搭建Python通信环境,实现与模型交互,助力FPGA工程师多方面工作。涵盖代码编写与优化,如生成代码框架、获取优化建议;技术文档理解与撰写,像解读复杂文档、辅助撰写报告;问题排查与解决,提供故障诊断思路和解决方案;以及学习与知识拓展,定制学习路径、追踪前沿技术。虽存在挑战,但实操展示了其巨大潜力,为FPGA工程师提供高效工作

- 基于FPGA的图像拼接处理卡

科恒盛远

fpga开发图像处理硬件工程

板卡介绍主要功能是实现对6路输入视频信号经过FPGA缩放后,叠加到一路视频中,并通过VGA接口和DVI接口同时显示叠加后的视频。输出可以是任意输入视频的四画面拼接,也可以是任意输入视频的六画面拼接。同时能通过串口接收主机的控制命令,切换显示拼接的形式。板卡照片原理框图实验效果1(六画面)实验效果2(四画面)技术指标☆主要功能:将输入的两路电视视频,两路VGA视频,两路DVI视频,经过FPGA缩放后

- ADV212图像压缩芯片调试记录一

cjx_csdn

fpga开发verilog

项目场景:最近两个月在调试ADV212芯片,目的是在FPGA平台上采用该芯片实现对图像数据的压缩功能。不得不说,这款芯片是我目前遇到的调试起来“较为”复杂的一款芯片了,光芯片手册就有六部分(1.ADV212;2.ADV202_HIPI_mode;3.ADV212_UserGuide;4.ADV212ProgrammingGuide;5.HIPI_mode_overview;6.TechNote_A

- 人工智能在fpga的具体应用_FPGA创意人工智能研发 校企合作培养专业人才

墨墨猪

人工智能在fpga的具体应用

FPGA英特尔®FPGA与人工智能技术培训——成都信息工程大学站人工智能在21世纪初迎来以深度学习与大数据云计算为主导的第三次浪潮,在无人驾驶、医疗保健、工业等多个领域得到广泛应用。随着人工智能理论和技术日益成熟,FPGA在人工智能方面的应用也越来越多,特别对于需要分析大量数据的AI、大数据以及机器学习等研究领域。人工智能与FPGA的灵活应用,对人工智能专业人才培养提出了更高要求。英特尔®FPGA

- Vulkan:Vulkan基础架构与环境搭建_2024-07-20_13-37-15.Tex

chenjj4003

游戏开发网络服务器linux前端数据结构androidjava

Vulkan:Vulkan基础架构与环境搭建Vulkan简介Vulkan的历史与发展Vulkan是一个跨平台的2D和3D图形及计算API,由KhronosGroup开发。KhronosGroup是一个由多家公司组成的非营利性行业联盟,负责制定和维护多种开放标准,包括Vulkan、OpenGL、OpenCL等。Vulkan的设计目标是提供更高效、更直接的硬件访问,以减少CPU在图形渲染中的开销,同时

- 广州游戏公司招聘4399秋季招聘火热报名中(第二次笔试来了)

han_xue_feng

java

诺瓦面经9.4吉比特笔试情况+第三题代码拼多多面经美团产品运营(到家医药电商)已offer拼多多基础电商后端面经8.22拼多多笔试AK有哪些值得计算机专业加入的国企?美团产品运营三面面经#运筹优化(3789)#牛客网上是真的很难找到运筹优化的相关攻略。我这边分析一下22届秋招运筹优傻B美团秋招面试技巧之可问不可问得物golang一面字节跳动FPGA实习面试及基础问题解答地平线一面面经快手的面试为什

- Maven

Array_06

eclipsejdkmaven

Maven

Maven是基于项目对象模型(POM), 信息来管理项目的构建,报告和文档的软件项目管理工具。

Maven 除了以程序构建能力为特色之外,还提供高级项目管理工具。由于 Maven 的缺省构建规则有较高的可重用性,所以常常用两三行 Maven 构建脚本就可以构建简单的项目。由于 Maven 的面向项目的方法,许多 Apache Jakarta 项目发文时使用 Maven,而且公司

- ibatis的queyrForList和queryForMap区别

bijian1013

javaibatis

一.说明

iBatis的返回值参数类型也有种:resultMap与resultClass,这两种类型的选择可以用两句话说明之:

1.当结果集列名和类的属性名完全相对应的时候,则可直接用resultClass直接指定查询结果类

- LeetCode[位运算] - #191 计算汉明权重

Cwind

java位运算LeetCodeAlgorithm题解

原题链接:#191 Number of 1 Bits

要求:

写一个函数,以一个无符号整数为参数,返回其汉明权重。例如,‘11’的二进制表示为'00000000000000000000000000001011', 故函数应当返回3。

汉明权重:指一个字符串中非零字符的个数;对于二进制串,即其中‘1’的个数。

难度:简单

分析:

将十进制参数转换为二进制,然后计算其中1的个数即可。

“

- 浅谈java类与对象

15700786134

java

java是一门面向对象的编程语言,类与对象是其最基本的概念。所谓对象,就是一个个具体的物体,一个人,一台电脑,都是对象。而类,就是对象的一种抽象,是多个对象具有的共性的一种集合,其中包含了属性与方法,就是属于该类的对象所具有的共性。当一个类创建了对象,这个对象就拥有了该类全部的属性,方法。相比于结构化的编程思路,面向对象更适用于人的思维

- linux下双网卡同一个IP

被触发

linux

转自:

http://q2482696735.blog.163.com/blog/static/250606077201569029441/

由于需要一台机器有两个网卡,开始时设置在同一个网段的IP,发现数据总是从一个网卡发出,而另一个网卡上没有数据流动。网上找了下,发现相同的问题不少:

一、

关于双网卡设置同一网段IP然后连接交换机的时候出现的奇怪现象。当时没有怎么思考、以为是生成树

- 安卓按主页键隐藏程序之后无法再次打开

肆无忌惮_

安卓

遇到一个奇怪的问题,当SplashActivity跳转到MainActivity之后,按主页键,再去打开程序,程序没法再打开(闪一下),结束任务再开也是这样,只能卸载了再重装。而且每次在Log里都打印了这句话"进入主程序"。后来发现是必须跳转之后再finish掉SplashActivity

本来代码:

// 销毁这个Activity

fin

- 通过cookie保存并读取用户登录信息实例

知了ing

JavaScripthtml

通过cookie的getCookies()方法可获取所有cookie对象的集合;通过getName()方法可以获取指定的名称的cookie;通过getValue()方法获取到cookie对象的值。另外,将一个cookie对象发送到客户端,使用response对象的addCookie()方法。

下面通过cookie保存并读取用户登录信息的例子加深一下理解。

(1)创建index.jsp文件。在改

- JAVA 对象池

矮蛋蛋

javaObjectPool

原文地址:

http://www.blogjava.net/baoyaer/articles/218460.html

Jakarta对象池

☆为什么使用对象池

恰当地使用对象池化技术,可以有效地减少对象生成和初始化时的消耗,提高系统的运行效率。Jakarta Commons Pool组件提供了一整套用于实现对象池化

- ArrayList根据条件+for循环批量删除的方法

alleni123

java

场景如下:

ArrayList<Obj> list

Obj-> createTime, sid.

现在要根据obj的createTime来进行定期清理。(释放内存)

-------------------------

首先想到的方法就是

for(Obj o:list){

if(o.createTime-currentT>xxx){

- 阿里巴巴“耕地宝”大战各种宝

百合不是茶

平台战略

“耕地保”平台是阿里巴巴和安徽农民共同推出的一个 “首个互联网定制私人农场”,“耕地宝”由阿里巴巴投入一亿 ,主要是用来进行农业方面,将农民手中的散地集中起来 不仅加大农民集体在土地上面的话语权,还增加了土地的流通与 利用率,提高了土地的产量,有利于大规模的产业化的高科技农业的 发展,阿里在农业上的探索将会引起新一轮的产业调整,但是集体化之后农民的个体的话语权 将更少,国家应出台相应的法律法规保护

- Spring注入有继承关系的类(1)

bijian1013

javaspring

一个类一个类的注入

1.AClass类

package com.bijian.spring.test2;

public class AClass {

String a;

String b;

public String getA() {

return a;

}

public void setA(Strin

- 30岁转型期你能否成为成功人士

bijian1013

成功

很多人由于年轻时走了弯路,到了30岁一事无成,这样的例子大有人在。但同样也有一些人,整个职业生涯都发展得很优秀,到了30岁已经成为职场的精英阶层。由于做猎头的原因,我们接触很多30岁左右的经理人,发现他们在职业发展道路上往往有很多致命的问题。在30岁之前,他们的职业生涯表现很优秀,但从30岁到40岁这一段,很多人

- [Velocity三]基于Servlet+Velocity的web应用

bit1129

velocity

什么是VelocityViewServlet

使用org.apache.velocity.tools.view.VelocityViewServlet可以将Velocity集成到基于Servlet的web应用中,以Servlet+Velocity的方式实现web应用

Servlet + Velocity的一般步骤

1.自定义Servlet,实现VelocityViewServl

- 【Kafka十二】关于Kafka是一个Commit Log Service

bit1129

service

Kafka is a distributed, partitioned, replicated commit log service.这里的commit log如何理解?

A message is considered "committed" when all in sync replicas for that partition have applied i

- NGINX + LUA实现复杂的控制

ronin47

lua nginx 控制

安装lua_nginx_module 模块

lua_nginx_module 可以一步步的安装,也可以直接用淘宝的OpenResty

Centos和debian的安装就简单了。。

这里说下freebsd的安装:

fetch http://www.lua.org/ftp/lua-5.1.4.tar.gz

tar zxvf lua-5.1.4.tar.gz

cd lua-5.1.4

ma

- java-14.输入一个已经按升序排序过的数组和一个数字, 在数组中查找两个数,使得它们的和正好是输入的那个数字

bylijinnan

java

public class TwoElementEqualSum {

/**

* 第 14 题:

题目:输入一个已经按升序排序过的数组和一个数字,

在数组中查找两个数,使得它们的和正好是输入的那个数字。

要求时间复杂度是 O(n) 。如果有多对数字的和等于输入的数字,输出任意一对即可。

例如输入数组 1 、 2 、 4 、 7 、 11 、 15 和数字 15 。由于

- Netty源码学习-HttpChunkAggregator-HttpRequestEncoder-HttpResponseDecoder

bylijinnan

javanetty

今天看Netty如何实现一个Http Server

org.jboss.netty.example.http.file.HttpStaticFileServerPipelineFactory:

pipeline.addLast("decoder", new HttpRequestDecoder());

pipeline.addLast(&quo

- java敏感词过虑-基于多叉树原理

cngolon

违禁词过虑替换违禁词敏感词过虑多叉树

基于多叉树的敏感词、关键词过滤的工具包,用于java中的敏感词过滤

1、工具包自带敏感词词库,第一次调用时读入词库,故第一次调用时间可能较长,在类加载后普通pc机上html过滤5000字在80毫秒左右,纯文本35毫秒左右。

2、如需自定义词库,将jar包考入WEB-INF工程的lib目录,在WEB-INF/classes目录下建一个

utf-8的words.dict文本文件,

- 多线程知识

cuishikuan

多线程

T1,T2,T3三个线程工作顺序,按照T1,T2,T3依次进行

public class T1 implements Runnable{

@Override

- spring整合activemq

dalan_123

java spring jms

整合spring和activemq需要搞清楚如下的东东1、ConnectionFactory分: a、spring管理连接到activemq服务器的管理ConnectionFactory也即是所谓产生到jms服务器的链接 b、真正产生到JMS服务器链接的ConnectionFactory还得

- MySQL时间字段究竟使用INT还是DateTime?

dcj3sjt126com

mysql

环境:Windows XPPHP Version 5.2.9MySQL Server 5.1

第一步、创建一个表date_test(非定长、int时间)

CREATE TABLE `test`.`date_test` (`id` INT NOT NULL AUTO_INCREMENT ,`start_time` INT NOT NULL ,`some_content`

- Parcel: unable to marshal value

dcj3sjt126com

marshal

在两个activity直接传递List<xxInfo>时,出现Parcel: unable to marshal value异常。 在MainActivity页面(MainActivity页面向NextActivity页面传递一个List<xxInfo>): Intent intent = new Intent(this, Next

- linux进程的查看上(ps)

eksliang

linux pslinux ps -llinux ps aux

ps:将某个时间点的进程运行情况选取下来

转载请出自出处:http://eksliang.iteye.com/admin/blogs/2119469

http://eksliang.iteye.com

ps 这个命令的man page 不是很好查阅,因为很多不同的Unix都使用这儿ps来查阅进程的状态,为了要符合不同版本的需求,所以这个

- 为什么第三方应用能早于System的app启动

gqdy365

System

Android应用的启动顺序网上有一大堆资料可以查阅了,这里就不细述了,这里不阐述ROM启动还有bootloader,软件启动的大致流程应该是启动kernel -> 运行servicemanager 把一些native的服务用命令启动起来(包括wifi, power, rild, surfaceflinger, mediaserver等等)-> 启动Dalivk中的第一个进程Zygot

- App Framework发送JSONP请求(3)

hw1287789687

jsonp跨域请求发送jsonpajax请求越狱请求

App Framework 中如何发送JSONP请求呢?

使用jsonp,详情请参考:http://json-p.org/

如何发送Ajax请求呢?

(1)登录

/***

* 会员登录

* @param username

* @param password

*/

var user_login=function(username,password){

// aler

- 发福利,整理了一份关于“资源汇总”的汇总

justjavac

资源

觉得有用的话,可以去github关注:https://github.com/justjavac/awesome-awesomeness-zh_CN 通用

free-programming-books-zh_CN 免费的计算机编程类中文书籍

精彩博客集合 hacke2/hacke2.github.io#2

ResumeSample 程序员简历

- 用 Java 技术创建 RESTful Web 服务

macroli

java编程WebREST

转载:http://www.ibm.com/developerworks/cn/web/wa-jaxrs/

JAX-RS (JSR-311) 【 Java API for RESTful Web Services 】是一种 Java™ API,可使 Java Restful 服务的开发变得迅速而轻松。这个 API 提供了一种基于注释的模型来描述分布式资源。注释被用来提供资源的位

- CentOS6.5-x86_64位下oracle11g的安装详细步骤及注意事项

超声波

oraclelinux

前言:

这两天项目要上线了,由我负责往服务器部署整个项目,因此首先要往服务器安装oracle,服务器本身是CentOS6.5的64位系统,安装的数据库版本是11g,在整个的安装过程中碰到很多的坑,不过最后还是通过各种途径解决并成功装上了。转别写篇博客来记录完整的安装过程以及在整个过程中的注意事项。希望对以后那些刚刚接触的菜鸟们能起到一定的帮助作用。

安装过程中可能遇到的问题(注

- HttpClient 4.3 设置keeplive 和 timeout 的方法

supben

httpclient

ConnectionKeepAliveStrategy kaStrategy = new DefaultConnectionKeepAliveStrategy() {

@Override

public long getKeepAliveDuration(HttpResponse response, HttpContext context) {

long keepAlive

- Spring 4.2新特性-@Import注解的升级

wiselyman

spring 4

3.1 @Import

@Import注解在4.2之前只支持导入配置类

在4.2,@Import注解支持导入普通的java类,并将其声明成一个bean

3.2 示例

演示java类

package com.wisely.spring4_2.imp;

public class DemoService {

public void doSomethin

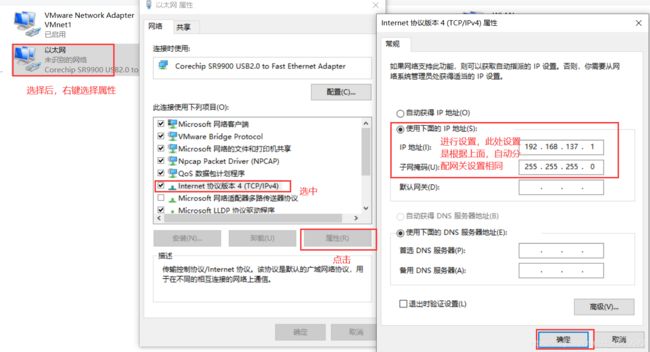

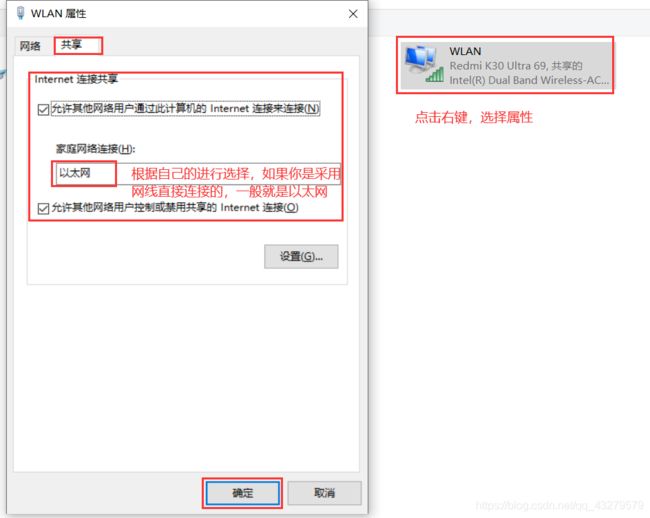

设置完成后,应该会有一个提示信息,信息内容大概是电脑自动分配网关

设置完成后,应该会有一个提示信息,信息内容大概是电脑自动分配网关