《自然语言处理--基于预训练模型的方法》第一章读书笔记

按研究对象:

形式

语义

推理

语用分析

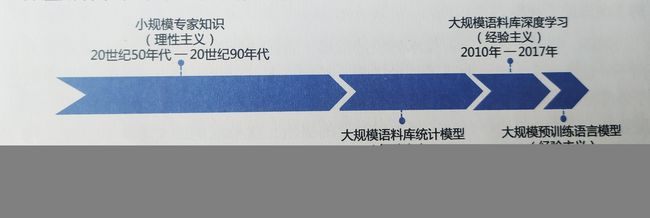

理性主义/经验主义

经验主义:基于统计模型/深度学习模型/最新的预训练模型的三个阶段

“新范式”:预训练+精调

1.1 自然语言处理的概念

自然语言通常指的是人类语言(本文特指文本符号,而非语音信号),是人类思维的载体和交流的基本工具,也是人类区别于动物的根本标志,更是人类智能发展的外在体现形式之一。

NLP:理解,生成

计算语言学,Computational Linguistics,CL

人工智能:

运算智能--机器的基础运算,存储能力

感知智能--机器的模式识别能力,如语音的识别以及图像的识别

认知智能

1.2 自然语言处理的难点

1.抽象性

语言是由抽象符号构成的。

2.组合性

有限的符号组合成无限的语义

无法使用穷举法实现对自然语言的理解。

3.歧义性

一词多义

4.进化性

新词汇,旧词汇新含义

5.非规范性

为森么,肿么了,pls,cooooool

6.主观性

标注数据难,难以评价

如何自动评价人机对话系统仍然是一个开放的问题。

7.知识性

理解语言通常需要背景知识以及基于这些知识的推理能力

8.难移植性

不同领域的用词以及表达方式不尽相同,因此在一个领域上学习的模型也很难应用于其他领域。

自然语言处理任务不同,很难使用统一的技术或模型加以解决。

1.3 自然语言处理任务体系

按任务层级:

1.资源建设:语言学知识库建设,语料库资源建设

2.基础任务:分词,词性标注,句法分析,句义分析等

3.应用任务:信息抽取/情感分析/问答系统/机器翻译/对话系统等

4.应用系统:教育/医疗/司法/金融/机器人等。

按任务类别:

回归问题:将输入文本映射为一个连续的数值,如对作文的打分,对案件刑期或罚款金额的预测等。

分类问题:文本分类,即判断一个输入的文本所属的类别。

匹配问题:判断两个输入文本之间的关系。如:它们之间是复述或非复述的两类关系。或蕴含/矛盾/无关三类关系。

解析问题:对文本中的词语进行标注或识别词语之间的关系,典型的解析问题包括词性标注/句法分析等。另外还有很多问题,如分词/命名实体识别。

生成问题:根据输入(可以是文本,也可以是图片/表格等其他类型数据)生成一段自然语言,如机器翻译/文本摘要/图像描述生成等都是典型的文本生成类任务。

研究对象与层次

自然语言处理的研究层次:

形式:语言符号层面的处理,研究的是“名”与“名”之间的关系,如通过编辑距离等计算文本之间的相似度。

语义:主要研究语言符号和其背后所要表达的含义之间的关系,即“名”和“实”之间的关系。(NLP主要关注的问题)

推理:在语义研究的基础上,进一步引入知识的运用,因此涉及“名”,“实”和“知”之间的关系。这一点正体现了自然语言的知识性。

语用: “言外之意”“弦外之音”,“名”,“实”,“知”和“境”。

1.4 自然语言处理技术的发展历史

基于统计学习的自然语言处理取得了一定程度的成功,但它也有明显的局限性,也就是需要事先利用经验性规则将原始的自然语言输入转化为机器能够处理的向量形式。这一转化过程(也称为特征提取)需要细致的人工操作和一定的专业知识,因此也被称为特征工程。

2010年以后,深度学习,表示学习,指机器能根据输入自动地发现可以用于识别或分类等任务等表示。

多层的处理层,抽象处理,更深层次的抽象,输入的一个表示。

反向传播算法

可以有效地避免统计学习方法中的人工特征提取操作,自动地发现对于目标任务有效的表示。

表示学习,打通了不同任务之间的壁垒,跨任务迁移。

表示学习能够将不同任务在相同的向量空间内进行表示。

跨模态迁移,综合利用多项任务/多种语言/多个模态的数据,使得人工智能向更通用的方向迈进了一步。

自然语言生成:深度学习,序列到序列生成框架,逐词的文本生成方法:机器翻译/文本摘要/人机对话

深度学习算法致命缺点:过度依赖大规模有标注数据

早期的静态词向量预训练模型,动态词向量预训练模型,2018,BERT/GPT为代表的超大规模预训练语言模型恰好弥补了自然语言处理标注数据不足的缺点,帮助自然语言处理取得了一系列的突破。

模型预训练(Pre-train),即首先在一个愿任务上预先训练一个初始模型,然后在下游模型(也称为目标任务)上继续对该模型进行精调(Fine-tune),从而达到提高下游任务准确率的目的。

在本质上,这也是迁移学习(Transfer Learning)思想的一种应用。

文本自身的顺序就是一种天然的标注数据,通过若干连续出现的词语预测下一个词语(又称语言模型)就可以构成一项原任务。由于图书/网页等文本数据规模近乎无限,所以,可以非常容易地获得超大规模的预训练数据。---自监督学习。

基于自注意力的Transformer模型显著地提升了对于自然语言的建模能力,是近年来具有里程碑意义的进展之一。