姓名:范凌峰 学号:16020188020

转载自:https://zhuanlan.zhihu.com/p/53341166

【嵌牛导读】:「可信赖 AI」才是 AI 的指路明灯

【嵌牛鼻子】:人工智能 道德准则 AI

【嵌牛提问】:如何看待欧盟发布《人工智能道德准则》?

【嵌牛正文】:

近日,欧盟委员会发布了由人工智能高级专家组(AI HLEG)编制的《人工智能道德准则》(AI Ethics Guidelines)草案,指出 AI 的发展方向应该是「可信赖 AI」,即确保这一技术的目的合乎道德,技术足够稳健可靠,从而发挥其最大的优势并将风险降到最低。该准则旨在为 AI 系统的具体实施和操作提供指导。《准则》最终版将于 2019 年 3 月发布。

执行摘要

人工智能是这个时代最具变革性的力量之一,它可以为个人和社会带来巨大利益,但同时也会带来某些风险。而这些风险应该得到妥善管理。总的来说,AI 带来的收益大于风险。我们必须遵循「最大化 AI 的收益并将其带来的风险降到最低」的原则。为了确保不偏离这一方向,我们需要制定一个以人为中心的 AI 发展方向,时刻铭记 AI 的发展并不是为了发展其本身,最终目标应该是为人类谋福祉。因此,「可信赖 AI」(Trustworthy AI)将成为我们的指路明灯。只有信赖这项技术,人类才能够安心地从 AI 中全面获益。

「可信赖 AI」由两部分组成:1)它应该尊重基本权利、相关法规、核心原则及价值观,确保其目的合乎伦理道德;2)它使用的技术应该非常稳健、可靠,因为即使是出于好意,如果没有成熟技术的加持,技术也会带来意想不到的伤害。这些指导原则构成了「可信赖 AI」的基本框架:

「可信赖 AI」框架

Chapter I :确保人工智能的目的合乎道德,规定了人工智能发展应该遵守的基本权利、原则和价值观。

Chapter II:关于实现「可信赖 AI」的指导原则,同时强调 AI 发展目的的道德性和技术稳健性。这部分列出了「可信赖 AI」的要求,以及实现这些要求所需的技术和非技术方法。(详细内容见下文)

Chapter III:提供「可信赖 AI」的具体但非详尽的评估列表实施要求。该列表将根据具体的用例进行调整。

与其他有关 AI 伦理道德的文件相比,这份准则的目的不是为 AI 增加一份核心价值观和原则清单,而是为 AI 系统的具体实施和操作提供指导。

该准则面向开发、部署或使用 AI 的所有利益攸关方,包括公司、组织、研究人员、公共服务单位、机构、个人或其他实体。该准则的最终版将提出一种机制,是否认可这些这些准则将由利益攸关方自行决定。

需要指出的是,制定这些准则并不是为了替代任何形式的决策或监管,也不是为了阻止其出台。这份准则应该不断更新,以适应技术和知识发展的要求。

「可信赖 AI」的实现

这一部分为「可信赖 AI」的实施和实现提供了指导,指出实现「可信赖 AI」有哪些要求,在发展、部署、使用 AI 的过程中有哪些方法可以满足这些要求,从而充分利用由 AI 创造的机遇。

1.「可信赖 AI」的要求

实现「可信赖 AI」意味着需要在 AI 系统和应用的具体要求中加入一般、抽象的原则。以下是从 Chapter I 的权利、原则和价值观中衍生出的十条要求。这十条要求同样重要,但实施过程中需要考虑不同应用领域和行业的具体背景。

问责机制

数据治理

为所有人设计

人工智能自治的治理(人的监督)

非歧视

尊重(增强)人类自主性

尊重隐私

稳健性

安全

透明

《准则》还对每一项要求进行了进一步解释。例如,在「问责机制」这项要求中,《准则》指出,问责机制的选择可能非常多样,从金钱补偿到过失调查,再到没有金钱补偿的和解。如一个系统误读了药品报销申请,错误地决定不予报销,系统所有者可能会被要求做出金钱补偿。其他要求的详细内容请参考原文。

这一清单按字母顺序对要求进行排序,以表明所有要求同等重要。Chapter III 还提供了一份评估清单,以支持这些要求的实施。

2. 实现「可信赖 AI」的技术和非技术方法

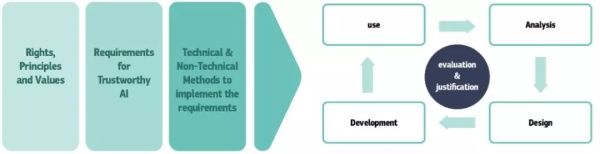

为了满足上一节中提到的要求,开发过程的所有层面(包括分析、设计、开发和使用)都可以采用技术和非技术方法(参见图 3)。对实施这些要求和方法的评估,以及对流程变化的报告和论证应该持续进行。事实上,考虑到 AI 系统不断发展,以及在动态环境中运行,实现「可信赖 AI」可以看作一个持续的过程。

虽然这份准则中的方法列表并不详尽,但它旨在列出实施「可信赖 AI」的主要方法。为了提高 AI 系统的可信度,这些方法应该基于第一章中定义的权利和原则。

图 3 显示了权利、原则和价值观对系统开发过程的影响。这些抽象的原则和权利被具体化为对 AI 系统的要求,该系统的实施和实现要由不同的技术和非技术方法支持。此外,考虑到 AI 技术的适应性和动态性,继续坚持原则和价值观要求将评估(evaluation)和论证(justification)流程作为开发流程的核心。

图 3:通过系统的整个生命周期实现「可信赖 AI」