【EMNLP2021&&含源码】「自然语言处理(NLP)」跨度提取QA形式算法改进

来源: AINLPer 微信公众号(每日论文干货分享!!)

编辑: ShuYini

校稿: ShuYini

时间: 2021-11-22

那么今天继续给大家分享一篇EMNLP顶会上的文章:Enhanced Language Representation with Label Knowledge for Span Extraction。

【论文及代码链接在后面】

引言

在自然语言信息抽取中,有这么一种描述叫:Span Extraction,翻译过来叫做跨度提取。这里的跨度提取指的就是在纯文本中提取文本中的命名实体、短语、事件等。这个词相当于把之前我们听到的命名实体抽取、短语抽取、事件抽取都涵盖到了一块儿。

该篇文章认为:最近的工作通过将 跨度提取任务形式化为问答问题(QA 形式化) 来引入标签知识以增强文本表示,从而实现了最先进的性能,但是QA Formalization 并没有充分利用标签知识,并且在训练/推理方面效率低下。为了解决这些问题,文章引入了一种新的范式来整合标签知识,并进一步提出了一种新的模型来明确有效地将标签知识整合到文本表示中。具体来说,它独立编码文本和标签注释,然后通过精心设计的语义融合模块将标签知识集成到文本表示中。

文章背景

信息提取 (IE) 是自然语言处理中的一项基本任务,旨在从非结构化文本中提取结构化知识。 它通常包含从纯文本中提取文本跨度(例如单词或短语)的过程,例如 NER。 跨度提取通常被表述为序列标记问题,该问题为文本中的每个标记分配一个分类标签。

许多努力致力于跨度提取。早期的方法主要基于手工制作的特征,例如领域词典和词汇特征。由于神经网络显示了自动学习文本特征的有效性,因此提出了许多基于神经的方法。最近,基于自我注意的预训练语言模型,如 BERT被广泛用于提升跨度提取任务。然而,大多数现有方法将标签视为独立且无意义的 one-hot 向量,忽略了先验标签信息(简称标签知识)。

为了缓解这种限制,一些研究开始将标签知识整合到跨度提取中。其中,QA 形式化因其有效性而特别有吸引力。简单地说,QA Formalization 将跨度提取视为问答问题。以NER为例,提取“PERSON”实体,形式化为根据给定的文本回答“文本中提到了哪个人,其中一个人代表人还是个体?”的问题。受益于标签 有了类别相关问题的知识,即使在资源匮乏的情况下,QA 形式化通常也会在跨度提取方面产生最先进的性能。

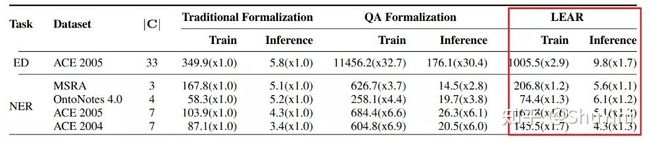

然而,QA 形式化表现出两个主要缺点:1) 效率低下:将跨度提取形式化,因为 QA 会导致训练/推理效率的急剧下降。2)未充分利用:标签知识基于自注意力机制隐式集成到文本表示中。self-attention 机制的“注意力”会被文本分散注意力,而不是完全集中在问题部分。因此,标签知识没有被充分利用来增强文本表示。

模型介绍

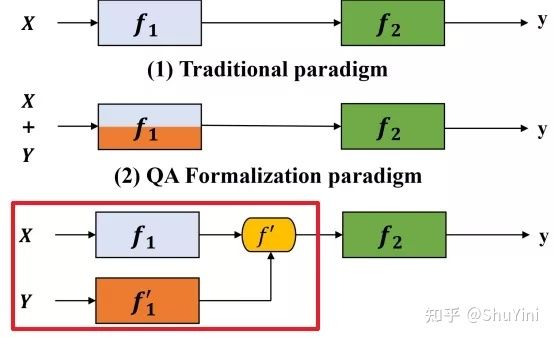

为了解决上述两个问题,我们提出了一种新的范式(见下)来整合标签知识。首先,由于联合编码效率低,我们将问题文本编码过程分解为两个独立的编码模块:文本编码模块 f1 和问题编码模块 f0. 这样,样本集的大小不再扩大|C| 次。其次,为了充分利用标签知识,设计了一个融合模块 f0 来显式地整合标签和文本表示。

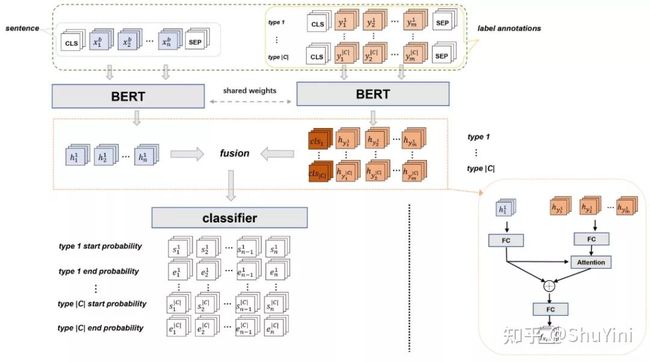

为了实例化上述范式,文章进一步提出了一个称为 LEAR 的模型来学习 Labelknowledge 增强表示。强大的编码器 f1 对于理解标签注释至关重要。然而,从头开始训练编码器 f1 具有挑战性,因为标签注释的数量太少。因此我们共享了 f1 和 f0 的权重(称为共享编码器),可以通过大型预训练模型学习标签知识,并且不会引入额外的参数。接下来,通过语义引导注意模块将学习到的标签知识集成到文本表示中。模型如下图所示:

实验结果

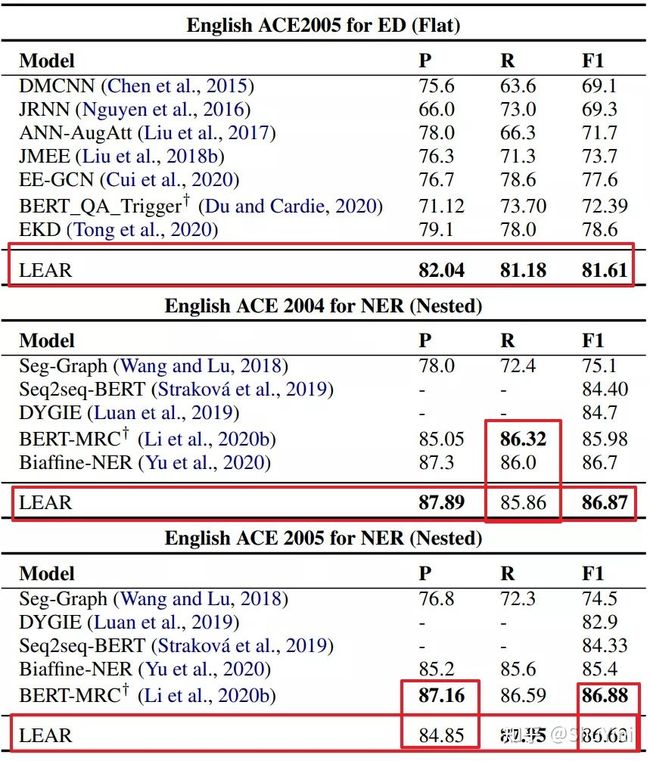

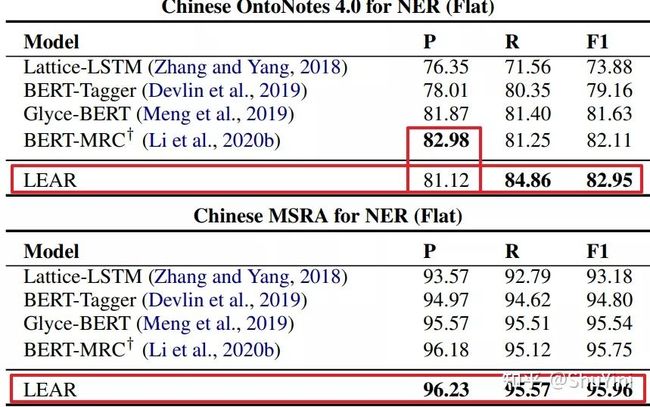

在实验方面,文章中对三个典型的跨度提取任务进行了广泛的实验:平面 NER、嵌套 NER 和事件检测。实证结果表明:

1)该方法在四个基准测试中达到了最先进的性能。

2)与 QA Formalization 范式相比,训练时间和推理时间分别平均减少了 76% 和 77%。

Paper&&Code

论文题目:Enhanced Language Representation with Label Knowledge for Span Extraction

论文链接:https://aclanthology.org/2021.emnlp-main.379.pdf

代码链接:https://github.com/akeepers/lear

如果您不便下载:回复: LEAR 获取原文。

推荐阅读

1、【南洋理工&&含源码】鲁棒问答的内省蒸馏(IntroD)

2、【NLP论文速递】邮件主题生成 && 舆论检测及立场分类

3、【英国谢菲尔德大学&&含源码】社交媒体舆论控制(RP-DNN)

4、【硬核干货,请拿走!!】历年IJCAI顶会论文整理(2016-2021)

5、论文下载收费?有它不用怕!!

6、必看!!【AINLPer】自然语言处理(NLP)领域知识&&资料大分享

7、收藏!「自然语言处理(NLP)」你可能用到的数据集(一)

8、收藏!「自然语言处理(NLP)」你可能用到的数据集(二)

9、重磅!「自然语言处理(NLP)」一千多万公司企业注册数据集

10、收藏!!「自然语言处理(NLP)」学术界全球知名学者教授信息大盘点(全)!

11、「自然语言处理(NLP)论文推送」清华大学XQA数据集(含源码)!

最后不是最后

关注 AINLPer 微信公众号(每日都有最新的论文推荐给你!!)