三, Spark 四种运行环境配置总结

三, Spark 运行环境

- Spark 的运行模式有 Local(也称单节点模式),Standalone(集群模式),Spark on Yarn(运行在Yarn上),Mesos以及K8s, Windows模式等常用模式

3.1 Local模式

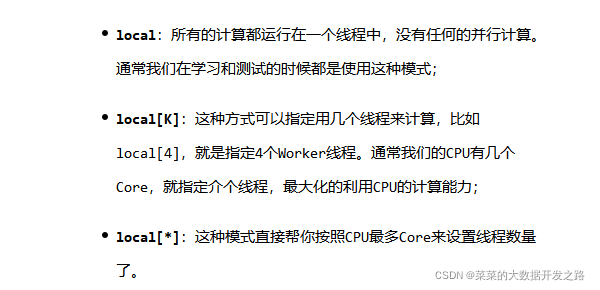

- Local模式被定义为

不需要其他任何节点资源, 在本地执行Spark代码的环境,也叫单机模式, 一般用于教学,调试, 演示等等, - 配置文件设置方法:

conf.setMaster[local[K]]

1. 解压相关的依赖文件

- 将

spark-3.0.0-bin-hadoop3.2.tgz文件上传到 Linux 并解压缩,放置在指定位置,路径中不要包含中文或空格- 下载地址: 点我

tar -zxvf spark-3.0.0-bin-hadoop3.2.tgz -C ../module

cd opt/module

mv spark-3.0.0-bin-hadoop3.2.tgz spark-3.0.0

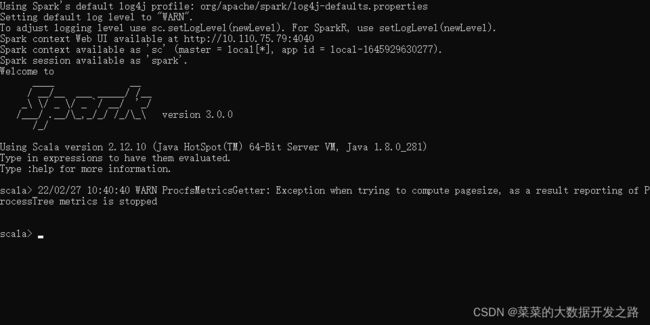

2. 启动local环境

- cd到安装目录

./bin/spark-shell

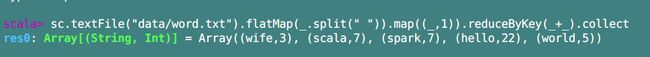

3. 测试运行情况

- 把测试文件 word.txt放入到上面提到的spark-3.0.0安装目录中,并输入之前的wordcount栗子的核心代码到

Spark-shell- 注意word.txt的文件路径是以Spark-shell为基准的!

sc.textFile("data/word.txt").flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_).collect

如何退出Shell? :quit

- 提交应用(使用spark-submit)

3.2 Standalone 模式

local 本地模式毕竟只是用来进行练习演示的,真实工作中还是要将应用提交到对应的集群中去执行,这里我们来看看只使用 Spark 自身节点运行的集群模式,也就是我们所谓的独立部署(Standalone)模式。Spark 的 Standalone 模式体现了经典的 master-slave 模式。

- 把上一节提到的

Spark-3.0.0改为spark-3.0.0-standalone

mv opt/module/spark-3.0.0 opt/module/spark-3.0.0-standalone

- 进入spark-alone/conf 目录, 修改slaves.temlates 文件名为slaves

mv slaves.template slaves

- 修改slaves文件, 添加work节点

bigdata01

bigdata02

bigdata03

- 修改spark-env.sh.template 文件名为 spark-env.sh

mv spark-env.sh.template spark-env.sh

- 修改spark-env.sh, 添加JAVA_HOME环境变量和集群对应的master节点

export JAVA_HOME=/opt/module/jdk-1.8

SPARK_MASTER_HOST=bigdata01

SPARK_MASTER_PORT=7077

注意:7077 端口,相当于 hadoop3 内部通信的 8020 端口,此处的端口需要确认自己的 Hadoop配置

- 分发 spark-standalone 目录

xsync spark-standalone

- 启动集群

./sbin/start-all.sh

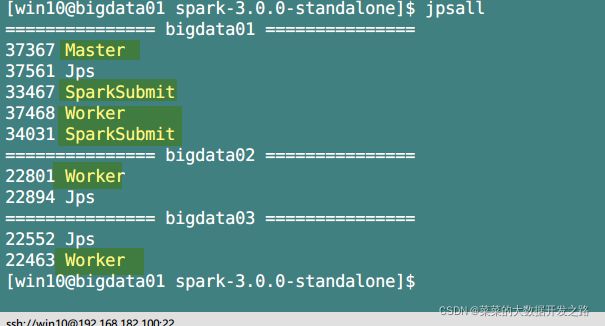

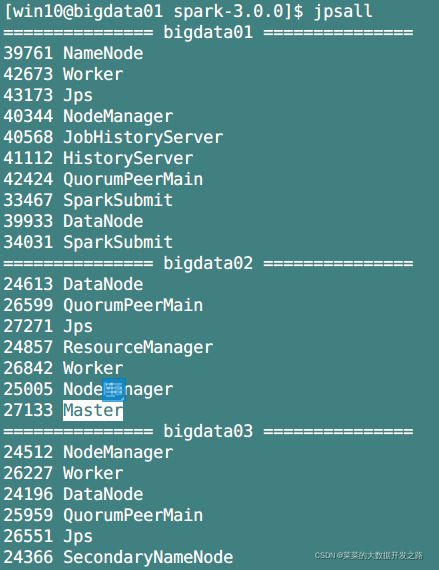

- 查看三台服务器的运行进程

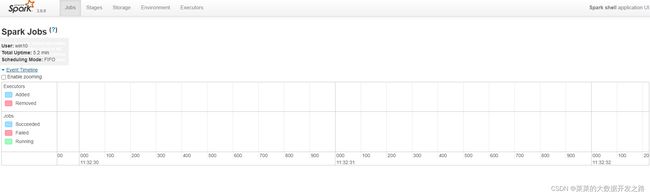

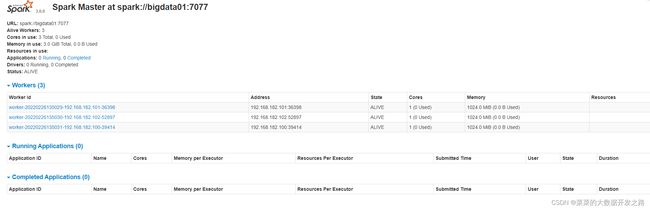

- 查看Master资源监控 Web UI界面:

- http://bigdata01:8080/

- 提交应用测试

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://bigdata01:7077 \

./examples/jars/spark-examples_2.12-3.0.0.jar \

10

- 结果同上一节

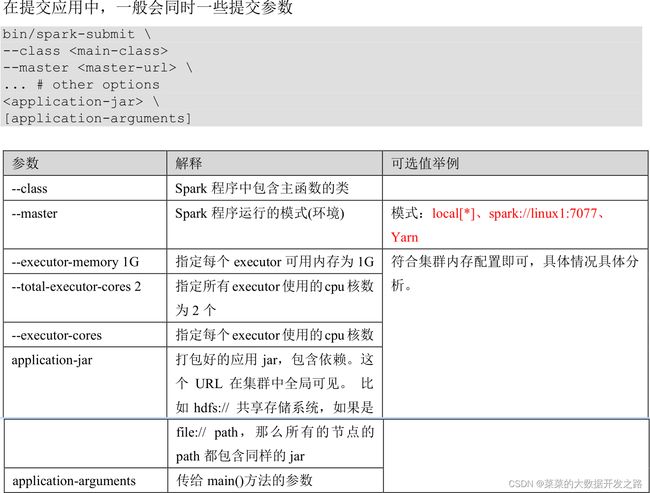

3.2.1 提交参数说明

3.2.3 配置历史服务

- 由于 spark-shell 停止掉后,集群监控 linux1:4040 页面就看不到历史任务的运行情况,所以开发时都配置历史服务器记录任务运行情况。

- 修改

spark-defaults.conf.template文件名为spark-defaults.conf

mv spark-defaults.conf.template spark-defaults.conf

- 修改

spark-default.conf文件,配置日志存储路径

spark.eventLog.enabled true

spark.eventLog.dir hdfs://bigdata01:8020/directory

注意:需要启动 hadoop 集群,HDFS 上的 directory 目录需要提前存在。

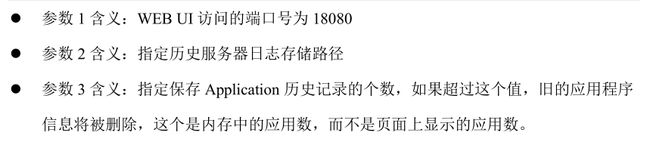

- 修改 spark-env.sh 文件, 添加日志配置

export SPARK_HISTORY_OPTS="

-Dspark.history.ui.port=18080

-Dspark.history.fs.logDirectory=hdfs://bigdata01:8020/directory

-Dspark.history.retainedApplications=30"

- 分发配置文件

xsync conf

- 重新启动集群和历史服务

sbin/start-all.sh

sbin/start-history-server.sh

- 重新执行任务

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://bigdata01:7077 \

./examples/jars/spark-examples_2.12-3.0.0.jar \

10

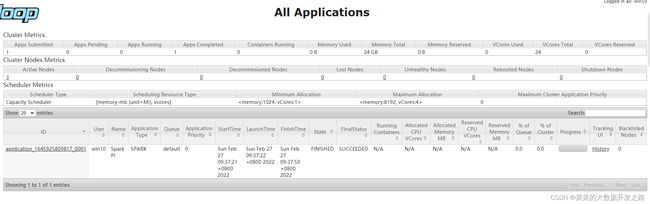

- 查看历史服务

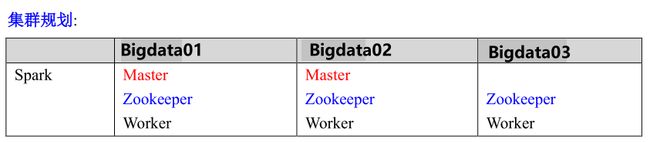

3.2.4 配置高可用(HA)

- 所谓的高可用是因为当前集群中的 Master 节点只有一个,所以会存在单点故障问题。

- 所以为了解决单点故障问题,需要在集群中配置多个 Master 节点,

- 一旦处于活动状态的 Master发生故障时,由备用 Master 提供服务,保证作业可以继续执行。这里的高可用一般采用Zookeeper 设置

-

停止集群,

sbin/stop-all.sh -

启动Zookeeper,

zk stop -

修改

spark-env.sh文件, 添加如下配置

注释如下内容:

#SPARK_MASTER_HOST=bigdata01

#SPARK_MASTER_PORT=7077

添加如下内容:

#Master 监控页面默认访问端口为 8080,但是可能会和 Zookeeper 冲突,所以改成 8989,也可以自定义,访问 UI 监控页面时请注意

SPARK_MASTER_WEBUI_PORT=8989

export SPARK_DAEMON_JAVA_OPTS="

-Dspark.deploy.recoveryMode=ZOOKEEPER

-Dspark.deploy.zookeeper.url=bigdata01,bigdata02,bigdata03

-Dspark.deploy.zookeeper.dir=/spark"

-

分发配置文件,

xsync conf -

启动集群,

sbin/start-all.sh -

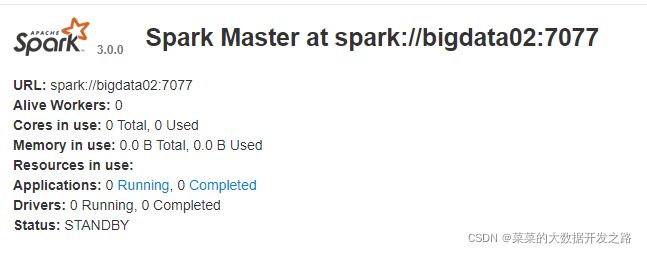

启动bigdata02的单独Master节点, 可以在bigdata02的Spark web监控网页看到: 此时bigdata02节点Master状态处于备用状态(StandBy)

[win10@bigdata02 sbin]$ start-master.sh

- 下面我们来测试下高可用

- 提交应用到高可用集群

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://bigdata01:7077 \

./examples/jars/spark-examples_2.12-3.0.0.jar \

10

-

停止bigdata01的资源监控进程Master,

sbin/stop-master.sh -

再来查看bigdata02的监控网页, 可以看到Master状态转为了活动(ALive)

3.3 Yarn 模式

- 独立部署(Standalone)模式由 Spark 自身提供计算资源,无需其他框架提供资源。这种方式降低了和其他第三方资源框架的耦合性,独立性非常强。

- 但是, Spark 主要是计算框架,而不是资源调度框架,所以本身提供的资源调度并不是它的强项,

- 所以还是和其他专业的资源调度框架集成会更靠谱一些。所以接下来我们来学习在强大的 Yarn 环境下 Spark 是如何工作的(其实是因为在国内工作中,Yarn 使用的非常多)。

3.3.1 解压

- 将

spark-3.0.0-bin-hadoop3.2.tgz文件上传到 Linux 并解压缩,放置在指定位置,路径中不要包含中文或空格- 下载地址: 点我

tar -zxvf spark-3.0.0-bin-hadoop3.2.tgz -C ../module

cd opt/module

mv spark-3.0.0-bin-hadoop3.2.tgz spark-3.0.0

3.3.2 修改配置文件

- 修改

spark-defaults.conf.template文件名为spark-defaults.conf

mv spark-defaults.conf.template spark-defaults.conf

- 修改 hadoop 配置文件

/opt/module/hadoop/etc/hadoop/yarn-site.xml, 并分发

<name>yarn.nodemanager.vmem-check-enabledname>

<value>falsevalue>

<description>Whether virtual memory limits will be enforced for containersdescription>

property>

<property>

<name>yarn.nodemanager.vmem-pmem-rationame>

<value>4value>

<description>Ratio between virtual memory to physical memory when setting memory limits for containersdescription>

property>

<property>

<property>

<name>yarn.nodemanager.pmem-check-enabledname>

<value>falsevalue>

property>

- 修改 conf/spark-env.sh,添加 JAVA_HOME 和 YARN_CONF_DIR 配置

mv spark-env.sh.template spark-env.sh

。。。

export JAVA_HOME=/opt/module/jdk1.8

YARN_CONF_DIR=/opt/module/hadoop/etc/hadoop

-

分发配置文件,

xsync conf -

启动hadoop集群

myhadoop start

启动后一定要确认Yarn已正常运行, jpsall, ResourceManager正在运行

- 提交任务

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master yarn \

--deploy-mode client \

./examples/jars/spark-examples_2.12-3.0.0.jar \

10

- 查看历史服务

3.3.5 配置历史服务器

- 由于 spark-shell 停止掉后,集群监控 linux1:4040 页面就看不到历史任务的运行情况,所以开发时都配置历史服务器记录任务运行情况。

- 修改

spark-defaults.conf.template文件名为spark-defaults.conf

mv spark-defaults.conf.template spark-defaults.conf

- 修改

spark-default.conf文件,配置日志存储路径

spark.eventLog.enabled true

spark.eventLog.dir hdfs://bigdata01:8020/directory

注意:需要启动 hadoop 集群,HDFS 上的 directory 目录需要提前存在。

- 修改 spark-env.sh 文件, 添加日志配置

export SPARK_HISTORY_OPTS="

-Dspark.history.ui.port=18080

-Dspark.history.fs.logDirectory=hdfs://bigdata01:8020/directory

-Dspark.history.retainedApplications=30"

-

分发配置文件,

xsync conf -

重新启动集群和历史服务

sbin/start-all.sh

sbin/start-history-server.sh

- 重新执行任务

bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://bigdata01:7077 \

./examples/jars/spark-examples_2.12-3.0.0.jar \

10

- 查看历史服务

3.4 K8S & Mesos 模式

- Mesos 是 Apache 下的开源分布式资源管理框架,它被称为是分布式系统的内核,在Twitter 得到广泛使用,管理着 Twitter 超过 30,0000 台服务器上的应用部署,

- 但是在国内,依然使用着传统的 Hadoop 大数据框架,所以国内使用 Mesos 框架的并不多,但是原理其实都差不多

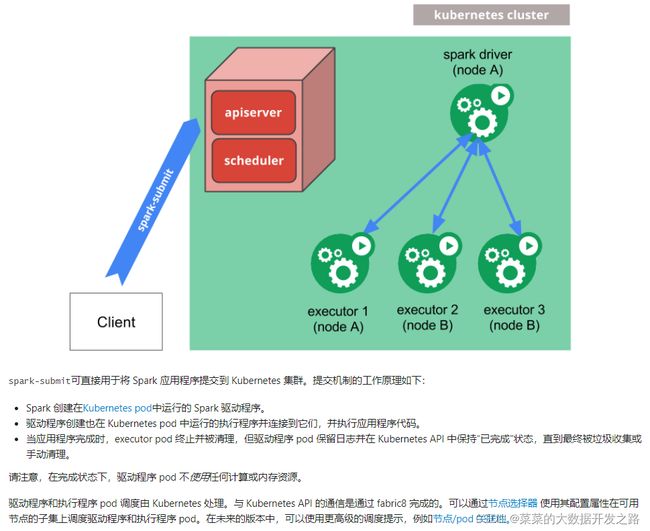

- 容器化部署是目前业界很流行的一项技术,基于 Docker 镜像运行能够让用户更加方便地对应用进行管理和运维。容器管理工具中最为流行的就是 Kubernetes(k8s),而 Spark也在最近的版本中支持了 k8s 部署模式。

3.5 Windows 模式

每次都需要启动虚拟机,启动集群,这是一个比较繁琐的过程,

并且会占大量的系统资源,导致系统执行变慢,不仅仅影响学习效果,也影响学习进度,Spark 非常暖心地提供了可以在 windows 系统下启动本地集群的方式,这样,在不使用虚拟机的情况下,也能学习 Spark 的基本使用

-

把上面 3.1小节的

spark-3.0.0-bin-hadoop3.2.tgz放到windows环境中, 解压到一个无中文五空格无下划线_的目录下, 注意一定要遵守这个原则, 否则在打开spark-shell.cmd时会闪退!!! -

测试一下:

sc.textFile("../data/word.txt").flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_).collect

- 可能出现的问题和解决办法: 点我