【论文速度】AAAI 2020 中的图像修复论文合集:(1) 区域归一化 (2) 结合结构知识

【论文速度】AAAI 2020 中的图像修复(1)区域归一化:Region Normalization for Image Inpainting

paper:https://arxiv.org/pdf/1911.10375.pdf

GitHub:https://github.com/geekyutao/RN

动机

早期,基于深度学习的方法都忽略了图像补全问题中的一个本质问题:图像补全输入图像有一些受损区域,而这些受损区域通常独立于未受损区域。将已损坏的图像作为一般的空间输入到神经网络中存在两个潜在问题:

1. 无效 (已损坏) 像素的参与卷积,其输出本身不准确;

2. 网络中总是有归一化层,而空洞区域参与归一化,会引起均值和方差偏移问题。

部分卷积 (Partial convolution, Liu et al. 2018) 解决了第一个问题,通过仅在有效像素上运行来解决无效卷积问题,实现了性能的提升。

然而,现有的方法都无法解决网络映射中归一化的均值移和方差移问题。

特别是,现有的方法大多在其网络中使用特征归一化 (FN) 来帮助训练,而现有的 FN 方法通常是跨空间维度对特征进行归一化,忽略了被破坏的区域,导致归一化的均值和方差发生位移。

策略

为了克服这一局限性,本文提出了区域归一化( Region Normalization, RN),这是一种基于空间区域的归一化方法,根据输入掩模将空间像素划分为不同的区域,并计算每个区域的均值和方差进行归一化。RN 可以有效地解决均值和方差偏移问题,改进inpaint 网络训练。

方法

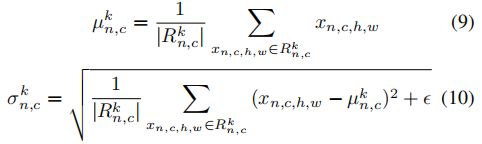

Formulation of Region Normalization

R 表示空洞,一共 K 个空洞;n 和 c 表示 batch size 和通道数。然后 RN 是按照类似 IN 的方式定义的:

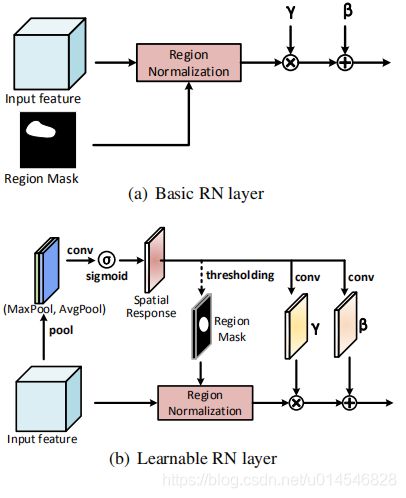

进一步设计了两种 RN:基本 RN (RN-B) 和可学习 RN (RN-L)。在网络的浅层中,输入图像有较大的损坏区域,造成严重的均值和方差偏移。因此,本文采用 RN-B 分别对已损坏区域和未损坏区域进行归一化来解决问题。RN-B 的输入掩模是由原始的空洞掩模得到的。经过几个卷积层后,损坏的区域逐渐融合,很难从原始掩码中获得区域掩码。因此,在网络的后一层中使用 RN-L,它通过利用输入特征的空间关系来学习检测潜在的损坏区域,并为 RN 生成一个区域掩码。此外,RN-L 还可以通过全局仿射变换增强腐蚀区域和未腐蚀区域的融合。RN-L 不仅解决了均值和方差漂移问题,而且推进了对损坏区域的重构。

Network Architecture

【论文速度】AAAI 2020 中的图像修复(2)结合结构知识:Learning to Incorporate Structure Knowledge for Image Inpainting

paper: https://arxiv.org/pdf/2002.04170.pdf

动机

最近,Nazeri 等人 (2019) 提出利用显式图像结构知识进行 inpainting,提出了一个由 边缘生成器 和图像生成器组成的模型。边缘产生器被训练来产生缺失区域可能的边缘草图。然后图像生成器将生成的草图作为结构的先决条件来生成最终的结果。Xiong et al.(2019) 提出了一个类似的模型,但采用了 轮廓生成器 而不是边缘生成器,更适用于受损图像中包含突出目标的情况。通过引入结构信息,这两种方法都能产生视觉上更加可信的 inpainting 结果。上述两阶段模型的成功表明,边缘和轮廓等结构知识对于生成合理、详细的图像补全内容起着重要作用。这也说明,以往基于深度学习的方法在学习过程中,如果没有结构知识的指导,可能难以理解被破坏图像的合理语义结构。

然而,采用两个阶段策略可能会有几个限制:

1) 由于使用两个生成器,需要更多的参数;

2) 由于采用串耦合体系结构,推理时,最后生成图像阶段容易受到前一阶段生成不合理的结构的影响;

3) 在学习过程中,如果没有明确的结构引导作为损失函数,例如第一阶段生成的结构信息有可能是稀疏的,再加上随着网络深度,结构信息会进一步被弱化甚至遗忘,从而导致第二阶段中不能充分融入充分的结构信息。

策略

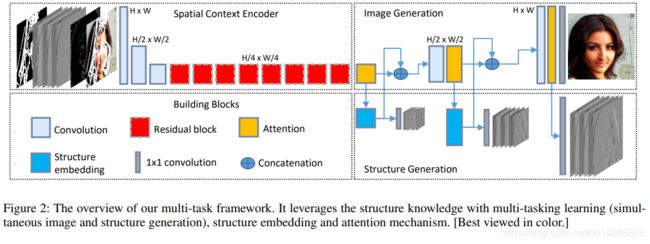

本文提出了一个多任务学习框架,试图结合图像结构知识来辅助图像补全。其主要思想是训练一个共享生成器来同时完成被破坏的图像和相应结构的边缘和梯度,从而隐含地鼓励生成器在补全时利用相关的结构知识。同时,作者还引入了一种金字塔结构损失来监督结构的学习和嵌入方案,将学习到的结构特征显式嵌入到图像补全过程中,从而为图像补全提供了可能的前提条件。此外,还开发了注意机制,进一步利用图像中的重复结构和模式来细化生成的结构和内容。

方法

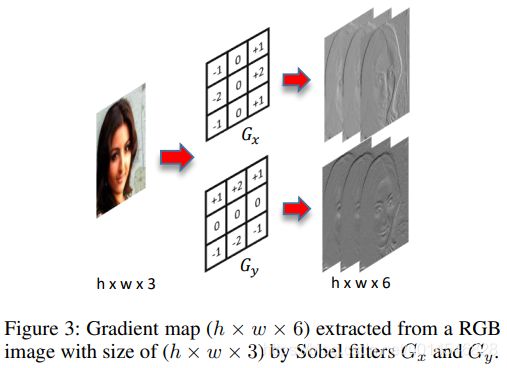

本文也采用表示图像结构的边缘信息作为辅助,进行图像补全。但并不是直接对边缘进行估计修复,而是考虑先对梯度信息进行修复。

I :真实图像;

C:I 的梯度图;采用 Sobel filters;

E:I 的边缘图;采用 Canny detector。

image mask M (with value 0 for known region 1 otherwise)

输入空洞图像 ![]()

空洞图像梯度 ![]()

空洞图像边缘 ![]()

Architecture

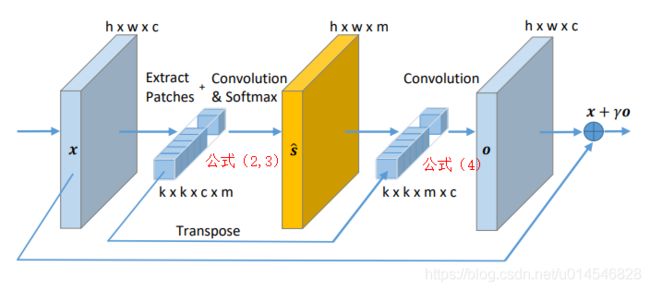

其中主力模块是这样的

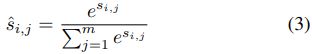

其中的 ![]() 是这么计算的:

是这么计算的:

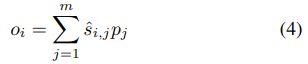

o 是这么算的:

Loss Functions

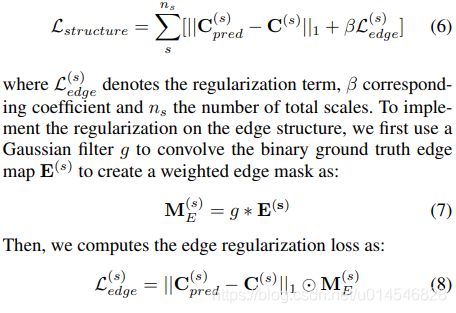

- Pyramid Structure Loss

其中,上标 s 表示拉普拉斯的尺度。

- Hybrid Image Loss

![]()

VGG loss

Style loss 也是计算特征空间的 L1 距离,但计算的是相应的 Gram matrix

PatchGAN

![]()

adversarial loss

![]()