MySQL学习:一条SQL语句的执行过程

最近在学习MySQL的一些底层知识,光会使用数据库是远远不够的,在面试过程中,这些底层核心知识更受面试官欢迎。学习了MySQL实战45讲,写的非常好,特此做一些笔记。

本博客主要是讲一条SQL语句的执行过程,主要涉及的是两方面知识:一是查询语句涉及的基础架构;二是更新语句涉及的日志系统。

一、一条SQL查询语句是怎么执行的(基础架构)

首先,需要了解一下MySQL的逻辑架构,当执行一条SQL语句时,我们知道它的执行过程,可以对MySQL有更深入的了解,在出现异常,错误的时候,可以更快速的定位问题所在。

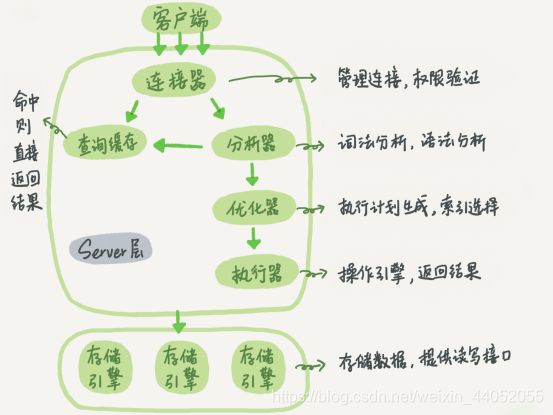

下面是MySQL的简单架构示意图,从图中可以看到一条SQL语句的执行和MySQL之间的关系。

注:图片源自林晓斌老师(下同),非常清晰,在此借用。

注:图片源自林晓斌老师(下同),非常清晰,在此借用。

MySQL主要分为Server层和存储引擎层。

(1)Server层包含连接器、查询缓存、分析器、优化器、执行器等,涵盖MySQL大多核心服务功能,以及所有的内置函数(如日期、时间、数学和加密函数等)。所有跨存储引擎的功能都在这一层,如存储转发,视图,触发器等。

(2)存储引擎层负责数据的存储和提取,其架构是插件式的,支持 InnoDB、MyISAM、Memory 等多个存储引擎。现在最常用的存储引擎是 InnoDB,它从 MySQL 5.5.5 版本开始成为了默认存储引擎。(你也可以选择存储引擎,来指定内存引擎创建表)

从图中可以看出,不同存储引擎共用一个Server层,从连接器到执行器。下面介绍一下Server层的各个功能。

1)连接器

连接器负责跟客户端建立连接、获取权限、维持和管理连接。代码命令如下:

mysql -h$ip -P$port -u$user -p

输完命令之后,需要在交互对话里面输入密码,不建议直接p后接密码。

连接命令中的 mysql 是客户端工具,用来跟服务端建立连接。在完成经典的 TCP 握手后,连接器就要开始认证你的身份,这个时候用的就是你输入的用户名和密码。

连接完成后,如果你没有后续的动作,这个连接就处于空闲状态。客户端如果太长时间没动静,连接器就会自动将它断开。这个时间是由参数 wait_timeout 控制的,默认值是 8 小时。如果在连接被断开之后,客户端再次发送请求的话,就会收到一个错误提醒: Lost connection to MySQL server during query。这时候如果要继续,就需要重连,然后再执行请求了。

下面讲一下数据库的长连接和短连接:

- 长连接是指连接成功后,如果客户端持续有请求,则一直使用同一个连接。

- 短连接则是指每次执行完很少的几次查询就断开连接,下次查询再重新建立一个。

建立连接的过程比较复杂,建议使用长连接,但使用长连接,MySQL的占用内存涨的很快,因为MySQL 在执行过程中临时使用的内存是管理在连接对象里面的,这些资源会在连接断开的时候才释放。所以长连接累计下来,内存占用特别大,可能会被系统强行杀掉(OOM),就是 MySQL 异常重启。

为了解决这个问题,有两种方案:

-

定期断开长连接。

-

如果是MySQL 5.7 或更新版本,可以在每次执行一个比较大的操作后,通过执行 mysql_reset_connection 来重新初始化连接资源。这样可以恢复到连接刚刚创建完成的状态。

2)查询缓存

建立连接成功后,可以执行select命令,逻辑则执行查询缓存。MySQL拿到一个查询请求,会先查找查询缓存,看是否是之前执行过的语句,如果之前执行过,则会以(key,value)对存储在内存中,key是查询语句,value是查询结果。如果语句不在查询缓存中,则执行后面的过程。

虽然看起来查询缓存的效率非常高,但建议不要使用查询缓存。因为查询缓存的失效非常频繁,只要有对一个表的更新,这个表上所有的查询缓存都会被清空。MySQL 8.0 版本直接将查询缓存的整块功能删掉了。

3)分析器(做什么)

- 分析器先进行词法分析,输入的是由多个字符串和空格组成的一条 SQL 语句,MySQL需要识别出里面的字符串分别是什么,代表什么。MySQL从你输入的"select"这个关键字识别出来,这是一个查询语句。它也要把字符串“T”识别成“表名 T”,把字符串“ID”识别成“列 ID”。

- 然后是语法分析。根据词法分析的结果,语法分析器会根据语法规则,判断你输入的这个 SQL 语句是否满足 MySQL 语法。

4)优化器(怎么做)

经过了分析器,MySQL 就知道你要做什么了。在开始执行之前,还要先经过优化器的处理。

优化器是在表里面有多个索引的时候,决定使用哪个索引;或者在一个语句有多表关联(join)的时候,决定各个表的连接顺序。

优化器就是决定执行的方案,在不同执行方法相同的逻辑结果下,选择一种执行方案。

优化器阶段完成后,这个语句的执行方案就确定下来了,然后进入执行器阶段。

5)执行器(开始做)

MySQL 通过分析器知道了你要做什么,通过优化器知道了该怎么做,于是就进入了执行器阶段,开始执行语句。

开始执行的时候,要先判断一下你对这个表 T 有没有执行查询的权限,如果没有,就会返回没有权限的错误。如果有权限,就打开表继续执行。打开表的时候,执行器就会根据表的引擎定义,去使用这个引擎提供的接口。

样例:

select * from T where ID=10;

如果这个例子中的表 T 中,ID 字段没有索引,那么执行器的执行流程是这样的:

- 调用 InnoDB 引擎接口取这个表的第一行,判断 ID 值是不是 10,如果不是则跳过,如果是则将这行存在结果集中。

- 调用引擎接口取“下一行”,重复相同的判断逻辑,直到取到这个表的最后一行。

- 执行器将上述遍历过程中所有满足条件的行组成的记录集作为结果集返回给客户端。

对于有索引的表,则是第一次调用的是“取满足条件的第一行”这个接口,之后循环取“满足条件的下一行”这个接口,这些接口都是引擎中已经定义好的。

在数据库的慢查询日志中可以看到一个== rows_examined== 的字段,表示这个语句执行过程中扫描了多少行。这个值就是在执行器每次调用引擎获取数据行的时候累加的。但是在有些场景下,执行器调用一次,引擎内部扫描了多行,因此引擎扫描行数跟 rows_examined 并不是完全相同的。

二、一条SQL更新语句是怎么执行的(日志系统)

从一个表的一个更新语句开始说:

创建一个表,这个表有一个主键 ID 和一个整型字段 c:

create table T(ID int primary key, c int);

将 ID=2 这一行的值加 1

update T set c=c+1 where ID=2;

如上讲查询语句的那一套流程,更新语句也是同样会走一遍。

与查询流程不一样的是,更新流程还涉及两个重要的日志模块:

redo log(重做日志)和 binlog(归档日志)

这是MySQL里两个绕不过的词。

1)redo log(物理日志)

在 MySQL 里有这个问题,如果每一次的更新操作都需要写进磁盘,然后磁盘也要找到对应的那条记录,然后再更新,整个过程 IO 成本、查找成本都很高。为了解决这个问题,MySQL 里使用到的 WAL 技术,WAL 的全称是 Write-Ahead Logging,它的关键点就是先写日志,再写磁盘。

具体来说,当有一条记录需要更新的时候,InnoDB 引擎就会先把记录写到 redo log里面,并更新内存,这个时候更新就算完成了。同时,InnoDB 引擎会在适当的时候,将这个操作记录更新到磁盘里面,而这个更新往往是在系统比较空闲的时候做。

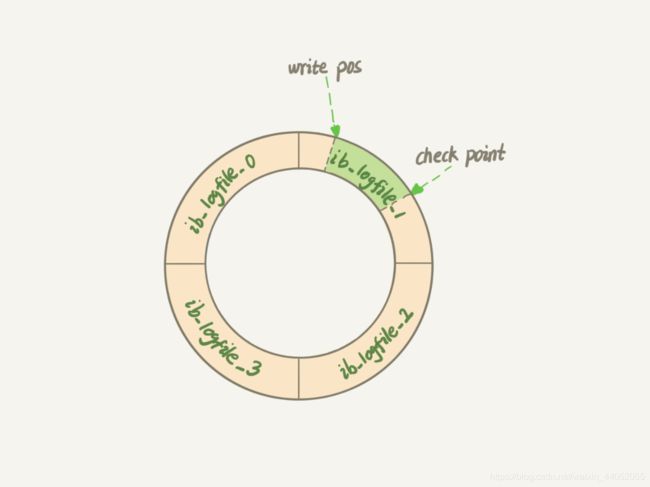

InnoDB 的 redo log 是固定大小的,比如可以配置为一组 4 个文件,每个文件的大小是 1GB,那么日志总共就可以记录 4GB 的操作。从头开始写,写到末尾就又回到开头循环写,如下面这个图所示:

类似与数据结构里的循环队列。

类似与数据结构里的循环队列。

write pos 是当前记录的位置,一边写一边后移,写到第 3 号文件末尾后就回到 0 号文件开头。checkpoint 是当前要擦除的位置,也是往后推移并且循环的,擦除记录前要把记录更新到数据文件。write pos 和 checkpoint 之间的是日志上还空着的部分,可以用来记录新的操作。如果 write pos 追上 checkpoint,表示日志满了,这时候不能再执行新的更新,得停下来先擦掉一些记录,把 checkpoint 推进一下。

有了 redo log,InnoDB 就可以保证即使数据库发生异常重启,之前提交的记录都不会丢失,这个能力称为crash-safe。

redo log 用于保证 crash-safe 能力。innodb_flush_log_at_trx_commit 这个参数设置成 1 的时候,表示每次事务的 redo log 都直接持久化到磁盘。这个参数建议设置成 1,这样可以保证 MySQL 异常重启之后数据不丢失。

2)binlog(逻辑日志)

redo log 是 InnoDB 引擎特有的日志,而 Server 层也有自己的日志,称为 binlog(归档日志)。

binlog有两种模式,statement 格式的话是记sql语句, row格式会记录行的内容,记两条,更新前和更新后都有。

两份日志的原因:

因为最开始 MySQL 里并没有 InnoDB 引擎。MySQL 自带的引擎是 MyISAM,但是 MyISAM 没有 crash-safe 的能力,binlog 日志只能用于归档。而 InnoDB 是另一个公司以插件形式引入 MySQL 的,既然只依靠 binlog 是没有 crash-safe 能力的,所以 InnoDB 使用另外一套日志系统——也就是 redo log 来实现 crash-safe 能力。

这两种日志有以下三点不同:

- redo log 是 InnoDB 引擎特有的;binlog 是 MySQL 的 Server 层实现的,所有引擎都可以使用。

- redo log 是物理日志,记录的是“在某个数据页上做了什么修改”;binlog 是逻辑日志,记录的是这个语句的原始逻辑,比如“给 ID=2 这一行的 c 字段加 1 ”。

- redo log 是循环写的,空间固定会用完;binlog 是可以追加写入的。“追加写”是指 binlog 文件写到一定大小后会切换到下一个,并不会覆盖以前的日志。

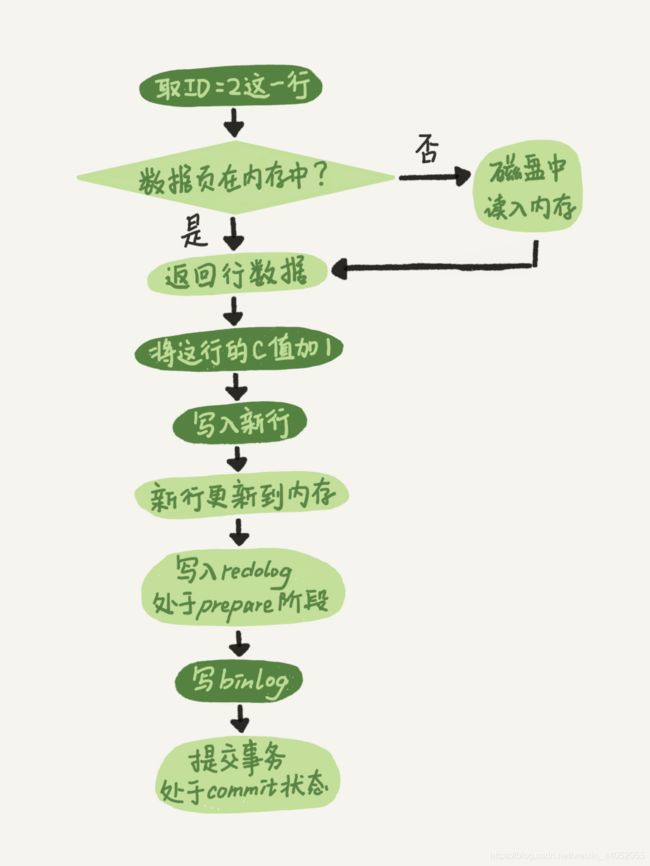

再来看执行器和 InnoDB 引擎在执行这个简单的 update 语句时的内部流程。

- 执行器先找引擎取 ID=2 这一行。ID 是主键,引擎直接用树搜索找到这一行。如果 ID=2

这一行所在的数据页本来就在内存中,就直接返回给执行器;否则,需要先从磁盘读入内存,然后再返回。 - 执行器拿到引擎给的行数据,把这个值加上 1,比如原来是 N,现在就是 N+1,得到新的一行数据,再调用引擎接口写入这行新数据。

- 引擎将这行新数据更新到内存中,同时将这个更新操作记录到 redo log 里面,此时 redo log 处于 prepare 状态。然后告知执行器执行完成了,随时可以提交事务。

- 执行器生成这个操作的 binlog,并把 binlog 写入磁盘。

- 执行器调用引擎的提交事务接口,引擎把刚刚写入的 redo log 改成提交(commit)状态,更新完成。

这个 update 语句的执行流程图,图中浅色框表示是在 InnoDB 内部执行的,深色框表示是在执行器中执行的。

最后三步,将 redo log 的写入拆成了两个步骤:prepare 和 commit,这就是"两阶段提交"。

sync_binlog 这个参数设置成 1 的时候,表示每次事务的 binlog 都持久化到磁盘。这个参数也建议设置成 1,这样可以保证 MySQL 异常重启之后 binlog 不丢失。

3)两阶段提交

数据恢复过程:

当需要恢复到指定的某一秒时,比如某天下午两点发现中午十二点有一次误删表,需要找回数据,那你可以这么做:

- 首先,找到最近的一次全量备份,如果你运气好,可能就是昨天晚上的一个备份,从这个备份恢复到临时库;

- 然后,从备份的时间点开始,将备份的 binlog 依次取出来,重放到中午误删表之前的那个时刻。

这样你的临时库就跟误删之前的线上库一样了,然后你可以把表数据从临时库取出来,按需要恢复到线上库去。

两阶段提交:

由于 redo log 和 binlog 是两个独立的逻辑,如果不用两阶段提交,要么就是先写完 redo log 再写 binlog,或者采用反过来的顺序。我们看看这两种方式会有什么问题。

仍然用前面的 update 语句来做例子。假设当前 ID=2 的行,字段 c 的值是 0,再假设执行 update 语句过程中在写完第一个日志后,第二个日志还没有写完期间发生了 crash,会出现什么情况呢?

- 先写 redo log 后写 binlog。假设在 redo log 写完,binlog 还没有写完的时候,MySQL

进程异常重启。由于我们前面说过的,redo log 写完之后,系统即使崩溃,仍然能够把数据恢复回来,所以恢复后这一行 c 的值是 1。但是由于 binlog 没写完就 crash 了,这时候 binlog 里面就没有记录这个语句。因此,之后备份日志的时候,存起来的 binlog 里面就没有这条语句。然后你会发现,如果需要用这个 binlog 来恢复临时库的话,由于这个语句的 binlog 丢失,这个临时库就会少了这一次更新,恢复出来的这一行 c 的值就是 0,与原库的值不同。 - 先写 binlog 后写 redo log。如果在 binlog 写完之后 crash,由于 redo log 还没写,崩溃恢复以后这个事务无效,所以这一行 c 的值是 0。但是 binlog 里面已经记录了“把 c 从 0 改成 1”这个日志。所以,在之后用 binlog 来恢复的时候就多了一个事务出来,恢复出来的这一行 c 的值就是 1,与原库的值不同。

可以看到,如果不使用“两阶段提交”,那么数据库的状态就有可能和用它的日志恢复出来的库的状态不一致。

我的理解就是,采用两阶段提交:最后三步,1,prepare阶段 2,写binlog 3,commit

当在2之前崩溃时,重启恢复,发现没有commit,回滚。备份恢复,没有binlog。则两者一致。

简单说,redo log 和 binlog 都可以用于表示事务的提交状态,而两阶段提交就是让这两个状态保持逻辑上的一致。