CRNN文字识别

OCR文字识别领域论文系列:

1️⃣CRNN:CRNN文字识别

2️⃣ASTER:ASTER文本识别详解

CRNN论文翻译——中英文对照

CRNN介绍:

近几年来,CRNN在计算机视觉文本识别领域取得不错成果。CRNN是一种卷积循环神经网络结构,用于解决基于图像的序列识别问题,特别是场景文字识别问题。CRNN网络实现了不定长验证结合CNN和RNN网络结构,使用双向LSTM循环网络进行时序训练,并在最后引入CTC损失函数来实现端对端的不定长序列识别,

CRNN网络结构:

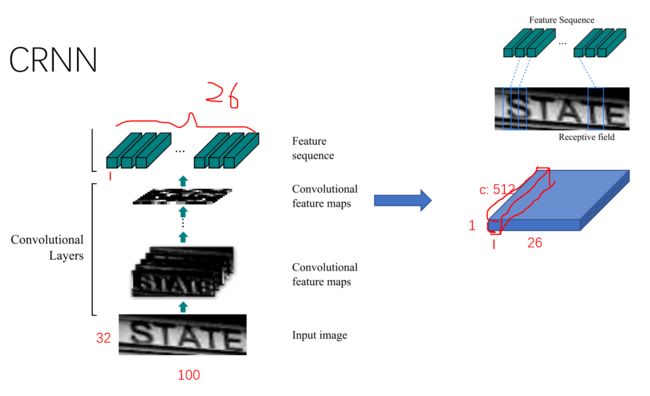

1.卷积层

卷积:提取图像特征 池化:为了降维减少计算量

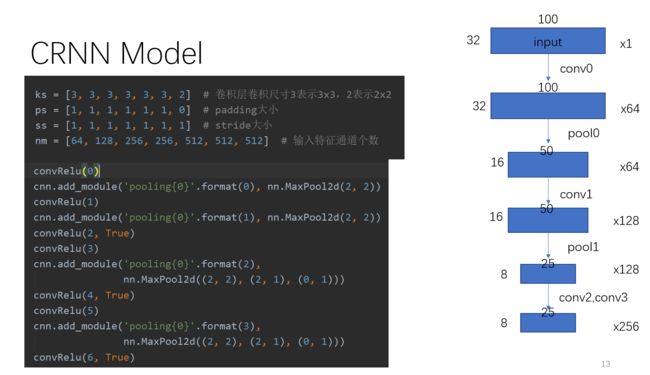

CRNN卷积层由标准的CNN模型中的卷积层和最大池化层组成,自动提取出输入图像的特征序列。与普通CNN网络不同的是,CRNN在训练之前,先把输入图像缩放到相同高度(图像宽度维持原样),论文中使用的高度值是32。

论文中该CNN结构输出的特征图大小为 ,若输入图片高度为32,宽度为100,则特征图的大小为(1, 24, 512)。这个结果可以认为图片从左到右被分割成了24块,每块大小的 特征维度 为512。提取的特征序列中的向量是从特征图上从左到右按照顺序生成的,每个特征向量表示了图像上一定宽度上的特征,论文中使用的这 个宽度是1,就是单个像素。

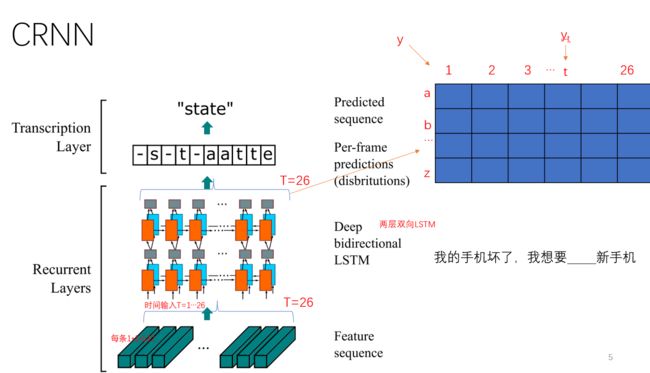

2.循环层

转录就是 RNN 对每个像素的预测转换为标签序列的过程。

CRNN的循环层由一个双向LSTM循环神经网络构成,预测特征序列中的每一个特征向量的标签分布(真实结果的概率列表),循环层的误差被反向传播,最后会转换成特征序列,再把特征序列反馈到卷积层,这个转换操作由论文中定义的“Map-to-Sequence”自定义网络层完成,作为卷积层和循环层之间连接的桥梁。

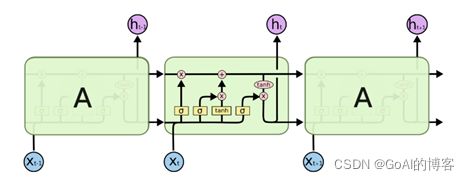

LSTM(长短期记忆网络)则是一种特殊结构的RNN,用于解决RNN的长期依赖问题,普通RNN会出现“梯度消失”或“梯度爆炸”的问题,不能获取更多上下文信息,所以 CRNN 中使用的是 LSTM,允许捕获长距离依赖。LSTM单元由输入门、遗忘门和输出门组成。

RNN原理参考:水很深的深度学习-Task05循环神经网络RNN_GoAl的博客-CSDN博客

LSTM原理参考:LSTM原理介绍_GoAl的博客-CSDN博客

3.转录层

CTC一般连接在RNN网络的最后一层用于序列学习和训练。对于一段长度为T的序列来说,每个样本点t(t远大于T)在RNN网络的最后一层都会输出一个softmax向量,表示该样本点的预测概率,所有样本点的这些概率传输给CTC模型后,输出最可能的标签,再经过去除空格(blank)和去重操作,就可以得到最终的序列标签。

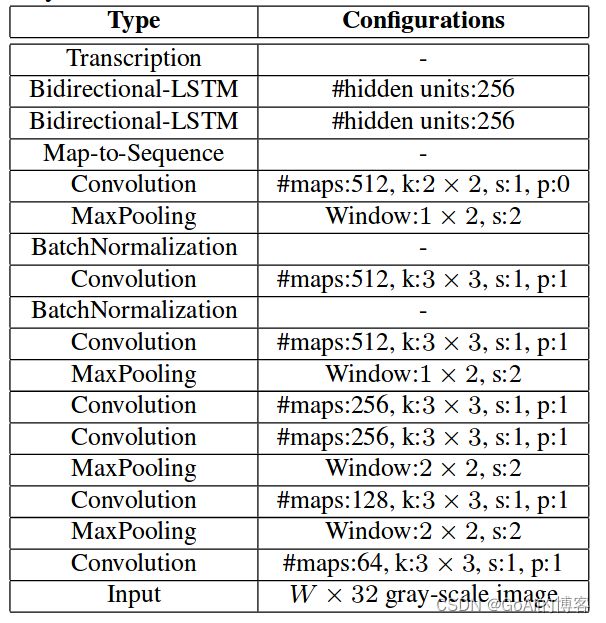

CRNN完整网络结构图:

从整个网络中可以看出,卷积层是由一系列的卷积、最大池化、批量归一化等操作组成,由标准的CNN模型中的卷积层和最大池化层组成,结构类似于VGG网络。

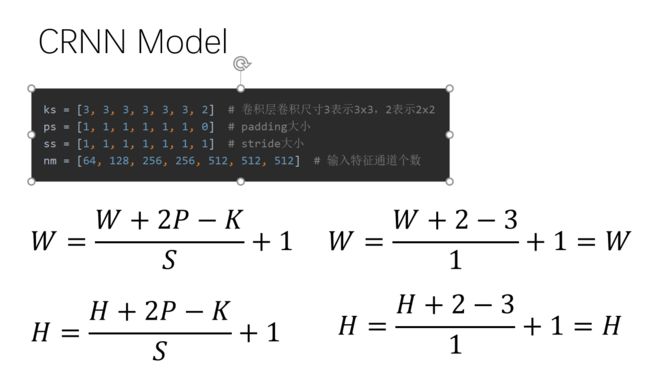

CRNN模型计算公式:

CRNN模型计算详细流程:

4.CTC原理介绍

CTC是一种Loss计算方法,用CTC代替Softmax Loss,训练样本无需对齐。引入blank字符,解决有些位置没有字符的问题,通过递推,快速计算梯度。

以下以apple单词为例,引入“-”符号,解释CTC网络是如何展开路径进行计算的。

路径展开原则:(如图中5点)

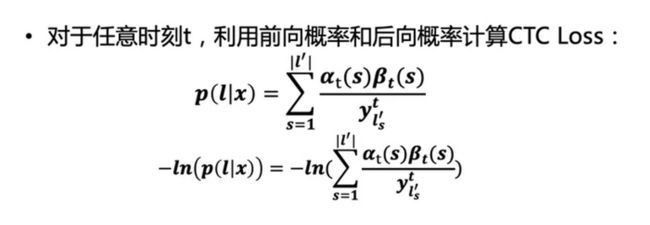

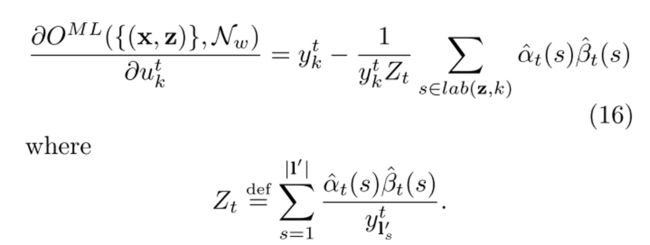

CTC训练流程和传统的神经网络类似,构建损失函数,然后根据BP算法进行训练,不同之处在于传统的神经网络的训练准则是针对每帧数据,即每帧数据的训练误差最小,而CTC的训练准则是基于序列的,比如最大化 p(l|x) ,序列化的概率求解比较复杂,因为一个输出序列可以对应很多的路径,所有引入前后向算法来简化计算。

前向概率:

后向概率:

计算CTC Loss:

CTC原理参考:

一文读懂CRNN+CTC文字识别 - 知乎

【Learning Notes】CTC 原理及实现_丁丁的博客-CSDN博客_ctc实现

CTC(Connectionist Temporal Classification)介绍 - PilgrimHui - 博客园

5.CRNN模型训练:

在模型训练过程中,首先使用标准的CNN网络提取文本图像的特征,再利用BLSTM将特征向量进行融合以提取字符序列的上下文特征,然后得到每列特征的概率分布,最后通过转录层(CTC)进行预测得到文本序列。其具体模型训练流程为:

1.将输入图像统一缩放至32*W*3。

2.利用CNN提取后图像卷积特征,得到的大小为:1*W/4*512。

3.通过上述输入到LSTM提取序列特征,得到W/4*n后验概率矩阵。

4.利用CTC损失,实现标签和输出一一对应,进行训练。

6.CRNN+CTC总结

CRNN将CNN/LSTM/CTC三种方法结合:提供了一种end2end文本行图片算算法。

(1)CNN提取图像卷积特征

(2)LSTM进一步提取图像卷积特征中的序列特征

(3)引入CTC解决训练时字符无法对齐的问题

优点:

- 可以直接从序列标签学习,不需要详细的标注

- 具有直接从图像数据学习信息表现的DCNN的相同性质,既不需要手工特征也不需要预处理步骤,包括实体化/分割,组件定位等;

- 具有 RNN 相同的性质,能够产生一系列标签

- 对类序列对象的长度无约束,只需要在训练阶段和测试阶段对高度进行归一化

- 比标准 DCNN 模型包含的参数要少的多,占用更少的存储空间