4月25日(星期一)至4月29日(星期五),International Conference in Learning Representations(ICLR)将连续第三年在线举行。它是世界机器学习研究世界上最大,最受欢迎的会议之一:它包含超过一千篇有关主题的论文,包括ML理论,强化学习(RL),计算机视觉(CV),自然语言处理(NLP),神经科学等。

1、Autoregressive Diffusion Models

Emiel Hoogeboom, Alexey A. Gritsenko, Jasmijn Bastings, Ben Poole, Rianne van den Berg, Tim Salimans.

一个用于离散变量,自回归新模型。

扩散模型在过去一年中一直在流行,并且它们逐渐被吸收到深度学习工具箱中。本文提出了这些模型的重要概念创新。推理时从采样某种“白噪声”图像开始,扩散模型通过迭代地在像素网格上添加“可微噪声”来生成图像,最终成为一个真实的图像。这项工作建议做一个类似的过程,但不是在同一时间应用扩散步骤迭代解码所有像素,他们在一次自回归中解码几个像素(见下图)。

此外,与DALL·E这样的自回归图像生成方法相比,这种方法在解码图像时不需要特定的排序。或者在每个扩散步骤中解码的像素的数量可以通过模型进行动态调整,并给定固定的步骤来解码整个图像!

对于训练,类bert的去噪自编码器自我监督就可以了,给定一幅图像,掩盖一部分像素,并预测其中一些的值。虽然结果不是惊天动地的,但这是扩散模型概念上的一个简单而有效的进化,允许它们解码输出自回归,并适用于非从左到右的文本生成。

https://openreview.net/forum?...

2、Poisoning and Backdooring Contrastive Learning

Nicholas Carlini, Andreas Terzis.

大规模自我监督的预训练与从网络上抓取的数据是训练大型神经网络的基本要素之一。本文探讨了对手如何”毒害“像CLIP这样的模型的一小部分训练数据 - 使用来自网络的图像-文本对的对比学习进行训练——从而使该模型将错误分类测试图像。他们尝试了两种方法:

目标修改:通过添加中毒样本来修改训练数据集,目的是使最终模型对带有错误特定标签的特定图像进行错误分类。根据研究结果,只要输入训练数据集的0.0001%,例如向300万个实例的数据集添加3个图像对,就可以实现这一点。

后门攻击:不是有一个特定的目标图像,这种方法旨在覆盖任何图像上的像素小块,这样就会被错误分类。这种攻击可以通过修改0.01%的训练数据集来持续实现,例如修改300万个实例数据集中的300张图像。

任何人都可以操纵公共互联网数据,这使这些攻击可行。这仍然是在开发和部署模型时应考虑的训练模型时的新弱点。

https://openreview.net/forum?...

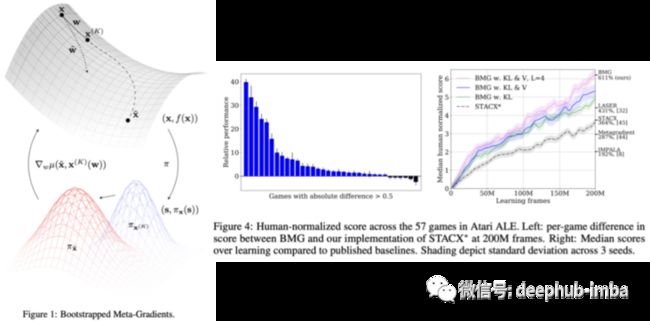

3、Bootstrapped Meta-Learning

Sebastian Flennerhag, Yannick Schroecker, Tom Zahavy, Hado van Hasselt, David Silver, Satinder Singh.

提出了一种用于元学习的算法,该算法使用梯度从本身或其他更新规则中引导元学习。许多强化学习算法对超参数的选择敏感。元学习是一种有希望的学习范式,用于完善学习者的学习规则(包括超参数),以使学习速度更快,更健壮。

在元学习中,优化了内部优化的“学习规则”,该规则直接优化了学习目标(例如,通过梯度下降)。简单地说,现有的元学习算法通常依赖于学习者的表现来评估学习规则:运行学习者k步,如果学习进步了,就多走几步;如果学习变差了,就少走几步。这个问题使用元学习的学习者的目标的优化变为:(1)限制为学习目标函数的相同几何形状(2)优化是近视的,因为它只会优化k步骤,而除此之外学习的动力可能会复杂得多。

这个过程的理论细节很复杂,所以我们简单来说:首先要求元学习者预测学习者超出评估的K-Steps的表现,然后根据这一预测来优化。换句话说,元学习者生成了自己的目标并进行优化。这使得元学习者可以在更长的时间范围内进行优化,而无需实际评估长的时间范围,因为这步计算是非常耗费资源的。

作者证明了这种方法的一些不错的理论特性,经验结果在ATARI ALE-Benchmark上获得了SOTA,并在多任务学习中提高了效率。

https://openreview.net/forum?...

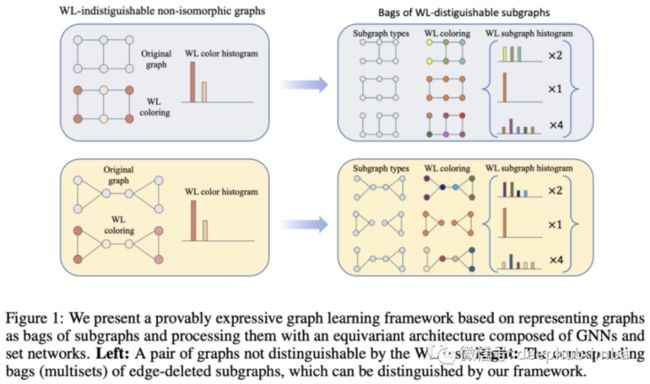

4、Equivariant Subgraph Aggregation Networks

Beatrice Bevilacqua, Fabrizio Frasca, Derek Lim, Balasubramaniam Srinivasan, Chen Cai, Gopinath Balamurugan, Michael M. Bronstein, Haggai Maron.

消息传递的神经网络(MPNN)的表现力有限,所以论文提出了一个基于将图表表示为多组子图并使用一种等变结构对其进行处理。

如何知道两个图是否相同?你可能认为看一眼就足够了,其实相同的图可以用不同的方式表示,重新组织或允许节点的顺序,这样对于给定的两个图,很难识别它们是否相同,因为这些图都是同构的。

Weisfeiler-Leman(WL)测试是一种算法,它基于其直接邻域对图的节点进行了递归分类。如果在所有这些过程之后,两个图的节点具有“不同的分类”,则意味着测试失败或者说这两个图是不同的(非同态)。如果两个图在WL测试之后“仍然相同”,则它们可能是同构的,但不能保证!有某些图形结构WL测试将无法区分。

https://openreview.net/forum?...

5、Perceiver IO: A General Architecture for Structured Inputs & Outputs

Andrew Jaegle, Sebastian Borgeaud, Jean-Baptiste Alayrac, Carl Doersch, Catalin Ionescu, David Ding, Skanda Koppula, Daniel Zoran, Andrew Brock, Evan Shelhamer, Olivier Hénaff, Matthew M. Botvinick, Andrew Zisserman, Oriol Vinyals, Joāo Carreira.

论文提出了一种叫Perceiver IO通用架构,可以处理来自任意设置的数据,同时随输入和输出的大小进行线性缩放。

这个框架采用感知器³类似的思路,通过增加一个灵活的查询机制,使模型具有任意大小的输出,而不是在模型结束时要求一个特定于任务的架构。它支持各种大小和语义的输出,从而消除了对特定于任务的体系结构工程的需要。

输入可以是任意长的嵌入序列,这些嵌入序列被映射到潜在数组编码中。鉴于潜在阵列大小是固定的因此该过程允许对很长的输入序列进行建模,因此当输入变长时,并不会出现复杂度爆炸。在此“编码步骤”之后,模型应用了由自注意力和前馈层组成的transformer 模块。最后,解码步骤接受输出查询数组,并将其与输入的潜在表示相结合,以产生所需维数的输出数组。

现有许多的学习技术可以应用此架构。该模型遵循现有的每个模态训练方法,在自然语言处理和视觉理解、多任务和多模态推理以及光流方面产生强大的结果。他们甚至把它插入AlphaStar(取代现有的transformer 模块),在具有挑战性的星际争霸2游戏中也取得强大的结果!

https://openreview.net/forum?...

6、Exploring the Limits of Large Scale Pre-training

Samira Abnar, Mostafa Dehghani, Behnam Neyshabur, Hanie Sedghi.

规模一直是ML圈内讨论的一个持久的话题。我们经常强调论文,因为这无疑是该领域必须解决的重要问题之一:在哪里添加参数和数据就不再有用了?结论差不多就是“当我们增加上游的准确性时,下游任务的表现就会饱和”。

论文研究了上游任务(如大规模ImageNet标签)的训练前表现如何转移到下游(DS)任务(如鲸鱼检测)。然后对大量的架构和规模做这个实验:

“在ViT、MLP-Mixers和ResNets上的4800个实验,参数的数量从1000万到100亿不等,在可用图像数据的最大规模上进行训练”。

有趣的图显示了上游和下游绩效间的关联。几乎在所有领域,它最终会饱和。尽管如此,看到计算机视觉不同架构之间的差异还是非常有趣的!

作者声称,他们的观察结果总体上对诸如上游数据的大小以及结构选择等似乎是稳健的。他们还探索了超参数选择的影响:是否有些超参数对于上游非常有利,但却不能有效地转化为下游任务?是的!他们在第4节深入研究了这一现象,发现例如,weight decay是一个特别显著的超参数,它对的表现有不同的影响。

在不从头开始训练模型而是选择预先训练的模型来引导应用程序的情况下,这项研究是关键。这篇文章的内容远不止几段话那么简单,如果你想深入了解,它绝对值得一读!

https://openreview.net/forum?...

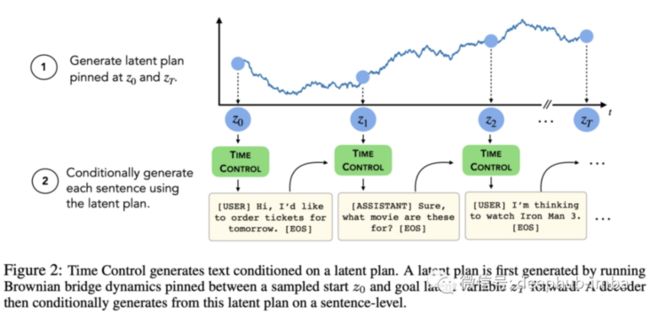

7、Language modeling via stochastic processes

Rose E Wang, Esin Durmus, Noah Goodman, Tatsunori Hashimoto.

论文引入了一个通过潜在随机过程隐含规划的语言模型。

现代大型生成语言模型非常擅长编写短文本,但当它们生成长文本时,全局一致性往往会丧失,事情不再有意义。本文提出了一种减轻这种情况的方法。

该模型被称为时间控制,它将句子表示模型为潜在空间中的布朗运动。在训练中,给定两个开始和结束的锚句,一个对比损失是由一个在锚句内的肯定句形成的这个肯定句落入了锚句在潜在空间中的"布朗桥"表征中,然后把负样本推出去。布朗桥:一个起始和结束位置固定的布朗(摇摆)轨迹。

对于推理,通过对潜在空间中的布朗过程进行抽样,生成一个句子级的计划,然后在这个高级计划的条件下生成标记级的语言。

研究结果非常有趣,尤其是在语篇连贯准确性方面,时间控制发挥了重要作用。这项工作为lm克服经典限制提供了一个不需要进入万亿参数尺度范围有前途的方向。

https://openreview.net/forum?...

8、Coordination Among Neural Modules Through a Shared Global Workspace

Anirudh Goyal, Aniket Didolkar, Alex Lamb, Kartikeya Badola, Nan Rosemary Ke, Nasim Rahaman, Jonathan Binas, Charles Blundell, Michael Mozer, Yoshua Bengio.

受大脑启发的模块化神经结构正在兴起;尽管它们在流行的计算机视觉或自然语言处理基准上没有取得类似人类的成功,但它们在健壮性、域外泛化、甚至学习因果机制方面都显示出了可喜的结果。

Global Workspace Theory(GWT)是一个被提议的认知架构,用来解释人类有意识和无意识的思维过程是如何表现的。它的核心假设之一是存在一个所有专业模块都可以访问的共享工作空间,从而在其他孤立的模块之间实现一致性。本文概念化了一个神经网络体系结构,专家神经网络处理一组输入,然后写入一个共享的工作空间——一组向量——然后再广播给其他专家。

这听起来可能比实际情况更神奇。例如有一个处理输入序列的Transformer,可以将位置操作概念化为专家操作。共享工作空间强加了一个条件,即允许在共享全局工作空间中更新多少更新的隐藏状态,从而施加一定程度的稀疏性,这已被证明可以提高鲁棒性和域外泛化。

与通常的这类工作一样,它们在不那么流行的任务和评估模式上表现良好,但在域内评估方面不会超过单一网络,所以它们不会成为很多头条新闻。但是这仍然是一项值得关注的并且非常有趣的工作。

https://openreview.net/forum?...

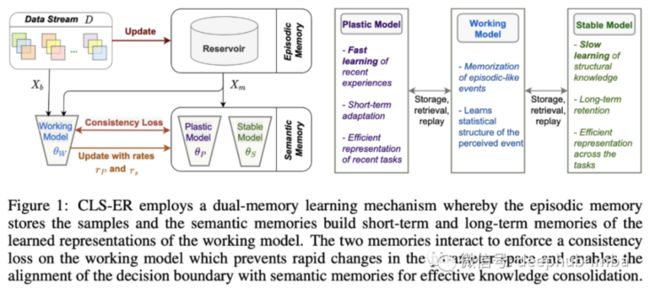

9、Learning Fast, Learning Slow: A General Continual Learning Method based on Complementary Learning System

Elahe Arani, Fahad Sarfraz & Bahram Zonooz.

由Daniel Kahneman普及的人类思维模式的二分法——快速和缓慢——是人类思维方式的核心。本文从这个想法中获得灵感,构建一个利用快速和缓慢学习来提高持续学习的体系结构。

持续学习是一种通过将模型暴露于新数据或与动态环境交互来逐步扩展其知识的方法。例如,考虑一个模型,它最初只学会对数字0到7的图像进行分类,并被教导识别数字8和9,而不会忘记前面的数字。其目标是能够利用现有知识更有效地学习新事物,就像人类所做的那样。

为本文提出了一种针对长、短两个时间尺度的记忆体验回放系统。其中一个主要的创新是语义记忆的使用:两个神经网络代表可塑性和稳定的模型。为了实现快速和短时间的学习,稳定模型由快速模型的指数移动平均组成:这使得两个模型具有一致的权值,但稳定模型的演化比可塑性模型更慢更平滑,因为可塑性模型对最新数据更敏感。这种方法也被用于其他场合,比如BYOL的对比学习中。储层作为情景记忆,保留数据流的样本,减轻灾难性遗忘。

实验显示,在以下3个任务上表现出色:

- 类别增量学习:在一个分类设置中逐步增加新的类别。

- 领域增量学习:在不添加新类的情况下引入数据的分布转移。

- 通用增量学习:将模型暴露给新的类实例和数据的快速分布,比如MNIST分类任务中的旋转数字。

https://openreview.net/forum?...

10、Autonomous Reinforcement Learning: Formalism and Benchmarking

Archit Sharma, Kelvin Xu, Nikhil Sardana, Abhishek Gupta, Karol Hausman, Sergey Levine, Chelsea Finn.

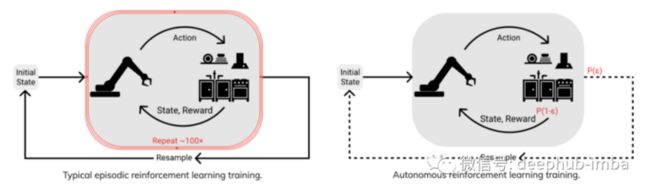

大多数RL基准测试是偶发性的:代理通过在每次代理失败时完全重新启动的环境中执行任务来学习。人类很少在这种环境中学习:当我们重新尝试做某事时,环境不会重新开始!如果机器人注定要出现在现实世界中,为什么我们还要在章节基准中评估大多数RL算法?

这项工作提出了一个专注于非情景性学习的基准,作者称之为Autonomous Reinforcement Learning(EARL),并希望它类似于真实世界。

从技术上讲,EARL是传统RL的一个子集,在这种RL中,环境随着代理的交互而不断演变,而不是在每一集结束时重新设置。但是在实践中很少这样做,因此这项工作通过为强化学习的形式(例如,学习代理、环境、奖励、政策评估、干预等概念的定义和数学公式)奠定了基础。

https://openreview.net/forum?...

引用

[1] “The Arcade Learning Environment: An Evaluation Platform for General Agents” by Marc G. Bellemare, Yavar Naddaf, Joel Veness, and Michael Bowling; 2012.

[2] “Learning Transferable Visual Models From Natural Language Supervision” by Alec Radford et al. 2021.

[3] “Perceiver: General Perception with Iterative Attention” by Andrew Jaegle et al. 2021.

[4] “Zero-Shot Text-to-Image Generation” by Aditya Ramesh et al. 2021.

[5] “Bootstrap your own latent: A new approach to self-supervised Learning” by Jean-Bastien Grill et al. 2020.

[6] “Recurrent Independent Mechanisms” by Anirudh Goyal et al. 2021.

[7] “Hierarchical Perceiver” by Joao Carreira et al. 2022.

https://www.overfit.cn/post/7faf217fd54f45bfb33cd791fc3f83e4

作者:Sergi Castella i Sapé