CSDN每日开源指数

文章目录

- 一、前言

- 二、开源指数计算规则

- 三、获取数据

- 四、存储数据

- 五、性能问题

- 六、结果

一、前言

身为一名程序员,想必你肯定知道有个神奇的网站叫Github,上面有各路大神开源的各种项目,CSDN也有自己的开源网站,以前叫CodeChina,现在叫GitCode,使用起来与github无太大差别,但网速比GitHub快很多,非常适合国内开发者使用。为了解决国内用户访问 github 速度较慢的问题,Gitcode将github上的所有开源项目都镜像到Gitcode Mirrors 镜像仓库里,从Gitcode Mirrors 镜像仓库 clone 项目可以有将近 50 倍左右的速度提升。

我们的目的,就是从GitCode镜像仓库,爬取每日最热门的开源项目

二、开源指数计算规则

开源指数 = 每日新增star数 + 每日新增fork数 + 近七天提交次数

开源指数越大的,排名越靠前

三、获取数据

数据源地址: https://gitcode.net/mirrors

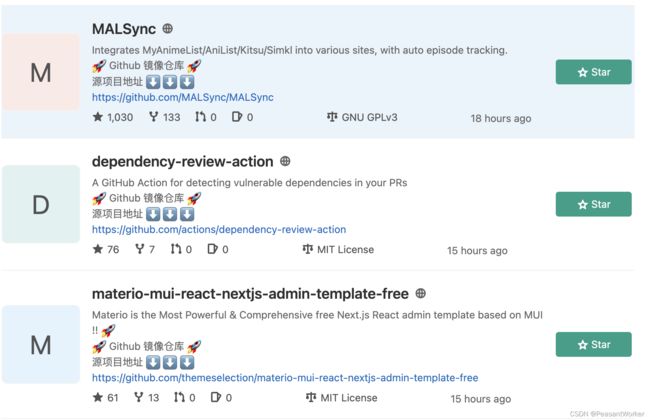

如下图:

这个页面,包含我们需要的大部分信息,如:star数,fork数等。

进入该网页时你会发现,这是个动态加载的页面,什么意思呢,就是你只通过requests.get的方式,拿不到网页的全部源码,因此,我们借助selenium来帮助我们模拟浏览器的操作,帮助我们获取页面上的所有源码,解析出我们需要的数据。

我们先new一个driver出来(爬取完后记得关闭)

chrome_options = Options()

chrome_options.add_argument('--no-sandbox')

chrome_options.add_argument('window-size=1920x3000')

chrome_options.add_argument('--hide-scrollbars')

chrome_options.add_argument('blink-settings=imagesEnabled=false')

chrome_options.add_argument('--headless')

chrome_options.add_argument('--disable-gpu')

driver = webdriver.Chrome(chrome_options=chrome_options)

关于chromedriver的安装,可以参考centos 安装 chromedriver

我们需要获取的数据可以分为两部分:

1、开源指数排行需要的数据(如star、fork)

2、开源项目自身的基本信息(如项目名称、项目描述、项目地址等)

四、存储数据

Gitcode Mirrors 镜像仓库共用5w+的开源项目,这么多数据,怎么存呢?

显然,用数据库来存储是最好的选择。

怎么存储呢?都存在一个表里?好像不太合理,因为开源项目自身的基本信息(项目名称、项目描述等)是不变的,只有开源指数需要的star数、fork数是每天需要更新的,如果都存在一个表里,很浪费存储空间,而且,我们每天都需要存5w+的数据,没几天上上百万级别了,因此,将全部数据存储在一个表里,是不合适的。

思考过后,我们决定将数据存储在两个表里,两个表可以通过project id来关联。如下:

- project_info 表----用来存储开源项目基本信息,这部分数据我们称为静态数据

- project_index_meta表----用来存储开源指数需要的star数、fork数,这部分需要每日更新的数据,我们称为动态数据

这样,project_info就只有5w+的数据,且来了新的project id就插入,若project id在表中已存在,就跳过,因此,这里需要一个判断该project id在project_info表中是否存在的函数

有了以上两个表,我们数据存在哪,怎么存的问题,就解决了。

五、性能问题

前面有提到https://gitcode.net/mirrors是个动态加载的网页,因此,我们获取网页源码时,需要等待网页加载完,才能获取到网页所有源码,总共有2500多页,获取每页的所有数据需要40s左右,获取所有数据需要100000s,一天86400s,就算我们的计算机全天不停,也爬不完。因此,我们需要使用多进程/多线程来解决这个问题。

首先,我们可以将2500页分为五段,每个进程处理500页,这样下来,我们开五个进程,速度飞快。

然后,将爬取到的每个项目的基本信息,放进队列中。

最后,我们再开启几个处理数据的进程,从队列里取出数据,做后续处理。

这一番操作下来,我们可以在三四个小时内就将所有数据都爬下来

部分代码:

def start(self):

max_page_index = self.get_max_page()

process_pool = []

one_process_pages = 1000

# 将页码分段,每个段开启一个进程

page_list = [i for i in range(1, max_page_index + 1, one_process_pages)]

if max_page_index not in page_list:

page_list.append(max_page_index)

page_tuple_list = []

for idx, value in enumerate(page_list):

if idx == len(page_list) - 1:

break

start_page = value

end_page = page_list[idx+1]

page_tuple_list.append((start_page, end_page))

# 创建爬取数据多进程

for idx, page in enumerate(page_tuple_list):

start_page = page[0]

end_page = page[1]

process_pool.append(Process(target=self.crawl_repo_url_p, args=(start_page,end_page), name="get_data_{}".format(idx)))

# 创建处理数据多进程

for i in range(self.process_num):

process_pool.append(Process(target=self.deal_repo_url_p, name="process_data_{}".format(i)))

process_pool.append(Process(target=self.stat, name=f"stat"))

# 启动进程运行

for t in process_pool:

t.start()

# 等待所有进程执行完毕

for t in process_pool:

t.join()

六、结果

我们将结果以社区帖子的形式发布了出来,请看 极客日报社区|开源指数频道

今日开源指数:CSDN每日指数–2022-04-12