目标检测算法-解读博客

Two Stage:

RCNN,Fast RCNN,Faster RCNN 总结

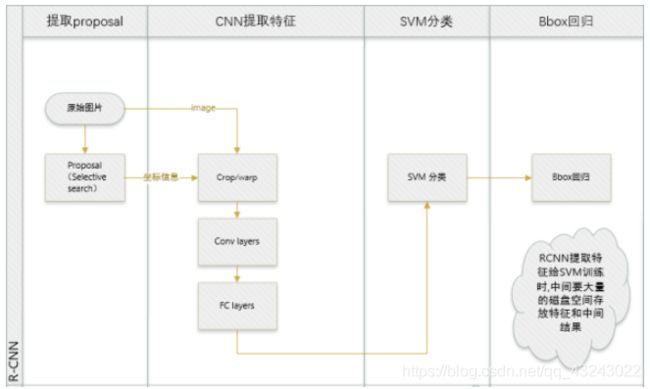

1 [RCNN] 2014

R-CNN论文详解:https://blog.csdn.net/WoPawn/article/details/52133338

RCNN- 将CNN引入目标检测的开山之作:https://zhuanlan.zhihu.com/xiaoleimlnote

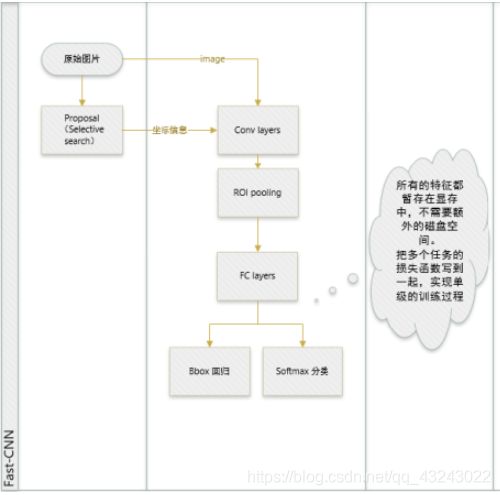

2 [Fast RCNN] 2015

【目标检测】Fast RCNN算法详解

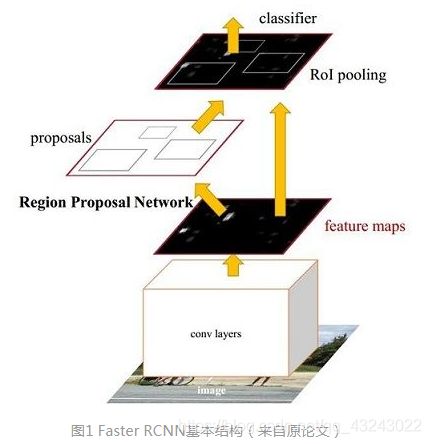

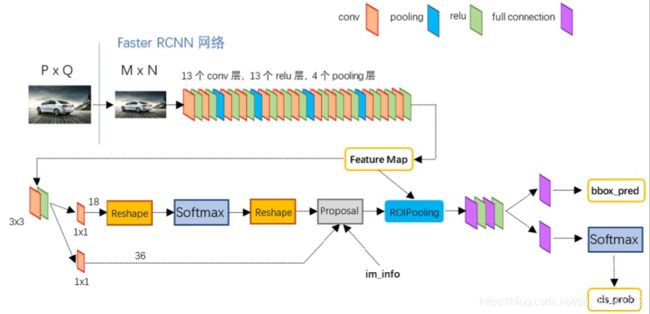

3 [Faster RCNN] 2016

一文读懂Faster RCNN

以VGG16为例的Faster RCNN

Tensorflow 版本 Faster RCNN 代码解读

faster rcnn的tensorflow代码的理解

4 R-FCN 2016

R-FCN详解

![]()

4 FPN(Feature Pyramid Network) 2017

FPN详解

![]()

5 Mask-RCNN 2017, Kaiming He

三个分支:分类+位置回归+增加一个mask分支进行实例分割

RoI Align 替代了ROI pooling

https://blog.csdn.net/wangdongwei0/article/details/83110305

![]()

6 RefineDet 2018

RefineDet算法笔记

two stage和one stage 的结合。

两个模块:ARM(anchor refinement module): 类似于RPN生成proposal,生成refined anchor boxes

ODM(Objective Detection Module):基于ARM的boxes,融合不同层的特征,做分类和回归

![]()

7 Cascade RCNN 2018

将RCNN级联,四个stages,一个RPN,3个RCNN。改变proposal的分布,使经过每个stage之后大于IOU的样本数增加。这样detector训练设置的IOU逐渐增加时,0.5,0.6,0.7,就不会造成正样本数量的减少,避免过拟合。

Cascade R-CNN论文阅读笔记

One Stage:

1 YOLO1

google ppt

将检测定位与分类融合:

结构:GoogLeNet 修改(将inception module 替换为1x1和3x3卷积)

细节:图片分为7X7个网格,每个网格有c个类条件概率(所有类别---是否包含物体的中心),以及两个边界框:每个候选框有5个参数x,y,w,h,confidence。confidence=P(obj)*IOU 置信度confidence计算时同时考虑了物体的存在的可能性和边界框与ground truth的重叠度。

YOLO1学习笔记

2 Light Head RCNN

Faster RCNN: RPN生成ROI+Feature Map——>ROI Pooling——>global average pooling——>fc+fc

(每个ROI都要经过RCNN subnet,计算量大速度慢;Global Pooling 导致位置信息损失)

R-FCN :ROI 的position-sensitive-score-map+feature map——>ROI pooling——>global average pooling

(仍然存在位置信息损失;score map维度太大,速度也慢)

Light Head RCNN: ROI(NMS减小overlap)的score map(Large separable convolution技术)+feature map—>ROI pooling—>2048fc+fc+fc

ROI 生产时利用NMS减小overlap;

score map的维度降低(class=10,10*P*P)(相比于Faster,不用每个ROI都经过RCNNsubnet,相比于R-FCN,scoremap维度降低);

Large separable convolution: 借鉴inception思想,用1xk 和kx1 代替k x k,分两边卷积,然后padding融合,size不变的feature map

Light head rcnn 论文解读![]()

3 YOLO v2

目标检测|YOLOv2原理与实现(附YOLOv3)

相比v1提高了训练图像的分辨率;引入了faster rcnn中anchor box的思想,对网络结构的设计进行了改进,输出层使用卷积层替代YOLO的全连接层,联合使用coco物体检测标注数据和imagenet物体分类标注数据训练物体检测模型。

具体改进:

Batch Normalization、High Resolution Classifier、Convolutional With Anchor Boxes、Dimension Clusters、New Network: Darknet-19、Direct location prediction、Fine-Grained Features、Multi-Scale Training

YOLO9000?

提出了一种联合训练方法,能够容许同时使用目标检测数据集和分类数据集。使用有标记的检测数据集精确定位,使用分类数据增加类别和鲁棒性。

4 YOLO v3

文章

YOLOv3 深入理解

提高了对小目标物体检测的精度;适合多标签分类任务

改进:

新的网络结构:Darknet-53

新的分类器:Logitic替代了softmax,适合多标签分类

多尺度特征提取并融合:3种尺度的featuremap,每种尺度用三种尺度的anchor box,同样要聚类。

YOLO系列总结:

https://www.cnblogs.com/makefile/p/YOLOv3.html