吴恩达机器学习(四)过拟合与正则化

1. 过拟合问题

(The Problem of Overfitting)

到现在为止,我们已经学习了线性回归和逻辑回归这两种学习算法,它们能够有效地解决许多问题,但是当将它们应用到某些特定的机器学习应用时,会遇到 过拟合(over-fitting)的问题,可能会导致学习效果很差。

1.1 回归问题中的过拟合

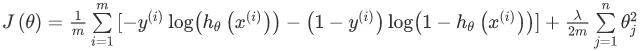

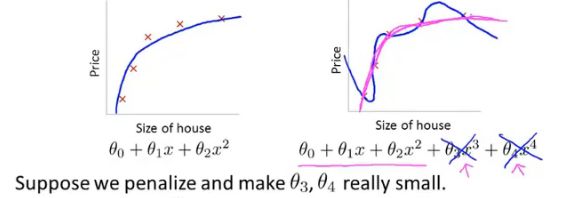

下图是一个回归问题的例子,如果我们有非常多的特征,我们通过学习得到的假设可能能够非常好地适应训练集(代价函数可能几乎为0),但是可能会不能推广到新的数据。

-

第一个模型是一个线性模型,欠拟合(under-fitting),具有较大偏差(high bias)不能很好地适应训练集;

-

第三个模型是一个四次方的模型,过于强调拟合原始数据,而丢失了算法的本质:预测新数据。虽然能非常好地适应训练集,但在新输入变量进行预测时效果表现的很差,是 过拟合(over-fitting);

-

中间的模型似乎最合适。

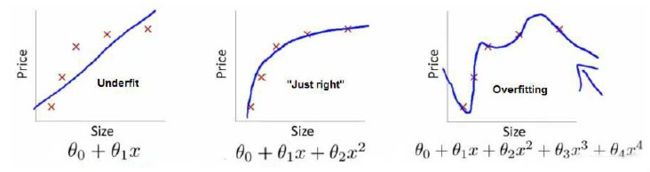

1.2 分类问题中的过拟合

分类问题中也存在这样的问题:

就以多项式理解, x x x 的次数越高,拟合的越好,但相应的预测的能力就可能变差。

就以多项式理解, x x x 的次数越高,拟合的越好,但相应的预测的能力就可能变差。

1.3 过拟合的解决方法

- 丢弃一些不能帮助我们正确预测的特征。可以是手工选择保留哪些特征,或者使用一些模型选择的算法来帮忙(例如PCA)

- 正则化(Regularization)。 保留所有的特征,但是减少参数的大小。

2. 正则化

(Regularization)

以回归问题中的过拟合为例,假设过拟合的模型是:

h θ ( x ) = θ 0 + θ 1 x 1 + θ 2 x 2 2 + θ 3 x 3 3 + θ 4 x 4 4 h_\theta(x)=\theta_0+\theta_1x_1+\theta_2x_2^2+\theta_3x_3^3+\theta_4x_4^4 hθ(x)=θ0+θ1x1+θ2x22+θ3x33+θ4x44正是高次项导致了过拟合的产生,所以如果我们能降低这些高次项的权重,即让其系数越小的话,模型就能很好的拟合了。

我们要做的就是在一定程度上减小这些参数的值,这就是正则化的基本方法。

要减少 θ 3 \theta_3 θ3 和 θ 4 \theta_4 θ4 的大小,可以通过修改代价函数,在其中 θ 3 \theta_3 θ3 和 θ 4 \theta_4 θ4 设置一点惩罚,例如:

min θ 1 2 m [ ∑ i = 1 m ( h θ ( x ( i ) ) y ( i ) ) 2 + 1000 θ 3 2 + 1000 θ 4 4 ] \mathop{\text{min}}\limits_{\mathcal{\theta}}\frac{1}{2m} \left[\sum_{i=1}^{m} (h_\theta(x^{(i)})y^{(i)})^2+1000\theta_3^2+1000\theta_4^4\right] θmin2m1[i=1∑m(hθ(x(i))y(i))2+1000θ32+1000θ44]

这样做的话,我们在尝试最小化代价函数时也需要将这个惩罚纳入考虑中,并最终导致选择较小一些的 θ 3 \theta_3 θ3 和 θ 4 \theta_4 θ4,对预测结果的影响就比之前要小许多。

如我们有非常多的特征,我们并不知道其中哪些特征要惩罚,那么将对所有的特征进行惩罚,并且让代价函数最优化的软件来选择这些惩罚的程度。这样的结果是得到了一个较为简单的能防止过拟合问题的假设:

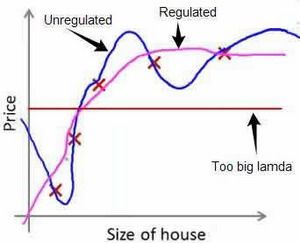

J ( θ ) = 1 2 m [ ∑ i = 1 m ( h θ ( x ( i ) ) y ( i ) ) 2 + λ ∑ j = 1 n θ j 2 ] J(\theta)=\frac{1}{2m} \left[\sum_{i=1}^{m} (h_\theta(x^{(i)})y^{(i)})^2+\lambda\sum_{j=1}^{n}\theta_j^2\right] J(θ)=2m1[i=1∑m(hθ(x(i))y(i))2+λj=1∑nθj2]其中 λ \lambda λ 又称为正则化参数(Regularization Parameter)。 注:根据惯例,我们不对 θ 0 \theta_0 θ0 进行惩罚。经过正则化处理的模型与原模型的可能对比如下图所示:

如果选择的正则化参数 λ \lambda λ 过大,则会把所有的参数都最小化了,导致模型变成 h θ ( x ) = θ 0 h_\theta(x)=\theta_0 hθ(x)=θ0,也就是上图中红色直线所示的情况,造成欠拟合。

为什么增加一项 λ ∑ j = 1 n θ j 2 \lambda\displaystyle\sum_{j=1}^{n}\theta_j^2 λj=1∑nθj2 可以使 θ \theta θ 的值减小呢?因为如果我们令 λ \lambda λ 的值很大的话,为了使代价函数尽可能的小,所有 θ \theta θ 的值(不包括 θ 0 \theta_0 θ0)都会在一定程度上减小。

所以对于正则化,我们要取一个合理的 λ \lambda λ 值,这样才能更好的应用正则化。

2.1 正则化的线性回归

(Regularized Linear Regression)

对于线性回归的求解,之前推导了两种学习算法:

- 一种基于梯度下降

- 一种基于正规方程

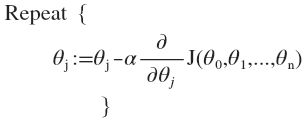

2.1.1 基于梯度下降的正则化

正则化线性回归的代价函数为:

J ( θ ) = 1 2 m [ ∑ i = 1 m ( h θ ( x ( i ) ) y ( i ) ) 2 + λ ∑ j = 1 n θ j 2 ] J(\theta)=\frac{1}{2m} \left[\sum_{i=1}^{m} (h_\theta(x^{(i)})y^{(i)})^2+\lambda\sum_{j=1}^{n}\theta_j^2\right] J(θ)=2m1[i=1∑m(hθ(x(i))y(i))2+λj=1∑nθj2]如果我们要使用梯度下降法令这个代价函数最小化:

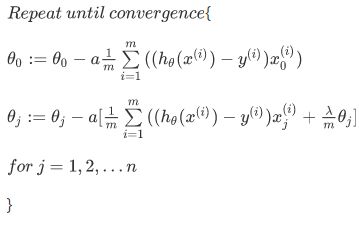

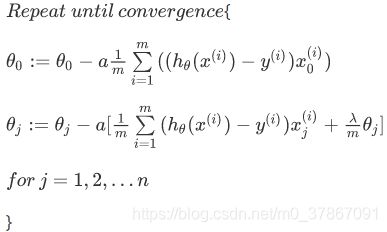

因为我们未对 θ 0 \theta_0 θ0进行正则化,所以梯度下降算法将分两种情形:

因为我们未对 θ 0 \theta_0 θ0进行正则化,所以梯度下降算法将分两种情形:

对上面的算法中 j = 1 , 2 , . . . , n j=1,2,...,n j=1,2,...,n 时的式子进行调整可得:

对上面的算法中 j = 1 , 2 , . . . , n j=1,2,...,n j=1,2,...,n 时的式子进行调整可得:

![]()

可以看出,正则化线性回归的梯度下降算法的变化在于:每次都在原有算法更新规则的基础上令 θ \theta θ 值减小到原来的 ( 1 − α 1 m ) (1-\alpha\frac{1}{m}) (1−αm1) 倍,通常学习率 α \alpha α 很小,样本数量 m m m 很大,因此 ( 1 − α 1 m ) < 1 (1-\alpha\frac{1}{m})<1 (1−αm1)<1

2.1.2 基于正规方程的正则化

已知正规方程可以求出使代价函数取得最小值的 θ \theta θ:

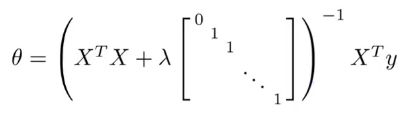

θ = ( X T X ) − 1 X T y θ=(X^TX)^{-1}X^Ty θ=(XTX)−1XTy加入正则化后,正规方程变为:

并且当 λ > 0 \lambda>0 λ>0 时,括号内的矩阵一定是可逆矩阵,因此运用正则化还可以解决某些情况下矩阵 X T X X^TX XTX不可逆的问题。

并且当 λ > 0 \lambda>0 λ>0 时,括号内的矩阵一定是可逆矩阵,因此运用正则化还可以解决某些情况下矩阵 X T X X^TX XTX不可逆的问题。

2.2 正则化的逻辑回归

(Regularized Logistic Regression)

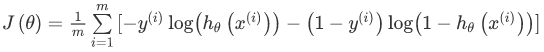

逻辑回归的代价函数为:

要最小化该代价函数,通过求导,得出梯度下降算法为:

注:看上去同线性回归一样,但是知道 h θ ( x ) = g ( θ T X ) h_θ(x)=g(\theta^TX) hθ(x)=g(θTX) ,所以与线性回归不同。

参考:

斯坦福大学2014机器学习教程中文笔记目录