量化论文不可复现是人品问题,赚不赚钱不是评价它的标准!

量化投资与机器学习微信公众号,是业内垂直于量化投资、对冲基金、Fintech、人工智能、大数据等领域的主流自媒体。公众号拥有来自公募、私募、券商、期货、银行、保险、高校等行业30W+关注者,连续2年被腾讯云+社区评选为“年度最佳作者”。

量化投资与机器学习公众号撰写

QIML观点

学术论文,研究报告,纵观其有各种各样的问题。作为Quant,对这些原材料的甄别、提炼及加工,本身就是工作的一部分。

研究需要有主线,策略需要有逻辑,沿着这条主线及逻辑,在不同的(甚至是不同领域的)论文去吸收新颖的方法及技巧,整合到自己的研究逻辑中。这才是Quant需要做的。

论文不可复现(甚至学术造假)是人品的问题,但赚不赚钱不是评价量化论文的标准。

只要论文中的假设及实证能对我们带来一些启发,这就是一篇有用的论文。即使前面是一滩浑水,我们Quant也唯有不断前进。

不能复现就是耍流氓

最近,杜克大学金融学杰出教授,Research Affiliates 合伙人,Man Group投资策略顾问Campbell R. Harvey在论文《The Pitfalls of Asset Management Research》里写道:

In my 35 years as an academic, as an advisor to many asset management companies, and as an editor of one of the top academic journals in finance, I now fully appreciate the crucial importance of the role incentives play in the production of research.

激励问题,加上统计方法的误用,导致了一个不幸的结论:即金融领域大约一半的实证研究结论可能是错误的!

Campbell R. Harvey

2020年,The Journal of Portfolio Management (简称:JPM)将年度Quant大奖颁发给了Campbell R. Harvey,表彰其在量化投资组合理论领域的杰出贡献。

Harvey博士提出了利率期限结构可以作为美国商业周期的领先指标的概念。此外,Harvey博士也扛起了遏制金融文献中普遍存在P-hacking(数据操纵)*行为的大旗,这个问题不能再被否认或忽视。

*我们在统计时经常用到P值,一般认为P≦0.05有统计学意义。但是现在很多统计学家并不是这样认为,对于P值的滥用和误用进行了苛刻的批评。因此出现了一个新词:P-hacking。

P-hacking 最早应该是美国宾夕法尼亚大学的Simmons和他的团队提出来的,Simmons等人也对P-hacking进行了定义:

P-hacking refers to the practice of reanalyzing data in many different ways to yield a target result. They, and more recently Motulsky, have described the variations on P-hacking, and the hazards, notably the likelihood of false positives—findings that statistics suggest are meaningful when they are no.

P-hacking 按照字面的意思来看是「P值黑客],但是实际上的意思科研动力认为是「P值篡改」或者「P值操纵」。P-hacking是科研人员不断的尝试统计计算直到p<0.05,当然有时这可能是无意识的。

回到主题。根据Harvey的统计,自20世纪60年代以来,有超过400种因子被发表在顶级期刊上,其中大约有一半是在过去10年中发现的。这些因子大概可以归类为规模、波动性或估值等应用于股票市场,并被认为能够跑赢市场。

来源: A Census of the Factor Zoo

Harvey表示,许多在paper看起来很有希望的因子在现实生活中都不起作用,有多少因子可以令人信服?

石川博士也曾写过一段话:

不论是什么领域,如果一篇学术论文提出的模型和得出的结论不能被其他学者或业界复现,那发表这样的文章就无异于耍流氓。

是的,在我们的研究中,存在着诸多人为和理论的影响因素,我们着重以下几个点进行阐述。

晋升与加薪

研究者需要发表文章以获得晋升并获得更高的报酬。他们意识到他们需要提供“Positive”的结果。为了得到“Positive”的结果并获得统计显著性,研究者采用了各种数据挖掘策略,虽然从原则上讲, 如果以高度纪律的方式进行数据挖掘并没有什么错,但通常他们并不是按照纪律进行的。他们可能会选择不同的样本开始日期或排除某些可能降低结果强度的影响期。

这里会涉及到P-hacking(数据操纵)行为,下面的内容也会讲到。

但是通过上面的骚操作,编辑、同行评审、读者和投资者很难察觉。例如,如果一个研究人员尝试了100个变量,但是最终只选择了最重要的一个,那这就是不当的研究行为。如果读者知道研究人员尝试了100个变量,他们也会知道大约5个变量纯粹是偶然出现的。

这个观点其实埃隆·马斯克也说过,那是在2013年可汗学院的一个采访上。

马斯克说:大多数学术论文都毫无价值!究竟有多少PhD论文被人真正用过?

针对这个问题。其实目前在业界与学界引起了大家的广泛讨论。

在Quora上,工程师副总裁Xavier Amatriain针对这问题的回答比较中肯:作为多篇论文的作者以及审稿人,Amatriain 表示:“现行的学术体系并不以提升‘实用性’为基础,一旦接受了这一设定,那么多数论文无用(useless)就毫不奇怪了……至少 useful 的部分定义是如此。” Amatriain 继续说,学术论文主要从是否有新意(novelty)、有意义(significance)和有多少原创性(originality)这几个方面考量。所以,在评论一篇学术论文的时候,真正应该问的是:这篇论文对这届学术论文是否有意义,而非问这篇论文是否对全人类有意义。

研究动机

模型是否有可靠的经济含义解释?

在进行研究之前是否存在经济解释或假设?

实证研究经常为理论的发展提供基础。考虑实验物理学和理论物理学的关系。实验物理的研究人员测试并检验现有理论。理论物理学家经常利用实验物理的结果来建立更好的模型。这一过程与科学方法的概念是一致的。提出了一个假设,实证检验试图寻找与假设不一致的证据,即所谓的可证伪性。

这个假说提供了一个规则,可以减少过拟合的机会。重要的是,这个假设需要有一个逻辑基础。例如,下图中的alpha-bet多空交易策略没有任何理论基础,更不用说先验假设了。

这个策略令人难以置信!

基于数据挖掘的股票策略:基于股票代码中的字母形成投资组合。

A(1)-B(1)表示:做多所有以“A”为首字母的股票,做空所有以“B”为首字母的股票,等权。下图的策略考虑了股票代码前三个字母的所有组合,表示为S(3)-U(3),效果却出奇的好

大家也可以尝试一下大A股,看看有没有类似的效果~

虽然这看起来很荒谬,但这在数据挖掘和机器学习中有重要的借鉴意义。

研究人员在没有事前经济假设的情况下开始实证调查,从而引发未来的问题。首先,如果没有事先的经济假设,就连考虑模型或变量都是低效的。其次,无论结果如何,如果没有一个可靠的经济含义解释,研究人员将模型应用到真实交易时,失效的可能性会很大,这是机器学习的缺点之一。

另一个微妙之处在于: 在医学等其他学科中,研究人员往往没有一个预先指定的理论,而数据探索在塑造未来的临床试验中至关重要。这些试验为研究人员提供了真正的样本外数据。在金融和经济领域,我们没有条件去创建一个大规模的样本外测试。因此,将这种探索性方法在金融和经济领域是危险的。我们可能不会危害客户的健康,但我们会危害他们的财富。这与机器学习方法尤其相关,机器学习方法是为数据更丰富的学科开发的。

数据和样本选择

筛选来的数据是否有意义?如果有其他数据,排除这些数据是否有意义?

研究人员是否采取措施确保数据的完整性?

数据转换(标准化)有意义吗?它们是提前选定的吗?最后结果是否对这些转换中的细微变化具有鲁棒性?

如果异常值被排除,排除规则是否合理?

如果数据被winsorized(处异常值的一种方法),是否有很好的理由这样做?winsorization规则是在研究开始前选定的吗?是否只尝试了一种winsorization规则(而不是很多)?

训练样本需要事先验证。研究开始后,样本不应该改变。例如,如果样本开始于1970年,假设模型有效,但如果样本开始于1960年,这种情况下,模型就不起作用了。一个极端的例子是删掉全球金融危机、科技泡沫或1987年的市场崩溃的数据,因为它们损害了模型的预测能力。研究人员不能篡改数据,使模型工作!

确保数据质量。有缺陷的数据会使研究人员误入歧途。对数据的任何统计分析都只取决于输入数据的质量,垃圾进,垃圾出!特别是在某些试图捕捉非线性的机器学习应用中。考虑到现在数据集的规模,在使用机器学习技术开发投资模型之前对数据进行清理是至关重要的!

对输入数据进行清洗(例如标准化)需要被记录下来,最好提前决定选用哪种。此外,结果是否对这些转换中的细微变化具有鲁棒性?例如,给定10个不同的volatility scaling去选择,如果研究人员选择的是表现最好的那个,这就是一个危险信号。

不要随意排除异常值。异常值是模型的有影响力的观测值。包含或排除有影响力的观测结果可以决定模型的成败。理想的情况是,在估计模型之前,应该为排除提供一个可靠的经济理由。一般来说,任何有影响力的值都不应该被删除。假设观测是基于有效数据,模型应该解释所有的数据,而不仅仅是被选量的观测。

在建立模型之前选择Winsorization级别。经过筛选的数据在某个阈值被截断(例如,将截断异常值到1%或2%的尾部),而不是被删除。Winsorization是一个有用的工具,因为异常值可以对任何模型产生巨大的影响。但是,在构建模型之前,应该先决定是否进行筛选,以及筛选的级别。一个错误研究的明显标志是,模型在5%的Winsorization上有效,但在1%的上失败,然后选择5%。

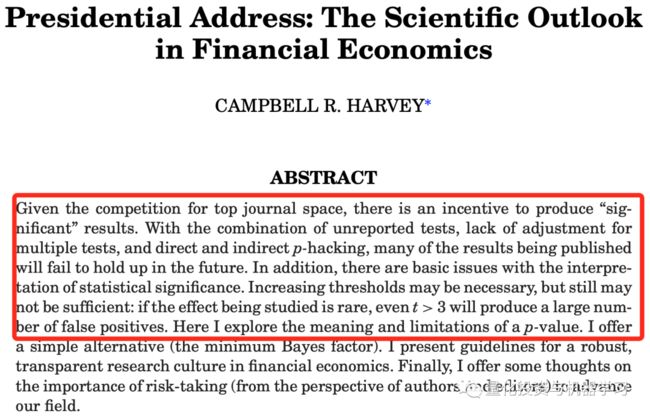

在2017年,Harvey在美国金融协会(AFA,American Finance Association)做的题为《The Scientific Outlook in Financial Economics》的主席演讲中,有一段演讲:“为了在期刊上发表文章,人们有一种强烈的诱惑,就是“折磨”这些数据,直到它们“供认不讳”——也就是说,进行一轮又一轮的测试,寻找一个可以声称具有统计学意义的发现”。

Harvey告诫大家:“我们不是推销员。我们是科学家!”

没有假设就难受

发表一篇没有“重大”结果的论文是很困难的。如下图所示,很少有金融领域的出版物提出所谓的negative结果(即不“支持”零假设的结果)。

“支持”假设的论文比例,在金融领域的学术期刊上发表的大约占90%

多重检验和统计方法

金融领域更有可能忽略多重检验问题。其他领域已经发现,为了控制多重检验,标准误差需要被夸大。也就是说,第 400 个因子“发现”的t值需要高于第一个因子。所以我们要思考一下的问题:

研究人员是否有跟踪所有尝试过的模型和变量(包括成功的和不成功的),是否意识到多重检验的问题?

如果使用了互动变量,是否对所有可能的互动变量进行了完整的统计?

研究人员是否检验了列出的所有变量,还是一旦找到一个好的模型,他们就立即停止了研究?

给定20个随机选择的策略,其中一个可能由于偶然因素而超过2Sigma阈值(t统计量2.0或以上)。因此,如果测试了多个策略,那么2.0的t统计量就不是一个有意义的基准。跟踪尝试过的策略的数量是至关重要的,同时也要衡量它们之间的相互关系。对于相对不相关的策略,则采用更大的阈值惩罚。例如,如果测试的20个策略相关度接近1.0,那么这个过程相当于只尝试一个策略。

假设研究人员从20个变量开始,并通过一些互动变量(变量1 x变量2)和(变量1 x变量3)进行实验。这种单一的互动不会转化为22个测试(最初的20个,加上两个额外的互动变量),而是转化为190个可能的互动。

另一种考虑这个问题的方法是假设(在一个单一的环境中)研究人员编制了一个包含20个变量的列表来测试预测能力。第一个研究人员只做了一个测试就停止了,因为他发现了第一个变量就是有效的。可运气太好了。另一个研究人员也他有相同的20个变量,却以不同的顺序进行测试,只有最后一个变量有效。在这种情况下,2sigma的发现将被丢弃,因为对于20种不同的测试,2sigma的阈值太低了。

这也回到了我们前面说的,晋升与加薪问题。不同的学术机构有不同的激励措施。最好的学校不仅仅计算教员的出版物数量。 这些学校也在寻找能够产生持久影响的出版物。刚才说到,如果一个研究人员尝试了100个变量,但是最终只选择了最重要的一个,但不太可能产生持久的影响,因为结果可能只是侥幸,进 一步的研究将揭示其脆弱性。然而,绝大多数的学术机构只计算出版物的数量, 以便做出提升的决定。

这些情况表明了一个重要的教训:同行评议的论文比非同行评议的论文更值得信任,但对同行评议论文的怀疑也是有道理的!

金融领域的复制危机

关于金融领域的复制危机,Harvey几年前就 开始了这场争论:一个新的因子需要清除一个更高的障碍,t值大于3.0。大多数声称金融经济学的研究结果可能是错误的。”

虽然我们的声明是带有挑衅的,但其他领域已经得到了类似的认知。尤其是在2005年,在医学领域, Ioannidis(2005)在他具有里程碑意义的论文中断言:“大多数已发表的研究成果都是错误的。”

大部分原因是研究人员在发表具有统计学意义的结果之前进行了大量的试验。或者在试验过程中改变不同的参数。这就是所谓的The garden of forking paths,并不总是经过深思熟虑的。

在过去的几年里,一些金融数学领域的一些学者已经注意到困扰大家的回测过拟合问题。例如,下面这篇在2016年发表的论文阐述了这个问题:

为什么在理论上看起来不错的策略往往在实践中表现不佳,是因为回测中那些看起来牛逼轰轰的表现往往不会在实际应用中继续重现。

沿着这条线,在下面这篇论文中:

论文表明:基于回测,可以很容易地实现任何预期的目标。比如10年或更长时间内每月增长1%。然而,当呈现新的数据时,它们总是被证明是禁不住考验的。至少,完全不能复制当初所宣称的目标。

如今,随着算力与程序化技术的兴起,情况更加恶化了!

为一个策略生成千上万、数百万甚至数十亿的组合权重或参数已经变得越来越简单。正如这篇论文所提到的:

Marcos Lopez de Prado、Michael Lewis在回顾了上述以及该领域其它的最新发展后,遗憾地得出结论:从业者和学者发现的大多数投资策略都是错误的!

同样,Marcos Lopez de Prado在2018年《福布斯》采访Brett Steenbarger时,也从以下几个方面讨论了这种情况:

假设一家制药公司开发了1000种药物,并在1000组志愿者身上进行测试。当有几十种测试证明“显著性”的几率为0.05时,这些药物就被当作有效的治疗方法开始销售了。病人们相信这些“科学测试”,纷纷涌向这些新的药物。结果却发现,由于药物并没有带来预期的效果,他们的病情反而恶化了。一些消费者病得很厉害,有些人甚至死亡。

显然,这种欺骗行为会引起公众的强烈抗议。事实上,这正是我们有一个监管机构和法律来帮助确保药物在向公众提供之前经过了适当的测试的原因。但金融消费者却得不到这样的保护,使他们容易受到未经验证投资策略的影响。这些假阳性结果尤其具有误导性,因为它们是由一群具有专业研究背景的人所推动的,而这些研究人员并没有使用必要的科学工具来发现这些虚假的结果。

Fama将有效市场定义为:如果资产价格完全反映了可得的信息,则市场有效。而在随后的研究中,众多异常收益现象(Anomalies)被发现,即持有具有某种特征的股票在未来会获取超额收益。

为了更好地评估金融领域的可复制性状态,Kewei You、Chen Xue、Lu Zhang发表了一篇关于金融领域异象指标复制的论文:

在Lu Zhang教授的论文中,基于美国市场数据,对447种异常收益现象进行了研究(考虑到变量定义的唯一性,实际有大约220种异常收益变量)。结果表明,将T值为2作为阈值时,约64%的异常收益组合收益是不显著的;将阈值提高至3时。约85%的异常收益组合收益是不显著的。也就是说,尽管已有文献记录了众多样本期内有效的因子,但当对其进行复制时,该因子有效性或丧失、或减弱。

论文最后指出:投资者必须对研究结果自己动手进行复制与回测,所谓“信任但要验证”。对任何感兴趣的研究成果,都需要在研究团队反复独立测试验证后才相信,对学术研究结果反复测试检验是很有必要的。科学文献自我纠正的机制是有限的,一般也只会纠正最重要研究成果的偏差。

大部分基于流动性的变量基本只在微盘股有效,即使用等权重,交易摩擦因子的复制成功率也只有不到40%。因此这个类别因子的有效性值得怀疑。我们并不是说流动性、交易微观结构和其他交易摩擦变量(例如交易费)在实践中不重要,而是就驱动股票获得超额收益的因子而言,交易摩擦远远没有价值、动量、投资和盈利因子重要。

其他一些众所周知的异象指标,作者无法复制,包括:

the Bhandari (1988) debt-to-market; the Lakonishok-Shleifer-Vishny (1994) five-year sales growth; the La Porta (1996) long-term analysts’ forecasts; several of the Abarbanell-Bushee (1998) fundamental signals; the O-score and Z-score studied in Dichev (1998); the Piotroski (2000) fundamental score; the Diether-Malloy-Scherbina (2002) dispersion in analysts’ forecasts; the Gompers-Ishii-Metrick (2003) corpo- rate governance index; the Francis-LaFond-Olsson-Schipper (2004) earnings attributes, including persistence, smoothness, value relevance, and conservatism; the Francis-LaFond-Olsson-Schipper (2005) accrual quality; the Richardson-Sloan-Soliman-Tuna (2005) total accruals; the Campbell-Hilscher-Szilagyi (2008) failure probability; and the Fama-French (2015) operating profitability.

有人担心,尽管Kewei You、Chen Xue、Lu Zhang引用了一些多重检验统计数据,但考虑到他们的研究范围,可能没有完全弥补这一现象。但这意味着,如果有什么区别的话,那么他们的研究结果是相对保守的。在他们的研究中,统计上可以复制的指标甚至更少,或者仅在非常有限的统计可信度下才可复制。

更重要的是应该记住,张教授他们的数据只持续到2016年。从那时起,全球市场上基于大数据的程序化交易大幅度增加,这也很可能意味着,一些曾经有重大价值的异象指标不再有效!

2016年,Harvey、Liu、Zhu的一项研究表明:他们分析了296篇已发表的论文中的异象,发现80至158篇(高达53%)可能是错误发现。

作者认为,该领域的一种基本结构性结构偏差可能是罪魁祸首:尽管复制研究经常出现在大多数其他科学领域的顶级期刊上,但这类研究很少在金融和经济领域发表。换句话说,人们普遍倾向于发表新的结果,而不是严格地验证之前的结果。

美国金融协会前任主席Campbell R. Harvey也注意到了这类问题:

https://faculty.fuqua.duke.edu/~charvey/Research/Published_Papers/P131_The_scientific_outlook.pdf

由于复制性研究和其他没有报告显著新结果的研究往往产生较少的引用,这类论文不太可能发表。另一方面,Harvey注意到研究人员也会造成发表偏见,摸清了期刊对有重大新结果的论文的套路,作者可能不会提交只有边缘结果的论文。这种偏见在其他领域被称为“file drawer effect”。发表偏见也可能是由于作者在期刊提交的论文中精心挑选最重要的结果引起的,这是P-hacking的一种形式。

当然也有最新的一些研究表面有不一样的观点:

Theis Jensen,Bryan Kelly 和 Lasse Pedersen 在2021年3月发表的一篇论文《 Is There a Replication Crisis in Finance? 》,他们使用贝叶斯方法研究了论文中的因子是否能复现的问题,并得出结论:

大多数因子确实是可以复现,而且在样本之外,在全球市场都表现出了一致性。

虽然有一小部分因子未能复现,但整体表现并没有大家认为的那么糟糕。

使用他们的贝叶斯方法,复现的成功率(超额收益在统计上显著)是85% ,而且这个结果在美国和全球数据都是一致的。

近期,美联储高级经济学家Andrew Chen及科隆大学教授Tom Zimmermann一篇工作论文《Open Source Cross-Sectional Asset Pricing》中,详细整理总结了过去关于资产定价的学术文献中提及的319个因子,并进行复现及测试。测试的数据及代码也在Github中开源,主要代码由Stata、R及SAS完成,他们根据原始出处的因子有效性的测试结果,作者将因子分为了以下四大类:

Clear Predictor:long-short收益在统计上非常显著,总计161个

Likely Predictor:long-short收益在统计上比较显著,总计44个

Not-Predictor:long-short收益在统计上不显著,总计14个

Indirect Signal:需与其他结合、或要做一些修改后才有预测性,总计100个

通过他们自己的测试,他们发现只有三个因子的测试结果与原论文不一致。对于原论文中的Clear Predictor和Likely Predictor(共205个),作者对原文测试结果的t-value与复现后的t-value进行了回归,结果如下图,可以看出复现的结果和原论文非常接近。,t 统计数据的斜率为0.90,r 平方为83% :

Chen 和 Zimmerman 还解释说,一些论文发现失败率更高的原因是他们对因子的分类错误。Kewei Hou, Chen Xue, and Lu Zhang (HXZ) 在《Replicating Anomalies》中研究了452个因子,实际上一共只有240各因子,其中212个是这240个不同持仓期。而且在这240个因子中,只有118在统计学上显著。但实际上,Chen 和 Zimmerman发现在HXZ认为无效的因子中,在原论文中就没有本身就没有进行多空收益统计显著性的测试。但对于研究公布后效果衰减的问题,他们的结论与McLean and Pontiff (MP)的高度一致,特别是对于样本内效果非常优秀的因子来说,发表后效果下降的更为明显。

需要注意的是,Chen 和 Zimmerman的复现并没有解决因子可投资性的问题,正如论文《A Taxonomy of Anomalies and Their Trading Costs 》和《Zeroing in on the Expected Returns of Anomalies》发现的那样,考虑了交易成本,如买卖价差之后大部分有效的因子也变得无效了,并不能带来真正的收益。所以因子的可投资性,也是因子研究中非常值得关注的问题。

该项目还有一个网站,用于更新项目的最新动态:

https://www.openassetpricing.com/

交叉验证

研究人员是否意识到真正的样本外测试只有在真实交易中才可能?

是否有适当的步骤来消除样本外“迭代”的风险(即样本内模型后来被修改以适应样本外数据)?

样本外分析是否代表真实交易?例如,是否考虑了交易成本和数据修正?

一个资产管理人,如果能说自己开发除了一套可以预测市场走势的系统,那应该是非常牛x的事了,肯定可以吸引无数的投资人。想必大家都曾在追寻“如何预测市场走势”的道路上有过类似的经历。

Goyal和Welch在2008年发表的一篇论文《a Comprehensive Look at the Empirical Performance of Equity Premium Prediction》中,测试了N多种预测股票未来超额收益的方法,最后不尽感叹道:

“Our article comprehensively reexamines the performance of variables that have been suggested by the academic literature to be good predictors of the equity premium. We find that by and large, these models have predicted poorly both in-sample (IS) and out-of-sample (OOS) for 30 years now; these models seem unstable, as diagnosed by their out-of-sample predictions and other statistics; and these models would not have helped an investor with access only to available information to profitably time the market.”

“...我们发现大部分的模型在样本内和样本外的表现都非常差;这些模型样本外的预测结果非不稳定了;这些模型没有办法帮助只有有限信息的投资人去预测股票市场。”

针对这个问题,我们从几个方面考虑:

Harvey在文章中说到,学术论文忽略了如交易成本等因素,这些成本可能是显著的。一个潜在有用的测试小组是新推出的 ETFs。许多新的ETF都声称是基于发表在最优秀DE 学术期刊上有同行评议研究。但很少有投资者意识到,同行评审的研究可能已经被P-hack或过度拟合到这样的程度,结果不太可能重复出样本。

Chris Brightman、Feifei Li、Xi Liu在2015年的一篇名为《Chasing Performance with ETFs 》的文章就论证了这种情况。

上图展示了所有ETF的市场调整收益率。回测的收益率是强劲的。然而,在向美国证券交易委员会提交申请并随后推出ETF之后,该EFT收益率为零。这种结果与过拟合/P-hacking行为是一致的。

Mclean、Pontiff 在16年的一篇名为《Does Academic Research Destroy Stock Return Predictability?》的论文说到:如果策略额外收益或者可预测性仅存于学术研究所覆盖的样本内,另一个可能的原因是统计偏差。

总之,统计偏差也会让策略在样本外的表现减弱。因此,我们需要在控制统计偏差的基础上来研究学术研究的发表效应。

作者通过研究97个long-short strategy发现,将学术文章所用的样本和学术文章样本之外的策略收益对比,策略收益平均减少26%,因此作者说26%就是平均意义上统计偏差的上界。(这个认识在好几个方面都不是很严格,不过笔者认为在不能做重复实验的基础上,这样的认识是非常合理的。)

但是策略发表后,收益平均下降58%,显著大于统计偏差。因为,作者认为发表效应确实显著存在。

但上图与后一种解释不一致。如果一种策略确实产生了Alpha,ETF就不太可能率先收获 Alpha,而对冲基金更有可能率先介入。因此,我们可以预判在向证券交易委员会提交申请之前,ETF的回测会变得更加平坦,但这张图没有展示这一点。事实上,在向美国证券交易委员会提出申请的前一年, 这个斜坡是非常陡峭的。因此,实证与回测过拟合是一致的。

因此,你可以在没有交易成本的情况下进行所有这些学术研究,然后说不存在复制危机。那么样本外如何的确认呢?在Harvey看来,这是非常有利的佐证!

同时,对于预留出来的样本外数据,它们也是已经发生过的历史。尽管模型将它们视作样本外,但由于我们经历了那段历史,知道在那段时间市场是如何发展的(什么时候涨、什么时候跌),会不可避免的把领先变量和这些历史经验联系起来。正是由于这个原因,历史数据中并没有真正的样本外,只有实盘交易才是真正的样本外。

一个更好的样本外是基于新发现的历史数据,例如一些研究人员试图将美国基础数据的历史数据库回填到20世纪20年代(1920s)。可以合理地假设这些数据没有被挖掘,因为这些数据以前不是以机器可读的形式提供的。但是要小心。尽管以前没有这些数据,但资深的研究人员知道历史是如何发展的,宏观经济事件是如何与市场波动相关联的。对于那些精通市场历史的人来说,这些数据只是他们自身经验和塑造他们先验假设的样本。即使对那些知识不那么渊博的人来说,今天的传统智慧也是来自过去的事件。

在不同环境中应用该模型是个好主意,但应谨慎行事,因为各国之间都存在相关性。例如,一种数据挖掘的(可能是假的)异象在美国市场的某个特定样本上有效,在加拿大或英国的同一时间段内也可能有效,因为这些市场之间存在相关性。

假设一个模型在样本期内是成功的,但在样本期外失败了。研究人员发现,这个模型由于一个特定的原因而失败了。研究人员对初始模型进行修改,使其在样本中和样本外都能工作。这已经不再是一个样本外测试了。

石川博士之前写过一篇文章,也是针对这点做了一些自己的见解《所有历史数据都是样本内》:

我们构建策略靠的不是站在回测起点往后看的先见之明,而是站在回测终点往前看的后见之明。所有历史数据都是样本内。

1、Out of Sample is Not Really Out of Sample.

举个例子。在因子选股中,我们通常会用 PE、ROE、EPS 等指标来选股,并按照各种逻辑 —— 比如动量或者估值 —— 进行难如登天的因子择时。在择时的时候,我们会非常小心的使用滚动窗口外推,利用 point in time 数据来避免 look-ahead bias(前视偏差)。但无论是在全部回测期内多因子选股,还是使用滚动窗口在“样本外”做因子择时,这背后无法否认的事实是我们已经知道 PE、ROE、EPS 在过去整段历史时间内是有效的!

我们并不是在 10 年前就预见到了 PE、ROE、EPS 会有效并在过去的 10 年里使用它们;而是在已经知道市场在过去 10 年是如何展开的前提下,通过 empirical data analysis 找到了 PE、ROE、EPS 这些好使的因子然后再去对着它们回测。扪心自问一下,如果一个因子在回测期内的表现是近似随机的,我们会用它来做因子择时吗?这当然不是说它们并没有业务依据,而只是想强调正是因为历史已经发生了,因此它不是真正的样本外。

2、Iterated Out of Sample is Not Out of Sample.

在可交易特征方面,满足一个策略假设的样本其实很少。举个极端的例子,比如 A 股中追踪大牛市的趋势类策略。在过去 20 年中,也仅有三波牛市,而且它们表现出来的市场特征均不相同(比如以 2007 年大牛市构建的趋势追踪策略在 2015 年大牛市中的逃顶效果并不好)。在这种情况下,如果还把数据分成训练集和测试集会怎样呢?我们一定会把策略在测试集中的体现出来的新市场环境反馈到训练过程中,这已经违背了分训练集和测试集调参的本意;这等价于我们在整个历史数据中对策略的参数调优了。

来看一个简单的例子 —— 针对沪深 300 指数使用双均线择时。

假设使用 2005 年 1 月 1 日到 2011 年 12 月 31 日作为样本内数据;使用 2012 年 1 月 1 日到 2019 年 2 月 25 日为“样本外”数据。在样本内,使用 2 天窗口计算快均线、40 天窗口计算慢均线效果非常理想(下图),其年化收益率超过 30%,夏普率高达 1.3。

再来看看这组参数在“样本外”的表现。不幸的是,该策略在样本外的年化收益不到 8%、最大回撤 -25.95%、夏普率仅有 0.51。

如果对着“样本外”搜参数,则最优的快、慢均线窗口参数是 20 和 24,其夏普率也仅有 0.70,远远差于 2012 年之前的表现。考虑到这种情况,很自然的想法就是添加更复杂的逻辑来提高 2012 年之后的表现。显然,这不是样本外测试,而是过拟合。

无论从独立性还是可交易特征而言,交易数据其实都是十分匮乏的。从构建策略的角度来说,如果要求策略能够适应不同的市场状态,那么基于历史数据不断迭代的样本外并不是真正的样本外。

不要忽视交易成本。几乎所有在顶刊的paper忽略了交易成本。即使交易成本不高,许多已发表的异象在统计学上的“显著性”也基本上消失了。对历史数据的任何研究都需要在样本内和样本外分析中考虑交易成本和现实的不足。

从业研究者的风气

是否应该注重科研的质量,而不是仅仅寻求一个赚钱策略?

研究人员是否了解大多数测试将会失败?

研究的目标清晰吗(应该寻找有逻辑支撑的东西而不仅仅是有效的东西)?

一家公司的研究文化也强烈地影响着P-hacking可能性。

假设一家公司有两名高级研究员,我们称他们为A和B,他们都向CIO推销自己的想法,CIO认为这两个研究想法同样有前途。这项研究进行得非常仔细,没有P-hacking。最后,A的想法在回测中表现很好,B凉了。

OK,A的想法进入了实盘交易。

在上面的例子中,A和B都是同等级别的高级研究员。资产管理公司犯了一个很大的错误,如果A被提升或者获得额外的奖金,或者更糟糕的是,B被解雇了。这种待遇导致了一种功能失调的研究文化,在这种文化中,一项研究刚刚开始,A和B都意识到他们需要提供统计上“重要”的结果,以便在公司得到晋升,或者得到保留。他们可能通过开始数据挖掘和P-hacking来回应这些激励。

Harvey认为,在资产管理领域,P-hacking不像在学术界那么成问题,尤其是在作为产品初期的专有研究领域,这个问题更小。原因很简单:

首先,在收取绩效费的情况下,需要对资产管理公司的研究进行优化,使业绩可重复的机会最大化。这意味着资产管理公司不会选择表现最好的回测,因为这很可能是过度拟合和运气造成的。如果该基金经理推出一种回测过拟合的策略,它很可能会失败,而且不会产生业绩费。

第二个原因是声誉。如果一个资产管理公司的产品因为过拟合而表现不如人意,其投资者肯定会撤资。这种市场机制自然会最小化过拟合。资产管理公司仍然会做出大量低质量的研究。与学术研究类似,投资者也需要持怀疑态度。

如果资管行业奖励那些通过回测得出不错结果的研究,那么,我们就创造了一种不良的风气,这种风气会让一些人篡改数据,从而产生一个看似不错的策略。

Researchers should be rewarded for good science, not good results!

避免P-hacking

在你自己的研究中避免P-hacking的一个好的方法是:从一开始就对自己诚实。仔细考虑并记录你想要测试的所有内容。如果你想测试20个不同的因子,请在开始测试之前指定这些因子,并在评估指标时考虑所有20个因子。

同时,对学术研究和实践研究持怀疑态度。

但最重要的是,想想你自己的模型在做什么。神经网络有时被认为是黑箱,从某种意义上说,的确如此,但是你应该批判性地回顾每一步。如果你正在进行图像识别,请观察每一层的激活,大致了解该层的激活基于什么。如果你正在进行强化学习来玩游戏,看看你是否能够大致理解逻辑是如何工作的。如果你正在进行自然语言处理,请考虑与同义词、反义词和相关单词有关的词向量。

如果你在做股票市场分析,问问自己你真正想从模型中得到什么。为什么某些因子的第n个延迟是一个预测因子?为什么以前的收益会影响未来的收益?你为什么只考虑最近的N次收益?为什么要预测一个(每天、每小时、每分钟)的周期?你为什么要考虑从X到Y这段时间?为什么验证到Z?

将股票增量输入到一个递归神经网络中就可以达到减少损失的目的,但是有了解释,你也可以将这些值拟合到一个随机数生成器中。