现有的评分和排名算法

前言

在之前的文章「投票==公平???」中已经得到了一个令人沮丧的结论:只有道德上的相对民主,没有制度上的绝对公平。投票是对不同选项或个体的排序,在投票中我们关注更多的是相对位置这样定性的结论,例如:积分前三名的同学才能进入下一环节。但有的时候我们不光想知道不同选项之间的先后顺序,还想了解不同选项之间的差异大小,这时我们就需要设计更精细的方法进行定量分析。

基础评分和排名

直接评分

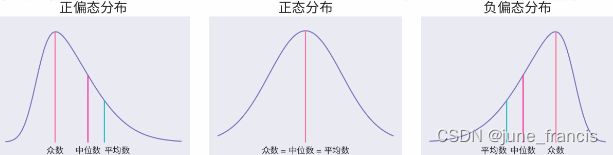

从小到大被评分最多的应该就是考试了,100,120 或是 150,这三个数字应该从小学一年级一直“陪”我们走过十几载青春。考试的评分算法简单且容易区分,整个系统设置了一个总分,根据不同的表现进行加分或扣分,统计最终得分作为最后的评分。一般情况下成绩是一个近似正态分布的偏态分布,如下图所示。

如果成绩近似正态分布(如上图-中),则说明本次考试难度分布较为均衡;如果成绩分布整体向左偏(如上图-左),则说明本次考试较为困难,学生成绩普遍偏低;如果成绩分布整体向右偏(如上图-右),则说明本次考试较为容易,学生成绩普遍偏高。

除此之外,也可能出现双峰分布,以及峰的陡峭和平缓都能反应考试的不同问题,在此就不再一一展开说明。一般情况下,考试的最终成绩已经能够很好地对学生的能力进行区分,这也正是为什么一般情况我们不会对考试分数做二次处理,而是直接使用。

加权评分

在现实生活中,不同的问题和任务难易程度不同,为了保证「公平」,我们需要赋予困难的任务更多的分数。这一点在试卷中也会有体现,一般而言判断题会比选择题分数更低,毕竟随机作答,判断题仍有 50% 的概率回答正确,但包含四个选项的选择题却仅有 25% 概率回答正确。

加权评分在问题和任务的难易程度与分值之间通过权重进行平衡,但权重的制定并不是一个容易的过程,尤其是在设置一个兼顾客观、公平、合理等多维度的权重时。

考虑时间的评分和排名

Delicious

最简单直接的方法是在一定的时间内统计投票的数量,得票数量高的则为更好的项目。在旧版的 Delicious 中,热门书签排行榜则是根据过去 60 分钟内被收藏的次数进行排名,每 60 分钟重新统计一次。

这种算法的优点是:简单、容易部署、更新快;缺点是:一方面,排名变化不够平滑,前一个小时还排名靠前的内容,往往第二个小时就一落千丈,另一方面,缺乏自动淘汰旧项目的机制,某些热门内容可能会长期占据排行榜前列。

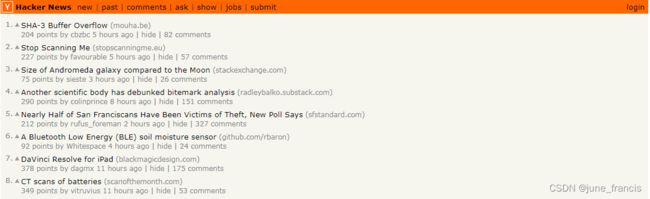

Hacker News

Hacker News 是一个可以发布帖子的网络社区,每个帖子前面有一个向上的三角形,如果用户觉得这个内容好,点击一下即可投票。根据得票数,系统自动统计出热门文章排行榜。

Hacker News 使用分数计算公式如下:

S c o r e = P − 1 ( T + 2 ) G (1) Score = \frac{P-1}{(T + 2)^G} \tag{1} Score=(T+2)GP−1(1)

其中, P P P 表示帖子的得票数,减去 1 1 1 表示忽略发帖人的投票; T T T 表示当前距离发帖的时间(单位为小时),加上 2 2 2 是为了防止最新的帖子分母过小; G G G 为重力因子,即将帖子排名被往下拉的力量,默认值为 1.8 1.8 1.8 。

在其他条件不变的情况下,更多的票数可以获得更高的分数,如果不希望“高票数”帖子和“低票数”帖子之间差距过大,可以在式 (1) 的分子中添加小于 1 1 1 的指数,例如: ( P − 1 ) 0.8 (P-1)^{0.8} (P−1)0.8

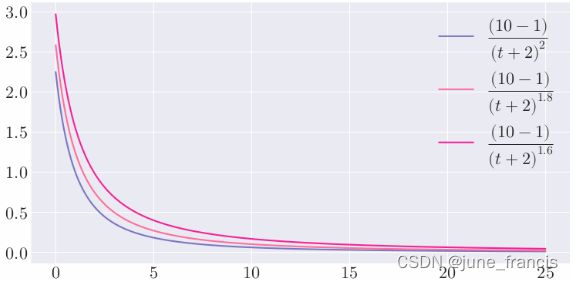

。在其他条件不变的情况下,随着时间不断流逝,帖子的分数会不断降低,经过 24 小时后,几乎所有帖子的分数都将小于 1 1 1 。重力因子对于分数的影响如下图所示:

不难看出, G G G 值越大,曲线越陡峭,排名下降的速度越快,意味着排行榜的更新速度越快。

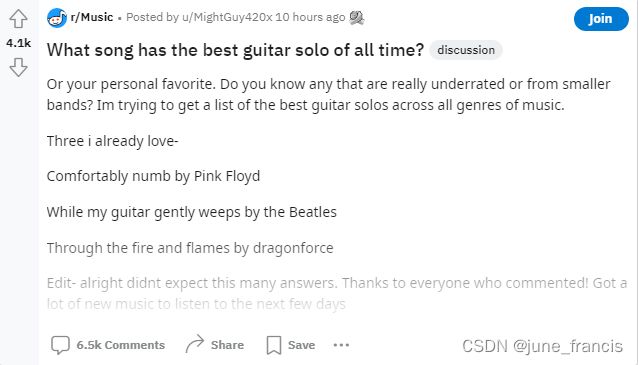

不同于 Hacker News,Reddit 中的每个帖子前面都有向上和向下的箭头,分别表示"赞成"和"反对"。用户点击进行投票,Reddit 根据投票结果,计算出最新的热点文章排行榜。

Reddit 关于计算分数的 代码 可以简要总结如下:

from datetime import datetime, timedelta

from math import log

epoch = datetime(1970, 1, 1)

def epoch_seconds(date):

td = date - epoch

return td.days * 86400 + td.seconds + (float(td.microseconds) / 1000000)

def score(ups, downs):

return ups - downs

def hot(ups, downs, date):

s = score(ups, downs)

order = log(max(abs(s), 1), 10)

sign = 1 if s > 0 else -1 if s < 0 else 0

seconds = epoch_seconds(date) - 1134028003

return round(order + sign * seconds / 45000, 7)

分数的计算过程大致如下:

- 计算赞成票和反对票的差值,即:

o r d e r = u p s − d o w n s (2) order = ups - downs \tag{2} order=ups−downs(2) - 利用如下公式计算中间分数,即:

o r d e r = l o g 10 m a x ( ∣ s ∣ , 1 ) (3) order = log_{10} max(|s|, 1) \tag{3} order=log10max(∣s∣,1)(3)

其中,取 ∣ s ∣ |s| ∣s∣ 和 1 1 1 的最大值是为了避免当 s = 0 s=0 s=0 时,无法计算 l o g 10 ∣ s ∣ log_{10}|s| log10∣s∣

。赞成票与反对票差值越大,得分越高。取以 10 10 10 为底的对数,表示当 s = 10 s=10 s=10 时,这部分为 1 1 1,只有 s = 100 s=100 s=100 时才为 2 2 2,这样设置是为了减缓差值增加对总分的影响程度。 - 确定分数的方向,即:

s i g n = { 1 , i f s > 0 0 , i f s = 0 − 1 i f s < 0 (4) sign = \begin{cases}1, & if \quad s \gt 0 \\ 0, & if \quad s = 0 \\ -1 & if \quad s \lt 0\end{cases} \tag{4} sign=⎩ ⎨ ⎧1,0,−1ifs>0ifs=0ifs<0(4) - 计算发帖时间距离2005年12月8日7:46:43(Reddit的成立时间?)的秒数,即:

s e c o n d s = t i m e s t a m p ( d a t e ) − 1134028003 (5) seconds = timestamp(date) - 1134028003 \tag{5} seconds=timestamp(date)−1134028003(5) - 计算最终分数,即:

s c o r e = o r d e r + s i g n × s e c o n d s 45000 (6) score = order + sign \times \frac{seconds}{45000} \tag{6} score=order+sign×45000seconds(6)

将时间除以 45000 45000 45000 秒(即 12.5 个小时),也就是说当前天的帖子会比昨天的帖子多约 2 2 2 分。如果昨天的帖子想要保持住之前的排名,则 s s s 值需要增加 100 100 100 倍才可以。

Reddit 评分排名算法决定了 Reddit 是一个符合大众口味的社区,而不是一个适合展示激进想法的地方。因为评分中使用的是赞成票和反对票的差值,也就是说在其他条件相同的情况下,帖子 A A A 有 1 1 1 票赞成, 0 0 0 票反对;帖子 B B B 有 1000 1000 1000 票赞成, 1000 1000 1000 票反对,但讨论火热的帖子 B B B 的得分却比帖子 A A A 要少。

Stack Overflow

Stack Overflow 是世界排名第一的程序员问答社区。用户可以在上面提出各种关于编程的问题,等待别人回答;可以对问题进行投票(赞成票或反对票),表示这个问题是不是有价值;也可以对这个回答投票(赞成票或反对票),表示这个回答是不是有价值。

在 Stack Overflow 的页面上,每个问题前面有三个数字,分别为问题的得分、回答的数量和问题的浏览次数。

创始人之一的 Jeff Atwood 公布的评分排名的计算公式如下:

4 × l o g 10 Q v i e w s + Q a n s w e r s × Q s c o r e 5 + ∑ ( A s c o r e s ) ( ( Q a g e + 1 ) − ( Q a g e − Q u p d a t e d 2 ) ) 1.5 (7) \frac{4 \times log_{10}Q_{views} + \frac{Q_{answers} \times Q_{score}}{5} + \sum (A_{scores})}{\bigl( (Q_{age} + 1) - (\frac{Q_{age} - Q_{updated}}{2}) \bigr)^{1.5} } \tag{7} ((Qage+1)−(2Qage−Qupdated))1.54×log10Qviews+5Qanswers×Qscore+∑(Ascores)(7)

其中:

- 4 × l o g 10 Q v i e w s 4 \times log_{10} Q_{views} 4×log10Qviews 表示问题的浏览次数越多,得分越高,同时利用 l o g 10 log_{10} log10 减缓了随着浏览量增大导致得分变高的程度;

- Q a n s w e r s × Q s c o r e 5 \frac{Q_{answers} \times Q_{score}}{5} 5Qanswers×Qscore 表示问题的得分(赞成票和反对票之差)越高,回答的数量越多,分数越高。采用乘积的形式意味着即使问题本身的分数再高,没有人回答的问题也算不上热门问题;

- ∑ ( A s c o r e s ) \sum (A_{scores}) ∑(Ascores) 表示问题回答的总分数。回答总分采用了简单的加和,但实际上一个正确的回答要胜过多个无用的回答,简单的加和无法很好的区分这两种不同的情况;

- ( ( Q a g e + 1 ) − ( Q a g e − Q u p d a t e d 2 ) ) 1.5 \bigl( (Q_{age} + 1) - (\frac{Q_{age} - Q_{updated}}{2}) \bigr)^{1.5} ((Qage+1)−(2Qage−Qupdated))1.5 可以改写为 ( Q a g e 2 + Q u p d a t e d 2 + 1 ) 1.5 \bigl( \frac{Q_{age}}{2} + \frac{Q_{updated}}{2} + 1 \bigr)^{1.5} (2Qage+2Qupdated+1)1.5 , Q a g e Q_{age} Qage 和 Q u p d a t e d Q_{updated} Qupdated

分别表示问题发布时间和最近一次回答的时间(单位为小时),也就是说问题时间越久远,最近一次回答时间越久远,分母就会越大,从而得分就会越小。

Stack Overflow 的评分排名算法考虑了参与程度(问题浏览次数和回答次数)、质量(问题分数和回答分数)、时间(问题时间和最近一次回答时间)等多个维度。

不考虑时间的评分和排名

上文中介绍的评分和排名方法多适用于具有时效性的信息,但是对于图书、电影等无需考虑时间因素的情况而言,则需要其他方法进行衡量。

威尔逊区间算法

在不考虑时间的情况下,以「赞成」和「反对」两种评价方式为例,通常我们会有两种最基础的方法计算得分。第一种为绝对分数,即:

评分 = 赞成票 − 反对票 (8) 评分 = 赞成票 - 反对票 \tag{8} 评分=赞成票−反对票(8)

但这种计算方式有时会存在一定问题,例如:A 获得 60 张赞成票,40 张反对票;B 获得 550 张赞成票,450 张反对票。根据上式计算可得 A 的评分为 20,B 的评分为 100,所以 B 要优于 A。但实际上,B 的好评率仅有 550 550 + 450 = 55 % \frac{550}{550+450}=55\% 550+450550=55% ,而 A 的好评率为 60 60 + 40 = 60 % \frac{60}{60+40}=60\% 60+4060=60% ,因此实际情况应该是 A 优于 B。

这样,我们就得到了第二种相对分数,即:

评分 = 赞成票 赞成票 + 反对票 (9) 评分 = \frac{赞成票}{赞成票 + 反对票} \tag{9} 评分=赞成票+反对票赞成票(9)

这种方式在总票数比较大的时候没有问题,但总票数比较小时就容易产生错误。例如:A 获得 2 张赞成票,0 张反对票;B 获得 100 张赞成票,1 张反对票。根据上式计算可得 A 的评分为 100 % 100\% 100%,B 的评分为 99 % 99\% 99% 。但实际上 B 应该是优于 A 的,由于 A 的总票数太少,数据不太具有统计意义。

对于这个问题,我们可以抽象出来:

- 每个用户的投票都是独立事件;

- 用户只有两个选择,要么投赞成票,要么投反对票;

- 如果投票总人数为 n n n,其中赞成票为 k k k,则赞成票的比例 p = k n p=\frac{k}{n} p=nk 。

不难看出,上述过程是一个二项实验。 p p p 越大表示评分越高,但是 p p p 的可信性取决于投票的人数,如果人数太少, 就不可信了。因此我们可以通过计算 p p p 的置信区间对评分算法进行调整如下:

- 计算每个项目的好评率;

- 计算每个好评率的置信区间;

- 根据置信区间的 下限值 进行排名。

置信区间的本质就是对可信度进行修正,弥补样本量过小的影响。如果样本足够多,就说明比较可信,则不需要很大的修正,所以置信区间会比较窄,下限值会比较大;如果样本比较少,就说明不一定可信,则需要进行较大的修正,所以置信区间会比较宽,下限值会比较小。

二项分布的置信区间有多种计算公式,最常见的 「正态区间」 方法对于小样本准确性较差。1927 年,美国数学家 Edwin Bidwell Wilson 提出了一个修正公式,被称为 「威尔逊区间」,很好地解决了小样本的准确性问题。置信区间定义如下:

1 1 + z 2 n ( p ^ + z 2 2 n ) ± z 1 + z 2 n p ^ ( 1 − p ^ ) n + z 2 4 n 2 (10) \frac{1}{1 + \frac{z^2}{n}} \biggl(\hat{p} + \frac{z^2}{2n}\biggr) \pm \frac{z}{1 + \frac{z^2}{n}} \sqrt{\frac{\hat{p} (1-\hat{p})}{n} + \frac{z^2}{4n^2}} \tag{10} 1+nz21(p^+2nz2)±1+nz2znp^(1−p^)+4n2z2(10)

其中, p ^ \hat{p} p^ 表示样本好评率, n n n 表示样本大小, z z z 表示某个置信水平的 z z z 统计量。

贝叶斯平均算法

在一些榜单中,有时候会出现排行榜前列总是那些票数最多的项目,新项目或者冷门的项目很难有出头机会,排名可能会长期靠后。以世界最大的电影数据库 IMDB 为例,观众可以对每部电影投票,最低为 1 分,最高为 10 分,系统根据投票结果,计算出每部电影的平均得分。

这就出现了一个问题:热门电影与冷门电影的平均得分,是否真的可比?例如一部好莱坞大片有 10000 个观众投票,一部小成本的文艺片可能只有 100 个观众投票。如果使用威尔逊区间算法,后者的得分将被大幅拉低,这样处理是否公平,是否能反映电影的真正质量呢?在 Top 250 榜单 中,IMDB 给到的评分排名计算公式如下:

W R = v v + m R + m v + m C WR = \frac{v}{v+m}R + \frac{m}{v+m}C WR=v+mvR+v+mmC

其中, W R WR WR 为最终的加权得分, R R R 为该电影用户投票的平均得分, v v v 为该电影的投票人数, m m m 为排名前 250 电影的最低投票数, C C C 为所有电影的平均得分。

从公式中可以看出,分量 m C mC mC 可以看作为每部电影增加了评分为 C C C 的 m m m 张选票。然后再根据电影自己的投票数量 v v v 和投票平均分 R R R 进行修正,得到最终的分数。随着电影投票数量的不断增加, v v + m R \frac{v}{v+m}R v+mvR 占的比重将越来越大,加权得分也会越来越接近该电影用户投票的平均分。

将公式写为更一般的形式,有:

x ‾ = C m + ∑ i = 1 n x i C + n (12) \overline{x} = \frac{Cm + \sum_{i=1}^n x_i}{C + n} \tag{12} x=C+nCm+∑i=1nxi(12)

其中, C C C 为需要扩充的投票人数规模,可以根据投票人数总量设置一个合理的常数, n n n 为当前项目的投票人数, x x x 为每张选票的值, m m m 为总体的平均分。这种算法称为「贝叶斯平均」。在这个公式中, m m m 可以视为“先验概率”,每新增一次投票,都会对最终得分进行修正,使其越来越接近真实的值。

比赛评分和排名

Kaggle

Kaggle 是一个数据建模和数据分析竞赛平台。企业和研究者可在其上发布数据,统计学者和数据挖掘专家可在其上进行竞赛以产生最好的模型。用户以团队形式参加 Kaggle 的比赛,团队可以仅包含自己一人,根据在每场比赛中的排名不断获取积分,用做 Kaggle 网站中的最终排名。

早期 Kaggle 对于每场比赛的积分按如下方式计算:

[ 100000 N t e a m m a t e s ] [ R a n k − 0.75 ] [ l o g 10 ( N t e a m s ) ] [ 2 y e a r s − t i m e 2 y e a r s ] (13) \biggl[\frac{100000}{N_{teammates}}\biggr][Rank^{-0.75}][log_{10}(N_{teams})]\biggl[\frac{2\;years - time}{2\;years}\biggr] \tag{13} [Nteammates100000][Rank−0.75][log10(Nteams)][2years2years−time](13)

在 2015 年对新的排名系统做了 调整 ,新的比赛积分计算公式调整为:

[ 100000 N t e a m m a t e s ] [ R a n k − 0.75 ] [ l o g 10 ( 1 + l o g 10 ( N t e a m s ) ) ] [ e − t 500 ] (14) \biggl[\frac{100000}{N_{teammates}}\biggr][Rank^{-0.75}][log_{10}(1+log_{10}(N_{teams}))]\bigl[e^{-\frac{t}{500}}\bigr] \tag{14} [Nteammates100000][Rank−0.75][log10(1+log10(Nteams))][e−500t](14)

其中, N t e a m m a t e s N_{teammates} Nteammates 为团队成员的数量, R a n k Rank Rank 为比赛排名, N t e a m s N_{teams} Nteams 为参赛的团队数量, t t t 为从比赛结束之日起过去的时间。

第一部分可以视为基础分,团队成员越少,所获得的基础分越多。从调整的文档来看,Kaggle 认为团队合作每个人的贡献程度会大于 1 / N t e a m m a t e s 1/N_{teammates} 1/Nteammates ,为了鼓励大家团队合作,Kaggle 减少了对团队人数的基础分惩罚力度。

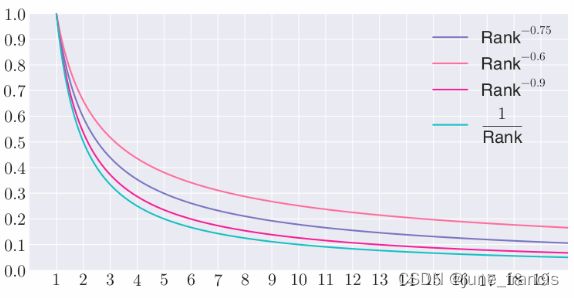

第二部分则是根据用户在比赛中的排名得到一个小于等于 1 的系数。下图显示了不同的指数以及 1 / R a n k 1/Rank 1/Rank 之间的区别:

从图中可以看出,通过调节指数的大小可以控制系数随排名下降而下降的速度。整体来说,Kaggle 更加重视前几名,对于 10 名开外的选手,系数均小于 0.2 0.2 0.2,且差异不大。

第三部分可以理解为通过参赛的队伍数量来衡量比赛的受欢迎程度(或是在众多参赛队伍中脱颖而出的难易程度)。以 100 和 1000 支参赛队伍对比为例,根据之前的计算公式,这一部分为:

l o g 10 100 = 2 l o g 10 1000 = 3 (15) log_{10}100 = 2 \\ log_{10}1000 = 3 \tag{15} log10100=2log101000=3(15)

但随着 Kaggle 本身比赛流行度越来越高,官方认为赢得一场 1000 人的比赛并不需要比赢得一场 100 人的比赛需要多 50 % 50\% 50% 的技能,因此通过调整后的算法,这个比例调整至大约为 25 % 25\% 25% 。

l o g 10 ( l o g 10 ( 100 ) + 1 ) ≈ 0.47 l o g 10 ( l o g 10 ( 1000 ) + 1 ) ≈ 0.6 (16) log_{10}(log_{10}(100) + 1) \approx 0.47 \\ log_{10}(log_{10}(1000)+1) \approx 0.6 \tag{16} log10(log10(100)+1)≈0.47log10(log10(1000)+1)≈0.6(16)

第四部分为时间衰减项,调整为新的计算公式后可以消除原来通过设置 2 年时限导致的积分断崖。如果任何一对个体都没有采取任何进一步的行动,那么排名不应该在任何一对个体之间发生变化。换句话说,如果整个 Kaggle 用户群停止参加比赛,他们的相对排名应该随着时间的推移保持不变。选择 1 / 500 1/500 1/500 的原因是可以将旧的 2 年断崖延长到更长的时间范围,并且永远不会变为 0。

Elo评分系统

Elo 评分系统(Elo Rating System)是由匈牙利裔美国物理学家 Arpad Elo 创建的一个衡量各类对弈活动水平的评价方法,是当今对弈水平评估公认的权威标准,且被广泛用于国际象棋、围棋、足球、篮球等运动。网络游戏的竞技对战系统也常采用此评分系统。

Elo 评分系统是基于统计学的一个评估棋手水平的方法。Elo 模型原先采用正态分布,但实践显明棋手的表现并非正态分布,所以现在的评分计分系统通常使用的是逻辑分布。

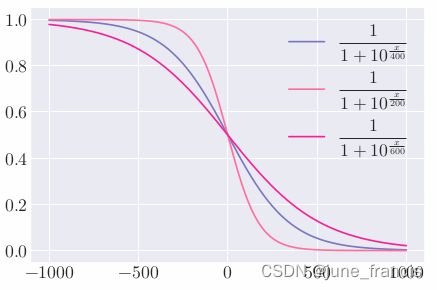

假设棋手 A A A 和 B B B 的当前评分分别为 R A R_A RA 和 R B R_B RB ,则按照逻辑分布, A A A 对 B B B 的胜率期望值为:

E A = 1 1 + 1 0 ( R B − R A ) / 400 (17) E_A = \frac{1}{1+10^{(R_B - R_A)/400}} \tag{17} EA=1+10(RB−RA)/4001(17)

类似的则有 B B B 对 A A A 的胜率期望值为:

E B = 1 1 + 1 0 ( R A − R B ) / 400 (18) E_B = \frac{1}{1+10^{(R_A - R_B)/400}} \tag{18} EB=1+10(RA−RB)/4001(18)

假如一位棋手在比赛中的真实得分 S A S_A SA (胜 1 分,和 0.5 分,负 0 分)和他的胜率期望值 E A E_A EA 不同, 则他的评分要作相应的调整:

R A ′ = R A + K ( S A − E A ) (19) R_A^{'} = R_A + K(S_A - E_A) \tag{19} RA′=RA+K(SA−EA)(19)

公式中 R A R_A RA 和 R A ′ R_A^{'} RA′ 分别为棋手调整前后的评分。 K K K 值是一个极限值,代表理论上最多可以赢一个玩家的得分和失分, K / 2 K/2 K/2 就是相同等级的玩家其中一方胜利后所得的分数。国际象棋大师赛中, K = 16 K=16 K=16;在大部分的游戏规则中, K = 32 K=32 K=32。通常水平越高的比赛中其 K K K 值越小,这样做是为了避免少数的几场比赛就能改变高端顶尖玩家的排名。 E A E_A EA 和 E B E_B EB 中的 400 400 400 是让多数玩家积分保持标准正态分布的值,在 K K K 相同的情况下,分母位置的值越大,积分变化值越小。

Glicko评分系统

Glicko 评分系统(Glicko Rating System)及 Glicko-2 评分系统(Glicko-2 Rating System)是评估选手在比赛中(如国际象棋及围棋)的技术能力方法之一。此方法由马克·格利克曼发明,原为国际象棋评分系统打造,后被作为评分评分系统的改进版本广泛应用。

Elo 评分系统的问题在于无法确定选手评分的可信度,而 Glicko 评分系统正是针对此进行改进。假设两名评分均为 1700 的选手 A 和 B 在进行一场对战后 A 获得胜利,在美国国际象棋联赛的 Elo 评分系统下,A 选手评分将增长 16,对应的 B 选手评分将下降 16 。但是假如 A 选手是已经很久没玩,但 B 选手每周都会玩,那么在上述情况下 A 选手的 1700 评分并不能十分可信地用于评定其实力,而 B 选手的 1700 评分则更为可信。

Glicko 算法的主要贡献是“评分可靠性”(Ratings Reliability),即评分偏差(Ratings Deviation)。若选手没有评分,则其评分通常被设为 1500,评分偏差为 350。新的评分偏差 ( R D ) (RD) (RD) 可使用旧的评分偏差 ( R D 0 ) (RD_0) (RD0) 计算:

R D = m i n ( R D 0 2 + c 2 t , 350 ) (20) RD = min \biggl(\sqrt{RD_0^2 + c^2t}, \; 350\biggr) \tag{20} RD=min(RD02+c2t,350)(20)

其中, t t t 为自上次比赛至现在的时间长度(评分期),常数 c c c 根据选手在特定时间段内的技术不确定性计算而来,计算方法可以通过数据分析,或是估算选手的评分偏差将在什么时候达到未评分选手的评分偏差得来。若一名选手的评分偏差将在 100 个评分期间内达到 350 的不确定度,则评分偏差为 50 的玩家的常数 c c c 可通过解 350 = 5 0 2 + 100 c 2 350=\sqrt{50^2+100c^2} 350=502+100c2,则有 c = ( 35 0 2 − 5 0 2 ) / 100 ≈ 34.6 c = \sqrt{(350^2-50^2)/100} \approx 34.6 c=(3502−502)/100≈34.6 。

在经过 m m m 场比赛后,选手的新评分可通过下列等式计算:

r = r 0 + q 1 R D 2 + 1 d 2 ∑ i = 1 m g ( R D i ) ( s i − E ( s ∣ r 0 , r i , R D i ) ) (21) r = r_0 + \frac{q}{\frac{1}{RD^2} + \frac{1}{d^2}} \sum_{i=1}^m g(RD_i)(s_i - E(s|r_0,r_i,RD_i)) \tag{21} r=r0+RD21+d21qi=1∑mg(RDi)(si−E(s∣r0,ri,RDi))(21)

其中:

g ( R D i ) = 1 1 + 3 q 2 ( R D i 2 ) π 2 E ( s ∣ r , r i , R D i ) = 1 1 + 10 ( g ( R D i ) ( r 0 − r i ) − 400 ) q = l n ( 10 ) 400 = 0.00575646273 d 2 = 1 q 2 ∑ i = 1 m ( g ( R D i ) ) 2 E ( s ∣ r 0 , r i , R D i ) ( 1 − E ( s ∣ r 0 , r i , R D i ) ) g(RD_i) = \frac{1}{\sqrt{1+\frac{3q^2(RD_i^2)}{\pi^2}}} \\ E(s|r,r_i,RD_i) = \frac{1}{1+10(\frac{g(RD_i)(r_0-r_i)}{-400})} \\ q = \frac{ln(10)}{400} = 0.00575646273 \\ d^2 = \frac{1}{q^2\sum_{i=1}^m(g(RD_i))^2E(s|r_0,r_i,RD_i)(1-E(s|r_0,r_i,RD_i))} g(RDi)=1+π23q2(RDi2)1E(s∣r,ri,RDi)=1+10(−400g(RDi)(r0−ri))1q=400ln(10)=0.00575646273d2=q2∑i=1m(g(RDi))2E(s∣r0,ri,RDi)(1−E(s∣r0,ri,RDi))1

r i r_i ri 表示选手个人评分, s i s_i si 表示每场比赛后的结果。胜利为 1 1 1,平局为 1 / 2 1/2 1/2,失败为 0 0 0 。

原先用于计算评分偏差的函数应增大标准差值,进而反应模型中一定非观察时间内,玩家的技术不确定性的增长。随后,评分偏差将在几场游戏后更新:

R D ′ = ( 1 R D 2 + 1 d 2 ) − 1 (22) RD^{'} = \sqrt{\biggl(\frac{1}{RD^2} + \frac{1}{d^2}\biggr)^{-1}} \tag{22} RD′=(RD21+d21)−1(22)

Glicko-2评分系统

Glicko-2 算法与原始 Glicko 算法类似,增加了一个评分波动率 σ \sigma σ,它根据玩家表现的不稳定程度来衡量玩家评分的预期波动程度。例如:当一名球员的表现保持稳定时,他们的评分波动性会很低,如果他们在这段稳定期之后取得了异常强劲的成绩,那么他们的评分波动性就会增加 1 1 1 。

Glicko-2 算法的简要步骤如下:

计算辅助量

在一个评分周期内,当前评分为 μ \mu μ 和评分偏差为 ϕ \phi ϕ 的玩家与 m m m 个评分为 μ 1 , … , μ m \mu_1,\dots,\mu_m μ1,…,μm 和评分偏差为 ϕ 1 , … , ϕ m \phi_1,\dots,\phi_m ϕ1,…,ϕm 的玩家比赛,获得的分数为 s 1 , … , s m s_1,\dots,s_m s1,…,sm ,我们首先需要计算辅助量 v v v 和 Δ \Delta Δ :

v = [ ∑ j = 1 m g ( ϕ j ) 2 E ( μ , μ j , ϕ j ) { s j − E ( μ , μ j , ϕ j ) } ] − 1 Δ = v ∑ j = 1 m g ( ϕ j ) { s j − E ( μ , μ j , ϕ j ) } (23) v = \biggl[\sum_{j=1}^mg(\phi_j)^2E(\mu,\mu_j,\phi_j)\{s_j - E(\mu, \mu_j, \phi_j)\}\biggr]^{-1} \\ \Delta = v\sum_{j=1}^mg(\phi_j)\{s_j-E(\mu, \mu_j, \phi_j)\} \tag{23} v=[j=1∑mg(ϕj)2E(μ,μj,ϕj){sj−E(μ,μj,ϕj)}]−1Δ=vj=1∑mg(ϕj){sj−E(μ,μj,ϕj)}(23)

其中:

g ( ϕ ) = 1 1 + 3 ϕ 2 / π 2 , E ( μ , μ j , ϕ j ) = 1 1 + e x p { − g ( ϕ j ) ( μ − μ j ) } g(\phi) = \frac{1}{\sqrt{1+3\phi^2/\pi^2}}, \\ E(\mu,\mu_j,\phi_j) = \frac{1}{1+exp\{-g(\phi_j)(\mu-\mu_j)\}} g(ϕ)=1+3ϕ2/π21,E(μ,μj,ϕj)=1+exp{−g(ϕj)(μ−μj)}1

确定新的评分波动率

选择一个小的常数 τ \tau τ 来限制时间的波动性,例如: τ = 0.2 \tau=0.2 τ=0.2 (较小的 τ \tau τ 值可以防止剧烈的评分变化),对于:

f ( x ) = 1 2 e x ( Δ 2 − ϕ 2 − v 2 − e x ) ( ϕ 2 + v + e x ) 2 − x − l n ( σ 2 ) τ 2 (24) f(x) = \frac{1}{2}\frac{e^x(\Delta^2-\phi^2-v^2-e^x)}{(\phi^2 + v + e^x)^2} - \frac{x-ln(\sigma^2)}{\tau^2} \tag{24} f(x)=21(ϕ2+v+ex)2ex(Δ2−ϕ2−v2−ex)−τ2x−ln(σ2)(24)

我们需要找到满足 f ( A ) = 0 f(A)=0 f(A)=0 的值 A A A 。解决此问题的一种有效的方法是使用 Illinois 算法 ,一旦这个迭代过程完成,我们将新的评级波动率 σ ′ \sigma^{'} σ′ 设置为:

σ ′ = e A / 2 (25) \sigma^{'} = e^{A/2} \tag{25} σ′=eA/2(25)

确定新的评分偏差和评分

之后得到新的评分偏差:

ϕ ′ = 1 1 ϕ 2 + σ ′ 2 + 1 v (26) \phi^{'} = \frac{1}{\sqrt{\frac{1}{\phi^2+\sigma^{'2}}+ \frac{1}{v}}} \tag{26} ϕ′=ϕ2+σ′21+v11(26)

和新的评分:

μ ′ = μ + ϕ ′ 2 ∑ j = 1 m g ( ϕ j ) { s j − E ( μ , μ j , ϕ j ) } (27) \mu^{'} = \mu + \phi^{'2} \sum_{j=1}^m g(\phi_j)\{s_j - E(\mu, \mu_j, \phi_j)\} \tag{27} μ′=μ+ϕ′2j=1∑mg(ϕj){sj−E(μ,μj,ϕj)}(27)

需要注意这的评分和评分偏差与原始 Glicko 算法的比例不同,需要进行转换才能正确比较两者。

TrueSkill评分系统

TrueSkill 评分系统是基于贝叶斯推断的评分系统,由微软研究院开发以代替传统 Elo 评分系统,并成功应用于 Xbox Live 自动匹配系统。TrueSkill 评分系统是 Glicko 评分系统的衍生,主要用于多人游戏中。TrueSkill 评分系统考虑到了个别玩家水平的不确定性,综合考虑了各玩家的胜率和可能的水平涨落。当各玩家进行了更多的游戏后,即使个别玩家的胜率不变,系统也会因为对个别玩家的水平更加了解而改变对玩家的评分。

在电子竞技游戏中,特别是当有多名选手参加比赛的时候需要平衡队伍间的水平,让游戏比赛更加有意思。这样的一个参赛选手能力平衡系统通常包含以下三个模块:

- 一个包含跟踪所有玩家比赛结果,记录玩家能力的模块;

- 一个对比赛成员进行配对的模块;

- 一个公布比赛中各成员能力的模块。

能力计算和更新

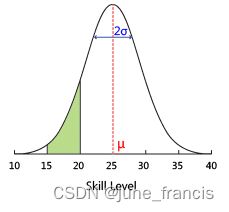

TrueSkill 评分系统是针对玩家能力进行设计的,以克服现有排名系统的局限性,确保比赛双方的公平性,可以在联赛中作为排名系统使用。TrueSkill 评分系统假设玩家的水平可以用一个正态分布来表示,而正态分布可以用两个参数:平均值和方差来完全描述。设 R a n k Rank Rank 值为 R R R,代表玩家水平的正态分布的两个参数平均值和方差分别为 μ \mu μ 和 σ \sigma σ,则系统对玩家的评分即 R a n k Rank Rank 值为:

R = μ − k × σ (28) R = \mu - k \times \sigma \tag{28} R=μ−k×σ(28)

其中, k k k 值越大则系统的评分越保守。

上图来自 TrueSkill 网站,钟型曲线为某个玩家水平的可能分布,绿色区域是排名系统的信念,即玩家的技能在 15 到 20 级之间。

下表格给出了 8 个新手在参与一个 8 人游戏后 μ \mu μ 和 σ \sigma σ 的变化。

| 姓名 | 排名 | 赛前 μ \mu μ | 赛前 σ \sigma σ | 赛后 μ \mu μ | 赛后\sigma |

|---|---|---|---|---|---|

| Alice | 1 | 25 | 8.3 | 36.771 | 5.749 |

| Bob | 2 | 25 | 8.3 | 32.242 | 5.133 |

| Chris | 3 | 25 | 8.3 | 29.074 | 4.943 |

| Darren | 4 | 25 | 8.3 | 26.322 | 4.874 |

| Eve | 5 | 25 | 8.3 | 23.678 | 4.874 |

| Fabien | 6 | 25 | 8.3 | 20.926 | 4.943 |

| George | 7 | 25 | 8.3 | 17.758 | 5.133 |

| Hillary | 8 | 25 | 8.3 | 13.229 | 5.749 |

第 4 名 Darren 和第 5 名 Eve,他们的 σ \sigma σ 是最小的,换句话说系统认为他们能力的可能起伏是最小的。这是因为通过这场游戏我们对他们了解得最多:他们赢了3 和 4 个人,也输给了 4 和 3 个人。而对于第 1 名 Alice,我们只知道她赢了 7 个人。

定量分析可以先考虑最简单的两人游戏情况:

μ w i n n e r ← μ w i n n e r + μ w i n n e r 2 c ∗ v ( μ w i n n e r − μ l o s e r , ε c ) μ l o s e r ← μ l o s e r + μ l o s e r 2 c ∗ v ( μ w i n n e r − μ l o s e r , ε c ) σ w i n n e r 2 ← σ w i n n e r 2 ∗ [ 1 − σ w i n n e r 2 c ∗ w ( μ w i n n e r − μ l o s e r c , ε c ) ] σ l o s e r 2 ← σ l o s e r 2 ∗ [ 1 − σ l o s e r 2 c ∗ w ( μ w i n n e r − μ l o s e r c , ε c ) ] c 2 = 2 β 2 + σ w i n n e r 2 + σ l o s e r 2 (29) \mu_{winner} \gets \mu_{winner} + \frac{\mu_{winner}^2}{c} * v\biggl(\frac{\mu_{winner}-\mu_{loser}}{},\frac{\varepsilon}{c}\biggr) \\ \mu_{loser} \gets \mu_{loser} + \frac{\mu_{loser}^2}{c} * v\biggl(\frac{\mu_{winner}-\mu_{loser}}{},\frac{\varepsilon}{c}\biggr) \\ \sigma_{winner}^2 \gets \sigma_{winner}^2 * \biggl[1-\frac{\sigma_{winner}^2}{c}*w\biggl(\frac{\mu_{winner}-\mu_{loser}}{c},\frac{\varepsilon}{c}\biggr)\biggr] \\ \sigma_{loser}^2 \gets \sigma_{loser}^2 * \biggl[1-\frac{\sigma_{loser}^2}{c}*w\biggl(\frac{\mu_{winner}-\mu_{loser}}{c},\frac{\varepsilon}{c}\biggr)\biggr] \\ c^2 = 2\beta^2 + \sigma_{winner}^2 + \sigma_{loser}^2 \tag{29} μwinner←μwinner+cμwinner2∗v(μwinner−μloser,cε)μloser←μloser+cμloser2∗v(μwinner−μloser,cε)σwinner2←σwinner2∗[1−cσwinner2∗w(cμwinner−μloser,cε)]σloser2←σloser2∗[1−cσloser2∗w(cμwinner−μloser,cε)]c2=2β2+σwinner2+σloser2(29)

其中, 系数 β \beta β 代表的是所有玩家的平均方差, v v v 和 w w w 是两个函数,比较复杂, ε \varepsilon ε 是平局参数。简而言之,个别玩家赢了 μ \mu μ 就增加,输了 μ \mu μ 就减小;但不论输赢, σ \sigma σ 都是在减小,所以有可能出现输了还涨分的情况。

对手匹配

势均力敌的对手能带来最精彩的比赛,所以当自动匹配对手时,系统会尽可能地为个别玩家安排可能水平最为接近的对手。TrueSkill 评分系统采用了一个值域为 ( 0 , 1 ) (0,1) (0,1) 的函数来描述两个人是否势均力敌:结果越接近 0 0 0 代表差距越大,越接近 1 1 1 代表水平越接近。

假设有两个玩家 A A A 和 B B B,他们的参数为 ( μ A , σ A ) (\mu_A,\sigma_A) (μA,σA) 和 ( μ B , σ B ) (\mu_B,\sigma_B) (μB,σB),则函数对这两个玩家的返回值为:

e − ( μ A − μ B ) 2 2 c 2 2 β 2 c 2 (30) e^{-\frac{(\mu_A-\mu_B)^2}{2c^2}} \sqrt{\frac{2\beta^2}{c^2}} \tag{30} e−2c2(μA−μB)2c22β2(30)

c c c 的值由如下公式给出:

c 2 = 2 β 2 + μ A 2 + μ B 2 (31) c^2 = 2\beta^2 + \mu_A^2 + \mu_B^2 \tag{31} c2=2β2+μA2+μB2(31)

如果两人有较大几率被匹配在一起,仅是平均值接近还不行,还需要方差也比较接近才可以。

在 Xbox Live 上,系统为每个玩家赋予的初值是 μ = 25 , σ = 25 3 \mu = 25,\; \sigma = \frac{25}{3} μ=25,σ=325 和 k = 3 k=3 k=3 。所以玩家的起始 R a n k Rank Rank 值为:

R = 25 − 3 × 35 3 = 0 (32) R = 25 - 3 \times \frac{35}{3} = 0 \tag{32} R=25−3×335=0(32)

相较于 Elo 评价系统,TrueSkill 评价系统的优势在于:

- 适用于复杂的组队形式,更具一般性;

- 有更完善的建模体系,容易扩展;

- 继承了贝叶斯建模的优点,如模型选择等。

参考文献

- 基于用户投票的排名算法

- 游戏排名算法