CVPR2021-语义分割调研

语义分割调研(2021)

一、 Rethinking BiSeNet For Real-time Semantic Segmentation

· Paper: https://arxiv.org/abs/2104.13188

· Code: https://github.com/MichaelFan01/STDC-Seg

文章归类:图像分割,网络结构创新,实时

主体思想:

1、希望利用网络结构的改造,来弥补“感受野”受限的不足,因此BiSeNet的网络结构拥有两条主线“Spatial Path (SP)” 和 “Context Path (CP)”

2、设计了特征整合的新模块“Feature Fusion Module (FFM)” 以及 用于attention加权的模块“Attention Refinement Module (ARM)” 来提升feature maps的一个性能,让特征更具有代表性。

3、速度快(网络结构小巧)

网络整体结构:

结果:主要是速度快,105FPS

二、ViP-DeepLab: Learning Visual Perception with Depth-aware Video Panoptic Segmentation

- Paper: https://arxiv.org/abs/2012.05258

- Code: https://github.com/joe-siyuan-qiao/ViP-DeepLab

提出了一个统一的模型ViP-DeepLab,试图解决视觉反投影问题,我们将其建模为从透视图像序列恢复点云,同时为每个点提供实例级语义解释。解决这一问题需要视觉模型预测每个三维点的空间位置、语义类和时间一致的实例标签。ViP-DeepLab通过联合进行单目深度估计和视频全景分割来实现。我们将这一联合任务命名为深度感知视频全景分割,并提出了一个新的评估指标和两个衍生数据集。

三、Progressive Semantic Segmentation

- Paper: https://arxiv.org/abs/2104.03778

- Code: https://github.com/VinAIResearch/MagNet

这项工作的目标是分割高分辨率的图像,而不超载GPU内存使用或丢失输出分割图中的精细细节。

在这项工作中,提出了MagNet,一个多尺度框架,解决了局部模糊看图像在多个放大级别。MagNet有多个处理阶段,每个处理阶段对应一个放大级别,一个处理阶段的输出被送入下一个处理阶段,进行从粗到细的信息传播。每个阶段都以比前一阶段更高的分辨率分析图像,恢复之前由于有损降采样步骤而丢失的细节,并通过处理阶段逐步细化分割输出。

对城市视图、航空场景和医学图像三个高分辨率数据集的实验表明,MagNet的性能一直显著优于最先进的方法。

四、Rethinking Semantic Segmentation from a Sequence-to-Sequence Perspective with Transformers

- Paper: https://arxiv.org/abs/2012.15840

- Code: https://github.com/fudan-zvg/SETR

将语义分割视为序列到序列的预测任务,通过部署一个纯 transformer(即,不进行卷积和分辨率降低)将图像编码为一系列patch。通过在 transformer的每一层中建模全局上下文,此编码器可以与简单的解码器组合以提供功能强大的分割模型,称为SEgmentation TRansformer(SETR)

结果:大量实验表明,SETR在ADE20K(50.28%mIoU),Pascal Context(55.83%mIoU)上取得了新的技术水平

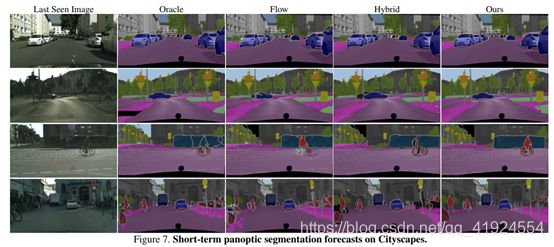

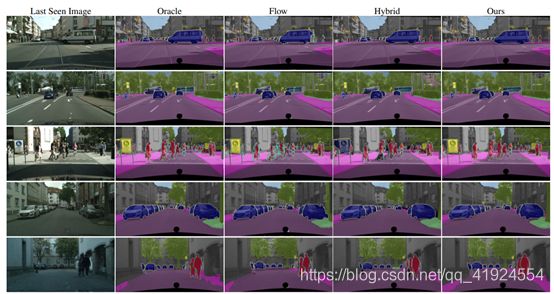

五、Panoptic Segmentation Forecasting

- Paper: https://arxiv.org/abs/2104.03962

- Code: https://github.com/nianticlabs/panoptic-forecasting

目标是根据一组最近的观察结果来预测不久的将来。优秀的预测可以通过将一个动态场景分解为单独的“事物”和背景“东西”。背景“东西”的移动很大程度上是由于摄像机的运动,而前景“东西”的移动是由于摄像机和单个物体的运动。在此分解之后,引入了全景分割预测。全景分割预测在现有的极端情况之间开辟了一个中间地带,既可以预测实例轨迹,也可以预测未来图像帧的出现。为了解决这个问题,我们开发了一个双组件模型:一个组件通过预测里程表来学习背景内容的动态,另一个组件预测被检测事物的动态。

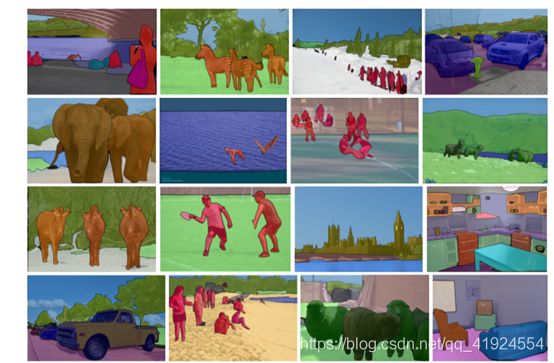

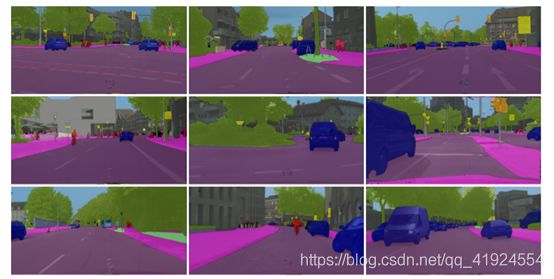

六、Fully Convolutional Networks for Panoptic Segmentation

· Paper: https://arxiv.org/abs/2012.00720

· Code: https://github.com/yanwei-li/PanopticFCN

总结:Panoptic FCN的关键思想是在全卷积的pipeline中用生成的内核统一表示和预测事物。

在本文中,该方法旨在在统一的全卷积****pipeline中表示和预测前景****things和背景****stuff。特别地,Panoptic FCN使用提出的kernel generator 将每个对象实例或填充类别编码为特定的内核权重,并通过直接卷积高分辨率特征来产生预测。

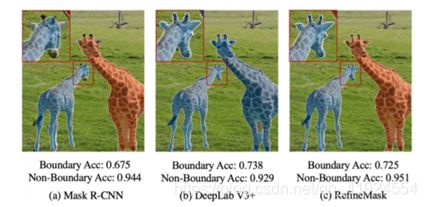

七、RefineMask: Towards High-Quality Instance Segmentation with Fine-Grained Features

- Paper: https://arxiv.org/abs/2104.08569

- Code: https://github.com/zhanggang001/RefineMask/

提出了一种名为RefineMask的高质量对象和场景实例分割的新方法,该方法在实例分割过程中以多阶段的方式融合细粒度特征通过逐步融合更详细的信息,RefineMask能够持续地细化高质量的mask。RefineMask成功地分割了困难的情况,比如被大多数以前的方法光滑过的对象的弯曲部分,并输出精确的边界。在没有附加功能的情况下,RefineMask在Coco、LVIS和Cityscapes基准上分别比Mask R-CNN获得了2.6、3.4、3.8 AP的显著收益,但只需要少量额外的计算成本。

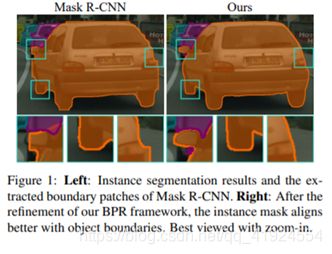

八、Look Closer to Segment Better: Boundary Patch Refinement for Instance Segmentation

- Paper: https://arxiv.org/abs/2104.05239

- Code:https://github.com/tinyalpha/BPR

提出了一个概念简单但有效的后处理细化框架,以提高基于任何实例分割模型的结果的边界质量,我们遵循更接近分割边界的思想,沿着预测的实例边界提取和细化一系列小的边界补丁。采用高分辨率的边界斑块细化网络实现细化。所提出的BPR框架在Ciryscapes基准上比Mask R-CNN基线有了显著改进,特别是在边界感知度量上。

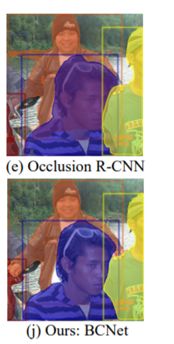

九、Deep Occlusion-Aware Instance Segmentation with Overlapping BiLayers

· Paper: https://arxiv.org/abs/2103.12340

· Code: https://github.com/lkeab/BCNet

主要是分割高度重叠的物体,将图像形成建模为两个重叠层的组成,并提出了双层卷积网络(BCNet),其中顶层****GCN层检测被遮挡的对象(occluder),底层****GCN层推断部分被遮挡的实例(occludee)。双层结构遮挡关系的显式建模可以自然解耦遮挡实例和被遮挡实例的边界,并考虑它们之间的相互作用。我们验证了双层解耦的有效性,在一级和两级目标探测器不同的骨干和网络层选择。尽管它很简单,但在COCO和KINS上的大量实验表明,我们的遮挡感知bnet获得了巨大和一致的性能增益,特别是在严重遮挡情况下。

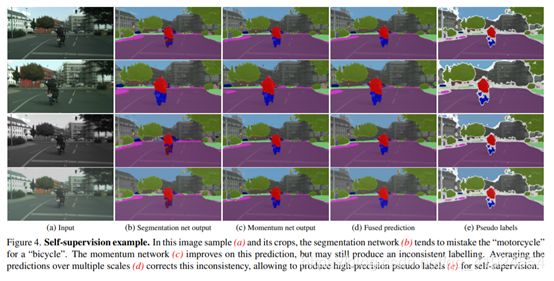

十、Self-supervised Augmentation Consistency for Adapting Semantic Segmentation

· Paper: https://arxiv.org/abs/2105.00097

· Code: https://github.com/visinf/da-sac

自适应语义切分的自监督增强一致性

提出了一种适用于语义切分的领域自适应方法。与之前的工作相比,放弃了使用涉及计算的对抗目标、网络集成和风格转移;相反,使用了标准的数据增强技术——光度噪声、翻转和缩放——并确保这些图像转换的语义预测的一致性。我们在一个轻量级的自我监督框架中开发了这一原则,该框架在共同进化的伪标签上训练,而不需要繁琐的额外训练回合。自适应后,显著提高了最先进的分割精度,在不同选择的主干架构和自适应场景中保持一致。

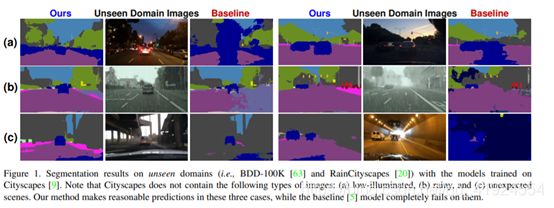

十一、RobustNet: Improving Domain Generalization in Urban-Scene Segmentation via Instance Selective Whitening

- Paper: https://arxiv.org/abs/2103.15597

- Code: https://github.com/shachoi/RobustNet

提高深度神经网络对不可见领域的泛化能力,对于现实世界中的安全关键应用(如自动驾驶)至关重要。针对这一问题,本文提出了一种新的实例选择性白化损失,以提高不可见区域分割网络的健壮性。文中的方法将特征表示的高阶统计量(即特征协方差)中编码的特定于领域的样式和领域不变的内容分开,并选择性地只删除导致领域漂移的样式信息。如图所示,我们的方法为(A)低照度,(B)多雨和(C)看不见的结构提供了合理的预测。这些类型的图像不包括在训练数据集中,在训练数据集中,基线显示性能显著下降,这与我们的情况相反。该方法简单有效,在不增加计算开销的情况下提高了各种骨干网络的健壮性。我们在城市场景分割中进行了大量的实验,并展示了我们的方法在现有工作中的优越性。

十二、Prototypical Pseudo Label Denoising and Target Structure Learning for Domain Adaptive Semantic Segmentation

域的典型伪标签去噪与目标结构学习

- Paper: https://arxiv.org/abs/2101.10979

- Code: https://github.com/microsoft/ProDA