EfficientNet介绍

EfficientNet系列介绍

- 卷积神经网络精度提升的经验

-

- EfficientNet特点

-

- 网络结构

卷积神经网络精度提升的经验

- 网络深度的增加,典型的如resnet,就是通过残差网络的堆叠,增加网络层数,以此来提升精度。

- 网络宽度的增加,通过增加每层网络的特征层数,提取更多的特征,以此来提升精度。

- 图像分辨率的增加,分辨率越高的图像,所能获取的信息越多,网络能够学习到更多的特征,从而提升精度。

EfficientNet特点

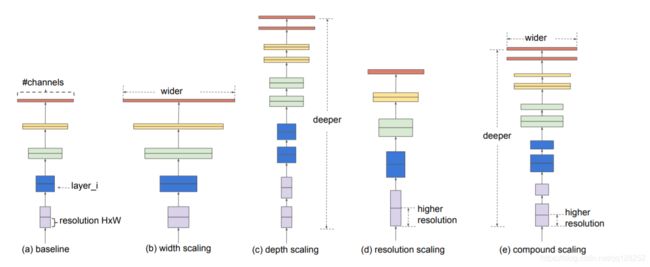

历史的实验经验表明,对于卷积神经网络的提升,着重点在于网络深度,网络宽度,分辨率这三个维度。因此,efficientnet应运而生,efficientnet结合了这三个优点,很好的平衡深度、宽度和分辨率这三个维度,通过一组固定的缩放系数统一缩放这三个维度。举个栗子,如果我们需要使用 2 N 2^N 2N的计算机资源,我们可以对网络深度放大 α N α^N αN,对网络宽度放大 β N β^N βN,对分辨率放大 γ N γ^N γN。

如上图,(a)是baseline基准网络。(b)是网络宽度的缩放。(c)是网络深度的缩放。(d)是分辨率的缩放。(e)是平衡综合网络深度,网络宽度,分辨率三个维度。

其中,baseline基准网络是通过网络结构搜索得到,基于baseline基准网络进行放大得到的一系列网络就是EfficientNet网络。

如下图,是EfficientNet和其他网络的比较,我们可以看出EfficientNet相对于其他网络,有了质的突破。

网络结构

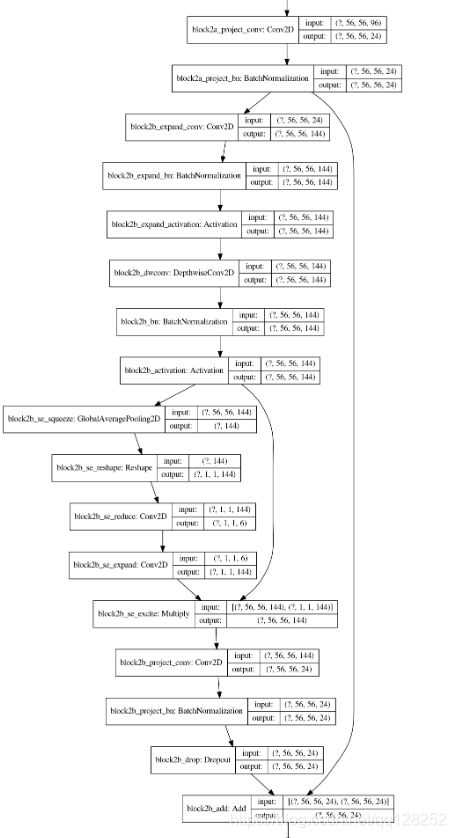

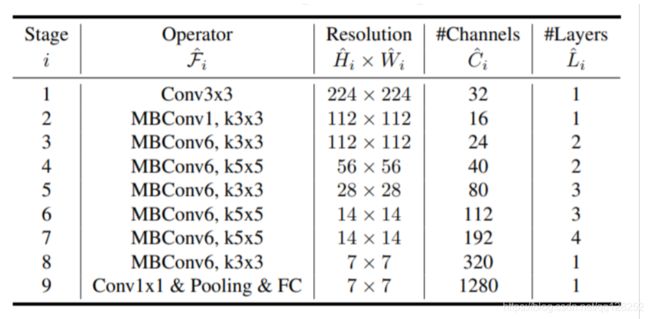

上图为EfficientNetB0的结构,B1到B7都是在此基础上进行的缩放。EfficientNetB0主要的结构在于MBConv结构的堆叠。

下面是基于keras框架下的这一模块的具体实现。

def block(inputs,

activation='swish',

drop_rate=0.,

name='',

filters_in=32,

filters_out=16,

kernel_size=3,

strides=1,

expand_ratio=1,

se_ratio=0.,

id_skip=True):

bn_axis = 3 if backend.image_data_format() == 'channels_last' else 1

# 升维设置

filters = filters_in * expand_ratio

#利用1*1的卷积核进行维度的提升

if expand_ratio != 1:

x = layers.Conv2D(

filters,

1,

padding='same',

use_bias=False,

kernel_initializer=CONV_KERNEL_INITIALIZER,

name=name + 'expand_conv')(

inputs)

x = layers.BatchNormalization(axis=bn_axis, name=name + 'expand_bn')(x)

x = layers.Activation(activation, name=name + 'expand_activation')(x)

else:

x = inputs

# 深度可分离 2D 卷积。

if strides == 2:

x = layers.ZeroPadding2D(

padding=imagenet_utils.correct_pad(x, kernel_size),

name=name + 'dwconv_pad')(x)

conv_pad = 'valid'

else:

conv_pad = 'same'

x = layers.DepthwiseConv2D(

kernel_size,

strides=strides,

padding=conv_pad,

use_bias=False,

depthwise_initializer=CONV_KERNEL_INITIALIZER,

name=name + 'dwconv')(x)

x = layers.BatchNormalization(axis=bn_axis, name=name + 'bn')(x)

x = layers.Activation(activation, name=name + 'activation')(x)

#压缩放大的系数

if 0 < se_ratio <= 1:

filters_se = max(1, int(filters_in * se_ratio))

se = layers.GlobalAveragePooling2D(name=name + 'se_squeeze')(x)

se = layers.Reshape((1, 1, filters), name=name + 'se_reshape')(se)

se = layers.Conv2D(

filters_se,

1,

padding='same',

activation=activation,

kernel_initializer=CONV_KERNEL_INITIALIZER,

name=name + 'se_reduce')(

se)

se = layers.Conv2D(

filters,

1,

padding='same',

activation='sigmoid',

kernel_initializer=CONV_KERNEL_INITIALIZER,

name=name + 'se_expand')(se)

x = layers.multiply([x, se], name=name + 'se_excite')

# 利用1*1的卷积核进行压缩

x = layers.Conv2D(

filters_out,

1,

padding='same',

use_bias=False,

kernel_initializer=CONV_KERNEL_INITIALIZER,

name=name + 'project_conv')(x)

x = layers.BatchNormalization(axis=bn_axis, name=name + 'project_bn')(x)

#残差网络的实现

if id_skip and strides == 1 and filters_in == filters_out:

if drop_rate > 0:

x = layers.Dropout(

drop_rate, noise_shape=(None, 1, 1, 1), name=name + 'drop')(x)

x = layers.add([x, inputs], name=name + 'add')

return x