人工神经网络发展史

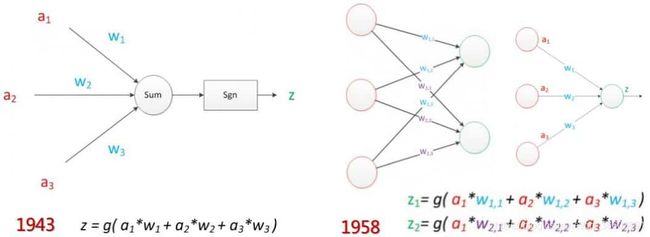

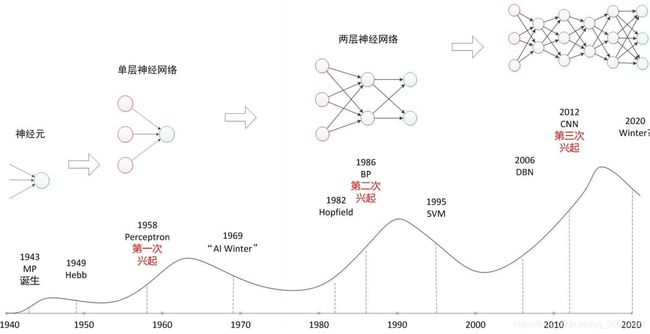

1943年,心理学家Warren McCulloch和数理逻辑学家Walter Pitts在合作的《A logical calculus of the ideas immanent in nervous activity》论文中提出并给出了人工神经网络的概念及人工神经元的数学模型,从而开创了人工神经网络研究的时代。1949年,心理学家唐纳德·赫布在《The Organization of Behavior》论文中描述了神经元学习法则。

进一步,美国神经学家Frank Rosenblatt提出可以模拟人类感知能力的机器,并称之为“感知机”。1957年,在Cornell航空实验室中,他成功在IBM704机上完成了感知机的仿真,并于1960年,实现了能够识别一些英文字母的基于感知机的神经计算机—Mark1。

第一代神经网络能够对简单的形状(如三角形、四边形)进行分类,人们逐渐认识到这种方法是使用机器实现类似于人类感觉、学习、记忆、识别的趋势。

但是,第一代神经网络的结构缺陷制约了其发展。感知机中特征提取层的参数有人手工调整,这违背了其“智能”的要求。另一方面,单层结构限制了它的学习能力,很多函数都超出了它的学习范畴。

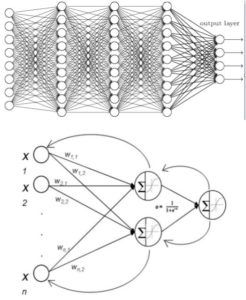

1985年,Geoffrey Hinton使用多个隐藏层来代替感知机中原先的单个特征层,并使用BP算法(Back-propagation algorithm,proposed in 1969,practicable in 1974)来计算网络参数

1989年,Yann LeCun等人使用深度神经网络来识别信件中邮编的手写体字符。后来Lecun进一步运用CNN(卷积神经网络)完成了银行支票的手写体字符识别,识别正确率达到商用级别。尽管该算法取得巨大的成功,但是它在数据集上训练了大约三天。

网络结构上分为输入层、多个隐层层和输出层,在训练网络前随机初始化权重,通过BP算法调整网络参数。BP算法并不总能很好的运行。即使使用随机梯度下降,BP算法依旧很容易陷入局部最优解。并且随着网络层数的增加,训练的难度越来越大。

第二代神经网络主要有以下缺点:

1.必须要对有标注的数据进行训练,无法对无标注数据进行训练

2.随着层数的增加,BP传回的信号会越来越弱,以至限制了网络的层数

3.在多个隐藏层之间来回传播导致训练过慢

4.其可能导致网络陷入局部最优解

5.有许多参数需要人类凭借经验和技巧进行手工设定,如网络层数、结点单元数等超参数,这些参数不能智能选取也制约了神经网络的发展。

而后人们尝试增加数据集、预估初始化权值的方法,以克服人工神经网络的缺陷。然而,SVM的出现使得人工神经网络的研究陷入寒冬。

SVM(Support Vector Machines)的简单结构使得其训练速度很快并且比较容易实现。同时,由于SVM的简单结构,其善于应对简单特征而不善于应对复杂特征。使用SVM进行学习需要对特定问题的先验知识,然而很难找到一些通用的先验知识。同时SVM的特征并不是自己选取的,而是人手工提取的。

尽管SVM在某些领域表现的很好,由于浅层结构的致命缺陷,它并不是人工智能领域好的发展趋势。

1958,Davidhubel和Torsten Wiesel进行了瞳孔区域与大脑皮层神经元对应关系的研究,发现后脑皮层中存在方向选择性细胞,大脑皮层对原始信号做低级抽象,逐渐向高级抽象迭代。

进一步的科学研究表明,和人类的许多认知能力相关的大脑皮层并不显示地预处理感知信号,而是让它们通过一个复杂的模块层次结构,久而久之,就可以根据观察结果呈现的规律来表达它们。

总的来说,人的视觉系统的信息处理是分级的,从低级的V1区提取边缘特征,再到V2区的形状或者目标的部分等,再到更高层,整个目标、目标的行为等。有就是说高层的特征是低层特征的组合,从低层到高层的特征表示越来越抽象。这一生理学发现促成了计算机人工智能,在四十年后的突破性发展。

1995年前后,Bruno Olshausen和David Field同时用生理学和计算机手段研究视觉问题。他们提出稀疏编码算法,使用400张图像碎片进行迭代,遴选出最佳的碎片权重系数。令人惊奇的是,被选中的权重基本都是照片少不同物体的边缘线,这些线段形状相似,区别在于方向。Bruno Olshausen和David Field的研究结果与四十年前David和Torsten Wiesel的生理发现不谋而合。更进一步的研究表明,深度神经网络的信息处理是分级的,和人类一样是从低级边缘特征到高层抽象表示的复杂层级结构。

研究发现这种规律不仅存在于图像中,在声音中也存在。科学家们从未标注的声音中发现了20中基本声音结构,其余的声音可以由这20中基本结构组成。1997年,LSTM(一种特殊的RNN)被提出并在自然语言理解方面具有良好效果。

2006年,Hinton提出了深度置信网络(DBN),一种深层网络模型。使用一种贪心无监督训练方法来解决问题并取得良好结果。DBN(Deep Belief Networks)的训练方法降低了学习隐藏层参数的难度。并且该算法的训练时间和网络的大小和深度近乎线性关系。

区别于传统的浅层学习,深度学习更加强调模型结构的深度,明确特征学习的重要性,通过逐层特征变换,将样本元空间特征表示变换到一个新特征空间,从而使分类或预测更加容易。与人工规则构造特征的方法相比,利用大数据来学习特征,更能够刻画数据的丰富内在信息。

相较浅层模型,深度模型具有巨大的潜力。在有海量数据的情况下,很容易通过增大模型来达到更高的正确率。深度模型可以进行无监督的特征提取,直接处理未标注数据,学习结构化特征,因此深度学习也叫做Unsupervised Feature Learning。随着GPU、FPGA等器件被用于高性能计算、神经网络硬件的出现和分布式深度学习系统的出现,深度学习的训练时间被大幅缩短,使得人们可以通过单纯的增加使用器件的数量来提升学习的速度。深层网络模型的出现,使得世界上无数难题得以解决,深度学习已成为人工智能领域最热门的研究方向。

2010年,美国国防部DARPA计划首次资助深度学习项目。

2011年,微软研究院和谷歌的语言识别研究人员先后采用DNN技术降低语音识别错误率20%-30%,是该领域10年来最大突破

2012年,Hinton将ImageNet图片分类问题的Top5错误率由26%降低至15%。同年Andrew Ng与Jeff Dean搭建Google Brain项目,用包含16000个CPU核的并行结算平台训练超过10亿个神经元的深度网络,在语音识别和图像识别领域取得突破性进展。

2013年,Hinton创立的DNN Research公司被Google收购,Yann LeCun加盟Facebook的人工智能实验室。

2014年,Google将语言识别的精准度从2012年的84%提升到如今的98%,移动端Android系统的语言识别正确率提高了25%。人脸识别方面,Google的人脸识别系统FaceNet在LFW上达到99.63%的准确率。

2015年,Microsoft采用深度神经网络的残差学习方法将Imagenet的分类错误率降低至3.57%,已低于同类试验中人眼识别的错误率5.1%,其采用的神经网络已达到152层。

2016年,DeepMind使用了1920个CPU集群和280个GPU的深度学习围棋软件AlphaGo战胜人类围棋冠军李世石。国内对深度学习的研究也在不断加速:

2012年,华为在香港成立“诺亚方舟实验室”从事自然语言处理、数据挖掘与机器学习、媒体社交、人际交互等方面的研究。

2013年,百度成立“深度学习研究院”(IDL),将深度学习应用于语言识别和图像识别、检索,2014年,Andrew Ng加盟百度。

2013年,腾讯着手建立深度学习平台Mariana,Mariana面向识别、广告推荐等众多应用领域,提供默认算法的并行实现。

2015年,阿里发布包含深度学习开放模块的DTPAI人工智能平台。

深度学习的研究已经渗透到生活的各个领域,已成为人工智能技术的主要发展方向。人工智能最终的目的是使机器具备与人相当的归纳能力,学习能力,分析能力和逻辑思考能力,虽然当前的技术离这一目标还很遥远,但是深度学习无疑提供了一种可能的途径,使得机器在单一领域的能力超越人类。