【DCANet2022】DCANet: Differential Convolution Attention Network for RGB-D Semantic Segmentation

DCANet: Differential Convolution Attention Network for RGB-D Semantic Segmentation

DCANet:用于RGB-D语义分割的差分卷积注意网络

arXiv:2210.06747v1 [eess.IV] 13 Oct 202

文章地址:https://arxiv.org/abs/2210.06747

代码地址:

摘要

结合RGB图像和相应的深度图进行语义分割,证明了近年来的有效性。现有的RGB-D模态融合方法要么缺乏非线性特征融合能力,要么对两幅模态图像一视同仁,而不考虑固有的分布差距或信息损失。在这里,我们发现由于局部深度连续性,深度贴图适合提供对象的内在细粒度模式,而RGB图像有效地提供了全局视图。基于此,我们提出了一个像素差分卷积注意(DCA)模块,用于考虑深度数据的几何信息和局部范围相关性。此外,我们将DCA扩展到集成差分卷积注意(EDCA),EDCA传播远程上下文依赖关系,并无缝合并RGB数据的空间分布。DCA和EDCA通过像素差异动态调整卷积权重,分别实现本地和远程自适应。提出了一种由DCA和EDCA组成的双分支网络,称为差分卷积网络(DCANet),用于融合双模态数据的局部和全局信息。因此,强调了RGB和深度数据的各自优势。我们的DCANet可以在两个具有挑战性的基准数据集(即NYUDv2和SUN-RGBD)上为RGBD语义分割设置最新的性能。

1导言

语义分割是计算机视觉中的一项基本任务,它可以推断场景中每个像素的语义标签。随着Kinect、Xition等三维传感器的广泛使用,可以方便地获取物体的三维几何信息,推动RGB-D语义分割的发展。对真实世界的几何信息进行编码后,RGB-D图像可用于克服2D仅在投影图像空间中显示光度外观属性的挑战,并丰富RGB图像的表示。RGB和深度图像的信息以完全不同的形式呈现。特别是,RGB图像捕获投影图像空间中的光度外观属性,而深度贴图可以为局部几何体的外观线索生成丰富的补充信息。因此,增强和融合RGB和深度数据在语义分割任务中的优势至关重要。

在真实场景中,有太多具有挑战性的图像,外观复杂。以图1为例,虽然椅子和桌子在RGB图像中是不可分割的,但它们很容易在深度上区分。显然,仅使用2D信息(如形状和颜色)将桌子和椅子分开是不可行的。虽然从深度图的角度来看,存在局部一致性信息,但这些信息不会受到类似混淆现象的限制。事实上,深度数据提供了更细粒度的局部几何差异信息,与仅使用RGB图像相比,理论上可以获得更好的分割性能。相反,正如经典的自我关注机制[54,60,63]所证实的那样,RGB数据关注更多的全局信息。

现有的方法[3, 9-11, 20, 24, 26, 29, 36, 39]试图通过引入新的卷积层和池化层、注意力机制、降噪模块等来融合RGB-D数据,以获得更好的语义分割结果。这些方法忽略了RGB和深度特征之间的内在差异,而是使用同质运算符。两类数据的权重被同等对待,以便对分割做出同样的贡献,这显然是不合适的。此外,RGB图像和深度图的信息主要是通过合并的最终通道实现的,不同通道的具体语义信息没有被考虑。

为了解决上述问题,我们提出了两种注意机制,即差分卷积注意(DCA)和集合差分卷收注意(EDCA),以提高RGB和深度数据在语义分割中的交叉模式能力。DCA使用像素差值项动态地增加标准卷积,并强制与内核中心具有类似差值的像素比其他像素对输出的贡献更大。DCA融合了局部几何信息,提高了深度数据的局部范围适应性。EDCA吸收了DCA动态卷积的优点,以传播远程上下文相关性,并无缝合并RGB数据的空间分布。同时,DCA和EDCA都避免了忽视渠道维度适应性等常见缺陷。我们的主要贡献总结如下。

-

我们提出了一个DCA模块,该模块结合了局部区域复杂的几何模式,并通过考虑局部区域像素的细微差异来实现深度数据的自适应。

-

我们将DCA扩展到EDCA,以实现远程相关性,并无缝合并RGB数据的空间分布。

-

基于DCA和EDCA,我们提出了一种在NYUDv2[47]和SUN-RGBD[48]数据集上实现最新性能的DCANet。我们还提供了对设计选择和模型变体的详细分析。

2.相关工作

2.1.RGB-D语义切分

借助额外的深度信息,这两种互补模式的组合在语义切分方面取得了很好的表现[3、9、17、27、28、45、47]。许多作品只是将RGB和深度图像的特征连接起来,以增强每个像素的语义信息[45,47]。融合方法可分为三种类型:早期融合、中期融合和晚期融合。Cao等人[3]在早期将由深度特征中的形状和基本分量分解的RGB和深度数据连接起来。然而,由于这两种模式的复杂性,由于它们的差异,单个模型无法很好地拟合它们的数据。Jiao等人[27]设计了两个编码器-解码器模块,以充分考虑RGB和深度信息,其中两个模块在后期融合。在这种方法中,RGB的不同特征与深度数据之间的交互不足,因为模态的丰富信息逐渐被压缩甚至丢失。在克服了早期和晚期融合策略的缺点后,通过融合两种不同模式的中间信息,中期融合效果更好。Gupta等人[18]将深度图像的地心嵌入与深度图像连接起来,以在中间阶段贡献最终语义信息。值得注意的是,在中间阶段融合策略中减少了分布差距,并且将多模态特征与充分的交互结合在一起。因此,最近的研究主要集中在中期融合。Chen等人[9]提出了一种空间信息引导卷积,它生成具有不同采样分布的卷积核,以增强网络和感受野调节的空间适应性。Chen等人[10]将两种模态的数据中信息最丰富的交叉模态特征统一为一种有效的表示。Lin等人[29]基于几何信息将图像分割为多个分支,其中网络的每个分支在语义上分割相关的相似特征。

我们的方法应用了两个分支,每个分支侧重于提取模态特定的特征,例如RGB图像中的颜色和纹理,以及深度图像中的几何、光照无关特征。具体来说,与中间阶段融合类似,DCA生成的关注深度特征在编码器的每个分辨率阶段都被融合到来自EDCA的关注RGB中。深度和RGB数据分别关注本地和远程信息。

2.2.注意模块

对注意模块的流行做出了巨大贡献的是,它们几乎可以在网络的任何阶段应用于对功能的全局依赖性建模。Woo等人[56]通过卷积块注意模块自适应地细化空间和信道维度的信息。受自然语言处理中自我注意网络的启发[51],这种自我注意相关模块在计算机视觉中获得了广泛关注[44,50,61]。许多研究者关注全局和局部依赖性。在[54]中,Wang等人提出了一个非局部模型,将自我关注扩展到更一般类型的非局部过滤方法,以捕获长期依赖关系。Fu等人[15]提出了两个注意模块,分别用于捕获空间和通道相关性。Cao等人[4]提出了一种基于查询独立公式的轻量级非本地网络,用于全局上下文建模。Zhu等人[63]在考虑长期依赖性和减少冗余参数的同时,整合了不同级别的特征。

我们的方法集成了DCA和EDCA,分别建立不同深度点和RGB数据点之间的关系。DCA模块支持相同对象在局部深度数据范围内具有更大的深度相似性,并且我们利用像素差异强制具有更一致几何形状的像素对相应输出做出更多贡献。EDCA模块支持RGB数据的长期依赖性。

3 方法

RGB-D语义分割需要融合来自RGB和深度模式的特征,这些特征本身是不同的。具体来说,RGB数据具有长距离的上下文依赖性和全局空间一致性,而深度数据包含局部的几何一致性。两种模式的内在特征应分别考虑,以确定每种模式的优势,同时增强两种特征表示。为此,我们提出了两个注意力模块,称为DCA和EDCA,分别捕捉深度和RGB数据的内在特征。在这一节中,我们将详细阐述所提出的DCA和EDCA的细节,然后是对所提出的差分卷积注意力网络(DCANet)的描述。

3.1. 差分卷积注意力

注意机制可以被认为是一个自适应的选择过程,它根据输入特征选择鉴别性特征,并自动忽略噪声响应[16]。注意机制的关键点是学习不同点之间的关系,并产生一个表示不同点的重要性的注意图。建立不同点之间关系的著名方法是自我注意机制[15, 54, 57, 61],它被用来捕捉长距离的依赖性。然而,由于其固有的特性,深度数据只与局部区域有关,长距离的依赖性可能会引入更多的干扰项。为此,我们探索卷积法来建立相关性,并通过考虑深度数据的局部区域来产生注意力图。

给定一个特征图 F ∈ R h × w × c F∈R^{h×w×c} F∈Rh×w×c; h 、 w h、w h、w和 c c c分别是输入特征图的高度、宽度和通道。为简单起见,我们把 X ∈ R h × w × 1 作 X∈R^{h×w×1}作 X∈Rh×w×1作为输入特征图。对于 X X X上的每个点 p ∈ R 2 p∈R^2 p∈R2,普通的卷积的计算方法为:

Y ( p ) = ∑ i = 1 k × k K i ⋅ X ( p + p i ) , (1) Y(p)=\sum_{i=1}^{k×k}K_i·X(p+p_i),\tag{1} Y(p)=i=1∑k×kKi⋅X(p+pi),(1)

其中 p i p_i pi列举了 p p p周围的局部位置。 K K K是卷积核的可学习权重,大小为 k × k k×k k×k(为简单起见,偏置项被忽略)。

在公式(1)中,普通的卷积的卷积核 K K K对任何输入都是固定的,它不能动态地感知输入的变化。然而,对于深度数据,我们希望卷积产生的注意力图能够在学习局部区域内不同点之间的相关性的同时即时感知几何信息。为此,我们探索了一个像素差异项来加权普通的卷积核,称为差分卷积核 K ∗ K^∗ K∗。

K i ∗ = K i ⋅ e x p ( − ∣ X ( p ) − X ( p + p i ) ∣ ) , (2) K^∗_i = K_i · exp(−|X(p) − X(p + p_i)|),\tag{2} Ki∗=Ki⋅exp(−∣X(p)−X(p+pi)∣),(2)

K ∗ K^∗ K∗中的差异项意味着深度数据中的几何信息,然后被正则化为 ( 0 , 1 ] (0,1] (0,1],这确保了任何两点之间的差异越大,相关性越小,反之亦然。直观地说,一个点的深度是局部连续的。在差分项的保佑下,差分卷积核 K ∗ K^∗ K∗不仅取决于输入特征,而且还取决于卷积位置。因此,对于深度数据来说,它是几何感知的。有了差分卷积核 K ∗ K^∗ K∗,输入特征图 X ∈ R h × w × 1 X∈R^{h×w×1} X∈Rh×w×1的差分卷积(DC)可以写成。

Y ( p ) = ∑ i = 1 k × k K i ∗ ⋅ X ( p + p i ) , (3) Y(p) =\sum^{ k×k}_{i=1} K^∗_i · X(p + p_i), \tag{3} Y(p)=i=1∑k×kKi∗⋅X(p+pi),(3)

如上所述,我们使用差分卷积核 K ∗ K^∗ K∗来计算局部感受野中不同点之间的相关性,而感受野的大小是与输入有关。在我们的实验中,深度数据的接受场大小为9×9。为了减少计算量,我们应用了深度可分离卷积[12],将差分卷积解耦为差分深度卷积和点卷积(1×1卷积)。对于广义的输入特征图 F ∈ R h × w × c F∈R^{h×w×c} F∈Rh×w×c,我们的DCA模块被定义为。

A t t e n t i o n = C o n v 1 × 1 ( D C − D W ( F ) ) , O u t p u t = A t t e n t i o n ⊗ F . \begin{align*} Attention &= Conv_{1×1}\left(DC-DW(\textbf{F})\right),\tag{4}\\ Output &= Attention ⊗ \textbf{F}. \end{align*} AttentionOutput=Conv1×1(DC−DW(F)),=Attention⊗F.(4)

这里,Conv1×1表示1×1卷积, D C − D W DC-DW DC−DW表示微分深度卷积,其微分核由公式(2)产生。 A t t e n t i o n ∈ R h × w × c Attention∈R^{h×w×c} Attention∈Rh×w×c表示注意力图,其大小与输入特征图 F \textbf{F} F相同。注意力图中的每个值都整合了深度图像局部范围内的几何信息,以表示每个特征的重要性。⊗表示元素明智的乘积。图2的上半部分说明了DCA的整个过程。

引入差异项的卷积核可以根据输入动态地重新平衡卷积权重。拟议的DCA模块迫使几何形状更一致的点对深度数据的相应输出做出更多贡献。总之,DCA不仅在局部空间维度上实现了灵活性,而且在通道维度上也实现了灵活性,并整合了局部范围的几何信息。值得注意的是,通道维信息在CNN中经常代表不同的对象[5, 43],这对于分割任务也是至关重要的。

3.2. 集合微分卷积注意力

如上所述,RGB数据具有长距离的上下文依赖性和全局空间一致性。虽然自我注意[54, 60, 63]是学习不同点之间关系以捕捉长距离依赖的实用方法,但它只获得空间上的适应性,而缺乏通道上的适应性。提出的DCA模块在空间维度和通道维度上都具有灵活性,它考虑了适合深度数据的局部范围的相关性。因此,对于RGB数据来说,扩展DCA以传播长距离的上下文依赖是很直观的。

最直接的方法是在DCA中使用更大的核差深度卷积。为了用比直接应用大核操作更少的计算成本和参数来捕获长距离关系,我们将基于大核的DC分解为差分深度卷积、差分深度扩张卷积和点卷积,称为集合差分卷积(EDC)。有了EDC,提议的EDCA可以写成。

F 1 = D C − D W ( F ) , F 2 = D C − D W D ( F 1 ) , A t t e n t i o n = C o n v 1 × 1 ( F 1 + F 2 ) , O u t p u t = A t t e n t i o n ⊗ F . \begin{align*} \textbf{F}_1 &= DC-DW(\textbf{F}),\\ \tag{5} \textbf{F}_2 &= DC-DWD(\textbf{F}_1),\\ Attention &= Conv_{1×1}(\textbf{F}_1 +\textbf{F}_2),\\ Output &= Attention ⊗ \textbf{F}. \end{align*} F1F2AttentionOutput=DC−DW(F),=DC−DWD(F1),=Conv1×1(F1+F2),=Attention⊗F.(5)

与DCA类似, F ∈ R h × w × c F∈R^{h×w×c} F∈Rh×w×c是输入特征图。 C o n v 1 × 1 Conv_{1×1} Conv1×1表示1×1卷积,⊗表示元素-明智的乘积。DC-DW和DC-DWD分别指差分深度卷积和差分深度扩张卷积,差分卷积核 K ∗ \textbf{K}^∗ K∗。图2显示了提议的EDCA模块。

EDC核的大小也取决于输入。在我们的实验中,DC-DW的DC核大小为5×5,DC-DWD的DC核大小为9×9,扩张3。在上述设置下,EDC的感受野大小近似为29×29。图3(d)显示了EDCA的卷积策略,为方便起见,我们显示了5×5的卷积和5×5的卷积与扩张3。据此,EDCA可以获得长距离的依赖性,而微分项动态调整卷积权重,为RGB数据提供空间分布信息。总之,基于EDCA的空间和信道适应性,判别性特征得到了提升,噪声响应被忽略了。

3.3. 理解DCA和EDCA

正如先前的工作所验证的那样,具有相同语义标签的像素在局部区域的深度相似[29, 36, 53]。DCA将几何感知能力整合到香草卷积中,并产生一个注意力图,表明深度数据中每个点的重要性。EDCA吸收了DCA动态卷积的优势,传播长距离的上下文依赖关系,并无缝地纳入RGB数据的空间分布。

| Properties | Convolution | self-attention | DCA | EDCA |

|---|---|---|---|---|

| Geometry Structure | ✘ | ✘ | ✔ | ✘ |

| Local-range dependence | ✔ | ✘ | ✔ | ✔ |

| Long-range dependence | ✘ | ✔ | ✘ | ✔ |

| Spatial adaptability | ✘ | ✔ | ✔ | ✔ |

| Channel adaptability | ✘ | ✘ | ✔ | ✔ |

如表1所示,我们提出的DCA和EDCA结合了卷积和自我关注的优势。通过用像素差异项来增强卷积核,DCA用局部接受场来捕捉几何图形。与普通卷积相比,DCA的可学习权重由几何方差来调整。在此基础上,在我们分解的大核的帮助下,EDCA被扩展到进一步捕捉满意的感受野中的精细像素差异。

3.4. DCANet结构

用于RGB-D语义分割的DCANet结构如图4所示。我们的DCANet采用DeepLabv3+[8]作为RGB-D语义分割任务的基线,其中编码器是ResNet-101[19],并保留DeepLabv3+的原始解码器。我们在DCANet中采用了双分支结构,一个用于RGB,另一个用于深度数据。

在ResNet-101的四个分辨率阶段中的每一个阶段,深度特征都通过关注和融合块融合到RGB编码器中。具体来说,两种模式的通道维度首先被挤压到1/8,以进行降维。接下来,我们同时应用深度数据的DCA和RGB数据的EDCA。第三,对DCA和EDCA的输出进行卷积,以匹配原始特征的维度,并与原始特征分别进行元素相加。最后,提取补充几何信息的深度数据通过元素相加被整合到RGB数据中,以获得更好的特征表示。注意力和融合块的输出如下。

D e p t h o u t = W 2 ( D C A ( W 1 ( D e p t h i n ) ) ) + D e p t h i n , R G B o u t = W 2 ′ ( E D C A ( W 1 ′ ( R G B i n ) ) ) + R G B i n , R G B o u t = R G B o u t + D e p t h o u t \begin{align*} Depth_{out }&= W_2 (DCA(W_1(Depth_{in}))) + Depth_{in}, \\\tag{6} RGB_{ou}t &= W'_2 (EDCA(W'_1(RGB_{in}))) + RGB_{in}, \\ RGB_{out }&= RGB_{out} + Depth_{out } \end{align*} DepthoutRGBoutRGBout=W2(DCA(W1(Depthin)))+Depthin,=W2′(EDCA(W1′(RGBin)))+RGBin,=RGBout+Depthout(6)

其中 W 1 ( W 1 ′ ) W1(W'_1) W1(W1′)和 W 2 ( W 2 ′ ) W2(W'_2) W2(W2′) 分别代表1×1卷积来挤压和恢复通道。值得注意的是,最后一个块的融合输出的RGB特征被传播到分割解码器。

4. 试验

4.1. 数据集和指标

在两个流行的RGB-D数据集上进行评估。

NYUDv2[47]。NYUDv2包含1449幅带有像素级标签的RGB-D图像。我们遵循40类设置和标准分割,有795张训练图像和654张测试图像。

SUN-RGBD[48]。这个数据集有37类物体,包含10335张RGB-D图像,其中5285张为训练图像,5050张为测试图像。

我们使用两个常见的指标来评估结果,即像素准确度(Pixel Acc.)和平均交集超过联合(mIoU)。

4.2. 实施细节

我们使用在ImageNet[46]上预训练的扩张ResNet-101[19]作为骨干网络进行特征提取,并在ResNet101的最后阶段添加另一个辅助损失。我们保持DeepLabv3+[8]的所有其他设置不变。我们使用PyTorch深度学习框架[40]来实现我们的网络,所有的模型都是用两个Nvidia Tesla V100 GPU训练的。我们采用了 "poly "策略[34],初始学习率为0.008,裁剪尺寸为480×480,批量大小为8,微调批量归一化参数[25],在训练过程中采用数据增强方法(即随机缩放、随机裁剪和左右翻转)。对于优化器,我们使用SGD,动量为0.9,权重衰减为0.0001。此外,我们对NYUDv2数据集进行了500次历时训练,对SUN-RGBD数据集进行了200次历时训练。为了与其他方法进行公平的比较,我们在推理过程中同时采用了单尺度和多尺度的测试策略。如果没有其他说明,实验是单尺度测试,表中的"∗"表示多尺度策略。

4.3. 消融研究

DCA的核大小。我们的DCA模块应用9×9、扩张1的DC核来捕捉深度数据的局部几何信息。为了证实应用9×9直流电核的有效性,我们尝试用其他直流电核大小对深度数据进行DCA,而不对RGB数据进行操作。表2中显示的结果证明,由于深度数据的局部几何性质,较大的DC核并没有带来明显的性能提升,我们的设置是有效的。

| Method | DCA | EDCA | Pixel Acc.% | mIoU% |

|---|---|---|---|---|

| Baseline | 75.1 | 47.4 | ||

| Model1 | ✔ | 76.5 | 50.9 | |

| Model2 | ✔ | 76.9 | 51.3 | |

| DCANet | ✔ | ✔ | 77.3 | 52.1 |

DCA和EDCA模块的有效性。我们对NYUDv2数据集进行了消融研究,以证明DCA和EDCA模块的不可或缺性。我们进行两个平行的DeepLabv3+(ResNet-101)作为基线。如表3所示。3所示,这两个注意力模块明显提高了性能。与基线相比,在深度数据上只采用DCA可以提高3.5%的mIoU,而在RGB数据上只采用EDCA可以提高3.9%。当我们同时应用这两个模块时,性能进一步提高到77.3%(Pixel Acc.)和52.1%(mIoU)。结果表明,这两个模块对性能的提高至关重要,并且在结合使用时效果最好。

| Self-Attention | EDCA- | EDCA | Pixel Acc.% | mIoU% |

|---|---|---|---|---|

| ✔ | 76.1 | 49.3 | ||

| ✔ | 76.3 5 | 0.1 | ||

| ✔ | 76.9 | 51.3 |

EDCA与自我关注。自我注意机制,如非局部神经网络[54],是著名的捕捉长距离依赖的方法。我们比较了自我注意和我们提出的EDCA的性能。如表所示。EDCA在mIoU和Pixel Acc.方面的表现分别优于自我注意2%和0.8%。自我注意机制是空间适应性的,但不像EDCA那样同时具有通道适应性。然而,通道适应性在分割任务中起着关键作用。此外,我们还通过去除EDCA中的差分项(称为EDCA-)来验证EDCA中差分项的有效性。表4中的结果显示,差分项为EDCA带来了1.5倍的收益。4显示,差分项给mIoU带来1.2%的改善。EDCA中的这个项在动态感知场景的同时为RGB数据提供了长距离的空间分布信息。

| RGB | Depth | Pixel Acc. | mIoU |

|---|---|---|---|

| EDCA | 76.9 | 51.3 | |

| DCA | 76.2 | 49.7 | |

| DCA | 76.5 | 50.9 | |

| EDCA | 76.1 | 49.2 |

DCA和EDCA的适用性。在拟议的DCANet中,我们在深度数据上应用DCA来捕捉局部范围的依赖性和几何信息,在RGB数据上应用EDCA来获取长距离的关联性和空间分布信息。我们还通过对深度数据应用EDCA和对RGB数据应用DCA来确认这两个模块的适用性。如表5所示。5所示,与EDCA相比,在深度上应用DCA可以提高1.7%的mIoU,在RGB上应用EDCA比DCA可以提高1.6%的mIoU。这些结果说明,DCA和EDCA分别适合于深度和RGB数据。这也说明,深度图由于其局部深度的连续性,更适合于提供物体的内在几何信息,而RGB图像则有效地提供了全局视图。

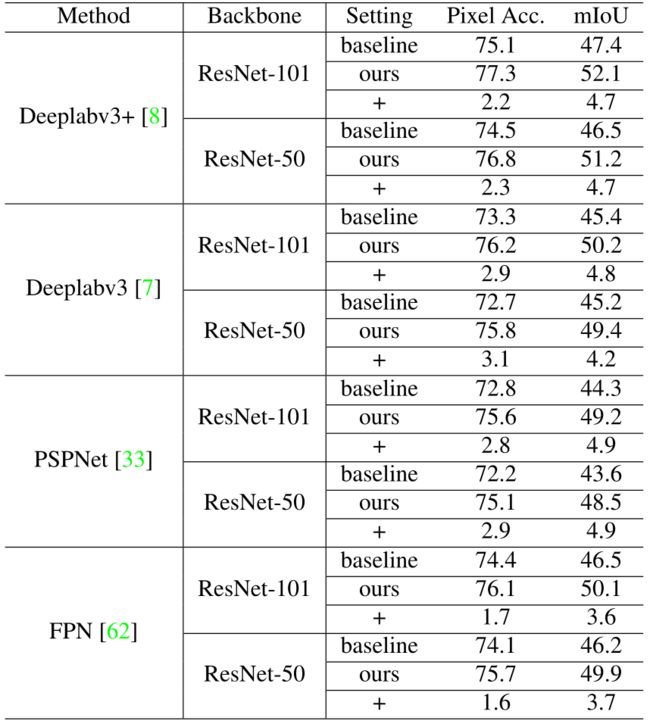

4.4. 在不同架构上的实验

我们提出的DCA和EDCA是RGB-D语义分割的通用模块,可以很容易地插入到CNN中作为语义分割的注意模块。我们的方法也被评估为与几个有代表性的语义分割架构有关。Deeplabv3+[8]、Deeplabv3[7]、PSPNet[33]和FPN[62],在NYUDv2数据集上有不同的骨架(ResNet-50、ResNet-101[19]),以验证其通用性。如表6所示,我们的方法优于其他方法。如表6所示,我们的方法在所有的设置下都以理想的幅度优于基线,证明了我们方法的泛化能力。

4.5. 与先进技术的比较

| Method | Pixel Acc.(%) | mIoU(%) |

|---|---|---|

| LSD-GF [11] | 71.9 | 45.9 |

| D-CNN [53] | - | 48.4 |

| MMAF-Net [14] | 72.2 | 44.8 |

| ACNet [23] | - | 48.3 |

| ShapeConv [3] | 75.8 | 50.2 |

| RDF [39]* | 76.0 | 50.1 |

| M2.5D [58]* | 76.9 | 50.9 |

| SGNet [9]* | 76.8 | 51.1 |

| SA-Gate [10]* | 77.9 | 52.4 |

| InverseForm [2]* | 78.1 | 53.1 |

| ShapeConv [3]* | 76.4 | 51.3 |

| DCANet | 77.3 | 52.1 |

| DCANet* | 78.2 | 53.3 |

NYUDv2。比较结果显示在表7。我们的方法取得了领先的性能。与这些方法相比,我们的模型更加关注RGB和深度数据的可变性,并应用不同的模块来增强特征表示。D-CNN[53]提出的深度感知卷积与我们的方法更为相似。为了公平比较,在单次测试中,D-CNN实现了48.4的mIoU,而我们的模型实现了52.1的socre,提高了3.7%。这是因为深度感知卷积被用来产生一个特征图,而我们的DCA和EDCA被用来产生一个注意力图,表明不同点的重要性。此外,深度感知卷积只比较深度图中局部区域的相似性,而忽略了RGB数据中的长程依赖性和全局空间一致性,这一点可以由我们的EDCA来把握。

| Method Pixel | Acc.(%) | mIoU(%) |

|---|---|---|

| 3DGNN [42] | - | 44.1 |

| D-CNN [53] | - | 42.0 |

| MMAF-Net [14] | 81.0 | 47.0 |

| SGNet [9] | 81.0 | 47.5 |

| ShapeConv [3] | 82.0 | 47.6 |

| ACNet [23] | - | 48.1 |

| 3DGNN [42]* | - | 45.9 |

| CRF [29]* | - | 48.1 |

| RDF [39]* | 81.5 | 47.7 |

| SA-Gate [10]* | 82.5 | 49.4 |

| SGNet [9]* | 82.0 | 47.6 |

| ShapeConv [3]* | 82.2 | 48.6 |

| DCANet | 82.2 | 48.1 |

| DCANet* | 82.6 | 49.6 |

SUN RGB-D。表 8显示了对SUN RGBD数据集的测试结果。与其他最先进的方法相比,DCANet在单尺度和多尺度测试中都取得了最好的结果。

5. DCANet的可视化

图5显示了NYUDv2和SUN RGB-D数据集的定性结果。从结果中,我们可以确认,深度图像中的局部几何信息和RGB图像中的全局依赖性被我们的DCA和EDCA模块很好地增强了。如右图第二行所示,我们的DCANet成功地识别了整个灯泡,包括其支架,而在强光条件下甚至无法识别。这是因为我们的模型有效地结合了两种模式数据的优势。具体来说,当物体的二维信息不可靠时,该模型会合理利用相应的几何信息。类似的例子可以在左边部分的第二行找到。

为了验证我们模型的DCA和EDCA的有效性,我们应用了基线模型和我们DCANet的响应图。如图6所示,精炼的特征图显示了我们的方法在捕捉像素级微妙信息(边缘区域)方面的分割效果,其中像素差分卷积很重要。RGB和深度数据的注意图也解释了DCA为深度数据提供了内在的细粒度的局部几何差异信息,而EDCA为RGB数据有效地提供了一个全局视图。

6. 结论

考虑到RGB和深度数据之间的内在差异,我们通过引入两个即插即用的模块,提出了一个最先进的差异卷积注意力网络。DCA和EDCA。DCA动态地感知深度数据中局部区域的微妙几何信息。EDCA吸收了DCA动态卷积的优势,以传播长距离的上下文依赖关系,并无缝地纳入RGB数据的空间分布。由DCA和EDCA产生的注意力图被用来提高特征表示,并进一步提高模型性能。

References

[1] Vijay Badrinarayanan, Alex Kendall, and Roberto Cipolla. Segnet: A deep convolutional encoder-decoder architecture for image segmentation. IEEE transactions on pattern analysis and machine intelligence, 39(12):2481–2495, 2017.

[2] Shubhankar Borse, Ying Wang, Yizhe Zhang, and Fatih Porikli. Inverseform: A loss function for structured boundary-aware segmentation. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 5901–5911, 2021. 7

[3] Jinming Cao, Hanchao Leng, Dani Lischinski, Daniel Cohen-Or, Changhe Tu, and Y angyan Li. Shapeconv:Shape-aware convolutional layer for indoor rgbd semantic segmentation. In Proceedings of the IEEE/CVF International Conference on Computer Vision, pages 7088–7097, 2021. 2, 7

[4] Y ue Cao, Jiarui Xu, Stephen Lin, Fangyun Wei, and Han Hu. Gcnet: Non-local networks meet squeeze-excitation networks and beyond. In Proceedings of the IEEE/CVF International Conference on Computer Vision Workshops, pages 0–0, 2019. 3

[5] Long Chen, Hanwang Zhang, Jun Xiao, Liqiang Nie,Jian Shao, Wei Liu, and Tat-Seng Chua. Sca-cnn:Spatial and channel-wise attention in convolutional networks for image captioning. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 5659–5667, 2017. 4

[6] Liang-Chieh Chen, George Papandreou, Iasonas Kokkinos, Kevin Murphy, and Alan L Y uille. Deeplab:Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected crfs.IEEE transactions on pattern analysis and machine intelligence, 40(4):834–848, 2017.

[7] Liang-Chieh Chen, George Papandreou, Florian Schroff, and Hartwig Adam. Rethinking atrous convolution for semantic image segmentation. arXivpreprint arXiv:1706.05587, 2017. 7

[8] Liang-Chieh Chen, Y ukun Zhu, George Papandreou,Florian Schroff, and Hartwig Adam. Encoder-decoder with atrous separable convolution for semantic image segmentation. In Proceedings of the European conference on computer vision (ECCV), pages 801–818,2018. 5, 7

[9] Lin-Zhuo Chen, Zheng Lin, Ziqin Wang, Y ong-Liang Yang, and Ming-Ming Cheng. Spatial information guided convolution for real-time rgbd semantic segmentation. IEEE Transactions on Image Processing,30:2313–2324, 2021. 2, 7

[10] Xiaokang Chen, Kwan-Y ee Lin, Jingbo Wang, Wayne Wu, Chen Qian, Hongsheng Li, and Gang Zeng. Bidirectional cross-modality feature propagation with separation-and-aggregation gate for rgb-d semantic segmentation. In European Conference on Computer Vision, pages 561–577. Springer, 2020. 2, 7

[11] Y anhua Cheng, Rui Cai, Zhiwei Li, Xin Zhao, and Kaiqi Huang. Locality-sensitive deconvolution networks with gated fusion for rgb-d indoor semantic segmentation. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 3029–3037, 2017. 2, 7

[12] Franc ¸ois Chollet. Xception: Deep learning with depthwise separable convolutions. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 1251–1258, 2017. 4

[13] Henghui Ding, Xudong Jiang, Bing Shuai, Ai Qun Liu, and Gang Wang. Semantic segmentation with context encoding and multi-path decoding. IEEE Transactions on Image Processing, 29:3520–3533,2020.

[14] Fahimeh Fooladgar and Shohreh Kasaei. Multi-

modal attention-based fusion model for semantic segmentation of rgb-depth images. arXiv preprint arXiv:1912.11691, 2019. 7

[15] Jun Fu, Jing Liu, Haijie Tian, Y ong Li, Y ongjun Bao,Zhiwei Fang, and Hanqing Lu. Dual attention network for scene segmentation. In Proceedings of the IEEE/CVF conference on computer vision and pattern recognition, pages 3146–3154, 2019. 3

[16] Meng-Hao Guo, Cheng-Ze Lu, Zheng-Ning Liu,Ming-Ming Cheng, and Shi-Min Hu. Visual attention network. arXiv preprint arXiv:2202.09741, 2022. 3

[17] Saurabh Gupta, Pablo Arbelaez, and Jitendra Malik. Perceptual organization and recognition of indoor scenes from rgb-d images. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 564–571, 2013. 2

[18] Saurabh Gupta, Ross Girshick, Pablo Arbeláez, and Jitendra Malik. Learning rich features from rgb-d images for object detection and segmentation. In European conference on computer vision, pages 345–360.Springer, 2014. 2

[19] Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun. Deep residual learning for image recognition.In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 770–778, 2016.5, 7

[20] Y ang He, Wei-Chen Chiu, Margret Keuper, and Mario Fritz. Std2p: Rgbd semantic segmentation using spatio-temporal data-driven pooling. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 4837–4846, 2017. 2

[21] Jie Hu, Li Shen, Samuel Albanie, Gang Sun, and Andrea V edaldi. Gather-excite: Exploiting feature context in convolutional neural networks. Advances in neural information processing systems, 31, 2018.

[22] Jie Hu, Li Shen, and Gang Sun. Squeeze-andexcitation networks. In Proceedings of the IEEE conference on computer vision and pattern recognition,pages 7132–7141, 2018.

[23] Xinxin Hu, Kailun Y ang, Lei Fei, and Kaiwei Wang.Acnet: Attention based network to exploit complementary features for rgbd semantic segmentation. In2019 IEEE International Conference on Image Processing (ICIP), pages 1440–1444. IEEE, 2019. 7

[24] Farzad Husain, Hannes Schulz, Babette Dellen,Carme Torras, and Sven Behnke. Combining semantic and geometric features for object class segmentation of indoor scenes. IEEE Robotics and Automation Letters, 2(1):49–55, 2016. 2

[25] Sergey Ioffe and Christian Szegedy. Batch normalization: Accelerating deep network training by reducing internal covariate shift. In International conference on machine learning, pages 448–456. PMLR, 2015. 5

[26] Jindong Jiang, Lunan Zheng, Fei Luo, and Zhijun Zhang. Rednet: Residual encoder-decoder network for indoor rgb-d semantic segmentation. arXiv preprint arXiv:1806.01054, 2018. 2

[27] Jianbo Jiao, Y unchao Wei, Zequn Jie, Honghui Shi,Rynson WH Lau, and Thomas S Huang. Geometryaware distillation for indoor semantic segmentation.In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 2869–2878, 2019. 2

[28] Salman H Khan, Mohammed Bennamoun, Ferdous Sohel, Roberto Togneri, and Imran Naseem. Integrating geometrical context for semantic labeling of indoor scenes using rgbd images. International Journal of Computer Vision, 117(1):1–20, 2016. 2

[29] Di Lin, Guangyong Chen, Daniel Cohen-Or, PhengAnn Heng, and Hui Huang. Cascaded feature network for semantic segmentation of rgb-d images. In Proceedings of the IEEE international conference on computer vision, pages 1311–1319, 2017. 2, 5, 7

[30] Guosheng Lin, Anton Milan, Chunhua Shen, and Ian Reid. Refinenet: Multi-path refinement networks for high-resolution semantic segmentation. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 1925–1934, 2017.

[31] Guosheng Lin, Chunhua Shen, Anton V an Den Hengel, and Ian Reid. Efficient piecewise training of deep structured models for semantic segmentation. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 3194–3203, 2016.

[32] Min Lin, Qiang Chen, and Shuicheng Y an. Network in network. arXiv preprint arXiv:1312.4400, 2013.

[33] Tsung-Yi Lin, Piotr Dollár, Ross Girshick, Kaiming He, Bharath Hariharan, and Serge Belongie. Feature pyramid networks for object detection. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 2117–2125, 2017. 7

[34] Wei Liu, Andrew Rabinovich, and Alexander C Berg.Parsenet: Looking wider to see better. arXiv preprint arXiv:1506.04579, 2015. 5

[35] Jonathan Long, Evan Shelhamer, and Trevor Darrell.Fully convolutional networks for semantic segmentation. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 3431–3440, 2015.

[36] Haiyang Mei, Bo Dong, Wen Dong, Pieter Peers, Xin Y ang, Qiang Zhang, and Xiaopeng Wei. Depth-aware mirror segmentation. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 3044–3053, 2021. 2, 5

[37] Vinod Nair and Geoffrey E Hinton. Rectified linear units improve restricted boltzmann machines. In Icml,2010.

[38] Timo Ojala, Matti Pietikainen, and Topi Maenpaa.Multiresolution gray-scale and rotation invariant texture classification with local binary patterns. IEEE Transactions on pattern analysis and machine intelligence, 24(7):971–987, 2002.

[39] Seong-Jin Park, Ki-Sang Hong, and Seungyong Lee.Rdfnet: Rgb-d multi-level residual feature fusion for indoor semantic segmentation. In Proceedings of the IEEE international conference on computer vision,pages 4980–4989, 2017. 2, 7

[40] Adam Paszke, Sam Gross, Francisco Massa, Adam Lerer, James Bradbury, Gregory Chanan, Trevor Killeen, Zeming Lin, Natalia Gimelshein, Luca Antiga, et al. Pytorch: An imperative style, highperformance deep learning library. Advances in neural information processing systems, 32, 2019. 5

[41] Lu Qi, Li Jiang, Shu Liu, Xiaoyong Shen, and Jiaya Jia. Amodal instance segmentation with kins dataset.In Proceedings of the IEEE/CVF Conference on Com-puter Vision and Pattern Recognition, pages 3014–3023, 2019.

[42] Xiaojuan Qi, Renjie Liao, Jiaya Jia, Sanja Fidler, and Raquel Urtasun. 3d graph neural networks for rgbd semantic segmentation. In Proceedings of the IEEE International Conference on Computer Vision, pages 5199–5208, 2017. 7

[43] Xu Qin, Zhilin Wang, Y uanchao Bai, Xiaodong Xie,and Huizhu Jia. Ffa-net: Feature fusion attention network for single image dehazing. In Proceedings of the AAAI Conference on Artificial Intelligence, volume 34, pages 11908–11915, 2020. 4

[44] Prajit Ramachandran, Niki Parmar, Ashish V aswani,Irwan Bello, Anselm Levskaya, and Jon Shlens.Stand-alone self-attention in vision models. Advances in Neural Information Processing Systems, 32, 2019.2

[45] Xiaofeng Ren, Liefeng Bo, and Dieter Fox. Rgb-(d)scene labeling: Features and algorithms. In 2012 IEEE Conference on Computer Vision and Pattern Recognition, pages 2759–2766. IEEE, 2012. 2

[46] Olga Russakovsky, Jia Deng, Hao Su, Jonathan Krause, Sanjeev Satheesh, Sean Ma, Zhiheng Huang,Andrej Karpathy, Aditya Khosla, Michael Bernstein,et al. Imagenet large scale visual recognition challenge. International journal of computer vision,115(3):211–252, 2015. 5

[47] Nathan Silberman, Derek Hoiem, Pushmeet Kohli,and Rob Fergus. Indoor segmentation and support inference from rgbd images. In European conference on computer vision, pages 746–760. Springer, 2012. 2, 5

[48] Shuran Song, Samuel P Lichtenberg, and Jianxiong Xiao. Sun rgb-d: A rgb-d scene understanding benchmark suite. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 567–576, 2015. 2, 5

[49] Nitish Srivastava, Geoffrey Hinton, Alex Krizhevsky,Ilya Sutskever, and Ruslan Salakhutdinov. Dropout:a simple way to prevent neural networks from overfitting. The journal of machine learning research,15(1):1929–1958, 2014.

[50] Ashish V aswani, Prajit Ramachandran, Aravind Srinivas, Niki Parmar, Blake Hechtman, and Jonathon Shlens. Scaling local self-attention for parameter efficient visual backbones. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 12894–12904, 2021. 2

[51] Ashish V aswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, Łukasz Kaiser, and Illia Polosukhin. Attention is all you need. Advances in neural information processing systems,30, 2017. 2

[52] Fei Wang, Mengqing Jiang, Chen Qian, Shuo Y ang,Cheng Li, Honggang Zhang, Xiaogang Wang, and Xiaoou Tang. Residual attention network for image classification. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 3156–3164, 2017.

[53] Weiyue Wang and Ulrich Neumann. Depth-aware cnn for rgb-d segmentation. In Proceedings of the European Conference on Computer Vision (ECCV), pages 135–150, 2018. 5, 7

[54] Xiaolong Wang, Ross Girshick, Abhinav Gupta, and Kaiming He. Non-local neural networks. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 7794–7803, 2018. 2, 3, 4,6

[55] Yikai Wang, Xinghao Chen, Lele Cao, Wenbing Huang, Fuchun Sun, and Y unhe Wang. Multimodal token fusion for vision transformers. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 12186–12195, 2022.

[56] Sanghyun Woo, Jongchan Park, Joon-Y oung Lee, and In So Kweon. Cbam: Convolutional block attention module. In Proceedings of the European conference on computer vision (ECCV), pages 3–19, 2018. 2

[57] Enze Xie, Wenhai Wang, Zhiding Y u, Anima Anandkumar, Jose M Alvarez, and Ping Luo. Segformer:Simple and efficient design for semantic segmentation with transformers. Advances in Neural Information Processing Systems, 34, 2021. 3

[58] Y ajie Xing, Jingbo Wang, and Gang Zeng. Malleable 2.5 d convolution: Learning receptive fields along the depth-axis for rgb-d scene parsing. In European Conference on Computer Vision, pages 555–571. Springer,2020. 7

[59] Hanrong Y e and Dan Xu. Inverted pyramid multitask transformer for dense scene understanding. arXiv preprint arXiv:2203.07997, 2022.

[60] Han Zhang, Ian Goodfellow, Dimitris Metaxas, and Augustus Odena. Self-attention generative adversarial networks. In International conference on machine learning, pages 7354–7363. PMLR, 2019. 2, 4

[61] Hengshuang Zhao, Jiaya Jia, and Vladlen Koltun. Exploring self-attention for image recognition. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 10076–10085,2020. 2, 3

[62] Hengshuang Zhao, Jianping Shi, Xiaojuan Qi, Xiaogang Wang, and Jiaya Jia. Pyramid scene parsing network. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 2881–2890, 2017. 7

[63] Zhen Zhu, Mengde Xu, Song Bai, Tengteng Huang,and Xiang Bai. Asymmetric non-local neural networks for semantic segmentation. In Proceedings of the IEEE/CVF International Conference on Computer Vision, pages 593–602, 2019. 2, 3, 4