[论文阅读笔记43]Hierarchical Multi-Label Classification Networks

一,题目

Hierarchical Multi-Label Classification Networks

层次多标签分类网络

Wehrmann J , R Cerri, Barros R C . Hierarchical Multi-Label Classification Networks[C]// International Conference on Machine Learning. 2019.

里奥格兰德天主大学 – 巴西

圣卡洛斯联邦大学 – 巴西

二,摘要

主要解决层次多标签分类问题;提出HMCN可以同时优化局部和全局损失函数,以发现整个类层次结构中的局部层次类关系和全局信息,同时惩罚层次违规。

使用了21个数据集进行估计,取得SOA;

HMC : hierarchical multi-label classification

HMCN, hierarchical multi-label classification Networks

三,相关背景与技术

问题:类不是互不是不相交的,而且是分层的关系,即HC(hierarchical classification),分层分类。基于这个任务,有可能返回的分类结果是一个父类或所有的子类。可以用树或有向图来形式化这个分层关系。在HC中,有一类分类是每个对象都可以与类层次结构的几个不同路径相关联,即HMC。

解决HMC问题的算法优化上,不管是局部或者全局的维度,都是从损失函数出发;

一般的思路是从局部或者全局的优化上进行组合去优化。

基于Predictive Clustering Trees (PCT):

| Clus-HMC | 是一种全局方法,它引入单一的决策树来处理整个类层次结构 | 2008 - Decision trees for hierarchical multi-label classification |

| Clus-HMC-Ens | 提出了一种生成Clus-HMC树集合的装袋策略 | 2010 - Predicting gene function using hierarchical multi-label decision tree ensembles |

| 研究了与FunCat注释基因中基因功能预测相关的不同局部性策略之间的协同作用 | Synergy of multi-label hierarchical ensembles, data fusion, and costsensitive methods for gene functional inference | |

| 在cost-sensitive方法中集成了核数据工具与集成算法 | Hierarchical cost-sensitive algorithms for genome-wide gene function prediction | |

| 在cost-sensitive方法中集成了核数据工具与集成算法 | True path rule hierarchical ensembles for genome-wide gene function prediction | |

| HMC-LMLP | 一种基于多层感知器(MLPs)链的局部HMC方法,每个链都有一个隐藏层 | 2011 - Hierarchical multi-label classification for protein function prediction: A local approach based on neural networks;2013 - Hierarchical multi-label classification using local neural networks;2016 - Reduction Strategies for Hierarchical Multi-Label Classification in Protein Function Prediction |

| kernel dependency estimation (KDE),CSSA | 提出树或图的转换方法,它使用内核依赖估计(KDE)将标签的数量减少到可管理的单标签学习问题。 | 2011 - Multi-Label Classification on Tree- and DAG-Structured Hierarchies |

| 把连续的分数转化成二元性 | 2016 - Labelling strategies for hierarchical multi-label classification techniques. | |

| PLS+OPP | 把分类问题转化为路径问题 | 2016 - Hierarchical multilabel classification with optimal path prediction |

四,模型

HMCN:提出递归和非递归神经网络结构两个版本。

4.1 HMCN-F模型

前向模型

两条信息流:

流1:主信息流(全局信息流),从输入层,穿过所有全连接(FC)层,直达全局输出层;负责将信息从第i层传递到第i+1层;它受到本地输出的影响,这些输出通过每个级别类集的反向传播梯度加强了全局信息流内的局部层次关系。

流2:局部信息流,从输入层开始,经过它们各自的全局FC层,但也通过特定的局部FC层,最后以相应的本地输出结束。

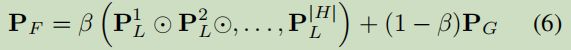

局部的所有输出,经级联起来,再由全局输出进行一致性池化操作,输出最后的结果。

整个过程采用前计算,分类的有多少层,这个前向网络就有多少层:

第1层:

第h层(h>1):

对照上面那个网络图,是加入了x信息,这个有点像是残差网络的感觉, ⊙表示两个向量级连起来。

全局信息:

对照一下图不一致,这里没有x的输入了。以哪个为准呢?

P_G是一个概率向量;

局部信息层情况:

W_T那个是转移矩阵,作用是对A矩阵作变换,后面那个W_L是要学习的参数;

对全局与局部信息的整合,参数β**∈ [0*,* 1] 表示对全局与局部的整合权重。

4.2 HMCN-R模型

由于HMCN-F模型的层数随着分层数据增加,参数很自然也在增多了。

循环模型—基于LSTM进行修改

对比较LSTM来看:

论文提出:

输出:

与HMCN-F处理局部信息一样,把![]() 经过矩阵投影成局部信息P_L。

经过矩阵投影成局部信息P_L。

4.3 Loss Function

最就化局部与全局信息:

由于标签是可以相交的,所以用二元交叉熵来定义:

这个损失函数不能保证网络会预测层次路径一致性,提出分级惩罚(当子类的分数比父类分类大时,这个惩罚机制就产生作用):

最终的损失函数:

五,实验

对比较的模型(4个):

ClusHMC (Vens et al., 2008)

Clus-HMC-Ens (Schietgat et al.,2010),

CSSA (Bi & Kwok, 2011),

HMC-LMLP (Cerriet al., 2016)

数据集(21个):

实验结果:

模型结构分析–以HMCN-F为例:

这个是以GloBAL ONLY作为基准,一步步增加乏力的结果。输入重用在很大程度上提高了网络的性能。

分层惩罚机制分析:

六,总结

这个论文讲述的思路比较详细与清晰,实验过程也是很清楚的。

by happyprince https://blog.csdn.net/ld326/article/details/118558876

![[论文阅读笔记43]Hierarchical Multi-Label Classification Networks_第1张图片](http://img.e-com-net.com/image/info8/21fe7af2186149e28460824b5ef634f0.jpg)

![[论文阅读笔记43]Hierarchical Multi-Label Classification Networks_第2张图片](http://img.e-com-net.com/image/info8/b0f7784c6ecf4290903feb107fc0dfed.jpg)

![[论文阅读笔记43]Hierarchical Multi-Label Classification Networks_第3张图片](http://img.e-com-net.com/image/info8/b249d031caaf48d5add14e4f55654688.jpg)

![[论文阅读笔记43]Hierarchical Multi-Label Classification Networks_第4张图片](http://img.e-com-net.com/image/info8/da1ed60b9a7d43f2a036b725619e06f8.jpg)

![[论文阅读笔记43]Hierarchical Multi-Label Classification Networks_第5张图片](http://img.e-com-net.com/image/info8/7a5a501ec16a44cd981c7f7a8edf1d5e.jpg)

![[论文阅读笔记43]Hierarchical Multi-Label Classification Networks_第6张图片](http://img.e-com-net.com/image/info8/27a018ed24aa482aa011c3fca8fcd004.jpg)

![[论文阅读笔记43]Hierarchical Multi-Label Classification Networks_第7张图片](http://img.e-com-net.com/image/info8/f727cccb63d94207ab61c99c85ba6f99.jpg)

![[论文阅读笔记43]Hierarchical Multi-Label Classification Networks_第8张图片](http://img.e-com-net.com/image/info8/20bc941aa9e740d5a7d5327d81046f44.jpg)

![[论文阅读笔记43]Hierarchical Multi-Label Classification Networks_第9张图片](http://img.e-com-net.com/image/info8/1c5d555de03b4c88bb0508b312fc22f6.jpg)

![[论文阅读笔记43]Hierarchical Multi-Label Classification Networks_第10张图片](http://img.e-com-net.com/image/info8/2c0248f57cd3466d9bb205a1fc1759da.jpg)

![[论文阅读笔记43]Hierarchical Multi-Label Classification Networks_第11张图片](http://img.e-com-net.com/image/info8/d18bf1350b0b4a299f87628778a49418.jpg)