- yum install locate出现Error: Unable to find match: locate解决方案

爱编程的喵喵

Linux解决方案linuxlocateyum解决方案

大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。喜欢通过博客创作的方式对所学的知识进行总结与归纳,不仅形成深入且独到的理解,而且能够帮助新手快速入门。 本文主要介绍了yuminstalllocate出现

- GraphCube、Spark和深度学习技术赋能快消行业关键运营环节

weixin_30777913

开发语言大数据深度学习人工智能spark

在快消品(FMCG)行业,需求计划(DemandPlanning)、库存管理(InventoryManagement)和需求供应管理(DemandSupplyManagement)是影响企业整体效率和利润水平的关键运营环节。GraphCube图多维数据集技术、Spark大数据分析处理技术和深度学习技术的结合,为这些环节提供了智能化、动态化和实时化的解决方案,显著提升业务运营效率和企业利润。一、技术

- 【人工智能机器学习基础篇】——深入详解无监督学习之降维:PCA与t-SNE的关键概念与核心原理

猿享天开

人工智能数学基础专讲人工智能机器学习无监督学习降维

深入详解无监督学习之降维:PCA与t-SNE的关键概念与核心原理在当今数据驱动的世界中,数据维度的增多带来了计算复杂性和存储挑战,同时也可能导致模型性能下降,这一现象被称为“维度诅咒”(CurseofDimensionality)。降维作为一种重要的特征提取和数据预处理技术,旨在通过减少数据的维度,保留其主要信息,从而简化数据处理过程,并提升模型的性能。本文将深入探讨两种广泛应用于无监督学习中的降

- Flink启动任务

swg321321

flink大数据

Flink以本地运行作为解读例如:第一章Python机器学习入门之pandas的使用提示:写完文章后,目录可以自动生成,如何生成可参考右边的帮助文档文章目录Flink前言StreamExecutionEnvironmentLocalExecutorMiniClusterStreamGraph二、使用步骤1.引入库2.读入数据总结前言提示:这里可以添加本文要记录的大概内容:例如:随着人工智能的不断发

- 计算机专业毕业设计题目推荐(新颖选题)本科计算机人工智能专业相关毕业设计选题大全✅

会写代码的羊

毕设选题课程设计人工智能毕业设计毕设题目毕业设计题目aiAI编程

文章目录前言最新毕设选题(建议收藏起来)本科计算机人工智能专业相关的毕业设计选题毕设作品推荐前言2025全新毕业设计项目博主介绍:✌全网粉丝10W+,CSDN全栈领域优质创作者,博客之星、掘金/华为云/阿里云等平台优质作者。技术范围:SpringBoot、Vue、SSM、HLMT、Jsp、PHP、Nodejs、Python、爬虫、数据可视化、小程序、大数据、机器学习等设计与开发。主要内容:免费功能

- 【机器学习】建模流程

CH3_CH2_CHO

什么?!是机器学习!!机器学习人工智能线性回归逻辑回归

1、数据获取1.1来源数据获取是机器学习建模的第一步,常见的数据来源包括数据库、API、网络爬虫等。数据库是企业内部常见的数据存储方式,例如:MySQL、Oracle等关系型数据库,以及MongoDB等非关系型数据库,它们能够存储大量的结构化和非结构化数据API(应用程序编程接口)提供了从外部获取数据的便捷方式,例如:社交媒体平台的API可以获取用户发布的内容和互动信息网络爬虫则适用于从网页中提取

- Marker可以快速且准确地将PDF转换为markdown格式。

星霜笔记

开源关注简介免费源码pdf

MarkerMarker可以快速且准确地将PDF转换为markdown格式。支持多种文档类型(针对书籍和科学论文进行了优化)支持所有语言移除页眉/页脚/其他杂质格式化表格和代码块提取并保存图像以及markdown将大多数方程转换为latex支持在GPU、CPU或MPS上运行工作原理Marker是一个由深度学习模型组成的管道:提取文本,必要时进行OCR处理(启发式算法,surya,tesseract

- Hugging Face预训练GPT微调ChatGPT(微调入门!新手友好!)

y江江江江

机器学习大模型gptchatgpt

HuggingFace预训练GPT微调ChatGPT(微调入门!新手友好!)在实战中,⼤多数情况下都不需要从0开始训练模型,⽽是使⽤“⼤⼚”或者其他研究者开源的已经训练好的⼤模型。在各种⼤模型开源库中,最具代表性的就是HuggingFace。HuggingFace是⼀家专注于NLP领域的AI公司,开发了⼀个名为Transformers的开源库,该开源库拥有许多预训练后的深度学习模型,如BERT、G

- Open-Sora - 为所有人实现高效的视频制作大众化

小众AI

AI开源音视频人工智能AI编程

GitHub:https://github.com/hpcaitech/Open-Sora更多AI开源软件:发现分享好用的AI工具、AI开源软件、AI模型、AI变现-小众AI这是一款开源的SOTA(State-of-the-Art)视频生成模型,仅用20万美元(224张GPU)就能训练出商业级11B参数的视频生成大模型。它采用Python语言和PyTorch深度学习框架开发,具有生成速度快、资源消

- 图像识别技术与应用课后总结(20)

一元钱面包

人工智能

图像分割概念图像分割是把图像中不同像素划分到不同类别,预测目标轮廓,属于细粒度分类。比如将图像里不同物体、背景等区分开来,就像把一幅画里的各个元素精准归类。应用场景人像抠图:能精准分离人物和背景,用于图片编辑、影视制作等,比如去除照片背景换背景。医学组织提取:在医学影像(如CT、MRI图像)中分离出不同组织,辅助疾病诊断、手术规划等。遥感图像分析:分析卫星或航空遥感图像时,区分土地、植被、建筑等不

- 机器学习课堂4线性回归模型+特征缩放

木尘152132

机器学习线性回归python

一、实验2-2,线性回归模型,计算模型在训练数据集和测试数据集上的均方根误差代码:#2-2线性回归模型importpandasaspdimportnumpyasnpimportmatplotlib.pyplotasplt#参数设置iterations=3000#迭代次数learning_rate=0.0001#学习率m_train=3000#训练样本的数量flag_plot_lines=False

- Adam-mini:深度学习内存效率新突破

XianxinMao

人工智能深度学习人工智能

标题:Adam-mini:深度学习内存效率新突破文章信息摘要:Adam-mini优化器在深度学习领域展现出突破性潜力,尤其在内存效率和计算性能上表现卓越。相比AdamW,Adam-mini将内存效率提升了一倍,并通过减少学习率数量显著降低了内存消耗,同时保持了与AdamW相当甚至更好的性能。在训练十亿参数级别的大语言模型(LLM)时,Adam-mini实现了49.6%的吞吐量提升,并减少了33%的

- 【机器学习】模型拟合

CH3_CH2_CHO

什么?!是机器学习!!机器学习人工智能欠拟合过拟合

1、欠拟合1.1现象欠拟合是机器学习和统计建模中的一种常见问题,表现为模型无法充分捕捉数据中的潜在规律和模式。无论是训练数据还是测试数据,模型的预测误差都居高不下。在实际应用中,欠拟合的模型往往显得过于简单和粗糙,无法对数据进行有效的拟合和描述。1.2原因模型过于简单是导致欠拟合的主要原因:例如,使用直线去拟合具有明显曲线趋势的数据,或者使用低阶多项式去拟合高阶的复杂函数关系。这种情况下,模型的表

- Transformer与图神经网络的融合与应用

AI天才研究院

DeepSeekR1&大数据AI人工智能大模型AI大模型企业级应用开发实战计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

Transformer与图神经网络的融合与应用关键词:Transformer,图神经网络,注意力机制,图结构数据,图表示学习,图分类,图生成1.背景介绍近年来,深度学习技术在各个领域取得了显著的进展。其中,Transformer模型和图神经网络(GraphNeuralNetworks,GNNs)是两个备受关注的研究方向。Transformer最初应用于自然语言处理领域,通过自注意力机制实现了并行计

- 深度学习的颠覆性发展:从卷积神经网络到Transformer

AI天才研究院

AI大模型应用入门实战与进阶ChatGPT大数据人工智能语言模型AILLMJavaPython架构设计AgentRPA

1.背景介绍深度学习是人工智能的核心技术之一,它通过模拟人类大脑中的神经网络学习从大数据中抽取知识,从而实现智能化的自动化处理。深度学习的发展历程可以分为以下几个阶段:2006年,GeoffreyHinton等人开始研究卷积神经网络(ConvolutionalNeuralNetworks,CNN),这是深度学习的第一个大突破。CNN主要应用于图像处理和语音识别等领域。2012年,AlexKrizh

- 高性能计算:GPU加速与分布式训练

AI天才研究院

DeepSeekR1&大数据AI人工智能大模型AI大模型企业级应用开发实战计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

1.背景介绍随着人工智能技术的飞速发展,深度学习模型的规模和复杂度不断提升,对计算能力的需求也越来越高。传统的CPU架构已经难以满足深度学习模型训练的需求,因此,GPU加速和分布式训练成为了高性能计算领域的研究热点。1.1.深度学习与计算挑战深度学习模型通常包含数百万甚至数十亿个参数,训练过程需要进行大量的矩阵运算和梯度更新,对计算资源的需求非常高。传统的CPU架构虽然具有较强的通用性,但其并行计

- 基于Python的智能决策支持系统:实现智能化决策的关键要素

AI天才研究院

DeepSeekR1&大数据AI人工智能大模型自然语言处理人工智能语言模型编程实践开发语言架构设计

文章目录基于Python的智能决策支持系统:实现智能化决策的关键要素11.背景介绍2.核心概念与联系数据收集与预处理模型构建与训练决策规则生成与优化决策结果评估与反馈3.核心算法原理具体操作步骤数据挖掘算法机器学习算法优化算法4.数学模型和公式详细讲解举例说明线性回归模型最小二乘法5.项目实践:代码实例和详细解释说明6.实际应用场景金融领域医疗领域供应链管理智能制造7.工具和资源推荐编程语言和开发

- 使用 MistralAI 平台进行开源模型托管与调用

VYSAHF

python

MistralAI是一个提供开放源码模型托管的平台,致力于帮助开发者更轻松地使用和管理开源模型。通过该平台,你可以方便地调用强大的深度学习模型,并将其集成到你的应用中。本文将带你了解如何利用MistralAI提供的服务来进行模型的托管和调用。技术背景介绍MistralAI的服务包括了如聊天模型和嵌入模型等,这些模型适用于聊天机器人、文本嵌入等各种场景。使用这些模型需要注册并获取一个有效的API密钥

- AI 大模型应用数据中心的数据迁移架构

AGI大模型与大数据研究院

DeepSeekR1&大数据AI人工智能javapythonjavascriptkotlingolang架构人工智能

AI大模型、数据中心、数据迁移、架构设计、迁移策略、性能优化、安全保障1.背景介绍随着人工智能(AI)技术的飞速发展,大规模AI模型的应用日益广泛,涵盖了自然语言处理、计算机视觉、语音识别等多个领域。这些AI模型通常需要海量的数据进行训练和推理,因此数据中心作为AI应用的基础设施,显得尤为重要。然而,随着AI模型规模的不断扩大,数据中心面临着新的挑战:数据规模庞大:AI模型的训练和推理需要海量数据

- DeepLabv3+改进18:在主干网络中添加REP_BLOCK

AICurator

深度学习python机器学习deeplabv3+语义分割

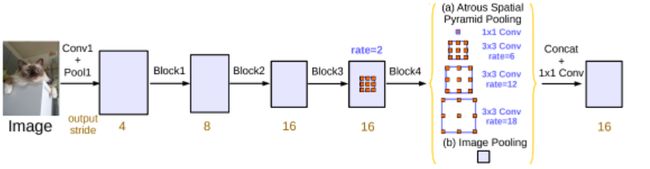

【DeepLabv3+改进专栏!探索语义分割新高度】你是否在为图像分割的精度与效率发愁?本专栏重磅推出:✅独家改进策略:融合注意力机制、轻量化设计与多尺度优化✅即插即用模块:ASPP+升级、解码器PS:订阅专栏提供完整代码论文简介我们提出了一种通用的卷积神经网络(ConvNet)构建模块,可在不增加推理时间成本的情况下提升性能。该模块名为多样化分支块(DBB),通过结合不同尺度和复杂度的多样化分支

- 暗光增强技术研究进展与产品落地综合分析(2023-2025)

AndrewHZ

深度学习新浪潮图像处理算法动态范围计算机视觉深度学习transformer暗光增强

一、引言暗光增强技术作为计算机视觉与移动影像领域的核心研究方向之一,近年来在算法创新、硬件适配及产品落地方面取得了显著进展。本文从技术研究与产业应用两个维度,系统梳理近三年(2023-2025)该领域的关键突破,并对比分析主流手机厂商的影像技术优劣势。二、暗光增强技术研究进展1.算法创新:从传统模型到深度学习(1)Retinex理论的深度结合清华与ETH联合提出的Retinexformer(202

- 金融风控算法透明度与可解释性优化

智能计算研究中心

其他

内容概要金融风控算法的透明化研究面临模型复杂性提升与监管合规要求的双重挑战。随着深度学习框架在特征提取环节的广泛应用,算法可解释性与预测精度之间的平衡成为核心议题。本文从联邦学习架构下的数据协作机制出发,结合特征工程优化与超参数调整技术,系统性分析逻辑回归、随机森林等传统算法在召回率、F1值等关键指标上的表现差异。研究同时探讨数据预处理流程对风控决策鲁棒性的影响,并提出基于注意力机制的特征权重可视

- 下一代模型技术演进与场景应用突破

智能计算研究中心

其他

内容概要当前模型技术正经历多维度的范式跃迁,可解释性模型与自动化机器学习(AutoML)成为突破传统黑箱困境的核心路径。在底层架构层面,边缘计算与量子计算的融合重构了算力分配模式,联邦学习技术则为跨域数据协作提供了安全可信的解决方案。主流框架如TensorFlow和PyTorch持续迭代优化能力,通过动态参数压缩与自适应超参数调优策略,显著提升模型部署效率。应用层创新呈现垂直化特征,医疗诊断模型通

- H800核心性能优化技术

智能计算研究中心

其他

内容概要作为新一代AI加速卡的核心创新载体,H800通过异构计算架构与动态能效管理技术的协同设计,实现了从硬件底层到应用层的系统性优化。其技术突破聚焦于张量核心重构带来的计算密度提升、混合精度运算对资源利用率的增强,以及智能散热方案在复杂负载场景下的稳定性保障。这些创新不仅显著提升了30%以上的能效比,更通过精细化任务调度机制,解决了深度学习训练中高并发数据处理与模型参数同步的效率瓶颈。值得关注的

- TikTokenizer 项目常见问题解决方案

齐飞锴Timothea

TikTokenizer项目常见问题解决方案tiktokenizerOnlineplaygroundforOpenAPItokenizers项目地址:https://gitcode.com/gh_mirrors/ti/tiktokenizer项目基础介绍TikTokenizer是一个开源项目,主要用于文本处理,特别是将文本转化为可用于深度学习的格式。该项目是基于TensorFlow和Keras开发

- TypeScript语言的计算机视觉

苏墨瀚

包罗万象golang开发语言后端

使用TypeScript进行计算机视觉:一个现代化的探索引言随着人工智能和机器学习的快速发展,计算机视觉(ComputerVision)成为了一个极具活力的研究领域。计算机视觉旨在使计算机能够“看”和“理解”数字图像或视频中的内容。近年来,TypeScript作为一种现代化的编程语言,因其类型安全和更好的开发体验,逐渐在前端和后端开发中得到了广泛应用。本文将探讨如何使用TypeScript进行计算

- DeepSeek混合专家架构赋能智能创作

智能计算研究中心

其他

内容概要在人工智能技术加速迭代的当下,DeepSeek混合专家架构(MixtureofExperts)通过670亿参数的动态路由机制,实现了多模态处理的范式突破。该架构将视觉语言理解、多语言语义解析与深度学习算法深度融合,构建出覆盖文本生成、代码编写、学术研究等场景的立体化能力矩阵。其核心优势体现在三个维度:精准化内容生产——通过智能选题、文献综述自动生成等功能,将学术论文写作效率提升40%以上;

- 人工智能之数学基础:数学对人工智能技术发展的作用

每天五分钟玩转人工智能

机器学习深度学习之数学基础人工智能深度学习机器学习神经网络自然语言处理数学

本文重点数学是人工智能技术发展的基础,它提供了人工智能技术所需的数学理论和算法,包括概率论、统计学、线性代数、微积分、图论等等。本文将从以下几个方面探讨数学对人工智能技术发展的作用。概率论和统计学概率论和统计学是人工智能技术中最为重要的数学分支之一。概率论和统计学的应用范围非常广泛,包括机器学习、数据挖掘、自然语言处理、计算机视觉等领域。在人工智能技术中,概率论和统计学主要用于处理不确定性的问题,

- 人工智能之数学基础:线性子空间

每天五分钟玩转人工智能

机器学习深度学习之数学基础人工智能深度学习线性代数线性子空间线性空间

本文重点在前面的课程中,我们学习了线性空间,本文我们我们在此基础上学习线性子空间。在应用中,线性子空间的概念被广泛应用于信号处理、机器学习、图像处理等领域。子空间的性质子空间是线性空间的一部分,它需要满足下面的性质:设V是数域F上的线性空间,W是V的一个非空子集。如果W对于V中的加法运算和数乘运算也构成F上的一个线性空间,则称W为V的线性子空间(或称向量子空间)。具体来说,设V是一个线性空间,W是

- 详解离线安装Python库

爱编程的喵喵

Python基础课程python离线安装requirements

大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。喜欢通过博客创作的方式对所学的知识进行总结与归纳,不仅形成深入且独到的理解,而且能够帮助新手快速入门。 本文主要介绍了详解离线安装Python库,希望能对

- 如何用ruby来写hadoop的mapreduce并生成jar包

wudixiaotie

mapreduce

ruby来写hadoop的mapreduce,我用的方法是rubydoop。怎么配置环境呢:

1.安装rvm:

不说了 网上有

2.安装ruby:

由于我以前是做ruby的,所以习惯性的先安装了ruby,起码调试起来比jruby快多了。

3.安装jruby:

rvm install jruby然后等待安

- java编程思想 -- 访问控制权限

百合不是茶

java访问控制权限单例模式

访问权限是java中一个比较中要的知识点,它规定者什么方法可以访问,什么不可以访问

一:包访问权限;

自定义包:

package com.wj.control;

//包

public class Demo {

//定义一个无参的方法

public void DemoPackage(){

System.out.println("调用

- [生物与医学]请审慎食用小龙虾

comsci

生物

现在的餐馆里面出售的小龙虾,有一些是在野外捕捉的,这些小龙虾身体里面可能带有某些病毒和细菌,人食用以后可能会导致一些疾病,严重的甚至会死亡.....

所以,参加聚餐的时候,最好不要点小龙虾...就吃养殖的猪肉,牛肉,羊肉和鱼,等动物蛋白质

- org.apache.jasper.JasperException: Unable to compile class for JSP:

商人shang

maven2.2jdk1.8

环境: jdk1.8 maven tomcat7-maven-plugin 2.0

原因: tomcat7-maven-plugin 2.0 不知吃 jdk 1.8,换成 tomcat7-maven-plugin 2.2就行,即

<plugin>

- 你的垃圾你处理掉了吗?GC

oloz

GC

前序:本人菜鸟,此文研究学习来自网络,各位牛牛多指教

1.垃圾收集算法的核心思想

Java语言建立了垃圾收集机制,用以跟踪正在使用的对象和发现并回收不再使用(引用)的对象。该机制可以有效防范动态内存分配中可能发生的两个危险:因内存垃圾过多而引发的内存耗尽,以及不恰当的内存释放所造成的内存非法引用。

垃圾收集算法的核心思想是:对虚拟机可用内存空间,即堆空间中的对象进行识别

- shiro 和 SESSSION

杨白白

shiro

shiro 在web项目里默认使用的是web容器提供的session,也就是说shiro使用的session是web容器产生的,并不是自己产生的,在用于非web环境时可用其他来源代替。在web工程启动的时候它就和容器绑定在了一起,这是通过web.xml里面的shiroFilter实现的。通过session.getSession()方法会在浏览器cokkice产生JESSIONID,当关闭浏览器,此

- 移动互联网终端 淘宝客如何实现盈利

小桔子

移動客戶端淘客淘寶App

2012年淘宝联盟平台为站长和淘宝客带来的分成收入突破30亿元,同比增长100%。而来自移动端的分成达1亿元,其中美丽说、蘑菇街、果库、口袋购物等App运营商分成近5000万元。 可以看出,虽然目前阶段PC端对于淘客而言仍旧是盈利的大头,但移动端已经呈现出爆发之势。而且这个势头将随着智能终端(手机,平板)的加速普及而更加迅猛

- wordpress小工具制作

aichenglong

wordpress小工具

wordpress 使用侧边栏的小工具,很方便调整页面结构

小工具的制作过程

1 在自己的主题文件中新建一个文件夹(如widget),在文件夹中创建一个php(AWP_posts-category.php)

小工具是一个类,想侧边栏一样,还得使用代码注册,他才可以再后台使用,基本的代码一层不变

<?php

class AWP_Post_Category extends WP_Wi

- JS微信分享

AILIKES

js

// 所有功能必须包含在 WeixinApi.ready 中进行

WeixinApi.ready(function(Api) {

// 微信分享的数据

var wxData = {

&nb

- 封装探讨

百合不是茶

JAVA面向对象 封装

//封装 属性 方法 将某些东西包装在一起,通过创建对象或使用静态的方法来调用,称为封装;封装其实就是有选择性地公开或隐藏某些信息,它解决了数据的安全性问题,增加代码的可读性和可维护性

在 Aname类中申明三个属性,将其封装在一个类中:通过对象来调用

例如 1:

//属性 将其设为私有

姓名 name 可以公开

- jquery radio/checkbox change事件不能触发的问题

bijian1013

JavaScriptjquery

我想让radio来控制当前我选择的是机动车还是特种车,如下所示:

<html>

<head>

<script src="http://ajax.googleapis.com/ajax/libs/jquery/1.7.1/jquery.min.js" type="text/javascript"><

- AngularJS中安全性措施

bijian1013

JavaScriptAngularJS安全性XSRFJSON漏洞

在使用web应用中,安全性是应该首要考虑的一个问题。AngularJS提供了一些辅助机制,用来防护来自两个常见攻击方向的网络攻击。

一.JSON漏洞

当使用一个GET请求获取JSON数组信息的时候(尤其是当这一信息非常敏感,

- [Maven学习笔记九]Maven发布web项目

bit1129

maven

基于Maven的web项目的标准项目结构

user-project

user-core

user-service

user-web

src

- 【Hive七】Hive用户自定义聚合函数(UDAF)

bit1129

hive

用户自定义聚合函数,用户提供的多个入参通过聚合计算(求和、求最大值、求最小值)得到一个聚合计算结果的函数。

问题:UDF也可以提供输入多个参数然后输出一个结果的运算,比如加法运算add(3,5),add这个UDF需要实现UDF的evaluate方法,那么UDF和UDAF的实质分别究竟是什么?

Double evaluate(Double a, Double b)

- 通过 nginx-lua 给 Nginx 增加 OAuth 支持

ronin47

前言:我们使用Nginx的Lua中间件建立了OAuth2认证和授权层。如果你也有此打算,阅读下面的文档,实现自动化并获得收益。SeatGeek 在过去几年中取得了发展,我们已经积累了不少针对各种任务的不同管理接口。我们通常为新的展示需求创建新模块,比如我们自己的博客、图表等。我们还定期开发内部工具来处理诸如部署、可视化操作及事件处理等事务。在处理这些事务中,我们使用了几个不同的接口来认证:

&n

- 利用tomcat-redis-session-manager做session同步时自定义类对象属性保存不上的解决方法

bsr1983

session

在利用tomcat-redis-session-manager做session同步时,遇到了在session保存一个自定义对象时,修改该对象中的某个属性,session未进行序列化,属性没有被存储到redis中。 在 tomcat-redis-session-manager的github上有如下说明: Session Change Tracking

As noted in the &qu

- 《代码大全》表驱动法-Table Driven Approach-1

bylijinnan

java算法

关于Table Driven Approach的一篇非常好的文章:

http://www.codeproject.com/Articles/42732/Table-driven-Approach

package com.ljn.base;

import java.util.Random;

public class TableDriven {

public

- Sybase封锁原理

chicony

Sybase

昨天在操作Sybase IQ12.7时意外操作造成了数据库表锁定,不能删除被锁定表数据也不能往其中写入数据。由于着急往该表抽入数据,因此立马着手解决该表的解锁问题。 无奈此前没有接触过Sybase IQ12.7这套数据库产品,加之当时已属于下班时间无法求助于支持人员支持,因此只有借助搜索引擎强大的

- java异常处理机制

CrazyMizzz

java

java异常关键字有以下几个,分别为 try catch final throw throws

他们的定义分别为

try: Opening exception-handling statement.

catch: Captures the exception.

finally: Runs its code before terminating

- hive 数据插入DML语法汇总

daizj

hiveDML数据插入

Hive的数据插入DML语法汇总1、Loading files into tables语法:1) LOAD DATA [LOCAL] INPATH 'filepath' [OVERWRITE] INTO TABLE tablename [PARTITION (partcol1=val1, partcol2=val2 ...)]解释:1)、上面命令执行环境为hive客户端环境下: hive>l

- 工厂设计模式

dcj3sjt126com

设计模式

使用设计模式是促进最佳实践和良好设计的好办法。设计模式可以提供针对常见的编程问题的灵活的解决方案。 工厂模式

工厂模式(Factory)允许你在代码执行时实例化对象。它之所以被称为工厂模式是因为它负责“生产”对象。工厂方法的参数是你要生成的对象对应的类名称。

Example #1 调用工厂方法(带参数)

<?phpclass Example{

- mysql字符串查找函数

dcj3sjt126com

mysql

FIND_IN_SET(str,strlist)

假如字符串str 在由N 子链组成的字符串列表strlist 中,则返回值的范围在1到 N 之间。一个字符串列表就是一个由一些被‘,’符号分开的自链组成的字符串。如果第一个参数是一个常数字符串,而第二个是type SET列,则 FIND_IN_SET() 函数被优化,使用比特计算。如果str不在strlist 或st

- jvm内存管理

easterfly

jvm

一、JVM堆内存的划分

分为年轻代和年老代。年轻代又分为三部分:一个eden,两个survivor。

工作过程是这样的:e区空间满了后,执行minor gc,存活下来的对象放入s0, 对s0仍会进行minor gc,存活下来的的对象放入s1中,对s1同样执行minor gc,依旧存活的对象就放入年老代中;

年老代满了之后会执行major gc,这个是stop the word模式,执行

- CentOS-6.3安装配置JDK-8

gengzg

centos

JAVA_HOME=/usr/java/jdk1.8.0_45

JRE_HOME=/usr/java/jdk1.8.0_45/jre

PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin

CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib

export JAVA_HOME

- 【转】关于web路径的获取方法

huangyc1210

Web路径

假定你的web application 名称为news,你在浏览器中输入请求路径: http://localhost:8080/news/main/list.jsp 则执行下面向行代码后打印出如下结果: 1、 System.out.println(request.getContextPath()); //可返回站点的根路径。也就是项

- php里获取第一个中文首字母并排序

远去的渡口

数据结构PHP

很久没来更新博客了,还是觉得工作需要多总结的好。今天来更新一个自己认为比较有成就的问题吧。 最近在做储值结算,需求里结算首页需要按门店的首字母A-Z排序。我的数据结构原本是这样的:

Array

(

[0] => Array

(

[sid] => 2885842

[recetcstoredpay] =&g

- java内部类

hm4123660

java内部类匿名内部类成员内部类方法内部类

在Java中,可以将一个类定义在另一个类里面或者一个方法里面,这样的类称为内部类。内部类仍然是一个独立的类,在编译之后内部类会被编译成独立的.class文件,但是前面冠以外部类的类名和$符号。内部类可以间接解决多继承问题,可以使用内部类继承一个类,外部类继承一个类,实现多继承。

&nb

- Caused by: java.lang.IncompatibleClassChangeError: class org.hibernate.cfg.Exten

zhb8015

maven pom.xml关于hibernate的配置和异常信息如下,查了好多资料,问题还是没有解决。只知道是包冲突,就是不知道是哪个包....遇到这个问题的分享下是怎么解决的。。

maven pom:

<dependency>

<groupId>org.hibernate</groupId>

<ar

- Spark 性能相关参数配置详解-任务调度篇

Stark_Summer

sparkcachecpu任务调度yarn

随着Spark的逐渐成熟完善, 越来越多的可配置参数被添加到Spark中来, 本文试图通过阐述这其中部分参数的工作原理和配置思路, 和大家一起探讨一下如何根据实际场合对Spark进行配置优化。

由于篇幅较长,所以在这里分篇组织,如果要看最新完整的网页版内容,可以戳这里:http://spark-config.readthedocs.org/,主要是便

- css3滤镜

wangkeheng

htmlcss

经常看到一些网站的底部有一些灰色的图标,鼠标移入的时候会变亮,开始以为是js操作src或者bg呢,搜索了一下,发现了一个更好的方法:通过css3的滤镜方法。

html代码:

<a href='' class='icon'><img src='utv.jpg' /></a>

css代码:

.icon{-webkit-filter: graysc