2018:Bottom-Up and Top-Down Attention for Image Captioning and Visual Question Answering

摘要

本文中,我们提出一种结合bottom-up和top-down的注意力机制,能够在对象和其它显著图像区域的水平上计算注意力。在我们的方法中,bottom-up的机制(基于Faster R-CNN)提出图像区域,每个区域都有一个相关的特征向量,而top-down的机制决定了特征权重。将此方法应用到VQA上,获得2017的VQA挑战中的第一名。

一、介绍

视觉注意力机制通过学习关注图像中的基于深度神经网络架构的突出区域来提高性能。

在人类视觉系统中,注意力可以通过当前任务决定top-down信号来卷积地聚焦,并通过意外的、新的或显著的刺激相关的bottom-up信号自动聚焦。本文中,我们将由非视觉或特定任务情境驱动的注意力机制称为“top-down”,将视觉反馈注意力机制成为“bottom-up”。

大多在VQA中使用的传统的视觉注意力机制是top-down的多样性,对于与图像相关的问题,这些机制通常被训练为有选择地关注卷积神经网络的一个或多个层的输出。但是,这种方法很少考虑如何确定需要注意的图像区域。

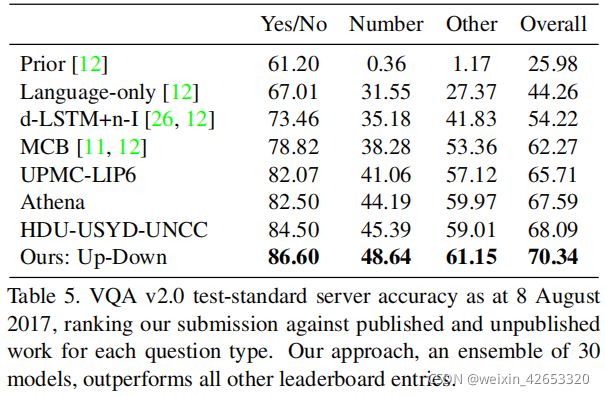

我们提出一个结合bottom-up和top-down的视觉注意力机制,bottom-up机制提出一组显著的图像区域,每个区域由一个池化的卷积特征向量表示,使用Faster R-CNN来实现bottom-up注意力,代表一个bottom-up注意力机制的自然表示。top-down机制使用特定任务的上下文来预测图像区域的注意力分布,参与的特征向量计算为所有区域上的图像特征的加权平均。在VQAv2测试-标准上实现了70.3%的总体准确率。

三、方法

3.1 Bottom-Up Attention Model

Faster R-CNN用于识别某些类的对象的实例,并使用边界框定位它们,其它区域提议网络也被训练为一个注意力机制。Faster R-CNN有效地作为一种“硬”注意力机制,因为只是从大量可能的配置中可以选择相对较少的图像边界框特征。

3.3 VQA模型

给定一组空间图像特征V,我们提出的VQA模型使用一个“软”top-down注意力机制对每个特征进行加权,使用问题表示作为上下文。如图4所示,提出的模型实现了问题和图像的联合多模态嵌入,然后对一组候选答案的分数回归进行预测。然而,实现决策对于确保这个相对简单的模型的高性能很重要。

网络内学到的非线性变换用门控双曲正切激活实现,这是公用网络的一个特殊情况,与传统的ReLU或tanh层相比具有很强的经验优势。我们的每个“门控tanh”层都实现了一个函数→:x∈Rm和∈Rn,参数为={W、W'、b、b'},定义如下:

我们提出的方法首先将问题编码为一个门控递归单元(GRU)的隐藏状态q,每个输入词都使用一个学习到的单词嵌入来表示。与公式3类似,给定GRU的输出q,我们为k个图像的每个特征生成一个非标准化的注意权重ai:

采用公式4和公式5(忽略下标t)计算归一化注意权值和参与的图像特征ˆv。可能的输出响应y的分布如下:

h是问题和图像的共同表示。

四、评估

4.1 数据集

4.1.1 Visual Genome Dataset

使用VG数据集预训练我们的bottom-up注意力模型,并在新联VQA模型时进行数据增强。数据集包含108K图像,其中包含对象、属性和关系,以及1.7M问题答案。保留5K图像用于验证、5K图像用于测试、剩余98K图像用于训练数据。

经过过滤训练数据,我们的最终训练集包含1600个对象类和400个属性类。当训练VQA模型时,我们使用VG问答对来增强VQAv2的训练数据,只有正确答案出现在模型的答案词汇表中,约占数据集的30%,或485K个问题。

4.1.3 VQA v2.0 Dataset

被用作2017VQA挑战赛的基础,包含1.1M问题,11.1M关于MSCOCO图像的答案。为了计算效率,问题被修剪为最多14个单词,候选答案被限制在训练集中出现超过8次的正确答案,导致输出词汇量大小为3129。我们的VQA测试服务器提交的是关于训练和验证集以及来自VG的其他问题和答案的训练。为了评估答案的质量,我们使用标准的VQA度量[2]来报告准确性,它考虑了注释者之间对地面真实答案偶尔出现的分歧。

4.2 ResNet Baseline

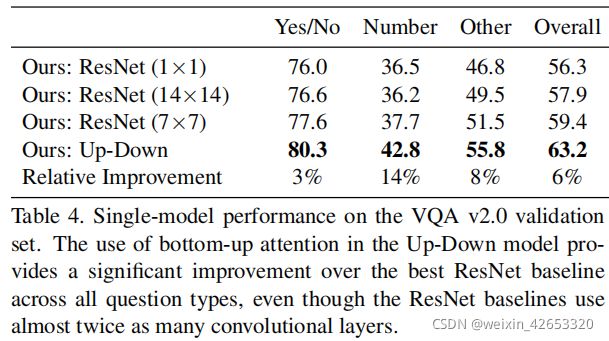

为量化bottom-up注意力的影响,在VQA实验中,我们评估了整个模型(UpDn)与以前的工作以及消融的基线对比。基线(ResNet)使用在ImageNet[35]上预训练的ResNet[13]CNN对每幅图像进行编码,以代替bottom-up的注意机制。

4.4 VQA结果

报告了在VQAv2.0验证集上的完整Up-DownVQA模型相对于几个ResNet基线的单个模型的性能。在所有问题类型中,增加bottom-up注意力可以显著改善性能,超过最佳ResNet基线,尽管ResNet基线使用了大约两倍的卷积层。表5报告了在官方VQA2.0测试-标准评估服务器上的30个集成模型的性能,以及之前发布的基线结果和排名最高的其他条目。在提交时(2017年8月8日),我们的表现优于所有其他测试服务器提交。我们的提交也在2017年的VQA挑战中获得了第一名。

4.5 定性分析

我们可视化了UpDown标注模型生成的不同单词的参与图像区域,我们的方法同样能够专注于细节或大的图像区域,之所以有这种能力,是因为我们模型中的注意力候选包含不同尺度和高宽比的重叠区域组成--每个区域都与一个对象、几个相关对象或其它突出的图像补丁对齐。

与传统方法不同的是,当一个候选注意区域对应于一个对象或几个相关对象时,所有与这些对象相关联的视觉概念似乎在空间上是共同定位的,并被一起处理。换句话说,我们的方法能够同时考虑与一个对象相关的所有信息。这也是一种引起注意的自然方式。在人类视觉系统中,在正确的组合中整合对象的问题称为特征绑定问题,实验表明注意力在解决方案[41,40]中起着核心作用。我们在图6中包含了一个VQA注意的示例。

五、总结

我们提出一种结合bottom-up和top-down视觉注意力机制的新方法,我们的方法使人们能够在对象和其它显著区域水平上更自然地计算出计算力。将此方法应用到图像标注和视觉问答中,在两个任务上都实现了先进的结果,同时提高了结果注意权重的可解释性。

在较高的层次上,我们的工作更紧密地将涉及视觉和语言理解的任务与对象检测的最新进展联系起来。虽然这为未来的研究提供了几个方向,但我们的方法的直接好处可以通过简单地用预先训练的bottom-up的注意力特征替换预先训练的CNN特征来捕捉到。