干货!针对图数据不变特征的对比学习方法

点击蓝字

关注我们

AI TIME欢迎每一位AI爱好者的加入!

李思杭:

中国科学技术大学硕士,师从何向南教授和王翔教授。研究图神经网络的预训练和泛化。

内容简介

现有的图对比学习框架中的数据强化方法可被分为两类:一类是随机破坏原图特征,这可能导致原始数据语义信息的改变;另一类则利用外源的领域知识进行指导,会导致模型的泛化能力的下降。因此,我们提出一种一种新的通用图对比学习框架,在进行数据强化时保留下原始图数据的本质特征,构建出更为有效的强化视图,从而提升预训练模型的泛化性能。

如今大量未经标注的图数据广泛分布在各个领域,下面展示了化学分子、知识图谱和社交网络等等。

而我们目前大多数的机器学习模型仍可以被看做是数据驱动的方法。为了能够充分利用这些数量巨大、却没有标注的数据,我们一般会采用上游大规模没有标签的数据进行预训练,然后再在下游小规模有标签数据上微调的模型范式。

Graph Contrastive Learning

对比学习是一种在过去数年受到机器学习社区研究者广泛关注的自监督方法,我们大多数的图对比学习框架可以被总结为两个模块的结合。

第一个模块是进行图数据的强化。我们基于原始的图数据样本来创建它的强化视图。这里需要强调的是,图这种数据和CV领域的image是有本质上的不同的。比如像image有一些强化的办法,如旋转等,并不会改变其语义信息。但是图这种数据是由节点和节点之间的边组成的,我们在强化的时候很难找到一种对应的、完全不改变语义信息的方法。所以目前图数据在强化的时候,我们往往会删除或者扰动一部分节点、边二者的属性。我们的工作主要关注的是节点label的数据强化方式,选出原始图数据样本节点集的一个子集,并保留这些子集中在原始结构已有的连接。

第二部分是在创建好强化视图之后,进行对比损失的优化。通过对对比损失函数的优化,使得同一个样本的强化视图在经过我们要预训练的图神经网络之后在超球面的投影尽可能地接近。同时使得不同样本的强化视图之间的投影尽可能地远离,尽可能地在超球面上形成一个uniform distribution,为预训练之后的下游微调提供一个更好的分类边界,以达到更好的性能。

Two Aug. lines and inherent limitations

我们用一个具体的化学分子来介绍现有的图数据强化方法以及局限性,以此引出我们的motivation。现有的图对比学习中的数据强化方法大致可以分为两类:

一类是随机的丢弃掉或者重组掉其中的节点、边结构。这一随机方法的局限性是非常明显的,他可能会丢掉数据重要的语义信息,那么其创建的数据强化图甚至会误导下一步对比损失的优化。如在上图所示,我们可以看到苯环、甲基、氨基和氰基这4个基团,其中氰基使得该分子具有剧毒。那么如果我们在数据强化的过程中因为随机的机制丢弃掉氰基,就会使得毒性这一重要语义信息发生了改变。我们在优化对比损失的时候,一个强化视图保留了氰基,具有剧毒;丢弃氰基的没有剧毒。我们令他们相互靠近,但是这样的训练不仅没有作用,反而伤害到了图神经网络的表达能力。

另一种强化方法则是利用了领域知识或者专家的手工标注来指导数据强化。如上图所示,在化学知识的指导下,我们可以保留下氰基、氨基这一类对分子化学性质影响非常大的基团。但是随之带来的问题是往往在实际应用中的这一类领域知识是非常昂贵且难以获得的,这也就限制了我们图对比学习框架的应用。

基于这些局限性,我们是否能够提出一种新的图数据强化方法?一方面并不依赖这些领域知识和专家的参与;另一方面,它在强化的时候又可以尽可能地保留下含有语义信息的、丰富的、区别于其他样本的特征节点。

Invariant Rationale Discovery

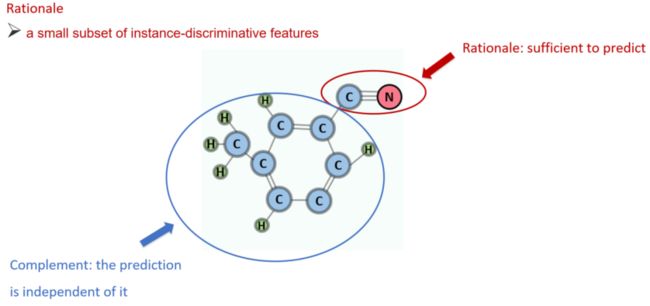

为了解决上述问题,我们将图数据强化和Invariant Rationale Discovery这个领域的知识相结合。一个图样本的rationale的定义是,含有instance-discriminative特征的一个子结构。一个直观的理解就是,该样本最显著的区别于其他样本的特征。以上图为例,氰基就可以被视为该分子的一个rationale,它决定了这个分子绝大多数的化学性质。我们形式化的描述了rationale需要满足的两个条件:

第一是充分性条件。Rationale中已经包含了充分的关键语义信息。比如我们仅在图中看到了氰基,就可以预测该分子因为含有氰化物是剧毒的。

第二是独立性条件。我们在给定rationale的情况下,语义信息及条件概率应当独立于它的补集。在图中的例子就意味着即使我们将蓝色圈中的补集部分替换为其他的基团,只要不改变氰基,分子的毒性不会发生丝毫改变。

Rationale-aware Graph Contrastive Learning

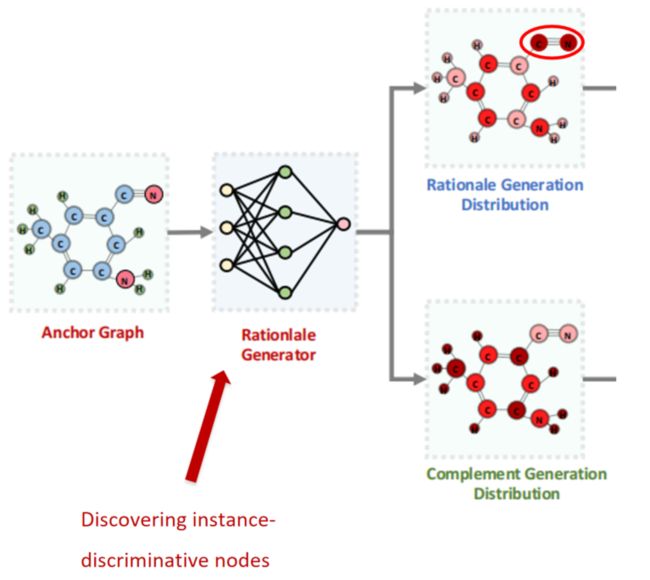

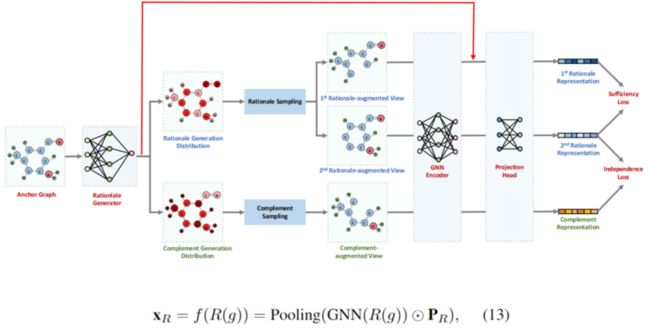

上图表示的框架Rationale-aware Graph Contrastive Learning简称为RGCL,我们将分为几个子模块逐个介绍其工作原理。

Rationale-aware Graph Contrastive Learning

首先第一个模块,使用了轻量的图卷积网络——Rationlale Generator,其作用是用来估计节点的重要性和包含语义信息的多少。得到的就是上支路的Rationale Generation Distributon,节点越重要、含有的语义信息越多,我们就越希望其能被赋予一个更高的采样概率。之后,我们只需将上支路的Rationale Generation Distributon做一个简单的反转。在补集中,越不重要的节点就越可能被赋予更高的采样概率。在得到这样一个采样概率之后,我们知道输入骨干神经网络的强化视图不是一个孤立的节点,而是一幅子图。

在获得每个点的采样概率之后,我们将子图的产生概率近似为这幅子图包含的所有节点概率和其所丢弃的节点的概率反转乘积。同时,为了满足充分性和独立性条件,我们会构建两类强化视图,一类是Rationale-augmented view,这类强化视图从Rationale的子图分布中采样,倾向于舍弃那些不重要的节点;另一类是Complement-augmented view,即从Complement的子图中采样构建,倾向于丢弃重要的节点,保留和其最终性质关系大的节点。

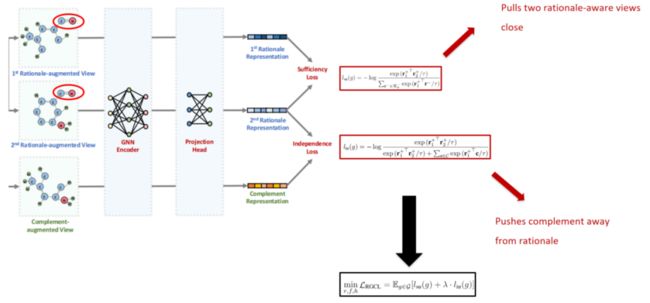

接下来就是一个类似于对比学习的框架,我们首先将两个Rationale-augmented view和一个Complement-augmented view通过神经网络之后就会得到他们各自的表达,即其在影空间的投影。我们设计了新的损失函数,由两个子损失函数构成,分别对应充分性和独立性条件。

我们构建的第一个子损失函数被称为Sufficiency Loss。其使得同一个样本的两个rationale的强化视图表达相互靠近,就对应了之前提到的充分性条件。

另一个函数是Independence Loss。其使得rationale的强化视图和同一个bench中其他的试图相远离,对应了独立性的条件。

最终的损失函数就是上述两个损失函数的加权和,通过一个超参数λ来trade off。

这里还带来的一个问题是从整个流程图可以看到,在进行梯度传播的时候,由于采样模块的存在,梯度是无法直接传播到rationale generator的。因此,我们增加了上图中红线所描述的这条路径。实际操作中,如上图中的公式(13)所示,我们将rationale generator所产生的得分Pr和经过神经网络所得到的表达进行一个点乘。这样一来,我们在优化损失函数的时候,重要的节点就会倾向于被赋予一个更高的分数,梯度也就会被回传到rationale generator,同时也会对他们骨干神经网络和rationale generator进行优化。

Experiments

我们通过多次实验来尝试回答两个问题,从而来展示我们提出的RGCL框架的有效性。

RQ1: effectiveness of rationale generator

我们提出的用于估计各个节点重要性的Rationale Generator是否能够准确的捕捉图数据中包含丰富语义信息的节点。

RQ2: performance of pre-trained backbone model on downstream tasks

RGCL预训练是否真的能提升预训练模型在下游任务的表现?

1

RQ1: effectiveness of rationale generator

Mutag dataset

首先,我们在包含两百万个无标注化学分子的数据集上进行预训练。模型收敛后取出Rationale Generator,让其对如图所示的化学分子数据集Mutag dataset中样本的节点重要性进行打分。上图中第一行是两位化学专家所标注的分子,里面高亮的黄色部分包含对其化学性质影响较大的基团或者原子。第二行是RGCL预训练的Rationale Generator重要性打分,可以看到二者是非常接近的。如果把专家的标注当作groundtruth,我们的Rationale Generator达到了80%的准确率。

MNIST-Superpixel dataset

这个实验是我们在MNIST-Superpixel dataset上进行验证,第一行是MNIST原始图片数据image,第二行是MNIST-Superpixel的样本,其数据类型是从image转化成了graph。第三行是先去掉所有标签,用无标签的数据在RGCL的框架下进行自监督训练,然后展示收敛后对各个节点重要性的估计。我们可以从上图看到,由于在MNIST-Superpixel样本中的语义节点就分布在中央,理想的采样概率分布可能是由中央到边缘,由深及浅的分布。但是我们从上图可以看到,颜色最深的是原始图片中的轮廓点,最浅的反而是轮廓点周围的一些点。我们对此的解释是,最中间的语义信息被赋予了最高的分数,这说明Rationale Generator能够比较准的捕捉那些含有语义信息非常丰富的节点。为什么最接近这些语义节点的点会被赋予最小的采样概率呢?我们把这一区域称之为混淆区域,比如0和8,1和7.这些很相近的节点是非常容易发生混淆的,多采样一个或是少采样一个可能就带来截然不同的结果。Rationale Generator在学习的过程中学到了要给他们赋予一个最小的采样概率来避免混淆。虽然这一实验结果在一开始是出人意料的,但是我们在分析后认为这是一个合理的采样分布。

通过上述两个实验,我们初步展示了Rationale Generator的有效性。

2

RQ2: performance on downstream tasks

Transfer Learning (Pretrained on ZINC15)

我们在这里展示了一些主要的实验结果,经过预训练的骨干神经网络在下游8个不同的化学分子数据集上微调的表现。我们可以看到,由于有了Rationale Generator的正确指导,相比于现有的一些图神经网络预训练框架,我们的RGCL框架取得了最好的平均表现,达到了SOTA。

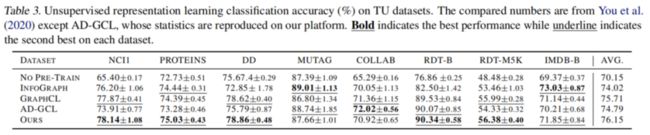

Unsupervised representation learning on TU-datasets

这里还展示了另一个在TU的数据集上进行自监督学习之后,并不再进行有监督的微调,而是用一个简单的分类器来展示学出的表达是否有效。这里也相比现有的框架总体上达到了较好的结果。

Summary

(1)我们提出了一种新的图对比学习框架RGCL,通过一个Rationale Generator揭示了图数据样本区别于其他样本的特征,并且在采样节点构建强化视图的时候将这些特征保留或者丢弃,以构建两类——一类是Rationale-augmented强化视图,一类是Complement-augmented强化视图。

(2)通过对两种损失函数——充分性损失函数和独立性损失函数的优化,使其满足充分性和独立性的条件,从而使得经过预训练的骨干神经网络具有更强大的表达能力。同时,我们也因为Rationale Generator的存在赋予了其一定的可解释性。

提

醒

点击“阅读原文”,即可观看本场回放

整理:林 则

作者:李思杭

往期精彩文章推荐

记得关注我们呀!每天都有新知识!

关于AI TIME

AI TIME源起于2019年,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法和场景应用的本质问题进行探索,加强思想碰撞,链接全球AI学者、行业专家和爱好者,希望以辩论的形式,探讨人工智能和人类未来之间的矛盾,探索人工智能领域的未来。

迄今为止,AI TIME已经邀请了800多位海内外讲者,举办了逾400场活动,超400万人次观看。

我知道你

在看

哦

~

点击 阅读原文 查看回放!