Improved Consistency Regularization for GANs

Improved Consistency Regularization for GANs

最近的工作(Zhang et al. 2020)通过在鉴别器上强制一致性代价,提高了生成对抗网络(gan)的性能。我们在几个方面改进了这项技术。我们首先说明一致性正则化可以将工件引入GAN样本,并解释如何修复这个问题。然后,我们提出了几个修改一致性正则化程序的设计,以提高其性能。

我们进行了广泛的实验,量化了我们的改进带来的好处。对于CIFAR-10和CelebA上的无条件图像合成,我们的修改在各种GAN架构上产生了最好的已知FID分数。对于CIFAR-10上的有条件图像合成,我们将最先进的FID得分从11.48提高到9.21。最后,在ImageNet-2012上,我们将我们的技术应用于原始的BigGAN(Brock, Donahue, and Simonyan 2019)模型,并将FID从6.66提高到5.38,这是该模型规模下的最佳得分。

1 Introduction

最近的工作(Wei等人,2018;Zhang等人,2020)表明,生成模型的性能可以通过引入一致性正则化技术来提高–这在半监督学习文献中很受欢迎(Oliver等人,2018)。特别是,Zhang等人(2020)表明,生成式对抗网络(GANs)(Goodfellow等人,2014)用一致性正则化增强可以实现最先进的图像合成结果。在CR-GAN中,将真实图像及其相应的增强图像送入鉴别器。然后鼓励鉴别器-通过一个辅助损失项-为图像及其相应的增强产生类似的输出。

尽管CR-GAN中的一致性正则化是有效的,但增强只适用于真实图像,而不是生成的样本,这使得整个过程有些不平衡。特别是,生成器可以学习这些人工增强的特征,并将它们作为不受欢迎的人工制品引入生成的样本。

此外,通过只对判别器进行正则化,并且只在图像空间中使用augmentations,Wei等人(2018)和Zhang等人(2020)的正则化并不直接作用于生成器。通过约束从先验到生成样本的映射,我们可以在首先对判别器进行一致性正则化的基础上进一步实现性能提升。

CR),它将一致性正则化的形式应用于生成的图像、潜在向量空间和生成器。首先,我们通过引入平衡一致性正则化(bCR)来解决生成样本上缺乏正则化的问题,其中鉴别器上的一致性项应用于真实图像和来自生成器的样本。

其次,我们引入了latent 一致性正则化(zCR),它包含了调节生成器和判别器对先验变化的敏感性的正则化项。特别是,考虑到增强/扰动的潜在向量,我们表明,鼓励生成器对扰动敏感,鼓励判别器不敏感是有帮助的。我们将bCR和zCR结合起来,并称之为改进的一致性正则化(ICR)。

ICR可以产生最先进的图像合成结果。对于CIFAR-10和CelebA上的无条件图像合成,我们的方法在各种GAN体系结构上获得了最著名的FID分数。对于CIFAR-10上的条件图像合成,我们将先进的FID评分从11.48提高到9.21。

CR可以产生最先进的图像合成结果。对于CIFAR-10和CelebA上的无条件图像合成,我们的方法在各种GAN体系结构上获得了最高的FID分数。对于CIFAR-10上的条件图像合成,我们将先进的FID评分从11.48提高到9.21。最后,在ImageNet-2012上,我们将我们的技术应用于原始BigGAN (Brock, Donahue, and Simonyan 2019)模型,并将FID从6.66提高到5.38,这是该模型尺寸下的最佳分数。

2 Improved Consistency Regularization

对于半监督或无监督学习,一致性正则化技术是有效的,最近已被广泛使用(Sajjadi, Javanmardi, and Tasdizen 2016; Laine and Aila 2016; Zhai等人2019; Xie等人2019; Berthelot等人2019)。

这些技术背后的直觉是将一些先验知识编码到模型训练中:模型应该产生一致的预测,这些预测是在给定的实例及其语义保护的增强中进行的。增强(或转换)可以采取多种形式,如image flipping and rotating, sentence back-translating, or even adversarial attacks。通过最小化实例对之间的L2损失(Sajjadi, Javanmardi, and Tasdizen 2016; Laine and Aila 2016),或分布之间的KL-散度损失(Xie et al. 2019; Miyato et al. 2018b),可以轻松实现对不一致性的惩罚。在GAN文献中,Wei等人(2018)提出了一个源于Lipschitz连续性考虑的一致性项来改善WGAN的训练。最近,CR-GAN(Zhang等人,2020)将一致性正则化应用于判别器,并取得了实质性的改进。

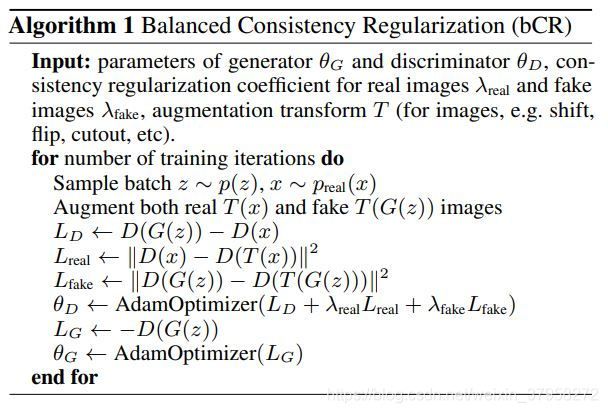

下面我们首先介绍我们的两种新技术,简称为bCR和zCR,以改进和普及GANs的CR。我们把这两种技术的组合称为ICR,我们将在后面说明ICR在各种情况下产生最先进的图像合成结果。图1显示了我们的方法与基线CR-GAN Zhang等人(2020)的比较图。

图1:我们的方法与基线的比较图。(1) CR-GAN(Zhang等人,2020)是基线,只在真实图像和其增强部分之间应用一致性正则化。(2) 在平衡一致性正则化(bCR-GAN)中,我们也在生成的假图像和它们的augmentations之间引入了一致性正则化。通过对真实图像和假图像进行一致性正则化,判别器以一种平衡的方式被训练,并产生较少的增强假象。(3) 此外,我们提出了latent一致性正则化(zCR-GAN),其中latent z被小幅度的噪声所增强。然后,对于判别器,我们对相应的对之间的一致性进行规范化;而对于生成器,我们鼓励相应的生成图像更加多样化。注意,{→←}表示loss项鼓励对更靠近,而{←→}表示loss项推动对分离。

2.1 Balanced Consistency Regularization (bCR)

图1(1)显示了基线CR-GAN,其中在鉴别器损失函数中增加了一项,以惩罚其对原始图像x和增广图像T(x)之间的差异的敏感性。原始CR-GAN的一个关键问题是,鉴别器可能“错误地相信”这些增强是目标数据集的实际特征,因为这些增强只在真实图像上执行。

图5:通过平衡一致性正则化解决生成伪影的说明。第一列显示了用不同大小的cutout增强的CIFAR-10训练图像。第二列展示了普通的CR-GAN(Zhang等人,2020)会导致生成的样本中出现增强的伪影。这是因为CR-GAN只对传入判别器的真实图像进行了一致性正则化。在最后一栏中(我们的平衡一致性正则化:算法1中的bCR),这个问题在真实图像和生成的假图像被送入判别器之前都得到了解决。

这种现象,我们称之为一致性不平衡,对于某些类型的增强(例如图像的移动和翻转)来说,不容易注意到。然而,当增强的样本包含不属于真实图像的视觉假象时,它可能导致生成的样本具有明确的增强假象。例如,我们可以很容易地观察到带有cutout 增强的CR-GAN的这种效果:见图5的第二列。这种不理想的效果大大限制了我们可以使用的高级增强的选择。

为了纠正这个问题,我们还建议在将生成的样本送入鉴别器之前对其进行增强,以便鉴别器将相对于真实和虚假的增强均匀地进行正则化,从而鼓励关注有意义的视觉信息。

具体来说,一个梯度更新步骤将涉及四个批次,一批真实图像x,这些真实图像的augmentations T(x),一批生成的样本G(z),以及相同批次的augmentations T(G(z))。鉴别器将有惩罚其在相应的{x, T(x)}和{G(z), T(G(z))}之间的敏感性的条款,而生成器成本保持不变。

这一技术在算法1中有更详细的描述,并在图1(2)中得到了可视化。我们略微滥用了这个符号,即D(x)表示在给定输入Z的情况下,鉴别器最后一层激活前的输出向量。T(x)表示一个增强变换,这里是指图像(例如移位、翻转、剪裁等)。可以通过调整 λ r e a l λ_{real} λreal和 λ f a k e λ_{fake} λfake的强度来平衡一致性正则化。这个提议的BCR技术不仅可以消除增强的假象(见图5的第三列),而且还带来了实质性的性能改进(见第3和第4节)。

2.2 Latent Consistency Regularization (zCR)

在第2.1节中,我们重点讨论了在图像空间中对判别器的输入进行增量的一致性正则化。在本节中,我们考虑一个不同的问题。如果我们对潜在空间中的增量实施一致性正则化,会有帮助吗(Zhao, Dua, and Singh 2018)?鉴于GAN模型由生成器和判别器组成,我们似乎有理由问,可以应用于判别器的技术是否也可以以某种类似的方式有效应用于生成器。

为了达到这个目的,我们建议通过轻微扰动先验的抽样z来增加对生成器的输入,从而得到 T ( z ) = z + Δ z , Δ z ∼ N ( 0 , σ n o i s e ) T(z)=z+Δz,Δz∼\mathcal N(0,σ_{noise}) T(z)=z+Δz,Δz∼N(0,σnoise)。假设扰动Δz足够小,我们希望判别器的输出不应该因为这个扰动而有太大的变化,并通过强制执行 ∣ ∣ D ( G ( z ) ) − D ( G ( T ( z ) ) ) ∣ ∣ 2 ||D(G(z))-D(G(T(z)))||^2 ∣∣D(G(z))−D(G(T(z)))∣∣2来修改判别器的损失。

然而,如果只在GAN损失上加上这个项,生成器就容易崩溃,为任何潜伏的Z生成相同的样本,因为这很容易满足上面的约束条件。为了避免这种情况,我们还对生成器的损失函数进行了修改,增加了一个使G(z)和G(T(z))之间的差异最大化的项,这也鼓励了来自类似潜质向量的生成器的多样性。

虽然动机不同,但这可以被视为与Odena等人(2018)的雅可比夹紧技术和Yang等人(2019)的多样性增加技术有关。

这个方法在算法2中有更详细的描述,并在图1(3)中进行了可视化。G(z)表示给定输入z的生成器的输出图像。T(x)表示一个增强变换,这里是指latent vectors(例如添加小的扰动噪声)。鉴别器的一致性正则化的强度可以通过 λ d i s λ_{dis} λdis来调整。从生成器的角度来看,直观地讲, L g e n = − ∣ ∣ G ( z ) − G ( T ( z ) ) ∣ ∣ 2 L_{gen} = -||G(z)-G(T(z))||2 Lgen=−∣∣G(z)−G(T(z))∣∣2项鼓励{G(z), G(T(z))}的多样性。我们在第4.3节中通过实验对 λ g e n λ_{gen} λgen的效果进行了分析。根据FID的测量,这种技术大大改善了GANs的性能。我们在第3和第4节中介绍了实验结果。

2.3 Putting it All Together (ICR)

尽管平衡一致性正则化和Latent一致性正则化都能提高GAN的性能(见第3节),但它们在相互 "叠加 "时是否有效并不明显。也就是说,也许它们是以不同的方式完成同样的事情,而我们不能把它们的好处加起来。然而,通过大量的实验验证,当把算法1和算法2结合在一起时,我们取得了最好的实验结果。我们称这种组合为改进一致性正则化(ICR)。注意,在ICR中,我们增加了图像和潜在空间的输入,并在鉴别器和生成器中都添加了正则化项。我们正则化{D(x), D(T(x))}, {D(G(z)), D(T(G(z)))}对应对的鉴别器一致性,以及{(G (z))、D (G (T (z)))};对于生成器,我们鼓励{G(z), G(T(z))}之间的差异。