Keras 1.0 与 2.0 中 Convolution1D 的区别(其实是tf1.0 2.0 区别)

1.0 Convolution1D:

一维卷积层

nb_filter: 卷积核的个数

filter_length: 每个卷积核的长度

init: 权重初始化函数名称

weights: 权重初始化

border_mode: 'valid', 'same' or 'full' 如果是‘valid ’ 进行有效的卷积,对边界数据不处理,‘same'表示保留边界处的卷积结果’

subsample_length: 子样的长度

W_regularizer: 权重上的正则化

b_regularizer: 偏置项上的正则化

activity_regularizer: 输出上的正则化

W_constraint: 权重上的约束项

b_constraint: 偏置上的约束项

bias: 偏置项

input_dim: 输入的维度

input_length: 输入的长度

见 https://www.jianshu.com/p/ca41dbd91de6

2.0 Convolution1D:

inputs : 输入tensor, 维度(None, a, b) 是一个三维的tensor

None : 一般是填充样本的个数,batch_size

a : 句子中的词数或者字数

b : 字或者词的向量维度

filters : 过滤器的个数

kernel_size : 卷积核的大小,卷积核其实应该是一个二维的,这里只需要指定一维,是因为卷积核的第二维与输入的词向量维度是一致的,因为对于句子而言,卷积的移动方向只能是沿着词的方向,即只能在列维度移动

一个例子:

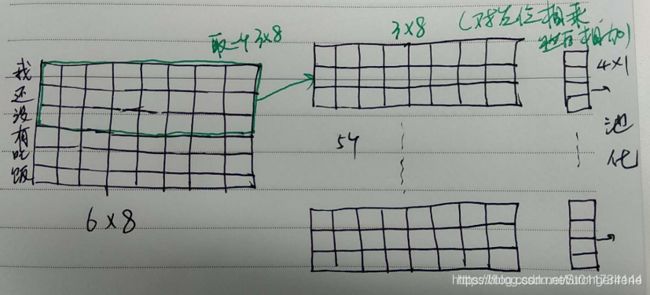

inputs = tf.placeholder('float', shape=[None, 6, 8])

out = tf.layers.conv1d(inputs, 5, 3)

说明: 对于一个样本而言,句子长度为6个字,字向量的维度为8

filters=5, kernel_size=3, 所以卷积核的维度为3*8

那么输入6*8经过3*8的卷积核卷积后得到的是4*1的一个向量(4=6-3+1)

又因为有5个过滤器,所以是得到5个4*1的向量

=================================================================================

就是卷积核好像是适配的,然后就这个是8维的它只能在维上面运动,所以

另外有个input_shape=(step, dim维) ctrl里面没有

更改: (始终搜不到那个二次抽样。、。。。)

model.add(Convolution1D(input_shape=(107,4),# 希望是107长 4 维的 input_dim=4, input_length=107,

# TODO 这里省略了个 subsample_length=1,

kernel_size=7,# filter_length=7,

filters=nbfilter,

padding='valid', # border_mode="valid",

activation="relu"

))

'''

model.add(Convolution1D(input_dim=4, input_length=107,

nb_filter=nbfilter,

filter_length=7,

border_mode="valid",

activation="relu",

subsample_length=1))

'''=================================================================================

比较重要的几个参数是inputs, filters, kernel_size,下面分别说明

inputs: 这个参数一般是经过词向量大矩阵embedding得到,如下

inputs = tf.nn.embedding_lookup(embedding, self.input_x)

其维度是:(batch_size, max_seqlength, embedding_dim) ,第三个维度是词向量矩阵维度

filters : 过滤器的个数,和conv2d差不多

kernel_size : 卷积核的大小,卷积核其实应该是一个二维的,维度是(3,embeding_dim),这里只需要指定一维,是因为卷积核的第二维与输入的词向量维度是一致的,(个人理解:如果第二个维度不是和embendding_dim一样,那么一句话顺序将会被打乱)因为对于句子而言,卷积的移动方向只能是沿着词的方向,即只能在列维度移动

说明: 对于batch_size个样本而言,句子长度为6个字,字向量的维度为8

filters=5, kernel_size=3, 所以卷积核的维度为38

那么输入68经过38的卷积核卷积后得到的是41的一个向量(4=6-3+1)

又因为有5个过滤器,则结果应该是横向拼接,维度是 4x5

最终的维度是 [batch_size, 4, 5]

画图如下:(自己想的话大概是横着的。。 )