【AI简报20210611期】Arm v9架构来啦、开源实战教你实现文字识别!

RT-AK新进展

RT-AK新增支持 Linux 环境

原文:

https://mp.weixin.qq.com/s/gBzgSfZduZAeWGtv3shFNQ

RT-AK 之前仅适用于 Windows 10 场景下,发现对于 Linux 开发者有点不太友好。有一个解决方法是:在 Windows 环境下先用 RT-AK 生成 AI BSP,然后切换到 Liunx 编写应用代码,这样就比较麻瓜。

详细参考先前文章:

并且计划将于下周开源RT-AK在k210平台适配插件

AI芯片

Arm v9的牙膏挤出来了,超大核机器学习性能x2,小核4年来终于更新

原文:

https://mp.weixin.qq.com/s/O8jjHNMiyjbcuSSGdHf-Ow

Arm v9架构,可以说是10年以来最大的升级。

在上月发布服务器端的Neoverse V1与N2平台之后,消费端的首批CPU终于亮相。包括Cortex-X2超大核、Cortex-A710大核以及Cortex-A510小核,分别取代X1、A78和A55。值得一提的是,小核系列上一次更新还是在2017年。超大核X2和小核A510已经完全基于64位指令集,只有A710还兼容32位。Arm说这是专为中国移动端市场保留的,因为只有中国还保留着大量32位的手机App。Arm要在2023年前彻底抛弃32位,App开发商们,再不升级就要被淘汰了。

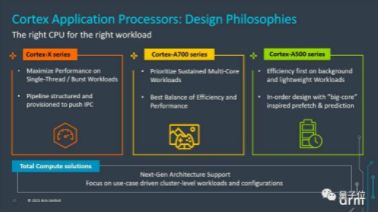

大中小核完整方案

去年开始,Arm让A系列继续保持PPA (性能、功耗、面积)的设计理念。大核A700系列将优先用于持续的主力多核负载,小核A500系列负责效率优先的轻型和后台任务。而超大核X系列被允许在尺寸和功率上继续增长,以达到更高的单核性能和应对突发的工作负载。

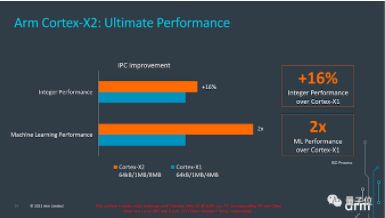

超大核X2:机器学习性能翻倍

X2与X1相比,机器学习性能则直接翻倍,在整数运算上性能也提高了16%。

算力堪比超算?谷歌推出新一代人工智能芯片

原文:

https://mp.weixin.qq.com/s/f2373pRZ2UEjBET4gKhy9Q

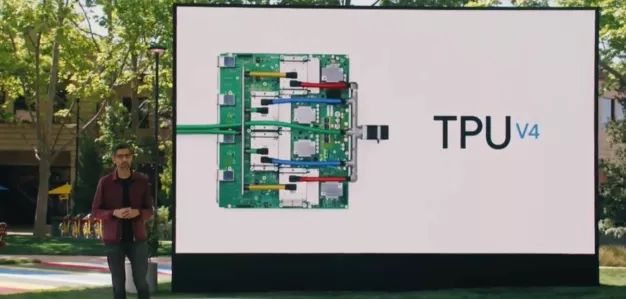

5月19日,谷歌推出新一代人工智能ASIC芯片TPUv4,运算效能是上一代产品的2倍以上。尤其值得注意的是,由4096个TPUv4单芯片组成的POD运算集群,可释放高达1exaflop(每秒10的18次方浮点运算)的算力,超过了目前全球运算速度最快的超级计算机。目前,TPUv4已应用于谷歌数据中心,预计年底之前向谷歌云用户开放。

本次推出的TPUv4,对系统内部的互联速度及架构进行优化,以进一步提升互联速度。据悉,TPUv4集群的互连带宽是大多数其他网络技术的10倍,可以提供exaflop级别计算能力。Google CEO 桑达尔 · 皮查伊(Sundar Pichai)表示,1exaflop相当于 1 千万人同时使用笔记本电脑的累加算力。此前要达到 1 exaflop,需要一台专门定制的超级计算机。

AI热点

超越YOLOv5,1.3M超轻量,高效易用,目标检测领域这一个就够了!

原文:

https://mp.weixin.qq.com/s/M4WwbyseSTymv6B3mJqttQ

论文:

https://arxiv.org/abs/2104.13534

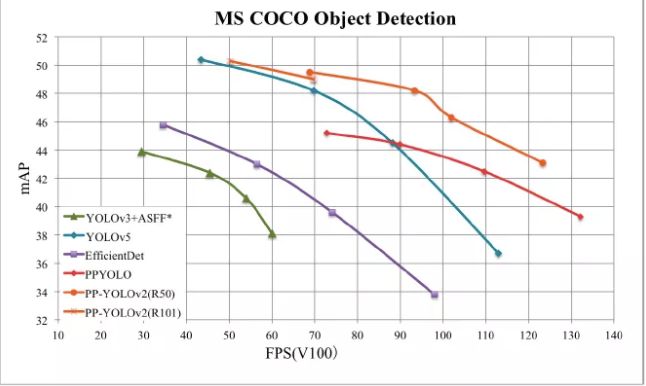

比YOLOv4、YOLOv5 更强的PP-YOLOv2,无需再纠结YOLOv3、YOLOv4、Scaled YOLOv4、YOLOv5到底选哪个了,选PP-YOLOv2就对了!最高mAP 50.3%,最高FPS106.5FPS,超越YOLOv4甚至YOLOv5!又快又好,他不香么?

论文:https://arxiv.org/abs/2104.10419

1.3M超超超轻量目标检测算法PP-YOLO Tiny

需要在AIoT边缘轻量化芯片部署?1.3M够不够小?!比YOLO-Fastest、 NanoDet更强的PP-YOLO Tiny,AI走向产业无需再等,赶紧用起来!

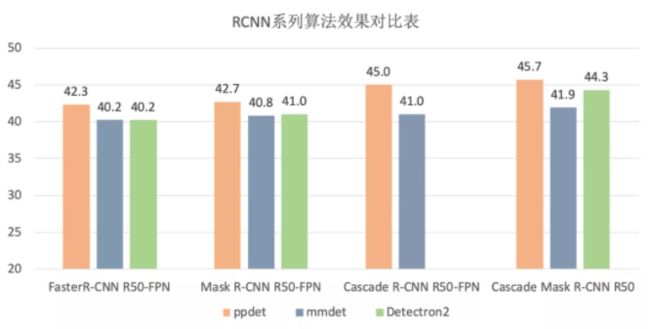

全面领先同类框架的RCNN系列算法

什么?还在用mmdetection和Detectron2?你Out了!RCNN系列模型(Faster RCNN, Mask RCNN, Cascade RCNN等)在PaddleDetection进行训练,比mmDetection和Detectron2在更短的时间获得更高的精度!

SOTA 的Anchor Free算法:PAFNet & PAFNet-Lite

连检测框都不要了?莫慌,PaddleDetection2.0带你紧跟全球科研动向。SOTA(最先进)的Anchor Free算法:PAFNet(Paddle Anchor Free)& PAFNet-Lite,从理论到直接使用,保证把你安排的明明白白!

信息来源:飞桨PaddlePaddle

让普通人秒会编程?微软在 Power 平台上集成 GPT-3,将自然语言直接变成现成代码

原文: https://mp.weixin.qq.com/s/nzmLDaocXgG6cL2VE9HNZw

去年 9 月,微软宣布获得了 OpenAI 的 GPT-3 语言模型的独家授权。而在近日举办的 Build 2021 开发者大会上,微软正式公布了收购之后的第一个商业用例:在 Microsoft Power Apps 中集成 GPT-3 的能力,可将自然语言直接转换为现成代码。虽然目前这项功能使用范围有限,只支持在微软 Power Fx 中生成公式(Power Fx 是一种由微软 Excel 公式衍生而来的低代码编程语言),但却已经显示出机器学习作为代码自动生成工具、帮助新手程序员快速投入生产的巨大潜力。微软公司低代码应用平台集团副总裁查尔斯·拉玛纳(Charles Lamanna)在采访中表示,“目前市场对于数字解决方案的需求量很大,但程序员数量却无法及时跟上。因此,除了在世界范围内推广编程学习之外,我们为什么不直接在开发环境里说大白话呢?”新功能将从今年 6 月起开放预览,它大大展现出了微软探索“低代码、无代码”的野心。但作为 GPT-3 的主要商业用例,这也只是当代 AI 领域中占主导地位的 AI 语言模型的其中一个实际应用。这些系统功能强大,几乎能够生成我们所能想象的任何文本类型,并通过多种方式操纵语言。与此同时,不少其他大型科技企业也正在探索其中蕴藏的无限可能性。谷歌已经将自己的语言 AI 模型 BERT 集成到搜索产品当中,而 Facebook 也将类似的系统引入到机器翻译等场景之下。但这些模型也有自己的问题。其核心往往来自研究人员从网络上爬取到的大量文本数据中的语言模式。就像微软的聊天机器人 Tay 会很快学会 Twitter 用户发布的侮辱性言论一样,这类模型也很可能在编码当中重现各种形式的性别歧视与种族主义表达。由此生成的输出,也可能带来意料之外的负面影响。例如,某个基于 GPT-3 的实验性聊天机器人本应发布医疗建议,却规劝模拟病患最好自行了断。拉玛纳强调,对于微软来说,使用 GPT-3 创建代码的风险虽小,但也仍然存在。该公司已经对 GPT-3 进行了微调,希望通过 Power Fx 公式示例进行训练以掌握代码转换的能力。但从根本上讲,这款程序的核心仍然基于从网络上学习到的语言模式,这意味着其中或多或少残留着某些负面元素与偏见。拉玛纳举了使用该程序查找“所有优秀求职者”的示例。程序会怎么理解这条命令?GPT-3 可以发明新的标准来回答问题,也有可能自行假设“好”跟“白人”是一回事,毕竟网上的不少言论就是这么暗示的。微软公司表示将通过多种方式解决这类问题。首先就是设定系统不会响应的违禁单词及短语列表。拉玛纳强调,“我们不会推出任何可能输出有毒言论的 AI 系统。”而如果这套系统生成了其自认为有问题的内容,还会提醒用户将结果上报给技术支持团队。之后,会有员工介入并努力解决问题。

来源公众号:AI前线

意念打字登Nature封面!每分钟写90个字符,准确率超99%,网友:我打的都比它慢

原文: https://mp.weixin.qq.com/s/M4WwbyseSTymv6B3mJqttQ

万万没想到,脑机接口这么快就有了重大突破!甚至还登上了Nature封面。一位截瘫患者,正在用“意念”打出一段话,0.5秒左右就能输出一个字母。准确率也十分惊人,高达99.1%。

RNN立功了

这位代号为T5的老爷子脑中植入的,是两个来自Braingate的电极阵列,各含有96个电极。实验刚开始就遇到第一个困难:如何识别用户什么时候开始尝试书写字母。最后发现原本用于语音识别的模型可以完成这个任务。解决这个问题之后,研究人员发现书写单个字符时观察到的脑部活动相对固定,并且总是集中在一起。看来即使瘫痪多年,运动皮层中笔迹的神经表征也没有消退。经过人工标注后,这些数据就可以作为原始数据集了。

接下来是算法,研究人员选择了循环神经网络 。除了26个字母以外,输入英文还得有一些必要的标点符号。比如空格,研究人员就要求老爷子用>代替,英文句号只有一个点也不好分辨,用~代替。此外还有逗号、顿号和问号。

不过这次研究没加入数字,可能是研究人员觉得区分z和2有点难,就留待下次解决了。

信息来源:量子位

NAACL2021 | 担心GPT-3被喂假消息?谷歌新研究,将知识图谱转成“人话”用于训练

原文:

https://mp.weixin.qq.com/s/nzmLDaocXgG6cL2VE9HNZw

论文地址:

https://arxiv.org/abs/2010.12688

还在担心大语言模型“啥都吃”,结果被用假信息训练了?放在以前,这确实是训练NLP模型时值得担心的一个难题。现在,谷歌从根本上解决了这个问题。他们做了个名为TEKGEN的AI模型,直接将知识图谱用“人话”再描述一遍,生成语料库,再喂给NLP模型训练。这是因为,知识图谱的信息来源往往准确靠谱,而且还会经过人工筛选、审核,质量有保障。目前,这项研究已经被NAACL 2021接收。谷歌用来描述知识图谱的TEKGEN模型,全名Text from KG Generator(知识图谱文本生成器)。它会读取一个知识图谱中的所有词语,捋清它们之间的关系,再用“人话”说出来。转换语句分为2步:首先,将关系图谱中的词语,按逻辑进行排列;然后,再添加一些词语、并调整语句间的逻辑关系,将它们变成一段完整的话。为了实现这个功能,TEKGEN包含4个部分:1)三元组(包含主语、宾语、关系词)生成器。将维基百科的知识图谱、和维基百科文本描述进行对应,生成训练数据集。2)T5的文本-文本生成器,用于将三元组转换成文本信息。3)实体子图创建器。用于将三元组中的文本信息转换成语句。4)语义质量滤波器。这部分用来处理低质量的输出,保证生成的语句质量。生成后的语句,就能用来放心地训练大语言模型了。这份生成的语料库,由4500万个三元组生成,组合起来的句子有1600万句。(来源:量子位)

开源项目

CVPR2021 | 商汤、港中文提出生成式渲染器+反向渲染,3D人脸重建效果逼真

原文:

https://mp.weixin.qq.com/s/nzmLDaocXgG6cL2VE9HNZw

论文地址:

https://arxiv.org/pdf/2105.02431.pdf

源码地址:https://github.com/WestlyPark/StyleRenderer

在传统计算机图像学里,渲染一张真实的人脸需要对人脸进行几何建模的同时,还需获得复杂的环境光照条件和人脸皮肤表面的反射材质,因而通过以图像渲染结果与真实图片之间的误差来优化可变形的人脸模型的过程中会进行繁琐的求导和不稳定的优化过程,而简单的利用卷积神经网络的回归特性来学习人脸模型和图片直接的转换过程会丧失比较多的生成细节,从而难以通过该方式比较高效地从拍摄图片获得人脸 3D 模型。该算法核心是提出一个更真实的生成式渲染器(GAR)与一种反向渲染以实现人脸重建的方法。生成式渲染器(GAR)比传统的基于图形学的渲染器有更加真实的渲染效果,从而减小渲染图片与真实图片之间的差异。而反向渲染技术可以充分利用生成式渲染器的优势,以生成与给定图像相似的图片为目标,反推出输入的人脸形状与纹理。该算法不但在点云的平均误差上达到目前人脸重建领域的最优效果,在几何的相似度和精细度上也大大超越已有方法。针对渲染效果不真实的问题,该论文提出了一个更真实的生成式渲染器(GAR)。生成式渲染器(GAR)的输入在几何部分与传统渲染器相同,由位姿和 3D 网格控制人脸位置和状态,但在生成渲染结果方面并没有根据固定的纹理贴图来显示计算光照和反射照度,而是利用风格化的卷积网络把基于网格得到的法向信息转换成颜色。一方面,保持了在基于物理光照的渲染模型中每个像素在幕布上的颜色由法向量控制的物理含义,另一方面,把复杂的人脸纹理交由生成器根据训练集分布找出压缩后的表示模式进行转换。在模型以外的部分,例如头发、牙齿等交由生成器进行生成,避免了为了渲染真实效果而对这些部位更进一步的复杂建模。具体实现上,该生成式渲染器(GAR)输入三个控制变量,其中法向图 n 由人脸形状、表情、位姿等系数生成得到,用于控制人脸几何、隐编码 z 用于控制皮肤纹理、头发配饰、背景等要素、噪声ɛ用于增加多样性。(来源:机器之心)

CVPR2021 | 实例分割新突破!港科大&快手开源重叠双层的深度遮挡感知实例分割

原文: https://mp.weixin.qq.com/s/nzmLDaocXgG6cL2VE9HNZw

论文地址:https://arxiv.org/pdf/2103.12340.pdf

源码地址:https://github.com/lkeab/BCNet

物体互相遮挡在日常生活中普遍存在,严重的遮挡会带来易混淆的遮挡边界及非连续自然的物体形状,从而导致当前已有的检测及分割等的算法的性能大幅下降。该研究系统提出了一个轻量级且能有效处理遮挡的实例分割算法,在工业界也具有极大意义。随着短视频作为主要信息传播媒介不断渗透进日常生活,在实际的物体分割应用场景中,分割的准确性直接影响着用户的使用体验和产品观感。因此,如何将实例分割技术应用在复杂的日常应用场景并保持高精度,此项研究给出了一个合理、有效的解决方案。整个分割系统分为两个部分,物体检测部分和物体分割部分。输入单张图像,使用基于Faster R-CNN或者FCOS的物体检测算法预测感兴趣目标区域(RoI)候选框坐标(x,y,w,h),采用Resnet-50/101及特征金字塔作为基础网络(backbone)获取整张输入图片的特征。使用RoI Align算法根据物体检测框位置,在整张图片特征图内准确抠取感兴趣目标区域的特征子图,并将其作为双图卷积神经网络的输入用于最终的物体分割。实例分割网络BCNet由级联状的双图层神经网络组成:a.第一个图层对感兴趣目标区域内遮挡物体(Occluder)的形状和外观进行显式建模,该层图卷积网络包含四层,即卷积层(卷积核大小3x3)、图卷积层(Non-local Layer)以及末尾的两个卷积(卷积核大小3x3)。第一个图卷积网络输入感兴趣目标区域特征,输出感兴趣目标框中遮挡物体的边界和掩膜。b.第二个图层结合第一个图卷积网络(用于对遮挡物体建模)已经提取的遮挡物体信息(包括遮挡物的Boundary和Mask),具体做法是将步骤2中得到的感兴趣目标区域特征与经过第一个图卷积网络中最后一层卷积后的特征3a相加,得到新的特征,并将其作为第二个图卷积网络(用于被遮挡物分割)的输入。第二个图卷积网络与第一个图卷积网络结构相同,构成级联网络关系。该操作将遮挡与被遮挡关系同时考虑进来,能有效地区分遮挡物与被遮挡物的相邻物体边界,最终输出目标区域被遮挡目标物体(Occludee)的分割结果。c.为了减少模型的参数量,使用非局部算子(Non-local Operator)操作进行图卷积层的实现,具体实现位于结构图左上位置,包含三个卷积核大小为1x1的卷积层以及Softmax算子,其将图像空间中像素点根据对应特征向量的相似度有效关联起来,实现输入目标区域特征的重新聚合,能较好解决同一个物体的像素点在空间上被遮挡截断导致不连续的问题。(来源:极市平台)

文末福利

【AI实战,附源代码】手把手教你文字识别(检测篇:MSER, CTPN, SegLink, EAST等方法)

链接:

https://mp.weixin.qq.com/s/jHOkFQiGjcAeUdEPdwiv6g

文字检测是文字识别过程中的一个非常重要的环节,文字检测的主要目标是将图片中的文字区域位置检测出来,以便于进行后面的文字识别,只有找到了文本所在区域,才能对其内容进行识别。

文字检测的场景主要分为两种,一种是简单场景,另一种是复杂场景。其中,简单场景的文字检测较为简单,例如像书本扫描、屏幕截图、或者清晰度高、规整的照片等;而复杂场景,主要是指自然场景,情况比较复杂,例如像街边的广告牌、产品包装盒、设备上的说明、商标等等,存在着背景复杂、光线忽明忽暗、角度倾斜、扭曲变形、清晰度不足等各种情况,文字检测的难度更大。

本文将介绍简单场景、复杂场景中常用的文字检测方法,包括“形态学操作、MSER+NMS、CTPN、SegLink、EAST”等方法,并主要以ICDAR场景文字图片数据集介绍如何使用这些方法,如下图:

![]()

作为RISC-V2021中国峰会同期活动,06月24下午 RT-Thread将联合中科蓝讯开展 “基于RISC-V MCU+RT-Thread的应用开发培训” 欢迎大家报名参加,了解更多关于RISC-V的情况,请扫描下方二维码:

扫码报名活动

你可以添加微信17775982065为好友,注明:公司+姓名,拉进 RT-Thread 官方微信交流群!

???????????? 点击阅读原文报名活动