pytorch conv1d原理说明

原理说明

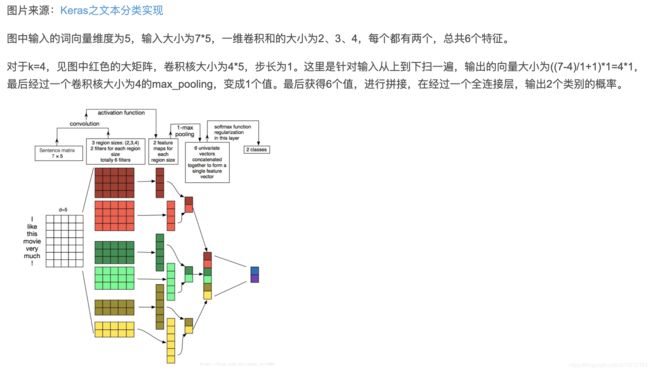

总结:conv1d对最后一个维度进行卷积,以文本为例,conv1d是将文本的序列维度和embedding维度进行压缩,序列长度这一维按照正常卷积,embeding这一维由设置根据输出的outchannel决定,此处设置的是1,一般计算前,请将序列这一维度permute到最后一维,embedding这一维度调整到倒数第二维。

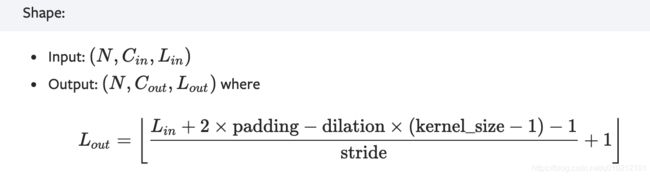

conv1d官方接口

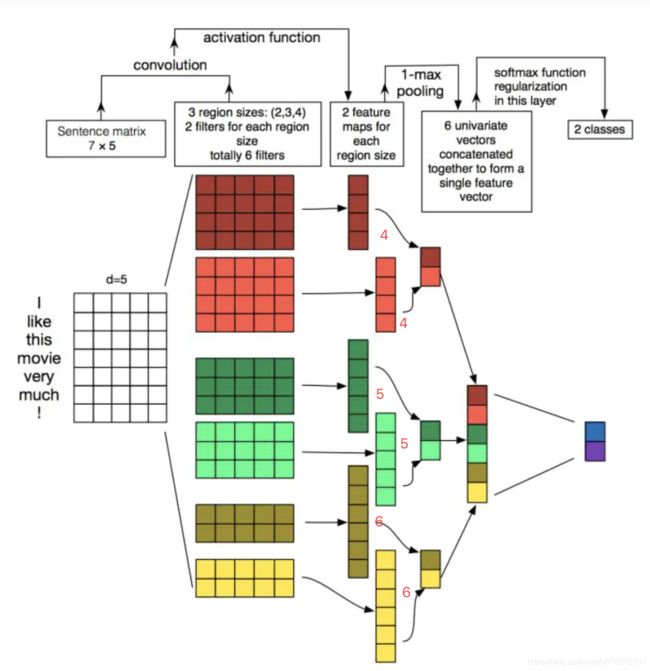

参见【原理说明】这一节的图,我们假设输入为7*5,那么:

- kernel_size 卷积核大小为2/3/4

- N 为batchsize

- dilation 为卷积核内部某一纬度相邻元素的差值,默认为1

- padding 为填充大小,为调整输入大小的一个参数,默认0

- Cin 和Cout 为channel大小,Cin为输入文本通道即为embedding大小5,Cout即为卷积产生的通道数,这里就是指卷积核的个数,这里都是了2

- Lin 就是输入的维度大小,Lin=7,即就是句子的长度,Lout就是Lin维度对应的输出维度大小

尝试按照如上公式计算下Lout:

- 当kernel_size=2时,即实际计算是用的 2x5这个核计算的(5就是最后一个维度的大小,将最后一维抹平为1维)

Lout=[( 7+2×0-1*(2-1)-1 )/1 + 1] = 6,同理可得 kernel_size=3、4时,Lout=5、4,如下图所示的位置。

仅供参考,如有疑问,欢迎交流。

Ref:

https://blog.csdn.net/sunny_xsc1994/article/details/82969867

官方api说明

关于channel的说明,见:https://www.cnblogs.com/Terrypython/p/10310531.html