2.1通过极简方案构建mnist手写数字识别模型(百度架构师手把手带你零基础实践深度学习原版笔记系列)

通过极简方案构建mnist手写数字识别模型

0前提条件

在数据处理前,首先要加载飞桨与手写数字识别模型相关的类库,实现方法如下。

#加载飞桨和相关类库

import paddle

import paddle.fluid as fluid

from paddle.fluid.dygraph.nn import Linear

import numpy as np

import os

from PIL import Image1数据处理

飞桨提供了多个封装好的数据集API,涵盖计算机视觉、自然语言处理、推荐系统等多个领域,帮助读者快速完成深度学习任务。如在手写数字识别任务中,通过paddle.dataset.mnist可以直接获取处理好的MNIST训练集、测试集,飞桨API支持如下常见的学术数据集:

- mnist

- cifar

- Conll05

- imdb

- imikolov

- movielens

- sentiment

- uci_housing

- wmt14

- wmt16

通过paddle.dataset.mnist.train()函数设置数据读取器,batch_size设置为8,即一个批次有8张图片和8个标签,代码如下所示。

# 如果~/.cache/paddle/dataset/mnist/目录下没有MNIST数据,API会自动将MINST数据下载到该文件夹下

# 设置数据读取器,读取MNIST数据训练集

trainset = paddle.dataset.mnist.train()

# 包装数据读取器,每次读取的数据数量设置为batch_size=8

train_reader = paddle.batch(trainset, batch_size=8)Cache file /home/aistudio/.cache/paddle/dataset/mnist/train-images-idx3-ubyte.gz not found, downloading https://dataset.bj.bcebos.com/mnist/train-images-idx3-ubyte.gz Begin to download Download finished Cache file /home/aistudio/.cache/paddle/dataset/mnist/train-labels-idx1-ubyte.gz not found, downloading https://dataset.bj.bcebos.com/mnist/train-labels-idx1-ubyte.gz Begin to download ........ Download finished

paddle.batch函数将MNIST数据集拆分成多个批次,通过如下代码读取第一个批次的数据内容,观察打印结果。

# 以迭代的形式读取数据

for batch_id, data in enumerate(train_reader()):

# 获得图像数据,并转为float32类型的数组

img_data = np.array([x[0] for x in data]).astype('float32')

# 获得图像标签数据,并转为float32类型的数组

label_data = np.array([x[1] for x in data]).astype('float32')

# 打印数据形状

print("图像数据形状和对应数据为:", img_data.shape, img_data[0])

print("图像标签形状和对应数据为:", label_data.shape, label_data[0])

break

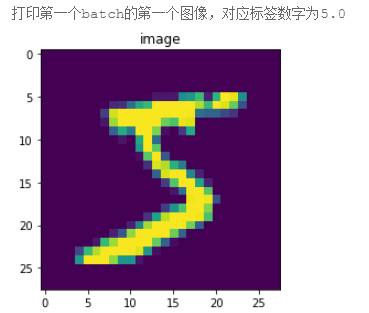

print("\n打印第一个batch的第一个图像,对应标签数字为{}".format(label_data[0]))

# 显示第一batch的第一个图像

import matplotlib.pyplot as plt

# img_data里面的数据经过了标准化范围[-1,1],经过变换变成[0,255]

img = np.array(img_data[0]+1)*127.5

img = np.reshape(img, [28, 28]).astype(np.uint8)

plt.figure("Image") # 图像窗口名称

plt.imshow(img)

plt.axis('on') # 关掉坐标轴为 off

plt.title('image') # 图像题目

plt.show()图像数据形状和对应数据为: (8, 784) [-1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -0.9764706 -0.85882354 -0.85882354 -0.85882354 -0.01176471 0.06666672 0.37254906 -0.79607844 0.30196083 1. 0.9372549 -0.00392157 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -0.7647059 -0.7176471 -0.26274508 0.20784318 0.33333337 0.9843137 0.9843137 0.9843137 0.9843137 0.9843137 0.7647059 0.34901965 0.9843137 0.8980392 0.5294118 -0.4980392 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -0.6156863 0.8666667 0.9843137 0.9843137 0.9843137 0.9843137 0.9843137 0.9843137 0.9843137 0.9843137 0.96862745 -0.27058822 -0.35686272 -0.35686272 -0.56078434 -0.69411767 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -0.85882354 0.7176471 0.9843137 0.9843137 0.9843137 0.9843137 0.9843137 0.5529412 0.427451 0.9372549 0.8901961 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -0.372549 0.22352946 -0.1607843 0.9843137 0.9843137 0.60784316 -0.9137255 -1. -0.6627451 0.20784318 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -0.8901961 -0.99215686 0.20784318 0.9843137 -0.29411763 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. 0.09019613 0.9843137 0.4901961 -0.9843137 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -0.9137255 0.4901961 0.9843137 -0.45098037 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -0.7254902 0.8901961 0.7647059 0.254902 -0.15294117 -0.99215686 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -0.36470586 0.88235295 0.9843137 0.9843137 -0.06666666 -0.8039216 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -0.64705884 0.45882356 0.9843137 0.9843137 0.17647064 -0.7882353 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -0.8745098 -0.27058822 0.9764706 0.9843137 0.4666667 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. 0.9529412 0.9843137 0.9529412 -0.4980392 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -0.6392157 0.0196079 0.43529415 0.9843137 0.9843137 0.62352943 -0.9843137 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -0.69411767 0.16078436 0.79607844 0.9843137 0.9843137 0.9843137 0.9607843 0.427451 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -0.8117647 -0.10588235 0.73333335 0.9843137 0.9843137 0.9843137 0.9843137 0.5764706 -0.38823527 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -0.81960785 -0.4823529 0.67058825 0.9843137 0.9843137 0.9843137 0.9843137 0.5529412 -0.36470586 -0.9843137 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -0.85882354 0.3411765 0.7176471 0.9843137 0.9843137 0.9843137 0.9843137 0.5294118 -0.372549 -0.92941177 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -0.5686275 0.34901965 0.77254903 0.9843137 0.9843137 0.9843137 0.9843137 0.9137255 0.04313731 -0.9137255 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. 0.06666672 0.9843137 0.9843137 0.9843137 0.6627451 0.05882359 0.03529418 -0.8745098 -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. -1. ] 图像标签形状和对应数据为: (8,) 5.0 打印第一个batch的第一个图像,对应标签数字为5.0

从打印结果看,从数据加载器train_reader()中读取一次数据,可以得到形状为(8, 784)的图像数据和形状为(8,)的标签数据。其中,形状中的数字8与设置的batch_size大小对应,784为MINIST数据集中每个图像的像素大小(28*28)。

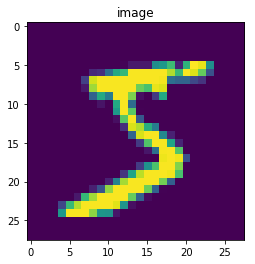

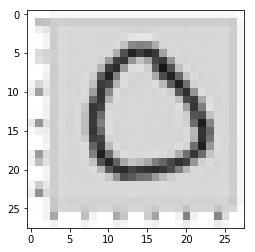

此外,从打印的图像数据来看,图像数据的范围是[-1, 1],表明这是已经完成图像归一化后的图像数据,并且空白背景部分的值是-1。将图像数据反归一化,并使用matplotlib工具包将其显示出来,如图2 所示。可以看到图片显示的数字是5,和对应标签数字一致。

图2:matplotlib打印结果示意图

说明:

飞桨将维度是28*28的手写数字图像转成向量形式存储,因此使用飞桨数据加载器读取到的手写数字图像是长度为784(28*28)的向量。

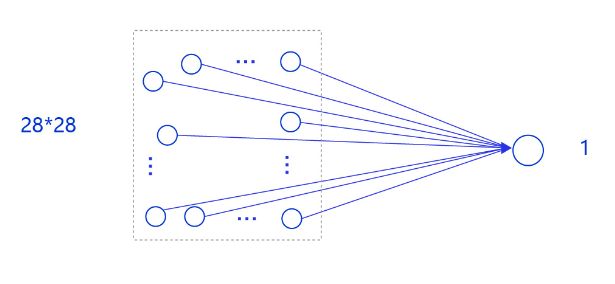

2模型设计(先使用回归模型做框架)

在房价预测深度学习任务中,我们使用了单层且线性变换的模型,取得了理想的预测效果。在手写数字识别任务中,我们依然使用这个模型预测输入的图形数字值。其中,模型的输入为784维(28*28)数据,输出为1维数据,如 图6 所示。

图6:手写数字识别网络模型

输入像素的位置排布信息对理解图像内容非常重要(如将原始尺寸为28*28图像的像素按照7*112的尺寸排布,那么其中的数字将不可识别),因此网络的输入设计为28*28的尺寸,而不是1*784,以便于模型能够正确处理像素之间的空间信息。

说明:

事实上,采用只有一层的简单网络(对输入求加权和)时并没有处理位置关系信息,因此可以猜测出此模型的预测效果有限。在后续优化环节中,介绍的卷积神经网络则更好的考虑了这种位置关系信息,模型的预测效果也会显著提升。

下面以类的方式组建手写数字识别的网络,实现方法如下所示。

# 定义mnist数据识别网络结构,同房价预测网络

class MNIST(fluid.dygraph.Layer):

def __init__(self):

super(MNIST, self).__init__()

# 定义一层全连接层,输出维度是1,激活函数为None,即不使用激活函数

self.fc = Linear(input_dim=784, output_dim=1, act=None)

# 定义网络结构的前向计算过程

def forward(self, inputs):

outputs = self.fc(inputs)

return outputs训练配置

训练配置需要先生成模型实例(设为“训练”状态),再设置优化算法和学习率(使用随机梯度下降SGD,学习率设置为0.001),实现方法如下所示。

# 定义飞桨动态图工作环境

with fluid.dygraph.guard():

# 声明网络结构

model = MNIST()

# 启动训练模式

model.train()

# 定义数据读取函数,数据读取batch_size设置为16

train_loader = paddle.batch(paddle.dataset.mnist.train(), batch_size=16)

# 定义优化器,使用随机梯度下降SGD优化器,学习率设置为0.001

optimizer = fluid.optimizer.SGDOptimizer(learning_rate=0.001, parameter_list=model.parameters())3训练过程

训练过程采用二层循环嵌套方式,训练完成后需要保存模型参数,以便后续使用。

- 内层循环:负责整个数据集的一次遍历,遍历数据集采用分批次(batch)方式。

- 外层循环:定义遍历数据集的次数,本次训练中外层循环10次,通过参数EPOCH_NUM设置。

# 通过with语句创建一个dygraph运行的context

# 动态图下的一些操作需要在guard下进行

with fluid.dygraph.guard():

model = MNIST()

model.train()

train_loader = paddle.batch(paddle.dataset.mnist.train(), batch_size=16)

optimizer = fluid.optimizer.SGDOptimizer(learning_rate=0.001, parameter_list=model.parameters())

EPOCH_NUM = 10

for epoch_id in range(EPOCH_NUM):

for batch_id, data in enumerate(train_loader()):

#准备数据,格式需要转换成符合框架要求

image_data = np.array([x[0] for x in data]).astype('float32')

label_data = np.array([x[1] for x in data]).astype('float32').reshape(-1, 1)

# 将数据转为飞桨动态图格式

image = fluid.dygraph.to_variable(image_data)

label = fluid.dygraph.to_variable(label_data)

#前向计算的过程

predict = model(image)

#计算损失,取一个批次样本损失的平均值

loss = fluid.layers.square_error_cost(predict, label)

avg_loss = fluid.layers.mean(loss)

#每训练了1000批次的数据,打印下当前Loss的情况

if batch_id !=0 and batch_id % 1000 == 0:

print("epoch: {}, batch: {}, loss is: {}".format(epoch_id, batch_id, avg_loss.numpy()))

#后向传播,更新参数的过程

avg_loss.backward()

optimizer.minimize(avg_loss)

model.clear_gradients()

# 保存模型

fluid.save_dygraph(model.state_dict(), 'mnist')epoch: 0, batch: 1000, loss is: [1.914191] epoch: 0, batch: 2000, loss is: [4.203541] epoch: 0, batch: 3000, loss is: [3.6532393] epoch: 1, batch: 1000, loss is: [1.7960105] epoch: 1, batch: 2000, loss is: [3.9927847] epoch: 1, batch: 3000, loss is: [3.5099282] epoch: 2, batch: 1000, loss is: [1.7756804] epoch: 2, batch: 2000, loss is: [3.8704638] epoch: 2, batch: 3000, loss is: [3.4187527] epoch: 3, batch: 1000, loss is: [1.7850097] epoch: 3, batch: 2000, loss is: [3.8069916] epoch: 3, batch: 3000, loss is: [3.3495646] epoch: 4, batch: 1000, loss is: [1.8023555] epoch: 4, batch: 2000, loss is: [3.7758842] epoch: 4, batch: 3000, loss is: [3.291829] epoch: 5, batch: 1000, loss is: [1.8208311] epoch: 5, batch: 2000, loss is: [3.7620187] epoch: 5, batch: 3000, loss is: [3.242042] epoch: 6, batch: 1000, loss is: [1.8383725] epoch: 6, batch: 2000, loss is: [3.757275] epoch: 6, batch: 3000, loss is: [3.1988058] epoch: 7, batch: 1000, loss is: [1.8544042] epoch: 7, batch: 2000, loss is: [3.7573588] epoch: 7, batch: 3000, loss is: [3.161274] epoch: 8, batch: 1000, loss is: [1.8688419] epoch: 8, batch: 2000, loss is: [3.7599602] epoch: 8, batch: 3000, loss is: [3.1287313] epoch: 9, batch: 1000, loss is: [1.8817756] epoch: 9, batch: 2000, loss is: [3.7638302] epoch: 9, batch: 3000, loss is: [3.1005385]

通过观察上述代码可以发现,手写数字识别的代码与房价预测任务几乎一致,如果不是下述读取数据的两行代码有所差异,往往会误认为这是房价预测的模型。

#准备数据,格式需要转换成符合框架要求

image_data = np.array([x[0] for x in data]).astype('float32')

label_data = np.array([x[1] for x in data]).astype('float32').reshape(-1, 1)

另外,从训练过程中Loss发生的变化可以发现,虽然Loss整体上在降低,但到训练的最后一轮,Loss值依然较高。可以猜测手写数字识别完全复用房价预测的代码,训练效果并不好。接下来我们通过模型测试,获取模型训练的真实效果。

4模型测试

模型测试的主要目的是验证训练好的模型是否能正确识别出数字,包括如下四步:

- 声明实例

- 加载模型:加载训练过程中保存的模型参数。

- 灌入数据:将测试样本传入模型,模型的状态设置为校验状态(eval),显式告诉框架我们接下来只会使用前向计算的流程,不会计算梯度和梯度反向传播。

- 获取预测结果,取整后作为预测标签输出。

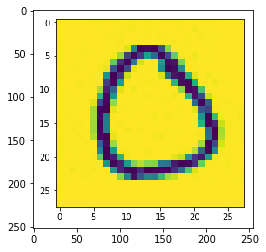

在模型测试之前,需要先从'./work/example_0.jpg'文件中读取样例图片,并进行归一化处理(本地处理的话根据自己本地路径来)。

# 导入图像读取第三方库

import matplotlib.image as mpimg

import matplotlib.pyplot as plt

import cv2

import numpy as np

# 读取图像

img1 = cv2.imread('./work/example_0.png')

example = mpimg.imread('./work/example_0.png')

# 显示图像

plt.imshow(example)

plt.show()

im = Image.open('./work/example_0.png').convert('L')

print(np.array(im).shape)

im = im.resize((28, 28), Image.ANTIALIAS)

plt.imshow(im)

plt.show()

print(np.array(im).shape)

(252, 255)

(28, 28)

# 读取一张本地的样例图片,转变成模型输入的格式

def load_image(img_path):

# 从img_path中读取图像,并转为灰度图

im = Image.open(img_path).convert('L')

print(np.array(im))

im = im.resize((28, 28), Image.ANTIALIAS)

im = np.array(im).reshape(1, -1).astype(np.float32)

# 图像归一化,保持和数据集的数据范围一致

im = 1 - im / 127.5

return im

# 定义预测过程

with fluid.dygraph.guard():

model = MNIST()

params_file_path = 'mnist'

img_path = './work/example_0.png'

# 加载模型参数

model_dict, _ = fluid.load_dygraph("mnist")

model.load_dict(model_dict)

# 灌入数据

model.eval()

tensor_img = load_image(img_path)

result = model(fluid.dygraph.to_variable(tensor_img))

# 预测输出取整,即为预测的数字,打印结果

print("本次预测的数字是", result.numpy().astype('int32'))[[255 255 255 ... 255 255 255] [255 255 255 ... 255 255 255] [255 255 255 ... 255 255 255] ... [255 255 255 ... 255 255 255] [255 255 255 ... 255 255 255] [255 255 255 ... 255 255 255]] 本次预测的数字是 [[4]]

从打印结果来看,模型预测出的数字是与实际输出的图片的数字不一致。这里只是验证了一个样本的情况,如果我们尝试更多的样本,可发现许多数字图片识别结果是错误的。因此完全复用房价预测的实验并不适用于手写数字识别任务!

接下来我们会对手写数字识别实验模型进行逐一改进,直到获得令人满意的结果。