MyDLNote - GAN : 2020 ECCV 让 GAN 拥有 Disentangled Representation:对 VAE 使用蒸馏

2020 ECCV

High-Fidelity Synthesis with Disentangled Representation

Wonkwang Lee1, Donggyun Kim1, Seunghoon Hong1, Honglak Lee2,3

- KAIST 2. University of Michigan 3. Google Brain

1 {wonkwang.lee,kdgyun425,seunghoon.hong}@kaist.ac.kr 2,3honglak@{umich.edu,google.com}

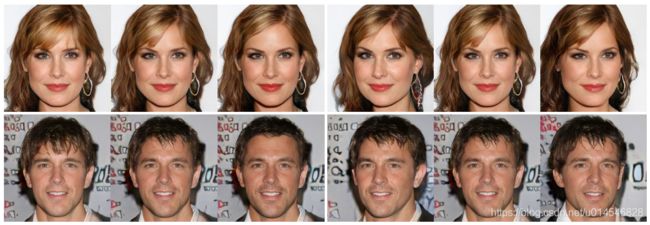

Figure 1. Generated images on the CelebA-HQ dataset [34]. The proposed framework allows synthesizing high-resolution images (1024×1204 pixels) using the disentangled representation learned by VAEs.

我的笔记:

本文的解决了图像生成领域内非常重要的问题:VAE 可以有效学习解耦表示,但生成图像质量不高;GAN 可以生成高质量图像,但不能学习解耦表示。

本文提出一种模型,同时学习解耦表示和高质量生成。方法即:step1,将 VAE 中学到的解耦表示;step2,通过蒸馏技术,传递给 GAN。这样,GAN 中有解耦表示,同时生成高质量图像。这个模型被称为 Information Distillation Generative Adversarial Network (ID-GAN)。

当然,这其中还有很多技术。请看原文:ID-GAN。

Abstract

Learning disentangled representation of data without supervision is an important step towards improving the interpretability of generative models. Despite recent advances in disentangled representation learning, existing approaches often suffer from the trade-off between representation learning and generation performance (i.e. improving generation quality sacrifices disentanglement performance).

提出问题:尽管最近在解耦表示学习方面取得了进展,但现有的方法经常在表示学习和生成性能之间进行权衡 (即提高生成质量牺牲了解耦性能)。

We propose an Information-Distillation Generative Adversarial Network (ID-GAN), a simple yet generic framework that easily incorporates the existing state-of-the-art models for both disentanglement learning and high-fidelity synthesis. Our method learns disentangled representation using VAE-based models, and distills the learned representation with an additional nuisance variable to the separate GAN-based generator for high-fidelity synthesis. To ensure that both generative models are aligned to render the same generative factors, we further constrain the GAN generator to maximize the mutual information between the learned latent code and the output.

提出了一种信息蒸馏生成对抗网络(ID-GAN),可以实现解耦学习和高保真。本文的方法使用VAE-based模型学习解耦表示,并将学习到的表示和nuisance 变量提取到单独的基于GAN的生成器,以实现高保真合成。为了确保两个生成模型是对齐的,以呈现相同的生成因子,我们进一步约束GAN生成器,以最大化学习的潜在编码(latent code)和输出之间的互信息。

Despite the simplicity, we show that the proposed method is highly effective, achieving comparable image generation quality to the state-of-the-art methods using the disentangled representation. We also show that the proposed decomposition leads to an efficient and stable model design, and we demonstrate photo-realistic high-resolution image synthesis results (1024x1024 pixels) for the first time using the disentangled representations.

本文的模型简单,且提出的方法是高度有效的,达到可比的图像生成质量的最先进的方法使用的解耦表示。首次使用解耦表征实现真实感高分辨率图像合成结果 (1024x1024像素)。

Introduction

在没有监督的情况下学习一个紧凑和可解释的数据表示,对于提高对数据和机器学习系统的理解是很重要的。最近,有人提出使用独立的数据变化因素来表示数据的解耦表示可以提高表示的可解释性(interpretability)和可转让性(transferability)。在解耦表示的各种用例中,我们对生成模型的应用特别感兴趣,因为它允许用户通过控制每个潜在维度中编码的生成因子,在输出中指定所需的属性。在不同的领域,如图像处理、药物开发、ML公平性等,对生成模型的需求越来越大。

在之前的无监督解耦表示学习的研究中,大部分都将问题表述为约束生成建模任务。基于成熟的框架,如变分自动编码器 (VAE) 或生成对抗网络 (GAN),它们引入了额外的正则化,以鼓励潜在流形的轴与数据中的独立生成因子对齐。基于VAE 的方法通过添加隐式或显式惩罚,以支持因数化潜在表示来增强其目标函数。另一方面,基于 GAN 的方法提出对生成器进行正则化,以增加输入潜码与输出之间的互信息。

现有方法的一个主要挑战是学习解耦表示和生成真实数据之间的权衡。VAE-based 方法在学习各种任务中有用的解耦表示时是有效的,但它们的生成质量通常比当前的 SOTA 差。GAN-based 的方法可以在不需要显式似然估计的情况下,以更有表现力的解码器实现高质量的合成。然而,它们往往比VAE对应对象学习更多的耦合表示,并且众所周知,即使使用最近的技术来稳定训练,也很难训练。

为了避免这种权衡,我们提出了一个简单和通用的框架来结合解耦表示学习和高保真生成。不同以前的方法通过一个单一的目标共同解决这两个问题,我们提出了两个独立但连续的问题:首先使用VAE学习一种解耦表示,然后将学习到的表示提取到GAN中进行高保真合成。从 VAE 到 GAN 的蒸馏是通过传递推理模型进行的,该模型提供了一个有意义的潜在分布,而不是一个简单的高斯先验,并确保两个模型是一致的,以呈现相同的生成因子。这种分解也自然允许分层的方法来学习潜表示,首先通过VAE学习主要的解耦因子,然后通过GAN学习丢失 (耦合) 妨害因子(nuisance factors)。我们将所提出的方法称为信息蒸馏生成对抗网络 Information Distillation Generative Adversarial Network (ID-GAN)。

Background: Disentanglement Learning

无监督分离学习的目的是使用一组统计上独立的生成因子z来描述每个数据x。本节简要回顾之前的工作,并讨论其优点和局限性。

目前最先进的无监督解耦学习方法主要是基于变分自编码器 (VAE)。他们重写了最初的目标,并推导出了鼓励潜在变量解耦的规则。例如,β-VAE [17] 提出对边际对数似然的 Evidence LowerBound (ELBO) 进行优化

当设置 β 值为1时,会还原到原来的 VAE。

通过迫使变分后验更接近经因子分解的先验 (1),模型学习了一种更解耦表示,但牺牲了生成质量,因为它也减少了 z 和 x 之间的互信息。为了解决这种权衡和提高生成质量,最近的方法提出逐步退火惩罚的 KL-divergence [7],或分解它来分离总相关的惩罚 [51],鼓励了潜在变量的统计独立性。

[17] β-VAE: Learning basic visual concepts with a constrained variational framework. In ICLR, 2017.

[7] Guillaume Desjardins, and Alexander Lerchner. Understanding disentangling in β-VAE

[51] Information Theoretical Analysis of Multivariate Correlation. IBM Journal of Research and Development, 1960

基于VAE的方法在学习从合成到复杂数据集的一系列任务的解耦表示中被证明是有效的。然而,它们的生成性能通常不足以实现高保真生成,即使使用最近的技术来分离潜在变量的因式分解。

这一问题从根本上归结为两个原因:首先,大多数基于 VAE 的方法都假设了完全独立的生成因子。这种严格的假设过分简化了潜在的流形,可能会导致生成实际数据所需的有用信息 (例如相关因素) 的丢失。其次,他们通常利用一个简单的生成器,如因式分解高斯解码器(factorized Gaussian decoder),并学习从潜在空间到输入空间的单模态映射。虽然这可能是有用的学习有意义的表示 (例如捕获一个局部的结构模式),这样的解码器使它难以渲染复杂的模式输出 (例如纹理)。

High-Fidelity Synthesis via Distillation

我们的目标是构建一个生成模型 Gω:Z→X 产生高保真输出 x∈X 和一个可判断的潜在编码(code) z∈Z (即解耦表示)。为了实现这个目标,我们在基于 VAE-based 模型的基础上构建了我们的框架,因为它们在学习解耦表示方面很有效。

由于完全分解潜在变量的严格限制和简单解码器的使用,VAE导致生成质量的牺牲。我们的目标是改善基于VAE-based模型,提高生成质量,同时保持其解耦学习性能。

图2描述了所提算法的总体框架。

形式上,设 z = (s, c) 表示由解耦变量c和扰害变量(nuisance variable)s 组成的潜在变量,分别捕获变异的独立因素和相关因素。在提出的框架中,我们首先训练 VAE (如 Eq.(1))来学习数据的解耦表示,其中每个观测 x 可以在训练后由已学习的编码器![]() 。然后在第二阶段,我们固定这个编码器

。然后在第二阶段,我们固定这个编码器 ![]() 并训练生成器 Gω(z) = Gω(s,c),通过优化以下目标,实现高保真合成同时蒸馏学到的解耦:

并训练生成器 Gω(z) = Gω(s,c),通过优化以下目标,实现高保真合成同时蒸馏学到的解耦:

其中,![]() 编码器网络的后验集合。与 [10] 类似,式 (4) 对应的潜在编码与生成器输出I(c) 之间互信息的变分下界

编码器网络的后验集合。与 [10] 类似,式 (4) 对应的潜在编码与生成器输出I(c) 之间互信息的变分下界 ![]() ,但不同的是,(1) c 是从聚合的后验

,但不同的是,(1) c 是从聚合的后验 ![]() 而不是先验

而不是先验 ![]() 采样,(2) 它仅针对生成器进行优化。注意,我们把

采样,(2) 它仅针对生成器进行优化。注意,我们把 ![]() 当作一个常数,因为

当作一个常数,因为 ![]() 在式 (4) 中是固定的。我们将所提出的模型称为信息蒸馏生成对抗网络。

在式 (4) 中是固定的。我们将所提出的模型称为信息蒸馏生成对抗网络。