- 深入解读MaaS技术架构:从模型服务到智能部署的全流程分析

Cc不爱吃洋葱

架构人工智能大语言模型大模型智能部署MaaS技术架构LLM

随着人工智能(AI)的迅速发展,MaaS(ModelasaService,模型即服务)技术架构应运而生。它通过将复杂的AI模型封装为标准化服务,降低了模型的开发和部署门槛,帮助企业快速实现业务场景的智能化升级。本文将深入解析MaaS技术架构,详细阐述其各个组成部分以及如何在实际应用中高效发挥其功能。一、使用方层:从应用接入到业务赋能MaaS技术架构的顶层是使用方层,它主要面向第三方应用,是企业与M

- 想要了解大模型,看懂这一篇就够了!大模型工作流程及核心参数介绍!

Gq.xxu

qwen3vllmtransforms大语言模型部署深度学习人工智能

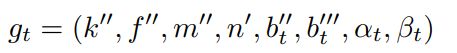

若想深入探究大模型核心参数的效果与作用,就务必先弄清大模型的工作流程,明确核心参数在流程各阶段的效能与功能,知晓其具体含义。一,大模型的工作流程大模型运行时的工作原理可以概括为输入处理→特征提取→模型推理→结果生成四个核心阶段,整个过程融合了深度学习架构、自然语言处理技术以及分布式计算能力。从用户输入到大模型输出,整个工作的处理流程如下:输入文本→分词→嵌入+位置编码→Transformer多层处

- 「源力觉醒 创作者计划」_以FastDeploy为例部署ERNIE-4.5-21B大模型全流程实践

cooldream2009

大模型基础AI技术文心大模型FastDeploy

目录前言1环境准备与依赖安装1.1硬件要求1.2Python环境与pip升级2下载ERNIE-4.5模型权重2.1安装HuggingFaceCLI工具2.2设置国内镜像加速(可选)2.3下载模型文件3安装FastDeploy与Paddle推理引擎3.1安装PaddlePaddle-GPU版本3.2安装FastDeploy-GPU4启动ERNIE-4.5本地服务4.1启动OpenAI兼容API服务4

- LSTM 论文(Hochreiter & Schmidhuber, 1997)精读(三)

文章:SeppHochreiter,JürgenSchmidhuber;LongShort-TermMemory.NeuralComput1997;9(8):1735–1780.doi:https://doi.org/10.1162/neco.1997.9.8.1735第2节PreviousWork(已有研究),这是论文对以往方法的一个评述,总结了已有递归神经网络在面对时间序列学习、尤其是长时依赖

- Python打卡:Day46

剑桥折刀s

python打卡python

importtorchimporttorch.nnasnnimporttorch.optimasoptimimporttorchvisionfromtorchvisionimportdatasets,transformsfromtorch.utils.dataimportDataLoaderfromtorch.utils.tensorboardimportSummaryWriterimportnu

- 深度学习-Tensor

Tensor张量:与numpy中的ndarray不同之处:tensor可以在GPU或其他专用硬件上运行,以加速计算。一、Tensor初始化1.直接从数据中创建data=[[1,2],[3,4]]x_data=torch.tensor(data)2.从numpy数组创建np_array=np.array(data)x_np=torch.from_numpy(np_array)3.从另一个Tensor

- 为什么在 macOS 中运行 Python 项目必须使用虚拟环境?

coding随想

Pythonmacospython开发语言

为什么在macOS中运行Python项目必须使用虚拟环境?在macOS上开发Python项目时,虚拟环境(VirtualEnvironment)是一个不可或缺的工具。无论你是初学者还是资深开发者,理解虚拟环境的意义和使用方法,都是提升开发效率和项目稳定性的关键。本文将从macOS的特殊性出发,深入浅出地解释为什么在macOS中运行Python项目必须使用虚拟环境。一、macOS系统Python的局

- 从0开始学习计算机视觉--Day08--卷积神经网络

之前我们提到,神经网络是通过全连接层对输入做降维处理,将输入的向量通过矩阵和激活函数进行降维,在神经元上输出激活值。而卷积神经网络中,用卷积层代替了全连接层。不同的是,这里的输入不再需要降维,而是可以保留输入的空间结构,例如输入的是32×32×3的图片,在全连接层中是3072×1的向量,而卷积层里则保持不变。这里的改变的地方是对于同样的WX的函数形式,这里是把5×5×3的权重矩阵(也叫卷积核)向量

- 扣子智能体5:使用Python异步执行工作流并获取执行结果

呆萌的代Ma

大模型python扣子

使用python异步执行工作流的步骤有3步:异步执行工作流,获取工作流的execute_id,之后就能根据这个id查询工作流的执行情况如果execute_id=“Success”,就表示工作流执行完毕执行完毕后,打印output,就是大模型最后的全部示例代码fromloguruimportloggerimportrequestsimportjsondefrun_coze_ai(coze_api_t

- MCP客户端请求MCP服务器资源的Python SDK实现

AI天才研究院

计算AI人工智能与大数据Python实战python开发语言ai服务器

我将为您提供一个详细的指南,说明如何使用PythonSDK让MCP客户端请求MCP服务器的资源。MCP客户端请求MCP服务器资源的PythonSDK实现核心概念ModelContextProtocol(MCP)是一个标准化协议,允许应用程序以标准化的方式为大语言模型(LLM)提供上下文,将提供上下文的关注点与实际的LLM交互分离。MCP中的资源(Resources)是一种核心原语,允许服务器暴露数

- 基于存算一体架构的实时深度学习推理优化

瑕疵

热点资讯架构深度学习人工智能

博客主页:瑕疵的CSDN主页Gitee主页:瑕疵的gitee主页⏩文章专栏:《热点资讯》基于存算一体架构的实时深度学习推理优化基于存算一体架构的实时深度学习推理优化基于存算一体架构的实时深度学习推理优化引言存算一体架构的核心优势1.能效比突破2.实时性保障架构设计与实现技术1.存储单元创新2.硬件加速器设计3.电路级优化深度学习推理优化策略1.模型压缩技术2.硬件-软件协同优化3.运行时调度典型应

- python中提示‘pyinstaller‘ 不是内部或外部命令,也不是可运行的程序 或批处理文件。

一、出现这个问题的原因:来自于首先安装这个pyinstaller的时候,没有将D:\01_SoftWare\python3.9.13\Scripts或者D:\01_SoftWare\python3.9.13或者是D:\01_SoftWare\python3.9.13\Lib添加到环境变量中,那需要做的第一步就是添加下系统的环境变量。这样就可以了。到这里,可能一部分人,再次安装就好了,但是这边尝试看

- 第十篇:Python 进阶-内存管理

程序员勇哥

Python全套教程pythonjvm开发语言

第十篇:Python进阶-内存管理1.垃圾回收机制引用计数原理引用计数是Python垃圾回收机制中最基本的一种方式。其核心思想是:每个对象都维护一个引用计数,记录当前指向该对象的引用(变量)的数量。当对象的引用计数变为0时,意味着没有任何变量指向该对象,Python解释器会立即回收该对象所占用的内存空间。例如,考虑以下代码:a=[1,2,3]#创建一个列表对象,并将其引用赋值给变量a,此时列表对象

- Python 三方库 python-dotenv

wohu007

#标准库和三方库pythonpython-dotenv

1.简介在一些项目中,处于安全性的要求,一般不将密码,key等放入到配置文件中。然而这些代码又是上传在git等平台上。为了方便管理。一般采用系统变量的方式来实现。从而实现配置和代码分开。2.安装pipinstallpython-dotenv3.使用目录结构及代码.├──.env└──demo.py.env内容REDIS_HOST="127.0.0.1"PWD="/home/wohu"你可以使用单词

- Python自动化测试基础知识

心 一

Python自动化测试python开发语言

Python自动化测试基础知识一、自动化测试基础概念1.什么是自动化测试使用脚本和工具代替人工执行测试用例的过程通过编写代码来模拟用户操作,验证系统功能核心目标是提高测试效率,减少重复劳动2.自动化测试的优势高效率:可快速执行大量测试用例可重复:相同测试可反复执行,结果一致准确性:避免人为错误覆盖率:可执行难以手动测试的复杂场景持续集成:易于与CI/CD流程集成3.自动化测试的适用场景回归测试性能

- python进阶之数据结构与算法--入门-二叉树

小白piao

数据结构与算法python篇数据结构算法二叉树python

二叉树概念:之前已经提及了关于树的概念,要想知道之前讲了什么请关注,前边文章里都有提及。这里不做赘述。二叉树是具有以下属性的有序树:1、每个节点最多有两个孩子节点2、每个孩子节点被命名为左子节点和右子节点3、对于每个节点的孩子节点,在顺序上,左子节点优先于右子节点4、若子树的根为内部节点v的左子节点或者右子节点,则该子树相应地被称为节点v的左子树或者右子树5、若每个节点都有零个或者两个节点,则这样

- Python进阶 - 关键字 Global 和 Return

孤寒者

Python全栈系列教程pythonglobalreturn

目录:每篇前言:一、`return`的角色与机制二、`global`关键字与命名空间三、函数多值返回的高级模式四、`global`vs`nonlocal`vs返回值五、最佳实践与反模式总结每篇前言:作者介绍:【孤寒者】—CSDN全栈领域优质创作者、HDZ核心组成员、华为云享专家Python全栈领域博主、CSDN原力计划作者本文已收录于Python全栈系列教程专栏:《Python全栈系列教程》热门专

- 人工智能LLM | 基础配置 | 通过环境变量配置API-KEY 一文通教程

H-大叔

人工智能大模型实战与教程人工智能

在实战开发大语言模型的过程中,经常会遇到各种API-KEY的配置问题,例如GPTOpenAIKEY的配置,而且目前大部分都要求将其配置在环境变量中,下面将会讲解如何在Linux、macOS、Windows中配置,本文一文通教程。您可以使用配置环境变量的方法,避免在调用各种SDK时显式地配置API-KEY,从而降低泄漏风险。环境变量是操作系统中用于存储有关系统环境的信息的变量。您可以通过环境变量来配

- Python Set() 完全指南:从入门到精通

2501_91537435

pythonpython开发语言

PythonSet()完全指南:从入门到精通Set(集合)是Python中一种非常有用的内置数据类型,它提供了高效的成员检测和消除重复元素的功能。本文将带你全面了解Python中的set(),从基础概念到高级用法。一、什么是Set?Set是Python中的一种无序、可变、不重复元素的集合数据类型。它类似于数学中的集合概念,支持并集、交集、差集等操作。#创建一个setfruits={'apple',

- 一文读懂Python+Pytest+Allure+Jenkins+Gitee自动化测试框架,手把手教你搭建

Python+Pytest+Allure+Jenkins+Gitee自动化测试框架一、框架整体架构1.技术栈分工Python:测试脚本开发语言Pytest:测试用例管理和执行引擎Allure:测试报告生成与展示Jenkins:持续集成和任务调度Gitee:代码版本管理和触发机制2.数据流向Gitee代码提交→Jenkins触发构建→Pytest执行用例→生成Allure结果→Jenkins收集报告

- 【vue】用conda配置nodejs,一键开通模版使用权

温择之

conda

特此鸣谢我的好同学@重中之重的特级教学,非常之好用一、conda环境下载安装二、创建包含nodejs的conda环境创建一个新环境:condacreate-n【自定义环境名字】python=3.9condacreate-nmy_nodejs_envpython=3.9激活新环境:condaactivate【环境名字】condaactivatemy_nodejs_env下载安装nodejs:cond

- 大模型API密钥的环境变量配置(大模型API KEY管理)(将密钥存储在环境变量)(python-dotenv)(密钥管理)环境变量设置环境变量

Dontla

大模型LLMpython开发语言

文章目录大模型API密钥的环境变量配置:安全与最佳实践引言安全风险代码泄露风险版本控制暴露环境变量的优势安全隔离跨环境一致性环境变量配置方法Linux/macOS配置Windows配置开发框架集成Node.js使用dotenvPython使用python-dotenv最佳实践.env文件管理环境变量模板容器环境配置安全增强措施密钥轮换机制秘密管理服务集成总结大模型API密钥的环境变量配置:安全与最

- 【人工智能】ChatGPT、DeepSeek-R1、DeepSeek-V3 辨析

G皮T

#大语言模型人工智能LLM大语言模型chatgptdeepseekDeepSeek-R1DeepSeek-V3

ChatGPT、DeepSeek-R1、DeepSeek-V3辨析1.ChatGPT对比DeepSeek1.1技术相似点1.2主要差异1.3关键区别1.4如何选择1.5总结2.DeepSeek-R1对比DeepSeek-V32.1DeepSeek-R12.2DeepSeek-V32.3核心区别总结2.4如何选择3.R1和V3有什么含义3.1DeepSeekR1的"R"3.2DeepSeekV3的"

- 「论文导读」LLM高效推理与模型量化

雷羿 LexChien

prompt人工智能LLM论文阅读

1.论文背景作者:HugoTouvron等人,來自MetaAI来源:arXiv:2302.13971,2023年2月主题:介绍LLaMA系列模型(LLaMA-7B、13B、33B、65B),专为研究用途设计,强调高效能与低资源需求的语言模型推理。论文探讨如何通过优化训练数据、模型架构和推理技术,在有限硬体资源(如单一GPU或CPU)上实现高效推理。学术背景:随着大型语言模型(LLM)如GPT-3的

- 在学校研究学习的偏算法,秋招投递开发岗位还有希望吗

程序员

前言Thelasttime,Ihavelearned这是星球同学,在周五晚上答疑聊天的时候对我的提问:如果简历上的项目偏算法,但是自学了一些操作系统和计网的知识,秋招的时候投递偏开发的岗位有希望吗?简历上是否也要加上相关项目?估计也是很多朋友的疑问,毕竟很多同学读研,有些老师疯狂push,要成果,发论文。要想尽快发论文,那只能“研究”人工智能、算法的一些东西了。但是众所周知,算法要求很高,不仅要求

- 操作系统领域的新宠儿:鸿蒙应用深度剖析

操作系统内核探秘

操作系统内核揭秘harmonyos华为ai

操作系统领域的新宠儿:鸿蒙应用深度剖析关键词:鸿蒙操作系统、微内核架构、分布式软总线、ArkUI框架、DevEcoStudio、跨设备开发、全场景生态摘要:本文深度剖析华为鸿蒙操作系统的核心技术架构与应用开发体系,从微内核设计、分布式协同技术、UI框架创新到全场景开发工具链展开分析。通过数学模型解析分布式一致性算法,结合Python代码演示核心调度逻辑,并以实战案例演示跨设备应用开发流程。探讨鸿蒙

- NumPy-随机数生成详解

GG不是gg

numpynumpy

NumPy-随机数生成详解一、随机数生成的基础:伪随机数与种子1.伪随机数的本质2.种子的设置:确保结果可复现二、常用随机数生成函数1.均匀分布随机数2.正态分布随机数3.整数随机数4.其他常用分布三、随机数生成的进阶操作1.随机排列与洗牌2.控制随机数的维度与形状四、随机数生成的应用场景1.数据增强2.蒙特卡洛模拟3.随机初始化参数五、注意事项NumPy作为Python数值计算的核心库,提供了功

- python namedtuple转为dict

链池

python开发语言

python相关学习资料:搭建私人助理大模型需要什么环境?006_指法标准_键盘正位_你好世界_hello_world_单引号_双引号一张图生成指定动作的动态视频,MagicAnimate本地部署Pythonnamedtuple转为dict的方法作为一名经验丰富的开发者,我很高兴能够帮助刚入行的小白们解决编程问题。今天,我们将一起学习如何将Python中的namedtuple转换为dict。这个过

- 2025 年机器学习工作流程的 7 个 AI 代理框架

盖瑞理

AIAgent人工智能

介绍机器学习从业者花费大量时间在重复性任务上:监控模型性能、重新训练流程、检查数据质量以及跟踪实验。虽然这些操作任务至关重要,但它们通常会占用团队60%到80%的时间,几乎没有留下任何创新和模型改进的空间。传统的自动化工具可以处理简单的、基于规则的工作流程,但它们难以应对机器学习操作所需的动态决策。何时应该根据性能漂移重新训练模型?当数据分布发生变化时,如何自动调整超参数?这些场景需要能够推理复杂

- Python namedtuple 详解:作用与使用方法

文章目录一、什么是namedtuple主要特点:二、namedtuple的作用1.替代普通元组,提高代码可读性2.替代简单类,减少样板代码3.作为轻量级数据结构三、基本使用方法1.创建namedtuple类型2.创建实例3.访问字段4.不可变性测试四、高级特性与方法1._asdict()-转换为有序字典2._replace()-创建新实例并替换字段3._fields-查看字段名4._make()-

- java数字签名三种方式

知了ing

javajdk

以下3钟数字签名都是基于jdk7的

1,RSA

String password="test";

// 1.初始化密钥

KeyPairGenerator keyPairGenerator = KeyPairGenerator.getInstance("RSA");

keyPairGenerator.initialize(51

- Hibernate学习笔记

caoyong

Hibernate

1>、Hibernate是数据访问层框架,是一个ORM(Object Relation Mapping)框架,作者为:Gavin King

2>、搭建Hibernate的开发环境

a>、添加jar包:

aa>、hibernatte开发包中/lib/required/所

- 设计模式之装饰器模式Decorator(结构型)

漂泊一剑客

Decorator

1. 概述

若你从事过面向对象开发,实现给一个类或对象增加行为,使用继承机制,这是所有面向对象语言的一个基本特性。如果已经存在的一个类缺少某些方法,或者须要给方法添加更多的功能(魅力),你也许会仅仅继承这个类来产生一个新类—这建立在额外的代码上。

- 读取磁盘文件txt,并输入String

一炮送你回车库

String

public static void main(String[] args) throws IOException {

String fileContent = readFileContent("d:/aaa.txt");

System.out.println(fileContent);

- js三级联动下拉框

3213213333332132

三级联动

//三级联动

省/直辖市<select id="province"></select>

市/省直辖<select id="city"></select>

县/区 <select id="area"></select>

- erlang之parse_transform编译选项的应用

616050468

parse_transform游戏服务器属性同步abstract_code

最近使用erlang重构了游戏服务器的所有代码,之前看过C++/lua写的服务器引擎代码,引擎实现了玩家属性自动同步给前端和增量更新玩家数据到数据库的功能,这也是现在很多游戏服务器的优化方向,在引擎层面去解决数据同步和数据持久化,数据发生变化了业务层不需要关心怎么去同步给前端。由于游戏过程中玩家每个业务中玩家数据更改的量其实是很少

- JAVA JSON的解析

darkranger

java

// {

// “Total”:“条数”,

// Code: 1,

//

// “PaymentItems”:[

// {

// “PaymentItemID”:”支款单ID”,

// “PaymentCode”:”支款单编号”,

// “PaymentTime”:”支款日期”,

// ”ContractNo”:”合同号”,

//

- POJ-1273-Drainage Ditches

aijuans

ACM_POJ

POJ-1273-Drainage Ditches

http://poj.org/problem?id=1273

基本的最大流,按LRJ的白书写的

#include<iostream>

#include<cstring>

#include<queue>

using namespace std;

#define INF 0x7fffffff

int ma

- 工作流Activiti5表的命名及含义

atongyeye

工作流Activiti

activiti5 - http://activiti.org/designer/update在线插件安装

activiti5一共23张表

Activiti的表都以ACT_开头。 第二部分是表示表的用途的两个字母标识。 用途也和服务的API对应。

ACT_RE_*: 'RE'表示repository。 这个前缀的表包含了流程定义和流程静态资源 (图片,规则,等等)。

A

- android的广播机制和广播的简单使用

百合不是茶

android广播机制广播的注册

Android广播机制简介 在Android中,有一些操作完成以后,会发送广播,比如说发出一条短信,或打出一个电话,如果某个程序接收了这个广播,就会做相应的处理。这个广播跟我们传统意义中的电台广播有些相似之处。之所以叫做广播,就是因为它只负责“说”而不管你“听不听”,也就是不管你接收方如何处理。另外,广播可以被不只一个应用程序所接收,当然也可能不被任何应

- Spring事务传播行为详解

bijian1013

javaspring事务传播行为

在service类前加上@Transactional,声明这个service所有方法需要事务管理。每一个业务方法开始时都会打开一个事务。

Spring默认情况下会对运行期例外(RunTimeException)进行事务回滚。这

- eidtplus operate

征客丶

eidtplus

开启列模式: Alt+C 鼠标选择 OR Alt+鼠标左键拖动

列模式替换或复制内容(多行):

右键-->格式-->填充所选内容-->选择相应操作

OR

Ctrl+Shift+V(复制多行数据,必须行数一致)

-------------------------------------------------------

- 【Kafka一】Kafka入门

bit1129

kafka

这篇文章来自Spark集成Kafka(http://bit1129.iteye.com/blog/2174765),这里把它单独取出来,作为Kafka的入门吧

下载Kafka

http://mirror.bit.edu.cn/apache/kafka/0.8.1.1/kafka_2.10-0.8.1.1.tgz

2.10表示Scala的版本,而0.8.1.1表示Kafka

- Spring 事务实现机制

BlueSkator

spring代理事务

Spring是以代理的方式实现对事务的管理。我们在Action中所使用的Service对象,其实是代理对象的实例,并不是我们所写的Service对象实例。既然是两个不同的对象,那为什么我们在Action中可以象使用Service对象一样的使用代理对象呢?为了说明问题,假设有个Service类叫AService,它的Spring事务代理类为AProxyService,AService实现了一个接口

- bootstrap源码学习与示例:bootstrap-dropdown(转帖)

BreakingBad

bootstrapdropdown

bootstrap-dropdown组件是个烂东西,我读后的整体感觉。

一个下拉开菜单的设计:

<ul class="nav pull-right">

<li id="fat-menu" class="dropdown">

- 读《研磨设计模式》-代码笔记-中介者模式-Mediator

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

/*

* 中介者模式(Mediator):用一个中介对象来封装一系列的对象交互。

* 中介者使各对象不需要显式地相互引用,从而使其耦合松散,而且可以独立地改变它们之间的交互。

*

* 在我看来,Mediator模式是把多个对象(

- 常用代码记录

chenjunt3

UIExcelJ#

1、单据设置某行或某字段不能修改

//i是行号,"cash"是字段名称

getBillCardPanelWrapper().getBillCardPanel().getBillModel().setCellEditable(i, "cash", false);

//取得单据表体所有项用以上语句做循环就能设置整行了

getBillC

- 搜索引擎与工作流引擎

comsci

算法工作搜索引擎网络应用

最近在公司做和搜索有关的工作,(只是简单的应用开源工具集成到自己的产品中)工作流系统的进一步设计暂时放在一边了,偶然看到谷歌的研究员吴军写的数学之美系列中的搜索引擎与图论这篇文章中的介绍,我发现这样一个关系(仅仅是猜想)

-----搜索引擎和流程引擎的基础--都是图论,至少像在我在JWFD中引擎算法中用到的是自定义的广度优先

- oracle Health Monitor

daizj

oracleHealth Monitor

About Health Monitor

Beginning with Release 11g, Oracle Database includes a framework called Health Monitor for running diagnostic checks on the database.

About Health Monitor Checks

Health M

- JSON字符串转换为对象

dieslrae

javajson

作为前言,首先是要吐槽一下公司的脑残编译部署方式,web和core分开部署本来没什么问题,但是这丫居然不把json的包作为基础包而作为web的包,导致了core端不能使用,而且我们的core是可以当web来用的(不要在意这些细节),所以在core中处理json串就是个问题.没办法,跟编译那帮人也扯不清楚,只有自己写json的解析了.

- C语言学习八结构体,综合应用,学生管理系统

dcj3sjt126com

C语言

实现功能的代码:

# include <stdio.h>

# include <malloc.h>

struct Student

{

int age;

float score;

char name[100];

};

int main(void)

{

int len;

struct Student * pArr;

int i,

- vagrant学习笔记

dcj3sjt126com

vagrant

想了解多主机是如何定义和使用的, 所以又学习了一遍vagrant

1. vagrant virtualbox 下载安装

https://www.vagrantup.com/downloads.html

https://www.virtualbox.org/wiki/Downloads

查看安装在命令行输入vagrant

2.

- 14.性能优化-优化-软件配置优化

frank1234

软件配置性能优化

1.Tomcat线程池

修改tomcat的server.xml文件:

<Connector port="8080" protocol="HTTP/1.1" connectionTimeout="20000" redirectPort="8443" maxThreads="1200" m

- 一个不错的shell 脚本教程 入门级

HarborChung

linuxshell

一个不错的shell 脚本教程 入门级

建立一个脚本 Linux中有好多中不同的shell,但是通常我们使用bash (bourne again shell) 进行shell编程,因为bash是免费的并且很容易使用。所以在本文中笔者所提供的脚本都是使用bash(但是在大多数情况下,这些脚本同样可以在 bash的大姐,bourne shell中运行)。 如同其他语言一样

- Spring4新特性——核心容器的其他改进

jinnianshilongnian

spring动态代理spring4依赖注入

Spring4新特性——泛型限定式依赖注入

Spring4新特性——核心容器的其他改进

Spring4新特性——Web开发的增强

Spring4新特性——集成Bean Validation 1.1(JSR-349)到SpringMVC

Spring4新特性——Groovy Bean定义DSL

Spring4新特性——更好的Java泛型操作API

Spring4新

- Linux设置tomcat开机启动

liuxingguome

tomcatlinux开机自启动

执行命令sudo gedit /etc/init.d/tomcat6

然后把以下英文部分复制过去。(注意第一句#!/bin/sh如果不写,就不是一个shell文件。然后将对应的jdk和tomcat换成你自己的目录就行了。

#!/bin/bash

#

# /etc/rc.d/init.d/tomcat

# init script for tomcat precesses

- 第13章 Ajax进阶(下)

onestopweb

Ajax

index.html

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns="http://www.w3.org/

- Troubleshooting Crystal Reports off BW

blueoxygen

BO

http://wiki.sdn.sap.com/wiki/display/BOBJ/Troubleshooting+Crystal+Reports+off+BW#TroubleshootingCrystalReportsoffBW-TracingBOE

Quite useful, especially this part:

SAP BW connectivity

For t

- Java开发熟手该当心的11个错误

tomcat_oracle

javajvm多线程单元测试

#1、不在属性文件或XML文件中外化配置属性。比如,没有把批处理使用的线程数设置成可在属性文件中配置。你的批处理程序无论在DEV环境中,还是UAT(用户验收

测试)环境中,都可以顺畅无阻地运行,但是一旦部署在PROD 上,把它作为多线程程序处理更大的数据集时,就会抛出IOException,原因可能是JDBC驱动版本不同,也可能是#2中讨论的问题。如果线程数目 可以在属性文件中配置,那么使它成为

- 正则表达式大全

yang852220741

html编程正则表达式

今天向大家分享正则表达式大全,它可以大提高你的工作效率

正则表达式也可以被当作是一门语言,当你学习一门新的编程语言的时候,他们是一个小的子语言。初看时觉得它没有任何的意义,但是很多时候,你不得不阅读一些教程,或文章来理解这些简单的描述模式。

一、校验数字的表达式

数字:^[0-9]*$

n位的数字:^\d{n}$

至少n位的数字:^\d{n,}$

m-n位的数字:^\d{m,n}$

![]()