机器学习系列——回归算法(线性回归、岭回归)

一、回归的定义

回归是针对连续变量而言的,比如房屋价格、天气温度等,这些问题有很多影响因素,比如影响房屋价格的因素有位置、是否学区等,通过对这些因素进行回归分析可以得到一个系数,从而预测接下来的房价走势。

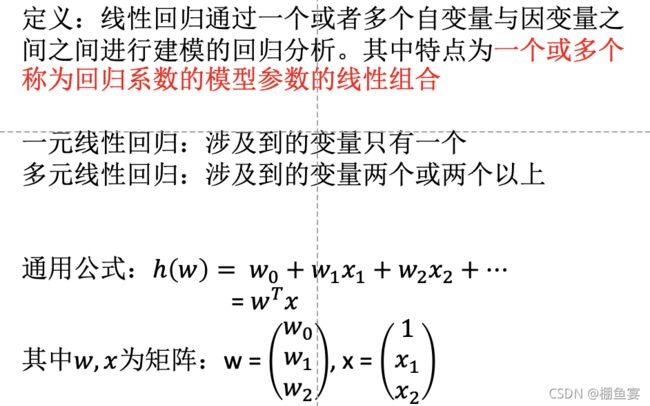

二、线性模型

我们进行线性回归分析,其本质是要求出w这个矩阵,即变量的系数。再利用现实中的数据代入方程式中即可得到预测结果。但在预测的过程中肯定不会能完全准确,所以势必会有一些信息的损失。在一元变量中,其结果如下:

上图中的直线为预测值,点为真实值,可以看出拟合过程是有一定差距的。在多元中为:

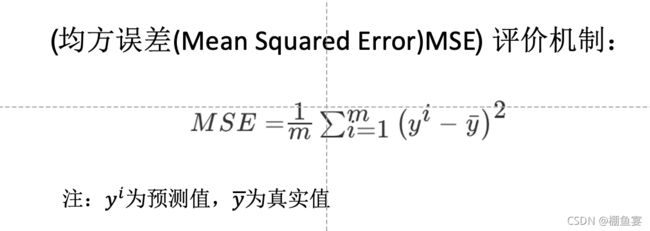

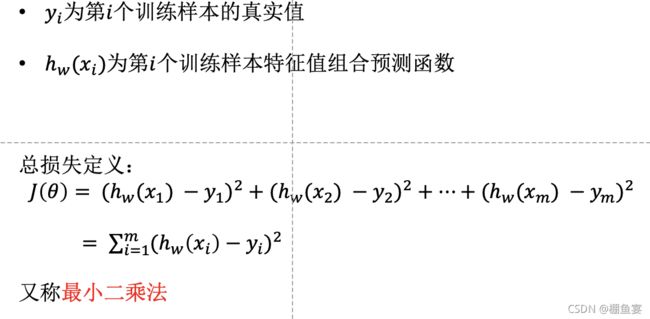

定义一个损失函数:将真实值与预测值做差再进行平方,可得到一个二次方程组,我们的目的是要找到一个w,使该方程组的值最小。

单变量的损失函数可直观的如下图所示:

直接求解w最小值,一步到位。

在训练数据量过大时,一步到位可能难度过大,且效果不好。此时我们需要另外一种最小化损失函数的方法——梯度下降法

先任意确定一个点,沿着函数的方向往下找,不断更新w的值,直至w最小。

正规方程和梯度下降的API分别为:

sklearn.linear_model.LinearRegression:正规方程

sklearn.linear_model.SGDRegressor:梯度下降

(一)线性回归:波士顿房价

# 导入相关模块

# 导入数据集

from sklearn.datasets import load_boston

# 导入线性回归相关API

from sklearn.linear_model import LinearRegression, SGDRegressor, Ridge, LogisticRegression

# 导入分割数据集API

from sklearn.model_selection import train_test_split

# 导入特征值处理API

from sklearn.preprocessing import StandardScaler

# 导入评估模型API

from sklearn.metrics import mean_squared_error, classification_report

# 实例化数据集

lb = load_boston()

# print(lb.DESCR)

# print("特征值为:", lb.data)

# print("目标值为:", lb.target)

# 将数据集划分为训练集和测试集

x_train, x_test, y_train, y_test = train_test_split(lb.data, lb.target)

# 特征值处理,标准化特征值和目标值【如果不对目标值进行标准化处理,w的值就会失真】;标准化两个处理的api进行处理

std_x = StandardScaler()

x_train = std_x.fit_transform(x_train)

x_test = std_x.transform(x_test)

std_y = StandardScaler()

y_train = std_y.fit_transform(y_train.reshape(-1,1))

y_test = std_y.transform(y_test.reshape(-1,1))

# 用估计器进行预测

# 1。正规方程求解法

lr = LinearRegression()

lr.fit(x_train, y_train)

print("正规方程求解系数为:", lr.coef_)

# 在预测时要使用inverse_transform将原先标准化了的值再返回回去,得到未经初始化的值

y_predict = std_y.inverse_transform(lr.predict(x_test))

print("正规方程求解预测房价为:", y_predict)

print("正规方程求解均方误差为:", mean_squared_error(std_y.inverse_transform(y_test), y_predict))

# 2。梯度下降法预测

sgd=SGDRegressor()

sgd.fit(x_train,y_train)

print("梯度下降求解系数为:", sgd.coef_)

sgd_predict=std_y.inverse_transform(sgd.predict(x_test))

print("梯度下降求解预测房价为:", sgd_predict)

print("梯度下降求解均方误差为:",mean_squared_error(std_y.inverse_transform(y_test), sgd_predict))

模型评价:

梯度下降和正规方程之间的比较

概念比较:过拟合与欠拟合

| 过拟合 | 欠拟合 |

|---|---|

| 在训练数据上能够获得很好的拟合, 在训练数据外的数据集上却不能很好地拟合数据。(模型过于复杂) | 在训练数据上不能获得更好的拟合, 在训练数据外的数据集上也不能很好地拟合数据。(模型过于简单) |

| 解决办法:进行特征选择,降低特征数量;交叉验证即让所有数据都得到学习; | 增加数据的特征数量 |

欠拟合在图像左侧,模型复杂度较低,模型在训练集和测试集的表误差均较大。过拟合在图像右边,训练误差较小而测试误差较大,模型过于复杂而导致的过拟合现象。

(二)岭回归:波士顿房价

岭回归是带有正则化的线性回归,正则化处理后,数据会变的很小,更加方便处理。岭回归得到的回归系数更符合实际,更可靠。另外,能让估计参数的波动范围变小,变的更稳定。在存在病态数据偏多的研究中有较大的实用价值。

# 导入相关模块

# 导入数据集

from sklearn.datasets import load_boston

# 导入线性回归相关API

from sklearn.linear_model import LinearRegression, SGDRegressor, Ridge, LogisticRegression

# 导入分割数据集API

from sklearn.model_selection import train_test_split

# 导入特征值处理API

from sklearn.preprocessing import StandardScaler

# 导入评估模型API

from sklearn.metrics import mean_squared_error, classification_report

# 实例化数据集

lb = load_boston()

# print(lb.DESCR)

# print("特征值为:", lb.data)

# print("目标值为:", lb.target)

# 将数据集划分为训练集和测试集

x_train, x_test, y_train, y_test = train_test_split(lb.data, lb.target)

# 特征值处理,标准化特征值和目标值【如果不对目标值进行标准化处理,w的值就会失真】

std_x = StandardScaler()

x_train = std_x.fit_transform(x_train)

x_test = std_x.transform(x_test)

std_y = StandardScaler()

y_train = std_y.fit_transform(y_train.reshape(-1, 1))

y_test = std_y.transform(y_test.reshape(-1, 1))

# 用估计器进行预测

# 1。正规方程求解法

lr = LinearRegression()

lr.fit(x_train, y_train)

print("正规方程求解系数为:", lr.coef_)

y_predict = std_y.inverse_transform(lr.predict(x_test))

print("正规方程求解预测房价为:", y_predict)

print("正规方程求解均方误差为:", mean_squared_error(std_y.inverse_transform(y_test), y_predict))

# 2。梯度下降法预测

sgd = SGDRegressor()

sgd.fit(x_train, y_train)

print("梯度下降求解系数为:", sgd.coef_)

sgd_predict = std_y.inverse_transform(sgd.predict(x_test))

print("梯度下降求解预测房价为:", sgd_predict)

print("梯度下降求解均方误差为:", mean_squared_error(std_y.inverse_transform(y_test), sgd_predict))

# 3。岭回归预测

rd = Ridge(alpha=1.0)

rd.fit(x_train, y_train)

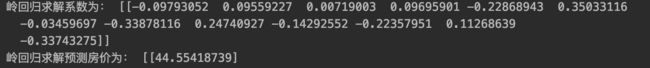

print("岭回归求解系数为:", rd.coef_)

rd_pred = std_y.inverse_transform(rd.predict(x_test))

print("岭回归求解预测房价为:",rd_pred)

print("岭回归的均方误差为:",mean_squared_error(std_y.inverse_transform(y_test), rd_pred))