【基于Tansformer的融合方法:感知损失:传递-感知损失】

HyperTransformer: A Textural and Spectral Feature Fusion Transformer for Pansharpening

(超级Transformer:一种用于全色锐化的纹理和光谱特征融合Transformer)

先看这一篇简单了解Transformer

(这是一篇高光谱图像融合论文)

全色锐化的目的是将配准后的高分辨率全色图像(PAN)与低分辨率高光谱图像(LR-HSI)进行融合,生成具有高光谱和空间分辨率的增强高光谱图像。现有的全色锐化方法忽略了使用注意机制将HR(高分辨率)纹理特征从PAN特征转换为LR-HSI特征,从而导致空间和光谱失真。本文提出了一种新的全色锐化注意机制HyperTransformer,该机制将LR-HSI和PAN的特征分别表示为变换器中的查询和键。HyperTransformer由三个主要模块组成,即两个独立的PAN和HSI特征提取器、一个multi-head feature soft-attention模块和一个空间-光谱特征融合模块。这样的网络通过学习PAN和LR-HSI的跨特征空间依赖性和长距离细节来改进全色锐化HSI的空间和光谱质量度量。此外,HyperTransformer可以在主干上跨多个空间尺度使用,以获得改进的性能。在三个广泛使用的数据集上进行的大量实验表明,HyperTransformer在空间和光谱质量度量上都比现有的方法有了显著的改进。

介绍

高光谱(Hyperspectral (HS))全色锐化旨在通过从更高空间分辨率全色(PAN)图像转移纹理(空间)细节,同时保留低分辨率高光谱图像(LR-HSI)的光谱特征,在空间上增强低分辨率高光谱图像(LR-HSI)。高光谱全色锐化技术的最新进展极大地提高了高光谱图像的光谱和纹理细节数量,这对于许多遥感应用高光谱图像的预处理是至关重要的(HS)全色锐化旨在空间增强低分辨率高光谱图像(LR-HSI)通过将纹理更高空间分辨率全色(PAN)图像的(空间)细节,同时保留LR-HSI的光谱特征。高分辨率全色锐化技术的发展极大地提高了高分辨率图像的光谱和纹理细节信息量,这对于许多遥感应用来说都是一个至关重要的预处理过程,可以准确快速地识别那些在其他方法下难以从低分辨率高分辨率图像中看到的潜在现象。HS全色锐化在广泛的遥感任务中是有益的,例如unmixing、变化检测、对象识别、场景解释和分类。HS全色锐化的早期研究采用了分量替换(CS)、多分辨率分析(MRA)、贝叶斯和变分方法将PAN图像的空间细节转换为LR-HSI。然而,这些传统的全色锐化方法通常会导致空间和频谱失真,这是由于先验知识建模不当、传感器特性不可访问、先验假设与问题之间不匹配(例如线性频谱混合假设和稀疏性假设),以及依赖于手工制作的特征,例如字典代表能力有限。

最近,由于深度卷积神经网络(ConvNets)学习适当图像特征的出色能力,它们也被引入用于HS全色锐化。然而,现有的SOTA方法通常采用直接的方式将纹理和光谱细节从PAN图像转移到LR-HSI。例如,Lee等人、Zheng等人和Bandara等人采用图1-(a)所示的网络作为主干,从上采样LR-HSI和PAN到全色锐化HSI的级联中学习映射函数。然而,我们认为PAN图像沿着数百个LR光谱波段的级联使得纹理和光谱特征的融合变得困难,并且效率低下。此外,由于纹理-光谱细节的不适当混合,它可能导致全色锐化HSI中的高光谱和空间失真。与图像域连接相比,研究人员还研究了PAN和LR-HSI的特征域连接,如图1-(b)所示。在这种方法中,利用两个单独的ConvNet从PAN中提取HR纹理模式,并从LR-HSI中提取光谱特性。然而,纹理和光谱细节的混合过程仍然只是添加,而没有对特征进行任何适当的指导/关注。我们认为上述方法无法有效地利用LR-HSI和PAN之间的跨特征空间依赖性,以及PAN在纹理-光谱混合过程中的长程细节。相反,它们完全依赖于随后的卷积运算来通过网络传播相关的纹理谱特征。尽管具有足够深度的卷积运算能够在一定程度上适当地融合纹理-光谱特征,但它并不是基于特征图的全局(长程)光谱-空间细节来调整每个像素值,而是通过使用卷积核来一起调整小空间区域的值,这在HS全色锐化中是不准确和不合适的。

受图像超分辨率工作的启发,我们提出了一种称为HyperTransformer的新型纹理-频谱特征融合变换器,用于HS全色锐化,解决了传统全色锐化方法的上述问题,如图1-(c)所示。与传统的全色锐化方法相比,HyperTransformer利用注意机制提取PAN和LR-HSI特征之间的跨特征空间依赖性,并在融合前为LR-HSI找到纹理上更高级和光谱上更相似的特征,这大大有助于获得同时具有高光谱和空间质量的全色锐化HSI。形式上,我们的HyperTransformer由四个相互连接的模块组成,即PAN和LR-HSI的两个特征提取模块(称为FE-PAN和FE-HSI)、注意机制和纹理-光谱特征融合模块(TSFF)。我们的HyperTransformer 首先通过 分别采用FE-PAN和FE-HSI将PAN和LR-HSI变换到它们各自的特征空间。然后,我们利用 LR-HSI、PAN↓↑和PAN特征作为注意机制中的查询(Q)、键(K)和值(V),来计算LR-HSI特征的纹理高级和光谱相似的特征表示。然后,将所计算的纹理高级特征图与来自构成全色锐化HSI的主干网络的LR-HSI特征混合。此外,为了获得视觉上吸引人的全色锐化HSI,除了广泛采用的L1损失之外,我们还向HS全色锐化引入了两个新的损失项,即感知损失和传递-感知损失。

(图1:我们的HyperTransformer与现有全色锐化架构的不同之处。传统的全色锐化方法简单地在(a)图像域或(B)特征域中连接PAN(p)和LR-HSI(y),以学习从LR-HSI到全色锐化的HSI(x)的映射函数。相比之下,(c)我们的HyperTransformer利用LR-HSI、PAN↓↑和PAN的特征表示作为注意机制中的查询(Q)、键(K)和值(V),以将最相关的HR纹理特征从主干网络转移到LR-HSI的频谱特征。HyperTransformer的输出是y的特征表示的增强版本。↑和↓分别表示双三次上采样和下采样。)

贡献

1)我们提出了一种新的Transformers网络,称为HyperTransformers的HS全色锐化,实现了显着改善的SOTA方法。据我们所知,我们是最早将基于Transformers融合网络架构引入HS全色锐化的研究之一。

2)提出了一种新的多尺度特征融合策略,通过在骨干网络的不同尺度上使用HyperTransformers,使网络能够有效地捕获PAN和LR-HSI的多尺度长距离细节和跨特征空间依赖性。

3)我们还引入了两个新的损耗函数用于HS全色锐化,即合成感知损耗和传输感知损耗,这使得我们的HyperTransformer能够学习更强大的PAN和LR-HSI特征表示。

相关工作

Classical approaches

经典的全色锐化方法可以分为四类:成分替代(CS)、多分辨率分析(MRA)、混合和贝叶斯方法。基于CS的方法首先将LR-HSI分解为频谱和空间分量。随后,用PAN图像替换空间分量,并通过采用逆变换将其变换回原始空间。广泛使用的算法如gram - schmidt (GS), GS-adaptive (GSA),和主成分分析(PCA)都是CS的例子。

基于MRA的全色锐化方法通过使用空间滤波器将空间特征注入LR-HSI。基于平滑滤波器的强度调制(SFIM)、MTF-GLP(MG)、带高通调制的MTF-GLP(MGH)是MRA的示例。考虑到CS和MRA的局限性,已经提出了混合方法,例如引导滤波PCA(GFPCA)。贝叶斯方法在贝叶斯推理框架中用公式表示融合问题。这些方法的例子包括贝叶斯融合(BF)、稀疏BF(BSF)和耦合非负矩阵分解(CNMF)。

ConvNet-based approaches

近年来,基于ConvNet的全色锐化方法因其对输入数据的高层次特征学习能力强而在全色锐化方面取得了显著的进展。在这些方法中,Masi等人首先提出了一种三层ConvNet架构,该架构将上采样LR-HSI与PAN叠加作为输入。受ResNet 在图像超分辨率任务中的广泛适应性的启发,提出了深度残差全色锐化网络(DRPNN),以学习参考HSI和上采样HSI之间的残差图像。受HSI数据的3-D特征的启发,Palsson等人提出了一种3d-ConvNet,当LR-HSI被附加噪声破坏时,该方法显示出了有希望的结果。后来,Dian等人提出了一种称为DHSIS的深度全色锐化方法,该方法将ConvNet学习到的先验信息集成到LR-HSI和PAN特征的融合中。为了提高HS全色锐化网络的光谱预测能力,有研究人员设计了两个光谱预测ConvNet模型,称为HyperPNN1和HyperPNN2。最近,注意力机制(即:光谱和空间关注)已经被引入到HS全色锐化中以捕获PAN和LR-HSI中存在的长距离细节。在DHP-DARN中,利用光谱和空间关注残差块来映射参考HR-HSI和上采样HSI之间的残差图像,并且与其他SOTA方法相比,实现了更好的融合性能。然而,上述这些基于注意力的方法中没有一种通过利用LR-HSI、PAN↓↑和PAN的特征表示作为查询、键和值来探索全色锐化的纹理-光谱特征融合过程的注意力–我们将在本研究中探索这一点。

方法

HyperTransformer的整体结构如图2所示,其中p、p ↓↑和y ↑分别表示PAN图像、顺序4×下采样和4×上采样PAN图像以及4×上采样LR-HSI。我们使用双三次插值进行上采样/下采样,因为实验证明其HSI的空间和光谱失真较小。连续的下采样和上采样操作使得p ↓↑ 与y ↑域一致:这对于注意机制的平稳和可靠操作是必不可少的。HyperTransformer p, p↓↑, y↑,和LR-HSI特性(F)产生的骨干作为输入,输出体现先进的F和可怕地相似特性表示(表示为˜F),这将进一步用于生成全色锐化HSI的骨干网络。提出的transforme有四个主要模块:用于PAN和HSI的两个单独的特征提取器(FE-PAN和FE-HSI)、特征注意模块和纹理-光谱特征融合模块。接下来,我们将详细讨论每个模块。

Feature Extractors for PAN and LR-HSI

我们设计了两个独立的特征提取器(FE),分别从PAN和LR-HSI中获得HR纹理和光谱特征。我们为FE采用类似VGG的网络架构(参见图3)。类似VGG的设计鼓励学习LR-HSI和PAN图像中精确的相互光谱和纹理信息。FE的输出定义了Query(Q)、Key(K)和Value(V)特征,它们是HyperTransformer内部注意机制的三个基本元素。形式上,Q、K和V可由下式获得:

HR Texture Transfer through Multi-Head Feature Soft-Attention (MHFSA)

特征关注旨在识别LR-HSI特征的光谱相似和纹理优越特征的表示,其将进一步用于由主干网络产生全色锐化的HSI。由于实验发现全色锐化HSI具有更好的空间和光谱特性,因此我们采用了多头特征软注意(MHFSA)机制来代替单头特征注意。为了便于MHFSA,我们首先通过利用N个全连通层,为Q、K和V中的每个特征导出一组N个全局描述符。接下来,我们并行地计算每个描述符的特征软关注度。最后,将特征软关注的输出特征描述子进行级联,并采用线性层将其转换回原始特征空间。 MHFSA机制极大地帮助网络提取PAN和LR-HSI之间的跨特征空间依赖关系以及PAN的长距离细节。

Obtaining a set of N global feature descriptors.

首先将查询Q ∈ R f q × w × h R^{fq×w×h} Rfq×w×h,关键字K ∈ R f k × w × h R^{fk×w×h} Rfk×w×h,V∈ R f v × w × h R^{fv×w×h} Rfv×w×h整形为二维张量q ∈ R f q × w h R^{fq×wh} Rfq×wh,k ∈ R f k × w h R^{fk×wh} Rfk×wh,v ∈ R f v × w h R^{fv×wh} Rfv×wh。请注意,为简单起见,我们从符号中删除了批维度。fq、fk和fv表示Q、K和V中的特征图的数目,w和h分别表示特征图的宽度和高度。接下来,我们利用一组N个线性(全连接)层来将q、k和v中的每个特征图变换成一组N个全局描述符(头部),以促进多头部特征软注意。每个特征映射q,k,v的N个全局描述子表示三维张量q ∈ R f q , N , β w h R^{fq,N,βwh} Rfq,N,βwh,k ∈ R f q , N , β w h R^{fq,N,β wh} Rfq,N,βwh,v ∈ R f q , N , β w h R^{fq,N,βwh} Rfq,N,βwh,其中β表示降维比。形式上,我们可以将上述过程定义为:

其中 f i f^i filinear-q(·)、 f i f^i filinear-k(·)和 f i f^i filinear-v(·)是与查询、键和值相关联的第i个线性层的参数表示,q(j,:)、k(j,:)和v(j,:)是q、k和v的第j个特征映射的1-D表示,并且q(j,i,:)、k(j,i,:)和v(j,i,:)分别是q、k和v的第j个特征映射的第i个全局描述符。

Feature Cross-Correlation Embedding (FCCE).

我们分别计算所有N个描述符的query(q)和key(k)之间的特征互相关矩阵,并将其表示为一个三维矩阵C ∈ R N × f q × f k R^{N×fq×fk} RN×fq×fk。为了使用矩阵乘法并行地高效计算所有N个描述符的特征互相关(即,没有任何“for”循环),我们首先置换q、k和v的前二维(dim0和1)。得到的置换矩阵记为q′ ∈ R N × f q × β w h R^{N×fq×βwh} RN×fq×βwh,k′ ∈ R N × f k × β w h R^{N×fk×βwh} RN×fk×βwh,v′ ∈ R N × f v × β w h R^{N×fv×βwh} RN×fv×βwh。然后,我们一次计算N个描述符的特征互相关,如下所示:

![]()

其中T表示矩阵转置运算,MatMul表示dim-1和2上的批量矩阵乘法,mean(·)表示平均值。第j个描述符的互相关矩阵的行(即,C(j,:,:))告诉我们给定的查询描述符(即,LR-HSI功能与所有密钥描述符相关。换句话说,它提取了LR-HSI特征和PAN特征之间的跨特征空间依赖性(注意,查询和值分别是LR-HSI和PAN↓↑的特征表示)。然后,我们沿着C中的每个相关矩阵的行利用Softmax层来获得行归一化的互相关矩阵。从形式上讲,我们可以将此过程定义如下:

Multi-Head Feature Soft-Attention (MHFSA).

然后,我们使用矩阵乘法一次计算N个描述符上的特征软关注,如下:

![]()

其中t ∈ R N , f q , β h w R^{N,fq,βhw} RN,fq,βhw是MHFSA的输出。接下来,我们将t的维数置换为其原始格式( R N , f q , β h w R^{N,fq,βhw} RN,fq,βhw → R f q , N , β h w R^{fq,N,βhw} Rfq,N,βhw),并应用线性层,然后进行整形,以从HyperTransformer获得纹理高级特征表示T ∈ R f q , × h × w R^{fq,× h × w} Rfq,×h×w,如下所示:

Textural-Spectral Feature Fusion (TSFF)

如图2所示,我们通过MHFSA获得的LR-HSI特征Q的纹理高级和频谱相似特征表示T进一步与来自主干网络的频谱特征F级联。接下来,我们使用3 × 3卷积,然后使用批归一化(BN)层将纹理-光谱细节融合在一起,并生成主干网络所需的残差分量,该分量将进一步用于生成全色锐化HSI。形式上,TSFF内部的过程可以定义如下:

![]()

其中~F是HyperTransformer的输出,其将进一步被骨干网络用于生成全色锐化HSI,并且Cat表示级联操作。

Multi-Scale Feature Fusion (MSFF)

传统的全色锐化方法仅在HR尺度上融合PAN的纹理特征,而我们在多个空间尺度上将HyperTransformer的纹理细节注入主干网络,如图3所示。特别地,我们在三个空间尺度上注入HR纹理细节:1)LR-HSI空间尺度(用×1 ↑表示),2)两倍上采样LR-HSI空间尺度(用×2 ↑表示),3)所需HR空间尺度(用×4 ↑表示)。因此,我们表示的输入和输出HyperTransformer X × s ↑ X^{×s↑} X×s↑一般X可以被K, V, F或˜F和s所代表的空间尺度:1、2或4(见图3)表示。在多个空间尺度上注入HR纹理知识有助于网络捕获PAN和LR-HSI的多尺度长程细节和多尺度跨特征空间依赖性,从而获得更好的全色锐化HSI的空间和光谱质量。

Loss Function

Reconstruction loss.

我们使用L1损耗作为重构损耗:

其中,xref是目标HR-HSI,x是预测HR-HSI,(C,H,W)是HR-HSI的大小。我们利用L1损失,已经证明,对于HS全色锐化,L1损失比L2损失表现更好。

VGG perceptual loss.

最初VGG感知损失已经演示了用于RGB超分辨率任务来提高图像的视觉质量。感知损失的基本思想是增强预测图像和目标图像之间的特征空间中的相似性。在RGB图像上训练VGG网络,得到预测图像和目标图像的特征映射。为了评估HSI图像的VGG损失,我们首先通过定义R、G和B波段的高斯近似光谱响应曲线来合成给定HSI的RGB图像。接下来,我们将感知损失评估为:

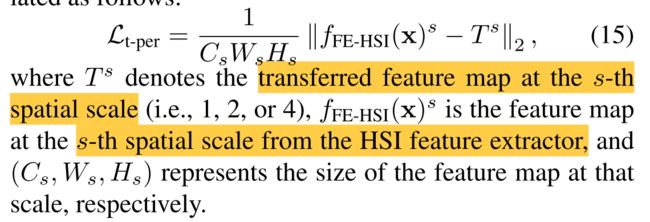

Transfer perceptual loss.

传输感知损失约束预测的HSI图像x具有与从HyperTransformer传输的纹理特征T相似的纹理特征,这使得我们的HR纹理传输过程更有效。传输感知损耗计算如下:

用于训练网络的总损失函数定义如下: