[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering

1. 题目

知识感知问答的可扩展性多跳关系推理模型

Feng Y, Chen X, Lin B Y, et al. Scalable multi-hop relational reasoning for knowledge-aware question answering[J]. 2020.emnlp-main.99

链接:https://arxiv.org/pdf/2005.00646.pdf

GitHub项目地址:https://github.com/INK-USC/MHGRN

2. 作者

Yanlin Feng♣∗ Xinyue Chen♠∗ Bill Yuchen Lin♥

Peifeng Wang♥

Jun Yan♥ Xiang Ren♥

[email protected], [email protected],

{yuchen.lin, peifengw, yanjun, xiangren}@usc.edu

♥University of Southern California 南加利福尼亚大学

Peking University ♠ 北京大学

Carnegie Mellon University 内基梅隆大学

3. 摘要

MHGRN:multi-hop graph relation networks

解决问题:把外部知识图谱的知识加入到问答中;

提出方法模型:知识感知方法,multi-hop graph relation networks(MHGRN);基于路径的推理方法与图神经网络相结合,具有更好的可解释性和可扩展性;

效果:SOTA 76.5% 在CommonsenseQA数据集;

4. 背景陈述

知识感知QA例子:

把知识图谱加入到QA中,为问答的解释与可信预测提供了可能。 例如:CHILD → AtLocation → CLASSROOM → Synonym → SCHOOLROOM

一种最直接使用KG的方法:直接对KG的关系路径进行建模。例如KagNet,MHPGM等。优点:可解释;缺点:难扩展(可能的路径随节点呈多项式与指数增长)。即时间复杂度还是比较高的。所以为了克服这个问题,有些模型只使用一跳路径来完成模型。

解决可扩展性问题,GNN是一个很好的方法,一般采用它的变种来解决。

==MHGRN:Multi-hop Graph Relation Network, 把基于路径模型与GCN相结合;==继承了基于路径的好的解释性与GCN的好的扩展性。

主要动机是在单层内执行多跳消息传递,以允许每个节点直接参与它的多跳邻居,实现多跳关系推理。

5. 问题形式化及模型概况

论文把任务范围限定在选择题问答上。

给定外部知识图(KG)作为知识源和问题q,目标是从一组给定的选择中找出正确的答案。

模型转化为测量问题q和每个答案选择a∈C之间的合理性得分模型。

由上面图可以看到,这里使用到了图与文本的编码器。

6. 多关系图编码方法

多关系图编码的两大类:

分类1:使用GNNs的图编码;

通过直接在图结构上传播信息来编码图结构;

| 名称 | 论文 | 方法 |

|---|---|---|

| message passing | ICML 2017 - Neural message passing for quantum chemistry | |

| GCNs | ICLR 2017–Semisupervised classifification with graph convolutional | |

| RGCNs | ESWC 2018-Modeling relational data with graph convolutional networks |

带有上标的hi的编码公式(一个典型的GCN通过passing messages来完成学习表示):

h_j表示第j个节点的属性信息;

W_r为学习权重;

N_r_i表示在关系r下的第i个邻居;

然后一个图可以经过池化编码为:

分类2:基于路径模型的图编码;

首先把图分解成路径,然后池化来实现编码。

Relation Networks (RNs) 的图表示(把节点与边向量并成一个长的向量输入到全连接来编码):

KagNet的图表示(输入为路径序列,LSTM模型来编码):

7. Multi-Hop Graph Relation Network (MHGRN)

整个MHGRN框架结构:

7.1 Type-Specifific Transformation

类型经过线性转换。这里对类型编码。

7.2 Multi-Hop Message Passing

赋予GNNs直接建模路径的能力;

K跳关系有效路径定义为:

对于这些路径进行信息传播时, RGCNs的单跳信息传播的一般化形式:

W_t_r是表示t跳r关系的学习训练的参数;

a表示关注力网络计算出来的;

d表示a的标准化因子。

通过关注力机制对不同长度的路径进行聚合作为信息的输入,如下的聚合:

7.3 非线性激活

经过激活函数之后,完成节点的嵌入:

7.4 关注力权重的计算

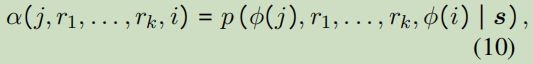

权重的计算采用概率图模型来建模,时间复杂度比较O(m^k)好:

例如可以采用条件随机场来计算:

f(▪),δ (▪),g(▪)被两层MLP参数化;

τ(▪)是mxm的转移矩阵;

β(▪)建模了k跳关系的权重;

γ(▪)建模了从节点类型φ(j)到φ(i)信息权重;

时间复杂度分析:

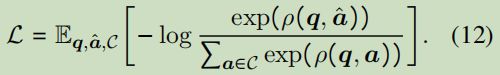

7.5 学习,推理,路径解码

首先通过关注力池化答案实体输出的节点嵌入,获取图表达;

在学习训练时,损失函数为通过最小化交叉熵来达到最大化正确答案的合理分数值的目标:

8. 实验

8.1 从外部KG抽取出目标的子图g

外部知识图谱:ConceptNet (2017- Conceptnet 5.5: An open multilingual graph of general knowledge)

主要是参考了KagNet中的方法。

预处理----合并了关系类型来提高图的密度;增加反向关系去增加多跳;

抽取步骤:从句子s中识别实体的mentions; 然后把这些实体在ConceptNet进行实体链接;把找到的实体保存在一个集合中。这里不做修剪,而是保留所有边去构建g.

8.2 数据集

CommonsenseQA, OpenBookQA

8.3 对比的方法

RGCN (Schlichtkrull et al., 2018);

GconAttn (Wang et al., 2019);

KagNet† (Lin et al., 2019);

另外,也对预处理的语言模型作微调。

8.4 实验结果

8.4.1 对于CommonsenseQA数据集实验

这是内部实验分割来处理的。【in-house split】

【offificial split】的结果:

8.4.2 对于OpenbookQA数据集实验

【offificial split】,文件编码采用ROBERTA-LARGE,

8.5 性能分析

8.5.1 Ablation Study on Model Components

这里做了一个消融研究,看看取消掉一些模块后性能有没有影响。

这里可以看出Type-specific transformation与Structured relational attention两部分还是比较关键的。

8.5.2 训练数据对训练结果的影响

GRN模型具有稳定性,可以认为与数据无关性。

8.5.3 跳数K的影响

当K>3时,性能反而有所下降。

8.5.4 模型的扩展性

与K相关的线性时间。

8.5.5 模型解释性

还是有好的解释性。

9. 相关工作

9.1 NLP的知识感知方法

抽取结构知识的方法

| 方法 | 论文 | 描述 |

|---|---|---|

| nodes | 2017-Leveraging knowledge bases in LSTMs for improving machine reading;2019-Improving natural language inference using external knowledge in the science questions domain | |

| triples | 2017-Dynamic integration of background knowledge in neural nlu systems;2018-Knowledge able reader: Enhancing cloze-style reading compre hension with external commonsense knowledge | |

| paths | 2018-Commonsense for generative multi-hop question answering tasks;2019-Exploiting explicit paths for multi-hop reading comprehension;2019-KagNet: Knowledge-aware graph networks for commonsense reasoning | |

| subgraphs | 2015-Answering elementary science questions by constructing coherent scenes using background knowledge. |

预训练语言模型

方法1:在大规模普通域数据集或富知识文件上进行微调语言模型;

方法2:通过信息检索技术为语言模型提供证据;

缺点是这些方法不能提供好的推理过程及证据,故很难让人信服。

9.2 神经图编码

| 方法 | 论文 | 描述 |

|---|---|---|

| GAT | 2018-Graph attention networks | 带有关注力机制; |

| RGCN | 2018 - Modeling relational data with graph convolutional networks | 提出相关信息传播; |

| K-hop neighbors | 2019-Mixhop: Higher-order graph convolutional architectures via sparsifified neighborhood mixing;2019-k-hop graph neural networks |

10. 总结

提出了MHCRN,结合了GNN与基于路径推理的优点。

整体感觉,研究的内容很多,理论性也特征别的强。感觉还需要进一点的消化。

参考:

【1】EMNLP2020 | 基于知识库的多跳关系推理,

https://mp.weixin.qq.com/s/uYi57h14y8z5onnAY9cc_g

happyprince,https://blog.csdn.net/ld326/article/details/114049909

w.r.t. : with respect to 的缩写。是 关于;谈及,谈到的意思。

i.e. :也就是,亦即(源自拉丁文id est),换而言之

cf. 参考

s.t. 服从,满足 ,受约束于

e.g. 例如

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第1张图片](http://img.e-com-net.com/image/info8/1879df37c43e434ab70265ec01f86c77.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第2张图片](http://img.e-com-net.com/image/info8/dd2e92713225413fb198708ec9e5bada.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第3张图片](http://img.e-com-net.com/image/info8/d5db2c3e1eb84beaa67db6df81ddebfa.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第4张图片](http://img.e-com-net.com/image/info8/2ce719e66b6046dab7a1fbc802ccfbbb.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第5张图片](http://img.e-com-net.com/image/info8/745c6ab055304a7083a4c1140040055c.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第6张图片](http://img.e-com-net.com/image/info8/9388329ae5284e1db13e09fb73557cf7.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第7张图片](http://img.e-com-net.com/image/info8/992201259ed64e2b8221130e3644a0df.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第8张图片](http://img.e-com-net.com/image/info8/95d4511a28924c3caa349423aaa4589d.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第9张图片](http://img.e-com-net.com/image/info8/df9d5e525ef04184976f063b6e681877.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第10张图片](http://img.e-com-net.com/image/info8/ee0ddebcee8f4599a708bfeb75b88171.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第11张图片](http://img.e-com-net.com/image/info8/d5cb505dab07440b817b1313dba42532.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第12张图片](http://img.e-com-net.com/image/info8/4530e3635a44499896710dd3f835431a.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第13张图片](http://img.e-com-net.com/image/info8/12a0819bc22d43f8b894a066dbddef80.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第14张图片](http://img.e-com-net.com/image/info8/3c75197269e84cdfa0ea79314c360eb2.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第15张图片](http://img.e-com-net.com/image/info8/b965c0f994ee4b2699ce1ed07f6587b4.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第16张图片](http://img.e-com-net.com/image/info8/4ed2bb4f70bc4e6d9d2eede69c394e0b.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第17张图片](http://img.e-com-net.com/image/info8/1e66f20613d04773ace35ccf489f6355.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第18张图片](http://img.e-com-net.com/image/info8/a1d991c1637f489f92a8f3502c075c3c.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第19张图片](http://img.e-com-net.com/image/info8/d404b549d91b4b7e9328301d9d62ad05.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第20张图片](http://img.e-com-net.com/image/info8/8034eb5950014c27bef89f1c540b5aea.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第21张图片](http://img.e-com-net.com/image/info8/0b3dbccd9b2f4bd3b8f78d22d1467f00.jpg)

![[论文阅读笔记19]Scalable multi-hop relational reasoning for knowledge-aware question answering_第22张图片](http://img.e-com-net.com/image/info8/a2b01b458aa643b6b7868c33b1715343.jpg)