LSTM学习总结

发展历程:

RNN:无法很好地学习到距离较远的信息。

LSTM:添加了忘记门。输入门。输出门。

GRU:将LSTM的门结构进行了重新设计,归结为两个门结构,一个重置门,另一个更新门。

Muti-Layers-LSTM:在层次上进行改善网络结构。

Bi-LSTM:在方向上改进。

STGAT论文 要点:

贡献:1、采用额外的LSTM显示建模交互作用的时间相关性;

2、通过使用GAT汇总LSTM的隐藏状态来模拟行人之间的空间相互作用。

评估误差:1、平均位移误差(ADE):预测轨迹所有位置的均方误差(MSE),以及地面真相轨迹。

2、最终位移误差(FDE):在Tpred处预测的最终目标与真实最终目标之间的距离。

总结:提出了新颖的Seq2Seq框架,该框架可以共同预测场景中所有行人的未来轨迹。对每个轨迹使用一个LSTM来捕获每个行人的历史轨迹信息,并采用图注意力网络对每个人群在每个时间步的交互进行建模;此外采用另一个LSTM来显示地建模交互之间的时间相关性。实验也证明了:图注意力网络看可以根据邻居的运动状态为邻居赋予合理的重要性,并且我们的模型可以预测不同场景下的准确轨迹。

SGCN论文要点:

贡献:1、提出了Sparse Directed Interaction和Motion Tendency来提高轨迹预测的准确性。

2、设计了adaptive method。

3、利用实验数据清晰描述了sparse graph convolution network(稀疏图卷积网络)的优势。

相关工作:

1、Pedestrain Trajectory Prediction:之前的模型要么只考虑固定范围内的邻近行人,要么考虑的行人不充分,这会导致剩余联系。Sparse Directed Interaction会缓解这个问题,也有Motion Tendency的优势。

2、Graph Convolution Networks:基于一个学习的稀疏邻接矩阵聚合结点,意味着要聚合的结点时动态确定的。

3、Self-Attention Mechanism:在连续的一串模型任务中表现良好。

方法:

1、稀疏图学习:

2、稀疏定向时间图:

3、轨迹预测

总结:识别稀疏定向交互和运动趋势使得在一些复杂的场景下更好的预测轨迹。

Bi-directional LSTM Trajectory Prediction Method based on Attention Mechanism要点:

摘要:此篇研究包括两个部分,一部分是轮船轨迹特征的抽取,一部分是轨迹序列预测。

关键词:uto-encode;attention mechanism;bi-directional LSTM.

介绍:轮船轨迹更无序,也更困难,之前采用construct dynamic equations的方法需要非常专业的知识,适应性也差。现在的主流方法是采用机器学习,利用历史轨迹预测当下,适应性更好,包括BP neural network,LSTM model, Attention-LSTM model。一些学者曾利用artificial neural network(ANN),增加self-learning wright,提出建立在多层BP neural network,并使用Sigmod函数,最后为了更符合时间序列数据的特征,提出基于Attention Mechanism CNN并结合LSTM的神经网络预测模型。LSTM model based on the attention mechanism效果更好,它可以突出主要特征,也可以反映轨迹数据的同步特征,但是缺乏复杂维度的数据处理,轨迹数据的时空关系也较差。所以该篇论文提出基于attention mechanism和Bi- directional LSTM的全新的轨迹预测方法。这个方法即可以高效地提取轨迹数据的特征,也会紧密联系轨迹时空以达到更好的预测结果。

相关工作:

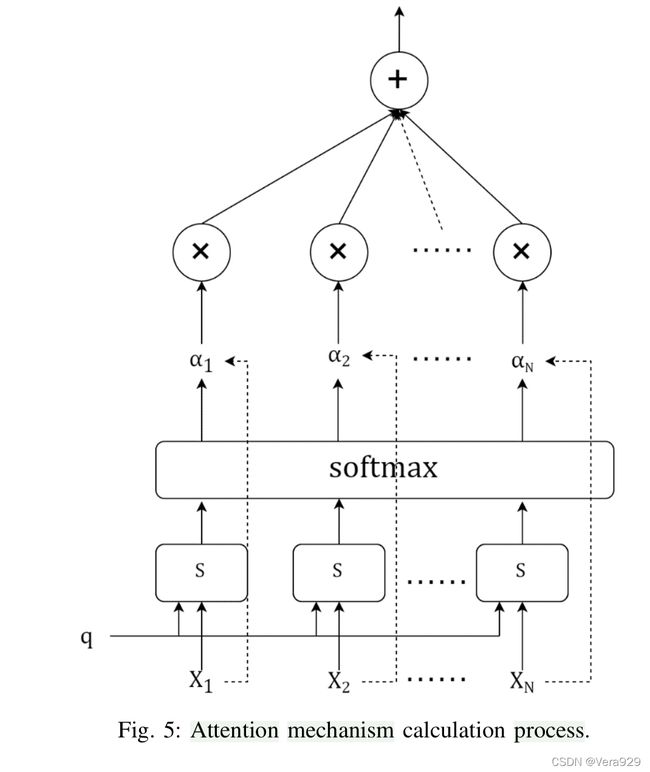

1、Attention Mechanism

注意力机制分为hard attention和soft attention。前者通过直接限制输入的处理方式,故无法充分适应时间序列预测领域。而soft attention mechanism使用权重以着重注意某些区域。在轨迹预测中采取attention mechanism可以加强一些数据决定性特征的影响力,提高预测的效率。

2、Bi-directional LSTM

前后两个方向的迭代LSTM层既能充分利用输入又能提高结果的准确性。

Ai、Bi代表前后不同时刻的隐藏状态,Wi是每层的权重

方法:

包括两部分,一是数据处理:轨迹特征挑选、线性修改、数据标准化和滑动窗口分割数据;一是轨迹预测模型,是基于Bi-directional LSTM的。

a.Data Preprocessing

1)Feature selection:longtitude,latitude,speed,heading,和time来表示轮船的航行状态。所以Pt={LATt,LONt,SOGt,HEADINGt,TIMEt},Traj={P1,P2......Pn}。

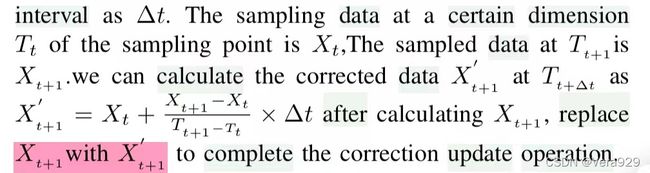

2)Linear correction:为了更充分地利用数据的时空特征,主要是用Xt+1‘代替Xt+1:

3)Data normalization:状态用四维表示,模型收敛速度不理想采用Min-MAX方法:

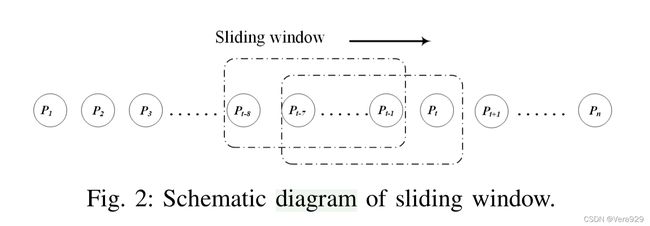

4)Sliding window to divide data:

b.AABiL Prediction Model

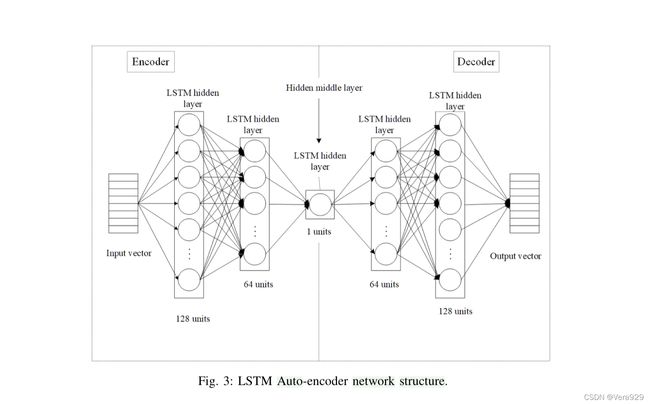

1)LSTM auto-encode:

2)Model construction:

综上所述,实验数据以6:2:2的比例划分成训练集、确认集、和测试集。模型在训练集上训练,在确认集上保存最好的model generalization performance,最终的测试结果在测试集。

结论:

实验表明auto-encoder,attention mechanism以及Bi-LSTM模型的综合使用可以极大地提高轨迹预测的准确性。