PESE Event Structure Extraction using Pointer Network based Encoder-Decoder Architecture论文解读

PESE: Event Structure Extraction using Pointer Network based Encoder-Decoder Architecture

code:alapanju/PESE: This is the code for our AACL-IJCNLP2022 paper “PESE: Event Structure Extraction using Pointer Network based Encoder-Decoder Architecture” (github.com)

paper:[2211.12157] PESE: Event Structure Extraction using Pointer Network based Encoder-Decoder Architecture (arxiv.org)

期刊/会议: AACL-IJCNLP2022

摘要

事件抽取(EE)的任务旨在从文本中找到事件和事件相关的论元信息,并以结构化格式表示它们。大多数以前的工作都试图通过分别识别多个子结构并将它们聚合以获得完整的事件结构来解决这个问题。目前大多数方法的问题在于它无法识别事件参与者之间的所有相互依赖关系(事件触发词、论元和角色)。在本文中,我们以唯一的元组格式表示每个事件记录,其中包含触发词短语、触发词类型、论元短语和相应的角色信息。我们提出的基于指针的编码器-解码器模型通过利用事件参与者之间的交互,在每个时间步骤中生成事件元组,并为EE任务提供真正的端到端解决方案。我们在ACE2005数据集上评估了我们的模型,实验结果证明了我们模型的有效性,与最先进的方法相比,我们实现了具有竞争力的性能。

1、简介

从文本文档中抽取事件是自然语言处理和理解的关键任务之一。事件抽取处理从自然语言文本中识别事件帧。这些事件帧具有复杂的结构,包含有关事件触发词、事件类型、事件特定论元和事件论元角色的信息。例如:

In Baghdad, a cameraman **died** when an American tank **fired** on the Palestine hotel.

在句子中died和fired分别是 Die 和 Attack 事件类型的事件触发词。这句话包含了实体短语:Baghdad、a cameraman、an American tank 和 Palestine hotel。其中一些实体在上述事件中扮演特定角色,称为事件论元。对于事件类型Die,(argument;role)对是:(Baghdad;Place),(a cameraman;vivtim),(an American tank ;instrument)。而对于Attack事件,(argument;role)对是:(Baghdad;Place)、(a cameraman;target)、(an American tank ;instrument)和(Palestine hotel;target)。显然,一个句子可能包含多个事件;实体可以由多个事件帧共享;此外,一个特定的论点可能在不同的事件框架中扮演不同的角色。因此,理想的事件抽取系统将识别所有触发词,分类正确的事件类型,提取所有特定于事件的论元,并正确预测事件论元角色。这些子任务中的每一项都同样重要且具有挑战性。

大多数现有工作将EE任务分解为这些预定义的子任务,然后聚合这些输出以获得完整的事件帧。其中一些模型遵循流水线方法,其中触发词和相应的论元在不同的阶段被识别。相反,其他人则依赖于同时预测触发词和相关论元的联合建模。然而,流水线方法必须处理错误传播问题,联合模型必须利用事件触发词、论元和相应角色之间的信息共享和相互依赖性。事件参与者之间的交互有以下几种类型:1)事件间交互:通常一句话中的事件类型是相互依存的。2)事件内论点交互:特定事件提及的论点之间存在某种关系。3)事件间论点交互:句子中出现的两个不同事件提及所共享的目标实体或论元通常具有一些相互依赖性。4)事件类型角色交互:每个事件框架根据其模式定义有一组不同的论元角色;因此,事件类型和论元角色有着密切的关系。5)论元交互:事件论元角色还取决于候选论元的实体类型,我们已经付出了大量努力来利用这些相互作用,但尽管取得了可喜的成果,但大多数现有系统都未能捕捉到所有这些相互依赖性。

为了利用上述事件参与者之间的相互作用,我们提出了一种基于神经网络的序列到结构学习模型,该模型可以从输入句子生成句子级事件帧。每个事件帧包含一个(trigger,argument)短语对以及相应的触发词类型(事件类型)和角色标签信息。受联合实体关系提取、方面情感三元组提取和语义角色标记所用模型的启发,我们设计了一个基于指针网络的事件结构提取(Pointer network-based Event Structure Extraction,PESE)框架,该框架利用事件间的相互依赖性从文本中提取事件帧。编码器编码输入句子,而解码器基于输入句子编码和在先前时间步骤中生成的事件帧来识别每个时间步骤中的事件帧。创新之处在于这种建模的有效性:1)我们的模型可以一起检测触发词、论元和角色标签,而不是将整个任务分解为单独的子任务,2)该模型还能够提取具有共同触发词或论元短语的多个事件元组,3)实验结果表明,该模型也可以识别句子中存在的重叠论元短语。总之,本文的贡献如下:

- 我们为事件帧提出了一种新的表示模式,其中每个帧都包含关于(事件、论元)短语对的信息。

- 我们提出了一个句子级的端到端事件抽取模型,该模型利用了事件-论元角色之间的相关性,并试图在一个句子中找到触发词、论元跨度和相应的标签。我们所提出的EE系统将句子作为输入,并生成该句子中出现的所有唯一事件帧作为输出。

- 我们将我们提出的方法应用于ACE2005数据集,实验结果表明,我们的方法优于几种最先进的基线模型。

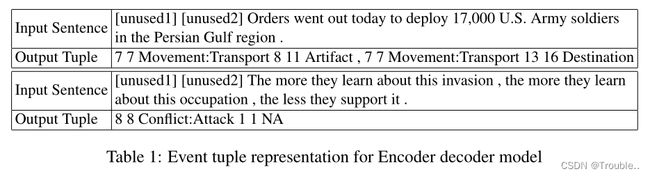

2、事件帧表示

给定一个句子,我们提出的端到端EE模型抽取该句子中出现的所有事件帧。这些事件帧是事件特定信息的结构化表示:(1)事件触发短语,(2)事件类型,(3)论元短语,(4)角色标签。在句子中,每个触发词和论元短语都是一个连续的单词序列;因此,表示这些短语的有效方法是通过它们对应的开始和结束位置。因此,在本文中,我们使用存储所有记录的6元组结构来表示每个事件帧,如前所述。6元组包含:1)触发词短语的开始索引,2)触发词短语结束索引,3)事件类型,4)论元短语开始索引,5)论元短语结束索引,6)触发词论元角色标签。触发短语(1-2)的开始索引和结束索引表示事件触发词跨度,而论元短语(4-5)的开始和结束索引代表事件论元跨度,其他两个记录(3和6)是两个标签:事件类型和角色类型。表1表示示例句子和这些句子中出现的相应事件帧及其6元组表示。然而,有些情况下,事件触发词出现在没有任何参数短语的句子中。为了概括事件元组表示,我们在每个句子前面连接两个额外的标记:[unused1]和[unused2],位置分别为1和2。如果句子中没有实际的论元短语,则将[unused2]标记用作伪论元,事件元组中论元短语的相应开始和结束索引由1表示,角色类型用“NA”表示(见表1)。标记[unused1]用于表示句子中没有任何有效的事件触发词。

2.1 问题描述

为了更加正式地定义EE任务,首先我们提前定义了事件类型集合 E ∈ { E 1 , E 2 , . . . , E p } E \in \{E_1,E_2,...,E_p\} E∈{E1,E2,...,Ep}和论元标签集合 R ∈ { R 1 , R 2 , . . . , R r } R \in \{R_1,R_2,...,R_r\} R∈{R1,R2,...,Rr}。其中 p , r p,r p,r代表的是事件类型和论元标签集合的数量。现在,给定一个句子 S = [ w 1 , w 2 , . . . , w n ] S=[w_1,w_2,...,w_n] S=[w1,w2,...,wn],其中 n n n代表句子的长度, w i w_i wi代表句子的第 i i i个token,我们的目标是抽取一系列的事件元组 E T = { e t i } i = 1 ∣ E T ∣ ET=\{et_i\}_{i=1}^{|ET|} ET={eti}i=1∣ET∣, e t i = [ s i t r , e i t r , E i , s i a r , e i a r , R i ] et_i=[s_i^{tr},e_i^{tr},E_i,s_i^{ar},e_i^{ar},R_i] eti=[sitr,eitr,Ei,siar,eiar,Ri], ∣ E T ∣ |ET| ∣ET∣代表的是句子 S S S事件帧的数量。在第 i i i个事件元组( e t i et_i eti)表示中, s i t r , e i t r s_i^{tr},e_i^{tr} sitr,eitr表示触发词短语的开始位置和结束位置, E i E_i Ei表示事件类型,是集合 E E E中的候选触发词。 s i a r , e i a r s_i^{ar},e_i^{ar} siar,eiar代表的是论元短语的开始和结束位置, R i R_i Ri是论元标签,是结合 R R R中的候选标签。

3、我们提出的EE框架

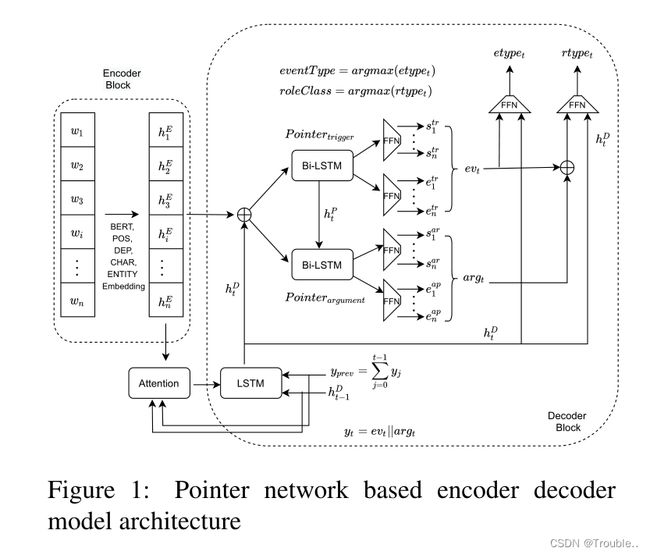

我们为端到端EE任务采用编码器-解码器架构。模型架构的如图1所示。模型的输入是一个句子(即一系列token),作为输出,我们得到了该句子中出现的事件元组列表。在我们的模型中,我们在编码器处使用预训练的BERT,在解码器处使用基于LSTM的网络。

3.1 句子编码

我们使用预训练的BERT模型作为句子编码器,以获得token的上下文表示。然而,词性标注(POS)标签信息是一个关键特征,因为大多数触发词短语是名词、动词或形容词。此外,依赖树特征(DEP)是句子级任务中的另一条信息线索。我们还使用实体类型信息(ENT)信息(BIO标签)作为特征。我们将POS、DEP、ENT和字符级特征与BERT嵌入相结合,以表示输入句子中的每个token。因此,除了预训练BERT嵌入外,我们还使用了四种其他嵌入:1)POS嵌入 E p o s ∈ R ∣ P O S ∣ × d p o s E_{pos} \in \R^{|POS| \times d_{pos}} Epos∈R∣POS∣×dpos,2)DEP嵌入 E d e p ∈ R D E P × d d e p E_{dep} \in \R^{DEP \times d_{dep}} Edep∈RDEP×ddep,3)实体类型嵌入 E e n t ∈ R ∣ E N T ∣ × d e n t E_{ent} \in \R^{|ENT|\times d_{ent}} Eent∈R∣ENT∣×dent,4)字符水平嵌入 E c h a r ∈ R ∣ V c ∣ × d c h a r E_{char} \in \R^{|V_c|\times d_{char}} Echar∈R∣Vc∣×dchar。因此, ∣ P O S ∣ 、 ∣ D E P ∣ 、 ∣ E N T ∣ 、 ∣ V c ∣ |POS|、|DEP|、|ENT|、|V_c| ∣POS∣、∣DEP∣、∣ENT∣、∣Vc∣分别表示唯一位置标签、依赖关系标签、实体标签和唯一字符字母表的计数。而 d p o s 、 d d e p 、 d e n t 、 d c h a r d_{pos}、d_{dep}、d_{ent}、d_{char} dpos、ddep、dent、dchar分别表示pos、依赖关系、实体和角色特征的对应维度。类似于,我们应用具有最大池的卷积神经网络来获得句子S中每个token的维度 d c d_c dc的特征级特征向量。所有这些特征表示都被级联以获得句子 S S S内每个token w i w_i wi的聚合向量表示 h i E h_i^E hiE。更具体地, h i E ∈ R d h h_i^E \in \R^{d_h} hiE∈Rdh其中 d h = d B E R T + d p o s + d d e p + d e n t + d c d_h=d_{BERT}+d_{pos}+d_{dep}+d_{ent}+d_c dh=dBERT+dpos+ddep+dent+dc。

3.2 抽取事件帧

我们提出的解码器生成事件元组序列。解码器包括序列生成器LSTM、两个指针网络和两个分类网络。事件帧序列由序列生成器LSTM生成。事件的触发词和论元跨度由指针网络标识。分类网络确定事件的类型和触发词论元角色标签。下面将更详细地描述这些模块中的每一个。

序列生成网络:我们使用LSTM单元来生成事件帧的序列。在每个时间步骤 t t t中,该LSTM将注意力加权句子嵌入( e t e_t et)和所有先前生成的元组嵌入( e T u p p r e v eTup_{prev} eTupprev)的聚合作为输入,并生成中间隐藏表示 h t D ( ∈ R d n ) h_t^D(\in \R^{d_n}) htD(∈Rdn)。要获得句子嵌入 e t ∈ R d h e_t \in \R^{d_h} et∈Rdh,我们使用了注意力机制,其中我们使用了 h t − 1 D h_{t-1}^D ht−1D和 e T u p p r e v eTup_{prev} eTupprev作为查询。解码器LSTM的隐藏状态表示为:

h t D = L S T M ( e t ⊕ e T u p p r e v , h t − 1 D ) h_t^D=LSTM(e_t \oplus eTup_{prev},h_{t-1}^D) htD=LSTM(et⊕eTupprev,ht−1D)

在生成当前元组时,我们考虑先前生成的元组表示,目的是捕获事件参与者的相互依赖性,并避免生成重复的元组。通过使用注意力方法来生成句子嵌入向量 e t e_t et。当前时间步骤 e T u p p r e v = ∑ k = 0 t − 1 e T u p k eTup_{prev}=\sum_{k=0}^{t-1} eTup_k eTupprev=∑k=0t−1eTupk之前生成的所有事件元组的聚合表示,其中 e T u p 0 eTup_0 eTup0是零张量。在时间步骤 t t t生成的事件元组由 e T u p t = t r t ⊕ a r t eTup_{t}=tr_t \oplus ar_t eTupt=trt⊕art表示,其中 t r t tr_t trt和 a r t ar_t art分别是在时间步骤 t t t从指针网络(稍后描述)获取的触发短语和实体短语的矢量表示, ⊕ \oplus ⊕表示串联操作。在生成每个事件元组时,我们考虑这些先前生成的事件元组来捕获事件-事件之间的依赖关系。

用于触发词/论元范围检测的指针网络:指针网络用于识别源句子中的触发词和论元短语跨度。每个指针网络包含一个Bi-LSTM网络,然后是两个前馈神经网络。我们的架构包含两个这样的指针网络,以分别标识触发词和论元短语的开始和结束索引。在每个时间步骤 t t t中,我们首先将中间向量 h t D h_t^D htD(从先前的LSTM层获得)与隐藏向量 h i E h_i^E hiE(从编码器获得)连接起来,并将它们馈送到具有第一指针网络的隐藏维度 d p d_p dp的Bi-LSTM层。Bi-LSTM网络生成隐藏向量 h i p t ∈ R 2 d p h_i^{pt} \in \R^{2d_p} hipt∈R2dp表示输入句子中的每个token。这些隐藏表示同时传递到具有softmax的两个前馈网络,以获得句子中每个etoken的0和1之间的两个归一化标量值( s ^ i t r \hat s_i^{tr} s^itr和 e ^ i t r \hat e_i^{tr} e^itr)。这两个值表示对应token成为当前事件元组的触发词短语的开始和结束索引的概率。

s i t r = W s 1 ∗ h i p t + b s 1 , s ^ t r = s o f t m a x ( s t r ) s_i^{tr}=W_s^1 * h_i^{pt}+b_s^1,\hat s^{tr}=softmax(s^{tr}) sitr=Ws1∗hipt+bs1,s^tr=softmax(str)

e i t r = W e 1 ∗ h i p t + b e 1 , e ^ t r = s o f t m a x ( e t r ) e_i^{tr}=W_e^1*h_i^{pt}+b_e^1,\hat e^{tr}=softmax(e^{tr}) eitr=We1∗hipt+be1,e^tr=softmax(etr)

其中 W s 1 ∈ R 2 d p × 1 , W e 1 ∈ R 2 d p × 1 , b s 1 , b e 1 W_s^1 \in \R^{2d_p \times 1},W_e^1 \in \R^{2d_p \times 1},b_s^1,b_e^1 Ws1∈R2dp×1,We1∈R2dp×1,bs1,be1代表第一个指针网络的权重和偏置参数。

抽取元组的自变量短语的第二个指针网络还包含具有两个前馈网络的类似Bi-LSTM。在每个时间步,我们将来自前一个Bi-LSTM网络的隐藏向量 h i p t h_i^{pt} hipt与 h t D h_t^{D} htD和 h i E h_i^E hiE连接起来,并将它们传递给第二个指针网络,第二个网络遵循与第一个指针网络相似的方程,以获得 s ^ i a r \hat s_i^{ar} s^iar和 e ^ i a r \hat e_i^{ar} e^iar。这两个标量表示第 i i i个源token的归一化概率分数,作为自变量短语的开始和结束索引。我们考虑将触发词指针网络的输出向量馈送到论元指针网络的输入,以利用触发词论元之间的依赖关系。然而,使用从两个指针网络收集的归一化概率 s ^ i t r \hat s_i^{tr} s^itr, e ^ i t r , \hat e_i^{tr}, e^itr, s ^ i a r \hat s_i^{ar} s^iar和 e ^ i a r \hat e_i^{ar} e^iar,分别为:

e v t = ∑ i = 1 n s ^ i t r ∗ h i p t ⊕ ∑ i = 1 n e ^ i t r ∗ h i p t ev_t=\sum_{i=1}^{n} \hat s_i^{tr}*h_i^{pt} \oplus\sum_{i=1}^{n}\hat e_i^{tr}*h_i^{pt} evt=i=1∑ns^itr∗hipt⊕i=1∑ne^itr∗hipt

a r g t = ∑ i = 1 n s ^ i a r ∗ h i p a ⊕ ∑ i = 1 n e ^ i a r ∗ h i p r arg_t=\sum_{i=1}^{n} \hat s_i^{ar}*h_i^{pa} \oplus\sum_{i=1}^{n}\hat e_i^{ar}*h_i^{pr} argt=i=1∑ns^iar∗hipa⊕i=1∑ne^iar∗hipr

前向分类层:我们需要两个前馈神经网络分类层来识别每个事件元组中的事件类型、论元类型和角色标签。首先,我们将触发短语 e v t ev_t evt的向量表示与 h t D h_t^D htD连接起来,并将聚合向量馈送到第一分类层,然后是softmax层,以找到检测到的触发短语的正确事件类型。

e T y p e t = s o f t m a x ( W t r ( w u t ⊕ h t D ) + b t r ) eType_t=softmax(W_{tr}(wu_t \oplus h_t^D)+b_{tr}) eTypet=softmax(Wtr(wut⊕htD)+btr)

e T y p e t ‾ = a r g m a x ( e T y p e t ^ ) \overline {eType_t}=argmax(\hat {eType_t}) eTypet=argmax(eTypet^)

最后, e v t , a r g t , h t D ev_t,arg_t,h_t^D evt,argt,htD的级联被馈送到第二个前馈网络,随后是softmax层,以预测正确的自变量角色标签,同时利用事件角色和论元角色相互依赖性。

r T y p e t = s o f t m a x ( W r ( e v t ⊕ a r g t ⊕ h t D ) + b r ) rType_t=softmax(W_r(ev_t\oplus arg_t \oplus h_t^D)+b_r) rTypet=softmax(Wr(evt⊕argt⊕htD)+br)

r T y p e t ‾ = a r g m a x ( r T y p e t ^ ) \overline {rType_t}=argmax(\hat {rType_t}) rTypet=argmax(rTypet^)

3.3 训练过程

为了训练我们的模型,我们最小化了负对数似然损失的总和,以识别相应触发词和论元跨度的四个位置索引以及两个分类任务:1)事件类型分类和2)角色分类。

L o s s = − 1 B × E T ∑ b = 1 B ∑ e t = 1 E T [ l o g ( s b , e t t r , e b , e t t r ) + l o g ( s b , e t a r , e a , e t t r ) + l o g ( e T y p e b , e t ) + l o g ( r T y p e b , e t ) ] Loss=-\frac{1}{B \times ET}\sum_{b=1}^{B}\sum_{et=1}^{ET}[log(s_{b,et}^{tr},e_{b,et}^{tr})+log(s_{b,et}^{ar},e_{a,et}^{tr})+log(eType_{b,et})+log(rType_{b,et})] Loss=−B×ET1b=1∑Bet=1∑ET[log(sb,ettr,eb,ettr)+log(sb,etar,ea,ettr)+log(eTypeb,et)+log(rTypeb,et)]

其中 B , E T B,ET B,ET分别代表batch_size和句子中出现的最大事件元组数, b , e t b,et b,et分别代表第 b b b个训练实例和第 e t et et个时间步长。此外, s ∗ , ∗ ∗ , e ∗ , ∗ ∗ , e T y p e ∗ , ∗ , r T y p e ∗ , ∗ s_{*,*}^{*},e_{*,*}^{*},eType_{*,*},rType_{*,*} s∗,∗∗,e∗,∗∗,eType∗,∗,rType∗,∗分别表示触发词和实体短语的真实开始和结束索引位置及其对应的事件类型和角色标签的softmax最大分数。

3.4 触发词/论元跨度的推断

在每个时间步骤 t t t,指针解码器网络为我们提供了四个归一化标量分数: s ^ i t r \hat s_i^{tr} s^itr, e ^ i t r , \hat e_i^{tr}, e^itr, s ^ i a r \hat s_i^{ar} s^iar和 e ^ i a r \hat e_i^{ar} e^iar分别表示第 i i i个令牌作为触发器和自变量跨度的开始和结束索引的概率。类似地,对于源句子 S S S(长度为 n n n)中的每个token,我们得到一组四个概率分数,根据这些分数将抽取有效的触发词和论元跨度。我们识别触发词短语和论元短语的开始和结束位置,使得聚合概率分数在事件元组内不具有任何重叠标记的约束和 1 ≤ b ≤ e ≤ n 1\le b\le e\le n 1≤b≤e≤n下最大化,其中 b b b和 e e e是相应短语的开始位置和结束位置并且 n n n是句子的长度。首先,我们选择触发词短语的开始(b)和结束(e)位置索引,使得: s ^ b t r × e ^ e t r \hat s_b^{tr} \times \hat e_e^{tr} s^btr×e^etr。类似地,我们选择论元短语的开始和结束位置索引,以便抽取的论元短语不与事件短语跨度重叠。因此,我们得到了四个位置索引及其相应的概率分数。我们重复整个过程,但通过互换序列,即首先识别论元跨度,然后识别触发词短语跨度。因此,我们将获得另一组具有相应概率分数的四个位置指数。为了识别有效的触发词和论元短语跨度,我们选择给出较高概率分数乘积的索引集。

4、实验

4.1 数据集

本文使用的ACE2005语料库共包含599个文档。我们使用了与先前工作相同的数据分割。训练数据包含529份文件(14669句),验证数据包含30份文件(873句),测试数据包含40篇文章(711句)。语料库包含33个事件子类型、13种类型的论元和36个独特的角色标签。这里我们处理的是句子级事件抽取任务,即,我们提出的系统基于句子中存在的信息来找到事件帧。数据集中存在三种类型的句子:

- 无论元的单触发器:句子只包含一个事件触发词,没有论元信息。

- 单个事件和相关论元:句子仅包含一个事件触发词和相关论元信息。

- 多个事件和相关论元:句子包含多个事件触发词(相同或不同的事件类型)和相应的论元短语。对于上述触发词,每个论元扮演相同或不同的角色。

- 无信息:这些句子不包含与预定义事件类型对应的任何事件触发词。

对于预处理、标记化、位置标记和生成依赖解析树,我们使用spaCylibrary(https://github.com/explosion/spaCy)。使用F1作为模型的评价指标。

4.2 参数设置

在我们的模型的编码器部分,我们采用了预训练BERT-base。与Bert-base类似,token嵌入长度( d B E R T d_{BERT} dBERT)为768。我们设置POS嵌入维度( d p o s d_{pos} dpos)的维度为50,DEP特征嵌入维度( d d e p d_{dep} ddep)为50,实体特征嵌入维度为50( d e n t d_{ent} dent),字符嵌入维度为50( d c h a r d_{char} dchar),字符级token嵌入维度为50( d c d_c dc)。用于抽取字符级token嵌入的CNN层的filter大小为3,并考虑最大长度为10的token。我们还设置了解码器LSTM的隐藏维度( d h d_h dh)=968,指针网络中BiLSTM的隐维度( d p d_p dp)=968。该模型被训练了40个epoch,batch_size为32,我们使用学习率为0.001,权重衰减为 1 0 − 5 10^{-5} 10−5的Adam优化器用于参数优化。我们将dropout概率设置为0.5,以避免过度拟合。在我们的实验中,我们使用P100-PCIE 16GB GPU,使用的参数总数为≈ 220M。选择dev数据集上F1得分最高的模型变量对测试数据进行评估。我们采用与先前工作定义的正确性度量来评估预测结果。

4.3 基准模型

使用之前的SOTA作为基准:

- JointBeam

- DMCNN

- JRNN

- JMEE

- DBRNN

- Joint3EE

- GAIL

- TANL

- TEXT2EVENT

- PLMEE

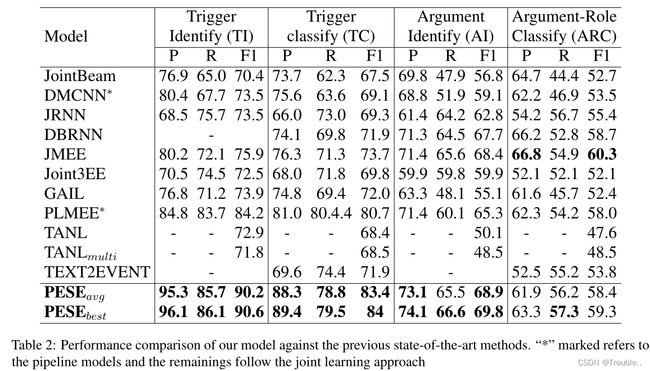

5、结果和讨论

表2展示了各种SOTA的实验结果。

5.1 多事件案例

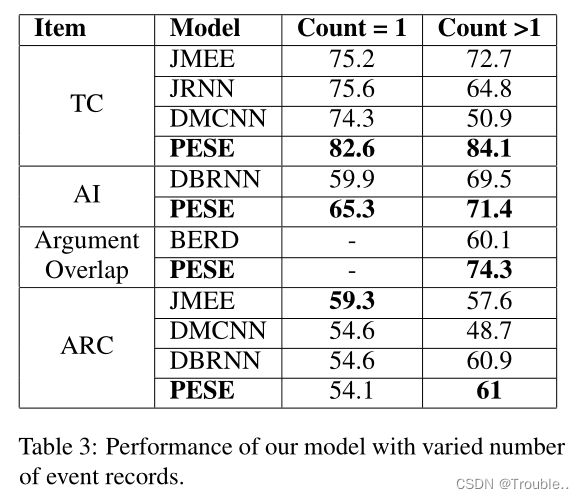

与之前的工作类似,我们根据出现的事件触发词的数量划分测试句子,并分别对这些句子进行评估。在单触发词和多触发词场景中,模型在事件类型识别任务中的执行率都超过90%。有趣的是,在触发词分类(TC)的情况下,该模型在多触发词实例中的表现相对更好,这假设了我们的模型在捕获句子内部的事件间依赖性方面的有效性。

5.2 共享论元方案

我们还研究了我们的模型在共享论元场景中的性能。在ACE2005数据集中,一个事件实例可以包含多个论元,或者一个论元短语可以由多个事件实例共享。与DBRNN相比,我们的模型在单论元和多论元场景中都表现得更好。

5.3 重复论元短语

在某些情况下,实体短语的部分被视为不同的论元。例如,中国前总统是Person类型的论点,而中国是GPE类型的论点。当句子中的所有论点都不同时,我们的模型在论点短语识别中获得80.6%的F1分数。或者,在存在重叠论元的情况下,F1得分为74.3%,这比BERD模型报告的结果要好得多)。

5.4 识别多个角色

当每个事件在一个句子中只有一个论点角色记录时,我们的模型得出的F1分数为54.1%。在存在多论元角色信息的情况下,F1得分为61%。表3中报告了所有结果。与Yang等人类似,我们还考虑了一个特定论点在句子中具有单个或多个角色信息的情况。对于单个角色类型,该模型的F1得分为82.4%,而对于多个角色实例,对应的F1得分则为54.7%。

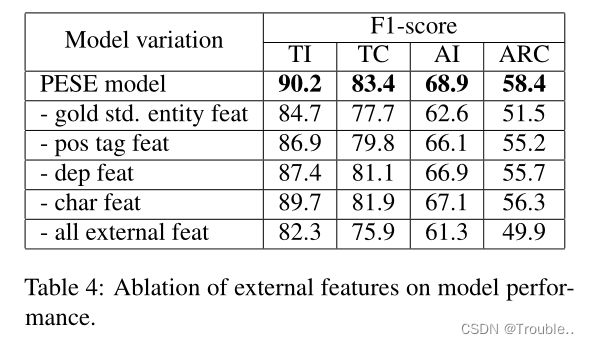

5.5 消融实验

为了研究我们模型中使用的外部特征的影响,我们在表4中报告了消融研究观察结果。我们发现实体类型信息对于端到端事件抽取非常重要。它非常显著地提高了每个子任务的F1分数。定量得分也验证了pos标签和依赖标签特征的使用。字符级功能的使用也使我们的模型性能有了微小的改进。

6、相关工作

根据ACE2005指南,EE的任务由三到四个子任务组成,对应于事件定义的不同方面。之前关于EE的大量工作只关注一些特定的子任务,例如:事件检测或论元抽取。能够抽取完整事件结构的模型主要以两种方式分类:(1)流水线方法和(2)联合建模方法。最近,问答、机器阅读理解、零零样本学习等方法也被用于解决EE问题。一些采用序列生成方法进行事件抽取的近期工作也取得了不错的结果。在之前的方法中,与我们的方法最接近的是TEXT2EVENT,该方法还以端到端的方式从句子生成事件结构。但它们以逐个token的格式生成事件表示,这意味着在每个时间步骤中,模型都生成一个token。而我们的模型在每个时间步长生成一个事件帧,这在端到端事件结构抽取中更为现实。

7、总结

些采用序列生成方法进行事件抽取的近期工作也取得了不错的结果。在之前的方法中,与我们的方法最接近的是TEXT2EVENT,该方法还以端到端的方式从句子生成事件结构。但它们以逐个token的格式生成事件表示,这意味着在每个时间步骤中,模型都生成一个token。而我们的模型在每个时间步长生成一个事件帧,这在端到端事件结构抽取中更为现实。