统计模型 | 学习笔记

一.概述

任何统计模型都是对现实世界复杂联系的简化

根据目的分类

聚类方法(细分类模型):市场细分,协同推荐

预测方法:回归模型,时间序列模型

关联归纳方法:购物篮分析,序列分析

根据方法原理分类

基于传统统计模型的推断性方法:在抽样理论的支持下,首先假定预测变量和影响因素间呈现某种公式化的联系,然后采用假设检验的方法来验证相应的假设是否成立,并给出相应的参数估计值

基本机器识别技术的自动化方法:也被称为非推断性方法,没有什么前提假设,就是从数据中寻找关联,然后采用验证数据集对找到的关联加以验证

损失函数:用于衡量模型的信息损失或者预测错误程度的函数

模型拟合的最终目标是使得损失函数达到最小值

分类:错分比例(及其所导致的损失)

分类预测正确率

熵

连续:残差所代表的信息量的综合(及其所导致的损失)

最小二乘法的残差平方和

离均差绝对值之和(最小一乘法)

凸函数:局部最小值即全局最小值

非凸函数:存在多个局部最小值/局部最优解

显然,凸函数在求解极值时容易很多

正则化:控制模型复杂度

模型应该复杂到什么程度才合适?在理想的损失函数的基础上增加一个惩罚项,用于表达模型复杂程度所带来的影响,以避免模型为了追求精确性而过于复杂

原损失函数 = 模型精确性衡量指标

新损失函数 = 模型精确性衡量指标 + 模型复杂度衡量指标

新损失函数 = 模型精确性衡量指标 + landa * 模型复杂度衡量指标

一个东西,三个名称:正则化(机器学习),模型惩罚项(统计学),范数(数学)

基本作用:保证模型尽可能简单,避免参数过多导致过拟合

约束模型特性,加入一些先验知识,例如稀疏,低秩等

正则化函数一般是模型复杂度的单调递增函数:模型越复杂,代价越大

L0正则化:复杂度指标为模型中非零参数的个数,容易理解,但数学上很难求解

L1正则化:模型中各个参数绝对值(加权)之和,几何学上的曼哈顿距离,主要用于特征选择/筛选变量(实例:lasso回归)

L2正则化:为模型各个参数平方(加权)之和(的开方),几何学上的欧几里得距离,主要用于防止过拟合(实例:岭回归)

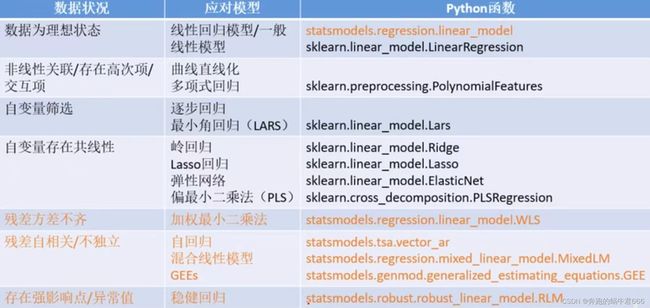

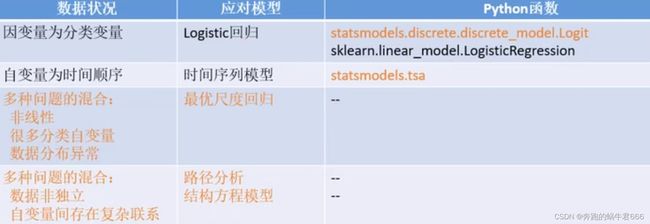

二.回归

希望描述某个群体的月收入状况,该如何给出相应的信息?

除了给出平均水平以外,还应当给出离散程度

均数:能够表示集中趋势

标准差:能够表示离散趋势

单因变量回归类模型的基本框架

三.线性回归

研究一个连续性变量(因变量)的取值随着其它变量(自变量)的数值变化而变化的趋势

通过回归方程解释两变量之间的关系显得更为精确,可以计算出自变量改变一个单位时因变量平均改变的单位数量,这是相关分析无法做到的

除了描述两变量的关系以外,通过回归方程还可以进行预测和控制,这在实际工作中尤为重要

线性回归假定自变量对因变量的影响强度始终保持不变

常用指标

决定系数:模型整体价值的衡量指标

相应的相关系数的平方

反映因变量的全部变异中能够通过回归关系被自变量解释的比例

偏回归系数:反映某一个自变量在数量上对因变量的影响强度

相应的自变量上升一个单位时,因变量取值的变动情况

标化偏回归系数:量纲问题

用于自变量间重要性的比较

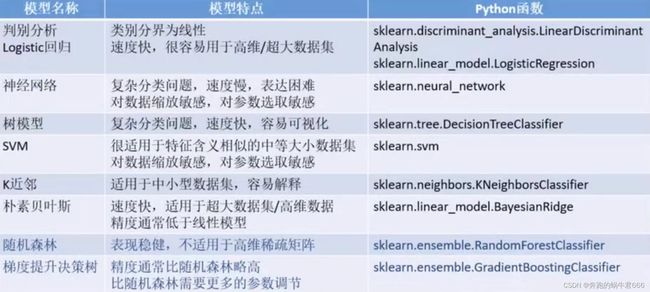

四.分类

五.聚类

按照个体(案例或者变量)的特征将它们分类,使同一类别内的个体具有尽可能高的同质性,而类别之间则具有尽可能高的异质性,随后总结每一类的基本特征,从而更清晰地了解问题的实质

无因变量,无监督学习方法

聚类分析前所有个体所属的类别是未知的,类别个数一般也是未知的,分析的依据就是原始数据。可能事先没有任何有关类别的信息可参考,当然如果有的话更好

本质是一种统计描述方法,或者说是一种建立假设而不是验证假设的方法

往往被作为一个中间步骤

基本原理

为了得到比较合理的分类,首先要采用适当的指标来定量地描述研究对象之间的联系的紧密程度

直观的理解为按空间距离的远近来划分类别

假定研究对象均用自变量所构成的高维空间中的点来表示

在聚类分析中,一般的规则是将距离较小的点归为同一类,将距离较大的点归为不同的类

常见的是对个体分类,也可以对变量分类,此时一般使用相似系数作为距离测量指标

常见分类

①划分聚类:K-Means

将数据集分割为k个部分,然后基于统计指标进行优化调整

计算速度相对比较快

适用于中小规模的数据库中的球状类别

②层次聚类:BIRCH

依次将数据点合并入同一类别,结果由不同层次的聚类结果组成

聚类结果较丰富,不同层次的结果间有嵌套的关系

计算量相对较大

③基于密度:DBSCAN

只要一个区域中的点的密度大过某个阈值,就应当被归入同一类中

擅长发现各种特殊形状的类

计算量较大

④基于网格:STING

首先将数据空间划分成为有限个单元的网格结构,然后基于单元格进行聚类

处理速度很快

⑤基于模型:SOM,高斯混合模型

六.主成分分析

只是一种中间手段,其背景是研究中经常会遇到多指标的问题,这些指标间往往存在一定的相关,直接纳入分析不仅复杂,变量间难以取舍,而且可能因多重共线性而无法得出正确结论

主成分分析的目的就是通过线性变换,将原来的多个指标组合成相互独立的少数几个能充分反映总体信息的指标,便于进一步分析,尽可能保留原始变量的信息,且彼此不相关

主成分的提取

提取出的每个主成分都是原来多个指标的线性组合

原则上如果有n个变量,则最多可以提取出n个主成分,但将它们全部提取出来就失去了该方法简化数据的实际意义(往往提取出前2~3个主成分已包含了90%以上的信息,其他可以忽略不计)

提取出的主成分包含主要信息即可,不一定非要有准确的实际含义

用途

主成分评价:当进行多指标的综合评价时,用主成分分析将多指标中的信息集中为若干个主成分,然后加权求和,得到综合评价指数

主成分回归:通过存在共线性的自变量进行主成分分析,从而在提取多数信息的同时解决共线性问题

python实现

#主成分分析

#用协方差阵而不是相关系数阵进行提取

sklearn.decomposition.PCA()

#因子分析

#方法太简单,不能进行因子旋转

sklearn.decomposition.FactorAnalysis()解决变量间多重共线性

新变量集能够更有利于简化和解释问题

有太多的变量,希望能够消减变量,用一个新的,更小的由原始变量集组合成的新变量集作进一步分析

探讨变量内在联系和结构

观测变量之间存在相互依赖关系

这反映的实际上是变量间的内在关联结构